ヘルプを受ける - FAQ ディスカッション Discord ドキュメント Web サイト

クイックスタート モデルのロードマップ ?デモ?エクスプローラー?例

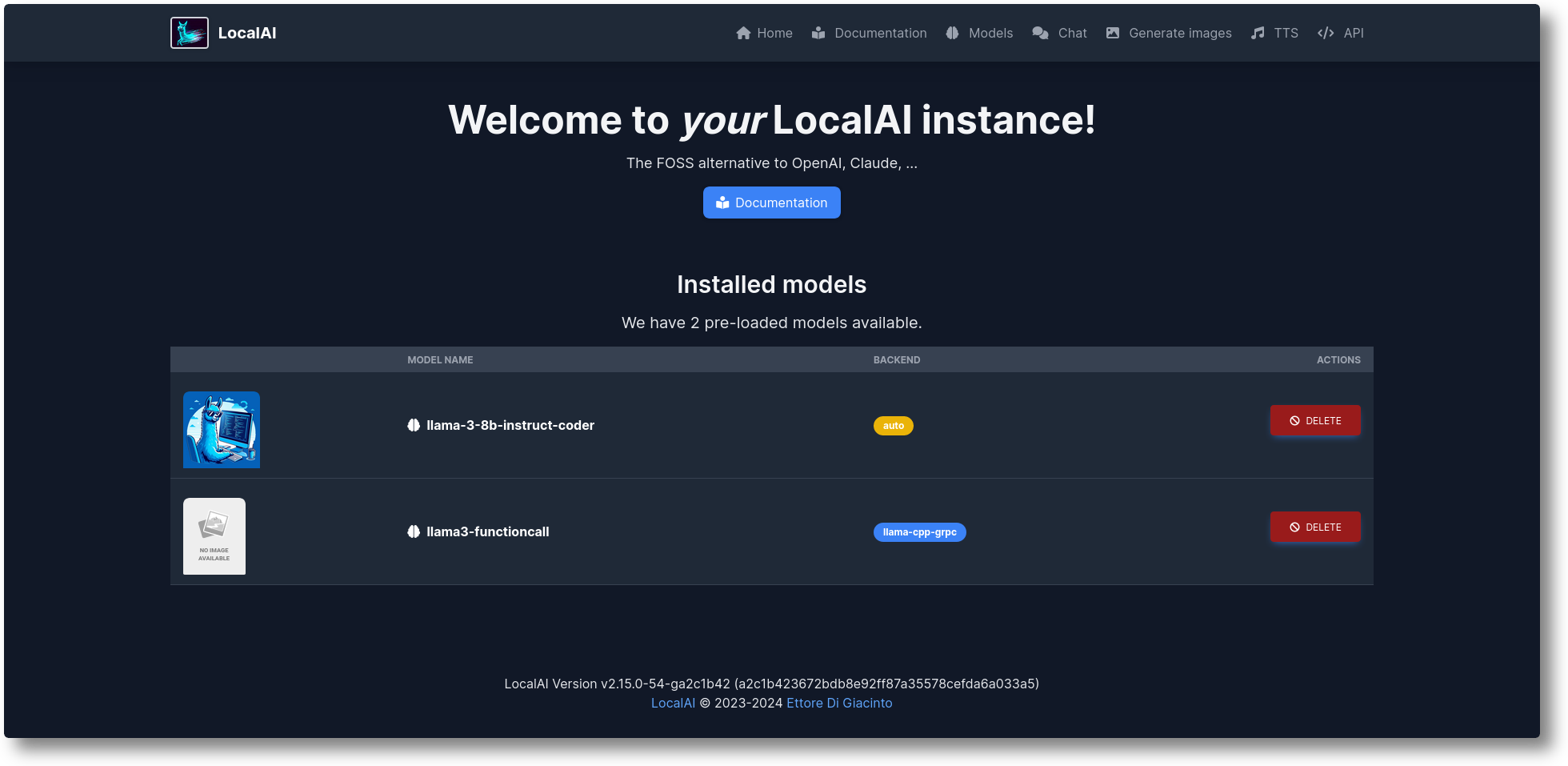

LocalAI は、無料のオープンソース OpenAI の代替品です。 LocalAI は、ローカル AI 推論用の OpenAI (イレブンラボ、アンスロピックなど) API 仕様と互換性のあるドロップイン代替 REST API として機能します。これにより、消費者グレードのハードウェアを使用して、ローカルまたはオンプレミスで LLM を実行し、画像、音声 (およびそれだけではありません) を生成し、複数のモデル ファミリをサポートすることができます。 GPUは必要ありません。 Ettore Di Giacinto によって作成および保守されています。

インストーラー スクリプトを実行します。

カール https://localai.io/install.sh |しー

または、docker で実行します。

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-aio-cpu# 代替イメージ:# - Nvidia GPU をお持ちの場合:# docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-aio-gpu-nvidia-cuda-12# - 事前構成モデルなし# docker run -ti --name local-ai -p 8080:8080 localai/localai:latest# - Nvidia GPU の事前構成モデルなし# docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai :最新-gpu-nvidia-cuda-12

モデルをロードするには:

# モデル ギャラリーから (WebUI のモデル タブから、または https://models.localai.io にアクセスして「local-ai モデル リスト」で利用可能なモデルを参照) local-ai から llama-3.2-1b-instruct を実行します。 q4_k_m# phi-2 モデルを使用して、huggingfacelocal-ai を実行して LocalAI を直接起動します Huggingface://TheBloke/phi-2-GGUF/phi-2.Q8_0.gguf# インストールして実行しますOllama OCI レジストリからのモデルlocal-ai run ollama://gemma:2b# 設定ファイルからモデルを実行local-ai run https://gist.githubusercontent.com/.../phi-2.yaml# インストールして標準 OCI レジストリ (Docker Hub など) からモデルを実行します。 local-ai run oci://localai/phi-2:latest

はじめる

2024 年 10 月: サンプルは LocalAI-example に移動されました

2024 年 8 月: ? FLUX-1、P2P エクスプローラー

2024 年 7 月: ? P2P ダッシュボード、LocalAI Federated モード、および AI Swarm: #2723

2024 年 6 月: ? LocalAI なしでモデル ギャラリーを閲覧できるようになりました。 https://models.localai.io をチェックしてください。

2024 年 6 月: OCI レジストリのモデルのサポート: #2628

2024 年 5 月: 分散型 P2P llama.cpp: #2343 (peer2peer llama.cpp!) ドキュメント https://localai.io/features/distribute/

2024 年 5 月: Openvoice: #2334

2024 年 5 月: ?文法および混合モードを使用しない関数呼び出し: #2328

2024 年 5 月: 分散推論: #2324

2024 年 5 月: WebUI でのチャット、TTS、および画像生成: #2222

2024 年 4 月: リランカー API: #2121

ロードマップ項目: 課題のリスト

vLLM とビデオの理解によるマルチモーダル: #3729

リアルタイム API #3714

分散型 P2P グローバル コミュニティ プール: #3113

WebUI の改善: #2156

バックエンド v2: #1126

UX の改善 v2: #1373

アシスタント API: #1273

モデレーションエンドポイント: #999

バルカン: #1647

Anthropic API: #1808

支援して貢献したい場合は、問題を入手できます: https://github.com/mudler/LocalAI/issues?q=is%3Aissue+is%3Aopen+label%3A%22up+for+grabs%22

GPT によるテキスト生成 ( llama.cpp 、 gpt4all.cppなど)

テキストをオーディオに変換

音声からテキストへ ( whisper.cppを使用した音声転写)

安定した拡散による画像生成

OpenAI に似たツール API

ベクトルデータベースの埋め込み生成

制約された文法

Huggingface からモデルを直接ダウンロードする

ビジョンAPI

リランカー API

P2P 推論

WebUIを統合!

ドキュメントの「はじめに」セクションを確認してください。

カスタム コンテナを構築してデプロイします。

https://github.com/sozercan/aikit

WebUI:

https://github.com/ジルビズ/localai-admin

https://github.com/go-skynet/LocalAI-frontend

QA-Pilot (GitHub コード リポジトリの迅速な理解とナビゲーションのために LocalAI LLM を活用する対話型チャット プロジェクト) https://github.com/reid41/QA-Pilot

モデルギャラリー

https://github.com/go-skynet/model-gallery

他の:

Helm チャート https://github.com/go-skynet/helm-charts

VSCode 拡張機能 https://github.com/badgooooor/localai-vscode-plugin

ターミナルユーティリティ https://github.com/djcopley/ShellOracle

ローカル スマート アシスタント https://github.com/mudler/LocalAGI

ホーム アシスタント https://github.com/sammcj/homeassistant-localai / https://github.com/drndos/hass-openai-custom-conversation / https://github.com/valentinfrlch/ha-gpt4vision

Discord ボット https://github.com/mudler/LocalAGI/tree/main/examples/discord

Slack ボット https://github.com/mudler/LocalAGI/tree/main/examples/slack

Shell-Pilot (Linux または MacOS システム上の純粋なシェル スクリプトを介して LocalAI モデルを使用して LLM と対話します) https://github.com/reid41/shell-pilot

テレグラムボット https://github.com/mudler/LocalAI/tree/master/examples/telegram-bot

Github アクション: https://github.com/marketplace/actions/start-localai

例: https://github.com/mudler/LocalAI/tree/master/examples/

LLM 微調整ガイド

ローカルでビルドする方法

Kubernetesにインストールする方法

LocalAIを統合したプロジェクト

How To セクション (コミュニティによって厳選)

LocalAI を使用して Visual Studio コードを実行する (SUSE)

Jetson Nano 開発キットで LocalAI を実行する

Pulumi を使用して AWS EKS で LocalAI を実行する

AWS で LocalAI を実行する

ドキュメントに回答するチームおよび OSS プロジェクト用の Slackbot を作成する

LocalAI と k8sgpt の出会い

LangChain、LocalAI、Chroma、GPT4All を使用したローカルでのドキュメントの質問応答

LocalAI で k8sgpt を使用するためのチュートリアル

このリポジトリ、データを下流プロジェクトで利用する場合は、次のように引用することを検討してください。

@misc{localai,

author = {Ettore Di Giacinto},

title = {LocalAI: The free, Open source OpenAI alternative},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/go-skynet/LocalAI}},LocalAI は便利だと思いますか?

後援者またはスポンサーになってプロジェクトをサポートしてください。あなたのロゴが Web サイトへのリンクとともにここに表示されます。

CI 費用をカバーするこのプロジェクトをサポートしてくださった寛大なスポンサーとスポンサー リストに多大な感謝を申し上げます。

LocalAI は、Ettore Di Giacinto によって作成されたコミュニティ主導のプロジェクトです。

MIT - 著者 Ettore Di Giacinto [email protected]

LocalAI は、コミュニティからすでに入手可能な優れたソフトウェアの助けがなければ構築できませんでした。ありがとう!

ラマ.cpp

https://github.com/tatsu-lab/stanford_alpaca

最初のアイデアについては https://github.com/cornelk/llama-go

https://github.com/antimatter15/alpaca.cpp

https://github.com/EdVince/Stable-Diffusion-NCNN

https://github.com/ggerganov/whisper.cpp

https://github.com/saharNooby/rwkv.cpp

https://github.com/rhasspy/piper

これはコミュニティ プロジェクトです。貢献者の皆様に心より感謝いたします。 ?