中国語 | 한국어 | 日本語 | Русский |ドイツ語 |フランセ |スペイン語 |ポルトガル語 |テュルクチェ |ティエン・ヴィエット |ああ

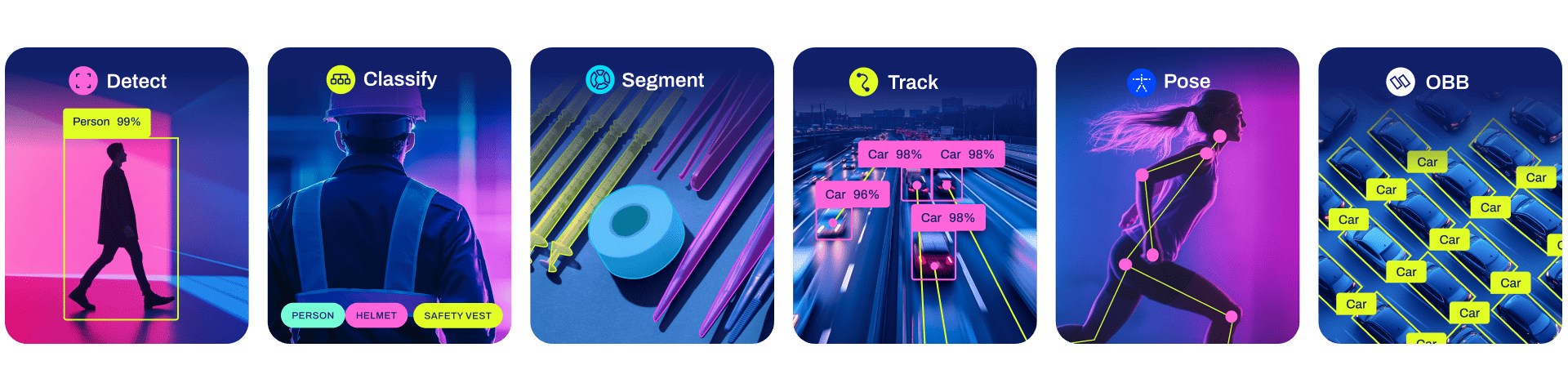

Ultralytics YOLO11 は、以前の YOLO バージョンの成功に基づいて構築され、パフォーマンスと柔軟性をさらに高めるための新機能と改善が導入された最先端の最先端 (SOTA) モデルです。 YOLO11 は、高速、正確、そして使いやすいように設計されており、幅広いオブジェクトの検出と追跡、インスタンスのセグメンテーション、画像分類、姿勢推定タスクに最適です。

ここのリソースが YOLO を最大限に活用するのに役立つことを願っています。詳細については Ultralytics のドキュメントを参照し、サポート、質問、ディスカッションについては GitHub で問題を提起し、Ultralytics Discord、Reddit、フォーラムのメンバーになってください。

エンタープライズ ライセンスをリクエストするには、Ultralytics ライセンスのフォームに記入してください。

ドキュメント

クイックスタートのインストールと使用例については以下を参照し、トレーニング、検証、予測、展開に関する完全なドキュメントについてはドキュメントを参照してください。

PyTorch>=1.8を備えたPython>=3.8環境で、すべての要件を含む Ultralytics パッケージを PIP インストールします。

pip インストール Ultralytics

Conda、Docker、Git などの別のインストール方法については、クイックスタート ガイドを参照してください。

YOLO は、 yoloコマンドを使用してコマンド ライン インターフェイス (CLI) で直接使用できます。

yolo 予測モデル = yolo11n.pt ソース = 'https://ultralytics.com/images/bus.jpg'

yoloさまざまなタスクやモードに使用でき、追加の引数 (例: imgsz=640を受け入れます。例については、YOLO CLI ドキュメントを参照してください。

YOLO は Python 環境で直接使用することもでき、上記の CLI の例と同じ引数を受け入れます。

from Ultralytics import YOLO# モデルをロードmodel = YOLO("yolo11n.pt")# モデルをトレーニングtrain_results = model.train( data="coco8.yaml", # データセット YAML へのパス epochs=100, # トレーニング エポック数 imgsz= 640、 # トレーニング イメージ サイズ device="cpu"、 # 実行するデバイス、つまり device=0 または device=0,1,2,3 またはdevice=cpu)# 検証でモデルのパフォーマンスを評価します setmetrics = model.val()# 画像でオブジェクト検出を実行しますresults = model("path/to/image.jpg")results[0].show()# モデルをエクスポートしますto ONNX formatpath = model.export(format="onnx") # エクスポートされたモデルへのパスを返しますその他の例については、YOLO Python ドキュメントを参照してください。

モデル

ここでは、COCO データセットで事前トレーニングされた YOLO11 検出、セグメント、ポーズ モデルのほか、ImageNet データセットで事前トレーニングされた YOLO11 分類モデルも利用できます。トラック モードは、すべての検出、セグメント、ポーズのモデルで利用できます。

すべてのモデルは、初めて使用するときに最新の Ultralytics リリースから自動的にダウンロードされます。

COCO でトレーニングされたこれらのモデルの使用例については、検出ドキュメントを参照してください。これには 80 の事前トレーニングされたクラスが含まれます。

| モデル | サイズ (ピクセル) | マップ値 50-95 | スピード CPU ONNX (MS) | スピード T4 TensorRT10 (MS) | パラメータ (男) | フロップス (B) |

|---|---|---|---|---|---|---|

| YOLO11n | 640 | 39.5 | 56.1±0.8 | 1.5±0.0 | 2.6 | 6.5 |

| YOLO11s | 640 | 47.0 | 90.0±1.2 | 2.5±0.0 | 9.4 | 21.5 |

| ヨロ11m | 640 | 51.5 | 183.2±2.0 | 4.7±0.1 | 20.1 | 68.0 |

| YOLO11l | 640 | 53.4 | 238.6±1.4 | 6.2±0.1 | 25.3 | 86.9 |

| YOLO11x | 640 | 54.7 | 462.8±6.7 | 11.3±0.2 | 56.9 | 194.9 |

mAP val値は、COCO val2017 データセットの単一モデル単一スケールのものです。

yolo val detect data=coco.yaml device=0で再現します。

Amazon EC2 P4d インスタンスを使用した COCO val イメージの平均速度。

yolo val detect data=coco.yaml batch=1 device=0|cpuで再現します。

COCO-Seg でトレーニングされたこれらのモデルの使用例については、セグメンテーションのドキュメントを参照してください。これには 80 の事前トレーニングされたクラスが含まれます。

| モデル | サイズ (ピクセル) | マップボックス 50-95 | マップマスク 50-95 | スピード CPU ONNX (MS) | スピード T4 TensorRT10 (MS) | パラメータ (男) | フロップス (B) |

|---|---|---|---|---|---|---|---|

| YOLO11nセグ | 640 | 38.9 | 32.0 | 65.9±1.1 | 1.8±0.0 | 2.9 | 10.4 |

| YOLO11sセグ | 640 | 46.6 | 37.8 | 117.6±4.9 | 2.9±0.0 | 10.1 | 35.5 |

| YOLO11mセグ | 640 | 51.5 | 41.5 | 281.6±1.2 | 6.3±0.1 | 22.4 | 123.3 |

| YOLO11lセグ | 640 | 53.4 | 42.9 | 344.2±3.2 | 7.8±0.2 | 27.6 | 142.2 |

| YOLO11x セグ | 640 | 54.7 | 43.8 | 664.5±3.2 | 15.8±0.7 | 62.1 | 319.0 |

mAP val値は、COCO val2017 データセットの単一モデル単一スケールのものです。

yolo val segment data=coco-seg.yaml device=0で再現します

Amazon EC2 P4d インスタンスを使用した COCO val イメージの平均速度。

yolo val segment data=coco-seg.yaml batch=1 device=0|cpuで再現します

ImageNet でトレーニングされたこれらのモデルの使用例については、分類ドキュメントを参照してください。これには 1000 の事前トレーニングされたクラスが含まれます。

| モデル | サイズ (ピクセル) | ACC トップ1 | ACC トップ5 | スピード CPU ONNX (MS) | スピード T4 TensorRT10 (MS) | パラメータ (男) | フロップス (B) 640 |

|---|---|---|---|---|---|---|---|

| YOLO11n-cls | 224 | 70.0 | 89.4 | 5.0±0.3 | 1.1±0.0 | 1.6 | 3.3 |

| YOLO11s-cls | 224 | 75.4 | 92.7 | 7.9±0.2 | 1.3±0.0 | 5.5 | 12.1 |

| YOLO11m-cls | 224 | 77.3 | 93.9 | 17.2±0.4 | 2.0±0.0 | 10.4 | 39.3 |

| YOLO11l-cls | 224 | 78.3 | 94.3 | 23.2±0.3 | 2.8±0.0 | 12.9 | 49.4 |

| YOLO11x-cls | 224 | 79.5 | 94.9 | 41.4±0.9 | 3.8±0.0 | 28.4 | 110.4 |

acc値は、ImageNet データセット検証セットのモデル精度です。

yolo val classify data=path/to/ImageNet device=0で再現します。

Amazon EC2 P4d インスタンスを使用した ImageNet val イメージの平均速度。

yolo val classify data=path/to/ImageNet batch=1 device=0|cpuで再現します。

COCO-Pose でトレーニングされたこれらのモデルの使用例については、Pose Docs を参照してください。これには、1 つの事前トレーニングされたクラス、人物が含まれます。

| モデル | サイズ (ピクセル) | マップポーズ 50-95 | マップポーズ 50 | スピード CPU ONNX (MS) | スピード T4 TensorRT10 (MS) | パラメータ (男) | フロップス (B) |

|---|---|---|---|---|---|---|---|

| YOLO11n-ポーズ | 640 | 50.0 | 81.0 | 52.4±0.5 | 1.7±0.0 | 2.9 | 7.6 |

| YOLO11s-ポーズ | 640 | 58.9 | 86.3 | 90.5±0.6 | 2.6±0.0 | 9.9 | 23.2 |

| YOLO11mポーズ | 640 | 64.9 | 89.4 | 187.3±0.8 | 4.9±0.1 | 20.9 | 71.7 |

| YOLO11l-ポーズ | 640 | 66.1 | 89.9 | 247.7±1.1 | 6.4±0.1 | 26.2 | 90.7 |

| YOLO11x-ポーズ | 640 | 69.5 | 91.1 | 488.0±13.9 | 12.1±0.2 | 58.8 | 203.3 |

mAP val値は、COCO Keypoints val2017 データセットの単一モデル単一スケールのものです。

yolo val pose data=coco-pose.yaml device=0で再現します。

Amazon EC2 P4d インスタンスを使用した COCO val イメージの平均速度。

yolo val pose data=coco-pose.yaml batch=1 device=0|cpuで再現します

DOTAv1 でトレーニングされたこれらのモデルの使用例については、OBB ドキュメントを参照してください。これには、15 の事前トレーニングされたクラスが含まれています。

| モデル | サイズ (ピクセル) | マップテスト 50 | スピード CPU ONNX (MS) | スピード T4 TensorRT10 (MS) | パラメータ (男) | フロップス (B) |

|---|---|---|---|---|---|---|

| YOLO11n-obb | 1024 | 78.4 | 117.6±0.8 | 4.4±0.0 | 2.7 | 17.2 |

| YOLO11s-obb | 1024 | 79.5 | 219.4±4.0 | 5.1±0.0 | 9.7 | 57.5 |

| YOLO11m-obb | 1024 | 80.9 | 562.8±2.9 | 10.1±0.4 | 20.9 | 183.5 |

| YOLO11l-obb | 1024 | 81.0 | 712.5±5.0 | 13.5±0.6 | 26.2 | 232.0 |

| YOLO11x-obb | 1024 | 81.3 | 1408.6±7.7 | 28.6±1.0 | 58.8 | 520.2 |

mAPテスト値は、DOTAv1 データセット上の単一モデル マルチスケールのものです。

yolo val obb data=DOTAv1.yaml device=0 split=testで再現し、マージされた結果を DOTA 評価に送信します。

Amazon EC2 P4d インスタンスを使用した DOTAv1 val イメージの平均速度。

yolo val obb data=DOTAv1.yaml batch=1 device=0|cpuで再現します。

統合

主要な AI プラットフォームとの重要な統合により、Ultralytics の製品の機能が拡張され、データセットのラベル付け、トレーニング、視覚化、モデル管理などのタスクが強化されます。 Ultralytics が W&B、Comet、Roboflow、OpenVINO と連携して AI ワークフローを最適化する方法をご覧ください。

![]()

![]()

![]()

| ウルトラリティクス ハブ ? | W&B | 彗星⭐NEW | ニューラルマジック |

|---|---|---|---|

| YOLO ワークフローを合理化: Ultralytics HUB を使用して、ラベル付け、トレーニング、デプロイを簡単に実行します。今すぐ試してください! | 重みとバイアスを使用して実験、ハイパーパラメータ、結果を追跡する | 永久無料の Comet では、YOLO11 モデルの保存、トレーニングの再開、対話型の視覚化と予測のデバッグが可能です | Neural Magic DeepSparse を使用して YOLO11 推論を最大 6 倍高速に実行 |

ウルトラリティクス ハブ

データ視覚化のためのオールインワン ソリューション、YOLO11 である Ultralytics HUB ⭐ でシームレスな AI を体験してください。コーディングなしでモデルのトレーニングとデプロイメントを実行できます。最先端のプラットフォームとユーザーフレンドリーな Ultralytics アプリを使用して、画像を実用的な洞察に変換し、AI ビジョンを簡単に実現します。今すぐ無料で旅を始めましょう!

貢献する

皆様からのご意見をお待ちしております。 Ultralytics YOLO は、コミュニティの支援なしには実現できません。始めるには貢献ガイドを参照し、アンケートに記入して体験に関するフィードバックを送信してください。ありがとう ?貢献者の皆様へ!

ライセンス

Ultralytics は、さまざまなユースケースに対応する 2 つのライセンス オプションを提供します。

AGPL-3.0 ライセンス: この OSI 承認のオープンソース ライセンスは、学生や愛好家にとって理想的であり、オープンなコラボレーションと知識の共有を促進します。詳細については、LICENSE ファイルを参照してください。

エンタープライズ ライセンス: 商用利用を目的として設計されたこのライセンスは、AGPL-3.0 のオープンソース要件をバイパスして、Ultralytics ソフトウェアと AI モデルを商用商品およびサービスにシームレスに統合することを許可します。あなたのシナリオに当社のソリューションを商用製品に組み込むことが含まれる場合は、Ultralytics ライセンスを通じてご連絡ください。

接触

Ultralytics のバグ レポートと機能リクエストについては、GitHub の問題にアクセスしてください。 Ultralytics Discord、Reddit、またはフォーラムのメンバーになって、質問したり、プロジェクトを共有したり、ディスカッションを学習したり、Ultralytics に関するあらゆることについてサポートを受けてください。