5/8/2024 : GPT-3.5 および LLama2 推論コードと図 6 の結果を更新。認知相乗効果の創発的な性質を示します。3/15/2024 : この論文は NAACL2024 の主要会議論文として採択されました。 pip install -r requirements.txt

config_template.shで OpenAI API 構成をセットアップし、 source config_template.shを実行して環境変数をセットアップします (実験では Azure API を使用していることに注意してください) 3 つのタスクごとに実行スクリプトが提供されています。詳細については、「.sh」スクリプト内のコメントを確認してください。

bash scripts/trivia_creative_writing.shbash scripts/codenames_collaborative.shbash scripts/logic_grid_puzzle.sh すべてのプロンプトは、 prompts/フォルダーにあります。

すべてのデータセットはdata/フォルダーにあります。

各タスクの論文の実験結果は、 logs/フォルダーにあります。 gpt4_w_sys_mesおよびgpt4_wo_sys_mesには、論文の表 2 に対応する結果が含まれています。図 6 の結果に対応する gpt-3.5 および llama2-13b の結果も含まれています。ここでは、システム メッセージを追加するかどうかなどのハイパーパラメーターが、gpt4 実験で最もパフォーマンスの高い選択肢に従います。

"test_output_infos" : 各インスタンスの評価メトリクス (例: # 件の正解の記載) が含まれます。"*raw_responses" : 各 API 呼び出しからの生の応答。"*parsing_flag" : 生の応答が正常に解析されたかどうか。 (コード名タスクの場合、このフィールドは「parsing_success_flag_spymaster」と「parsing_success_flag_guesser」に分かれています)"unwrapped_output" : 評価メトリクスの計算に使用される解析された出力。 (コード名タスクの場合、このフィールドは「spymaster_output」と「guesser_output」に分離されます。「hint_word」という名前の追加フィールドがあり、これはスパイマスターの出力から解析され、ゲッサーの入力に挿入されます。評価指標は「」に基づいて計算されます。推測_出力")"task data" : 現在のタスクインスタンスのデータ (例: 質問、回答、ターゲットワードなど)。"usage" : これまでに費やされたトークンの数とコストを記録します。この研究が興味深い/役立つと思われる場合は、論文を引用し、このリポジトリにスターを付けてください。

@article{wang2023unleashing,

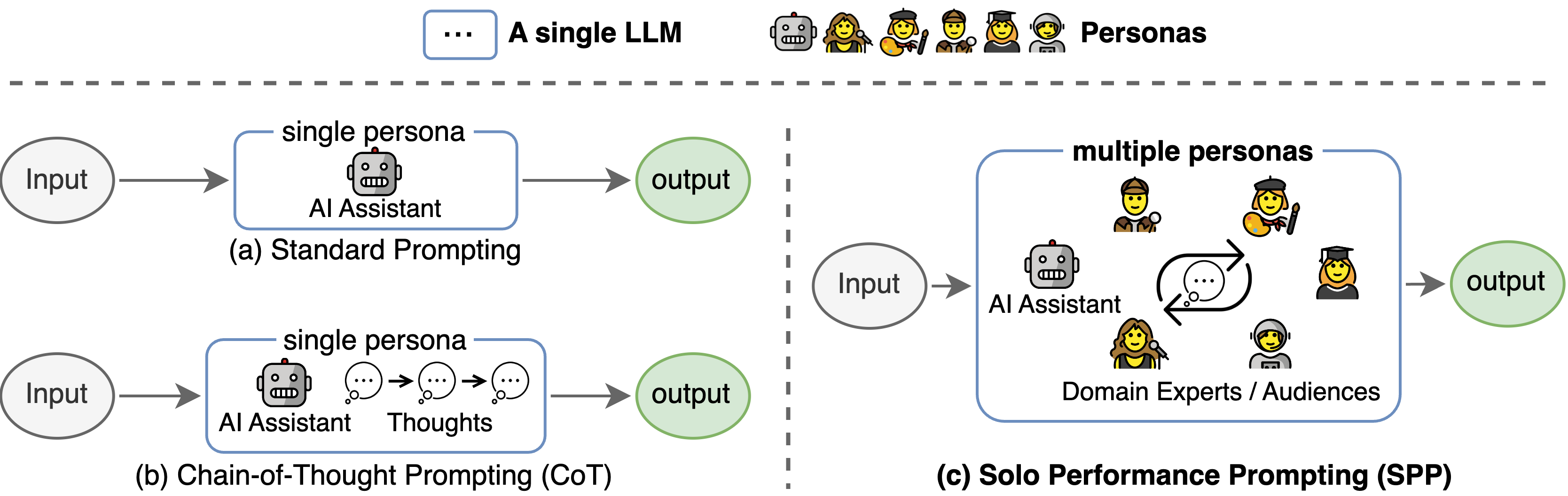

title={Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration},

author={Wang, Zhenhailong and Mao, Shaoguang and Wu, Wenshan and Ge, Tao and Wei, Furu and Ji, Heng},

journal={arXiv preprint arXiv:2307.05300},

year={2023}

}

このコードベースは、Tree-of-thought 公式リポジトリの構造を参照しました。著者らのオープンソース化への取り組みに感謝します。