素晴らしい AGI アンケート

汎用人工知能に関する必読の論文

?ニュース

- [2024-10] ?私たちの論文がTMLR 2024に受理されました。

- [2024-05] ?私たちは ICLR 2024 で AGI ワークショップを開催しており、ポジション ペーパー「私たちは AGI からどの程度離れていますか?」を発表しました。

私たちのプロジェクトは進行中のオープンな取り組みであり、AGI の進歩と並行して進化していきます。私たちはコミュニティからのフィードバックやプルリクエストを大歓迎しており、論文を毎年更新する予定です。プロジェクト Web サイトの貢献者には、将来の改訂で感謝の意を表します。

私たちの研究やリソースが役に立つと思われる場合は、BibTex から引用してください:

@article { feng2024far ,

title = { How Far Are We From AGI } ,

author = { Feng, Tao and Jin, Chuanyang and Liu, Jingyu and Zhu, Kunlun and Tu, Haoqin and Cheng, Zirui and Lin, Guanyu and You, Jiaxuan } ,

journal = { arXiv preprint arXiv:2405.10313 } ,

year = { 2024 }

}コンテンツ

- コンテンツ

- 1. はじめに

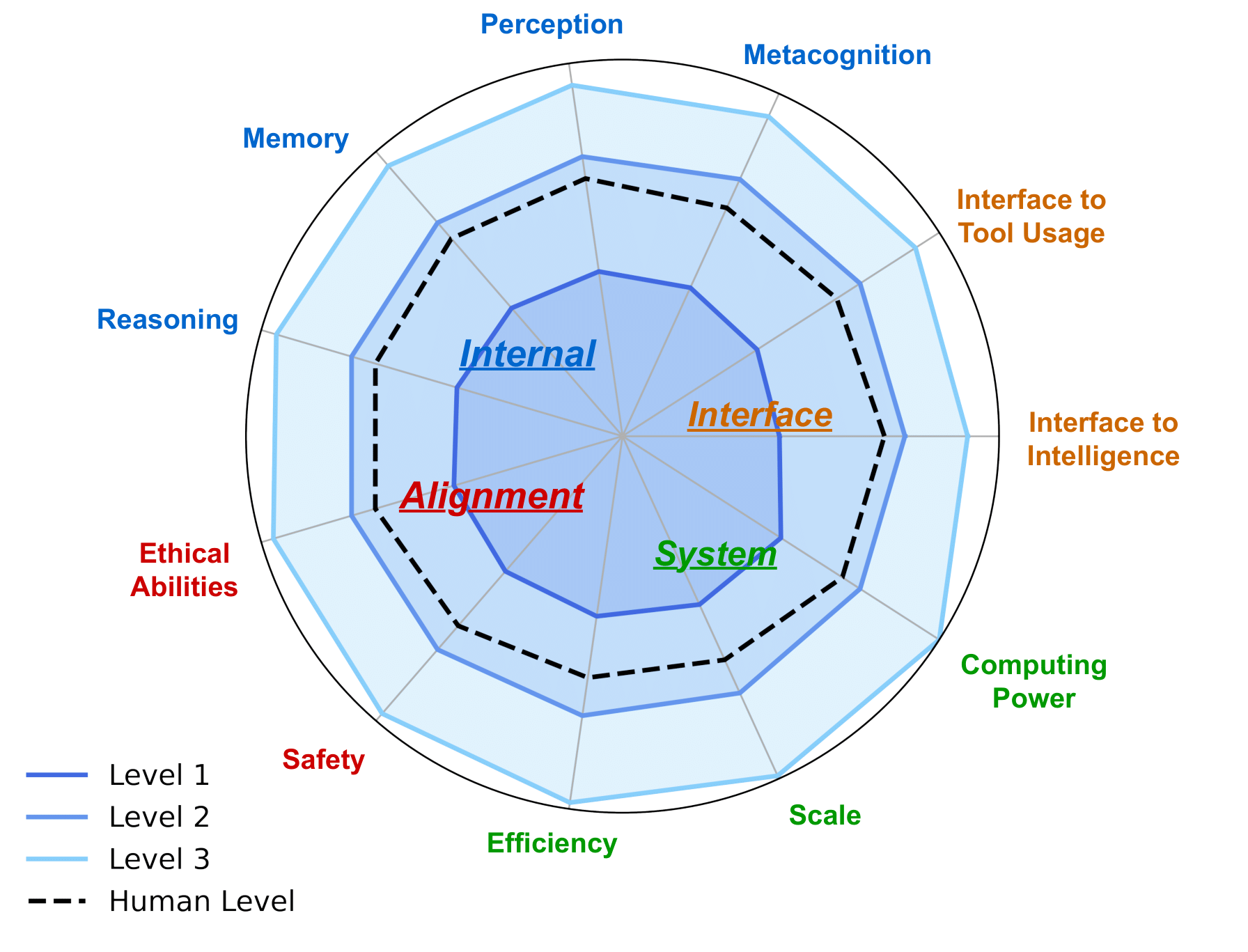

- 2. AGI Internal: AGI の精神を明らかにする

- 2.1 AI の認識

- 2.2 AI推論

- 2.3 AIメモリ

- 2.4 AI メタ認知

- 3. AGI インターフェース: AGI で世界を繋ぐ

- 3.1 AI とデジタル世界のインターフェース

- 3.2 AI と物理世界のインターフェース

- 3.3 AI とインテリジェンスのインターフェース

- 3.3.1 AI エージェントへの AI インターフェース

- 3.3.2 AI と人間のインターフェース

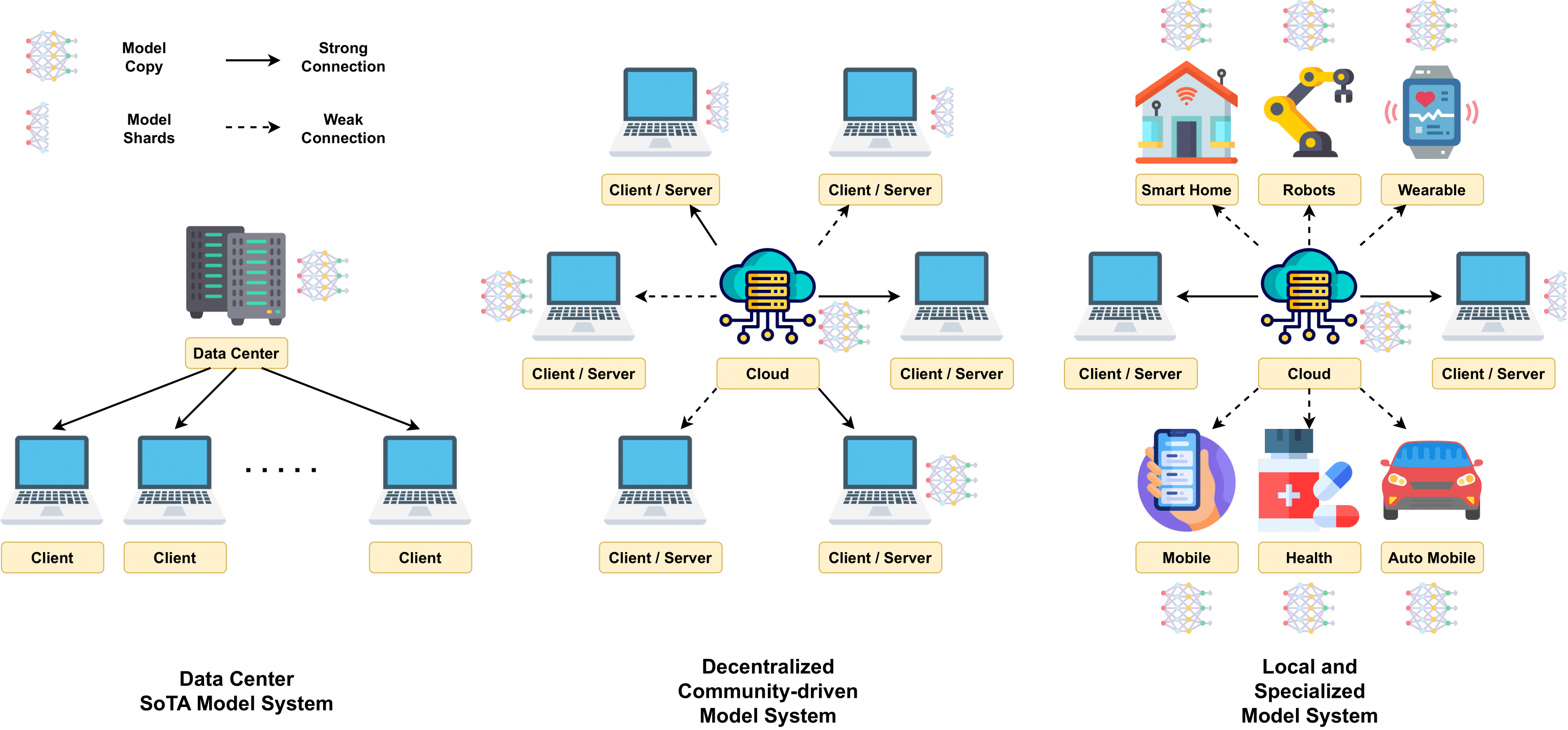

- 4. AGI システム: AGI のメカニズムの実装

- 4.2 スケーラブルなモデルのアーキテクチャ

- 4.3 大規模な訓練

- 4.4 推論手法

- 4.5 コストと効率

- 4.6 コンピューティングプラットフォーム

- 5. AGI の調整: AGI がさまざまなニーズを確実に満たすようにする

- 5.1 AGI アライメントへの期待

- 5.2 現在のアライメント技術

- 5.3 AGI アライメントへのアプローチ方法

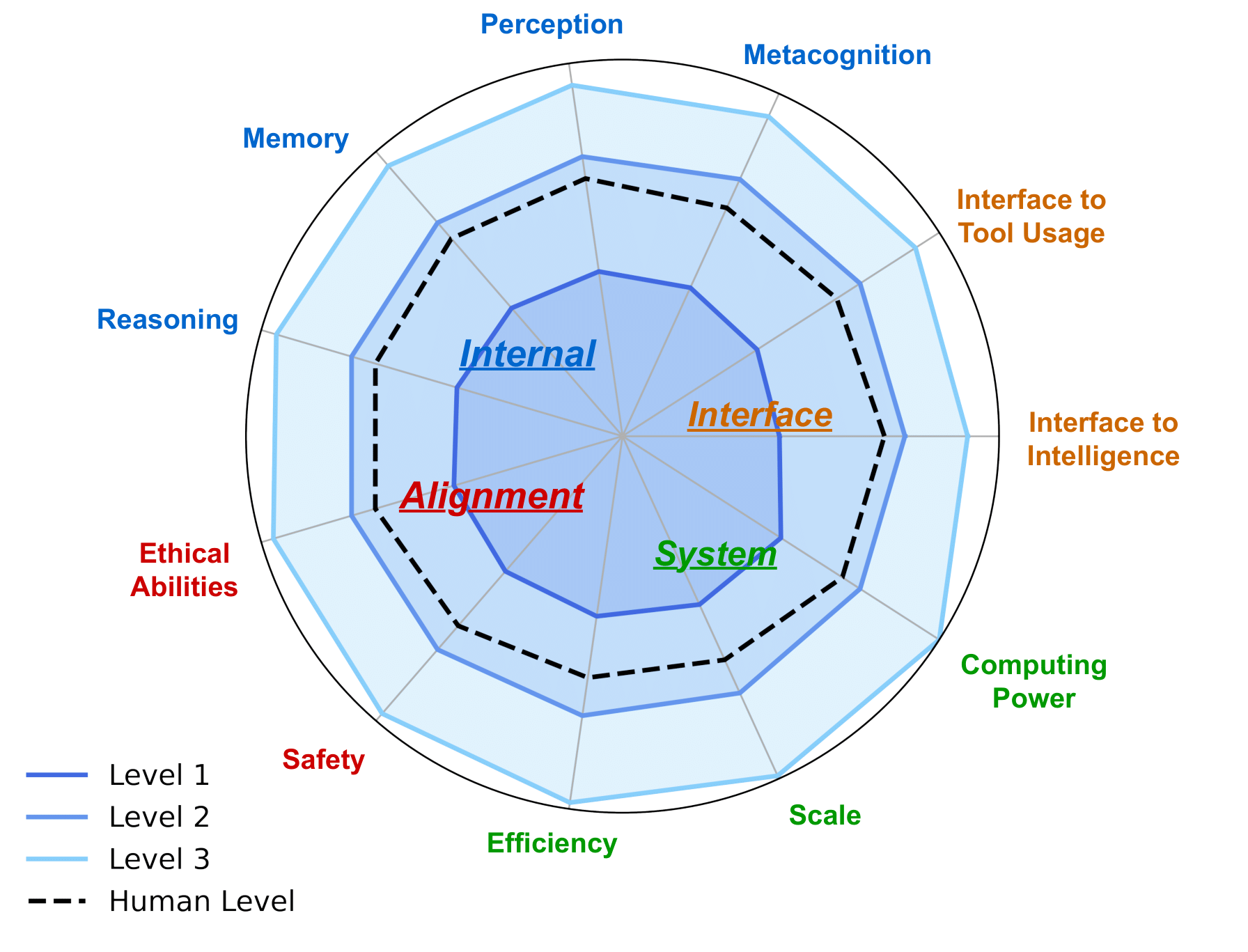

- 6. AGI ロードマップ: AGI への責任あるアプローチ

- 6.1 AI レベル: 人工知能の進化をグラフ化する

- 6.2 AGIの評価

- 6.2.1 AGI評価への期待

- 6.2.2 現在の評価とその限界

- 6.5 AGI開発中のさらなる考慮事項

- 7. ケーススタディ

- 7.1 科学の発見と研究のための AI

- 7.2 生成的視覚知能

- 7.3 ワールドモデル

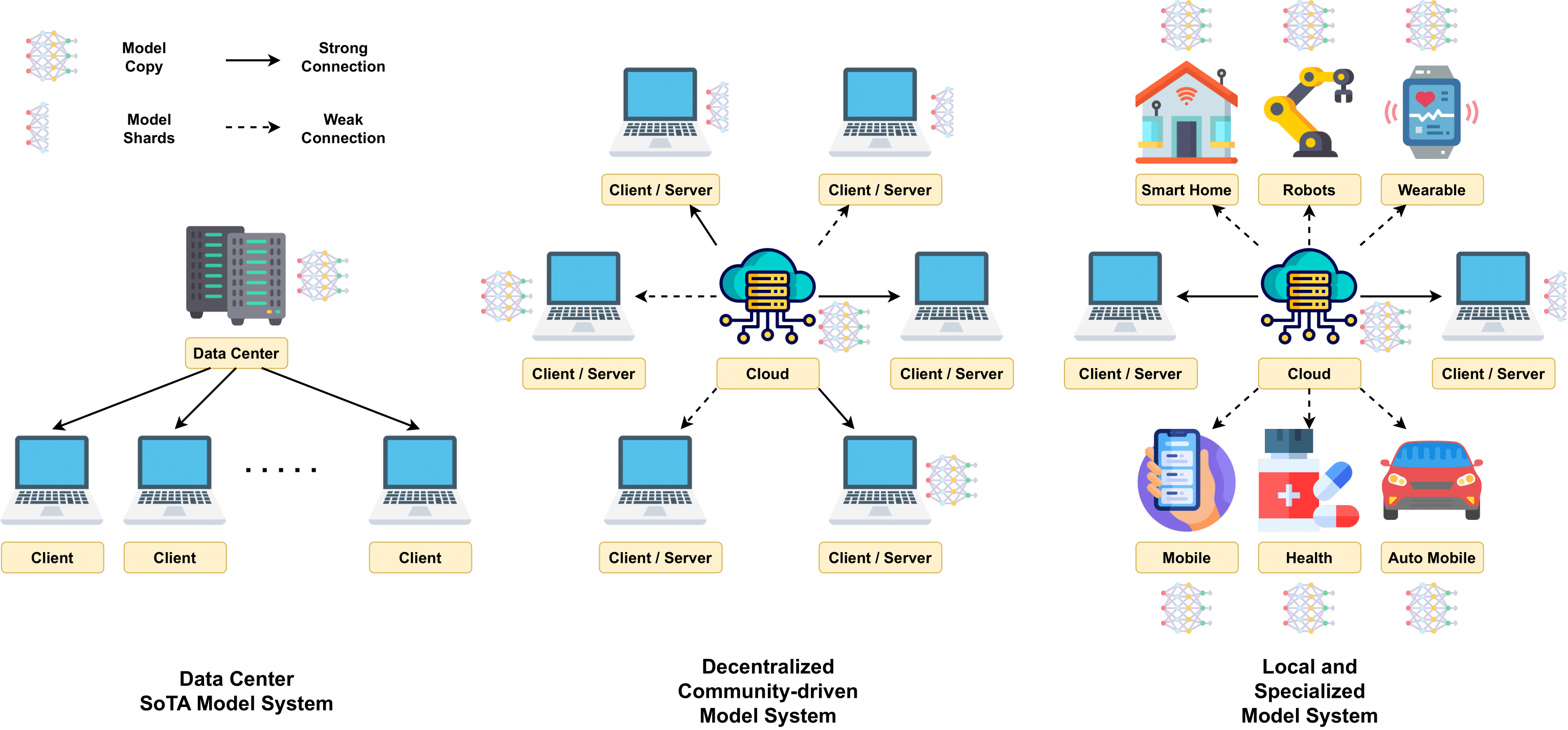

- 7.4 分散型 LLM

- 7.5 コーディングのための AI

- 7.6 現実世界のアプリケーションにおけるロボット工学のための AI

- 7.7 人間とAIのコラボレーション

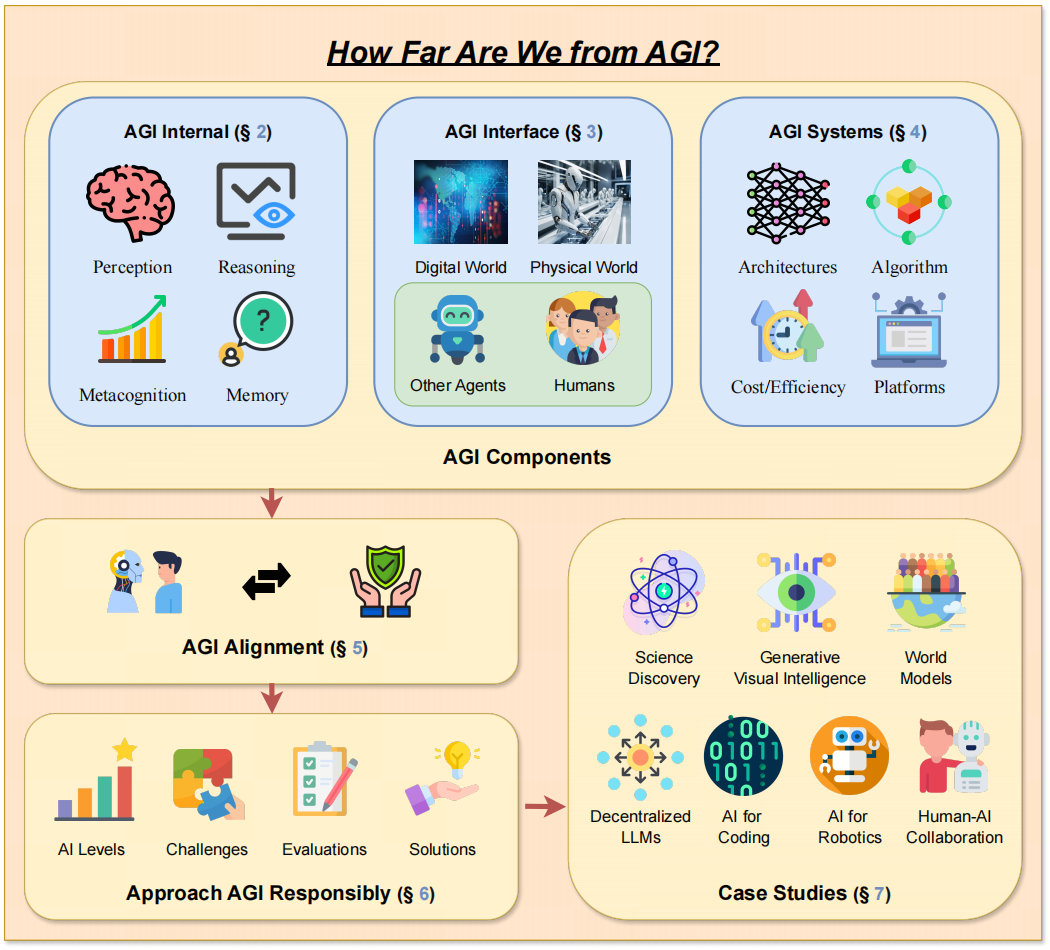

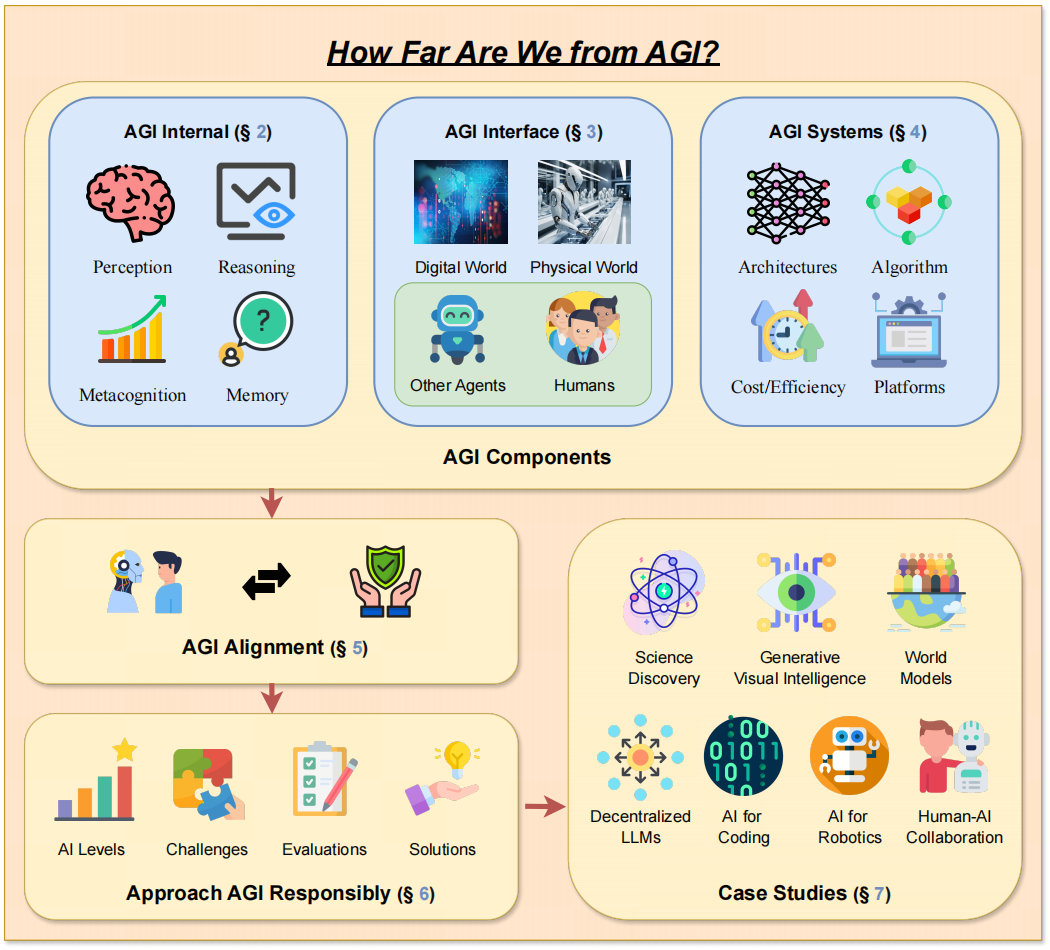

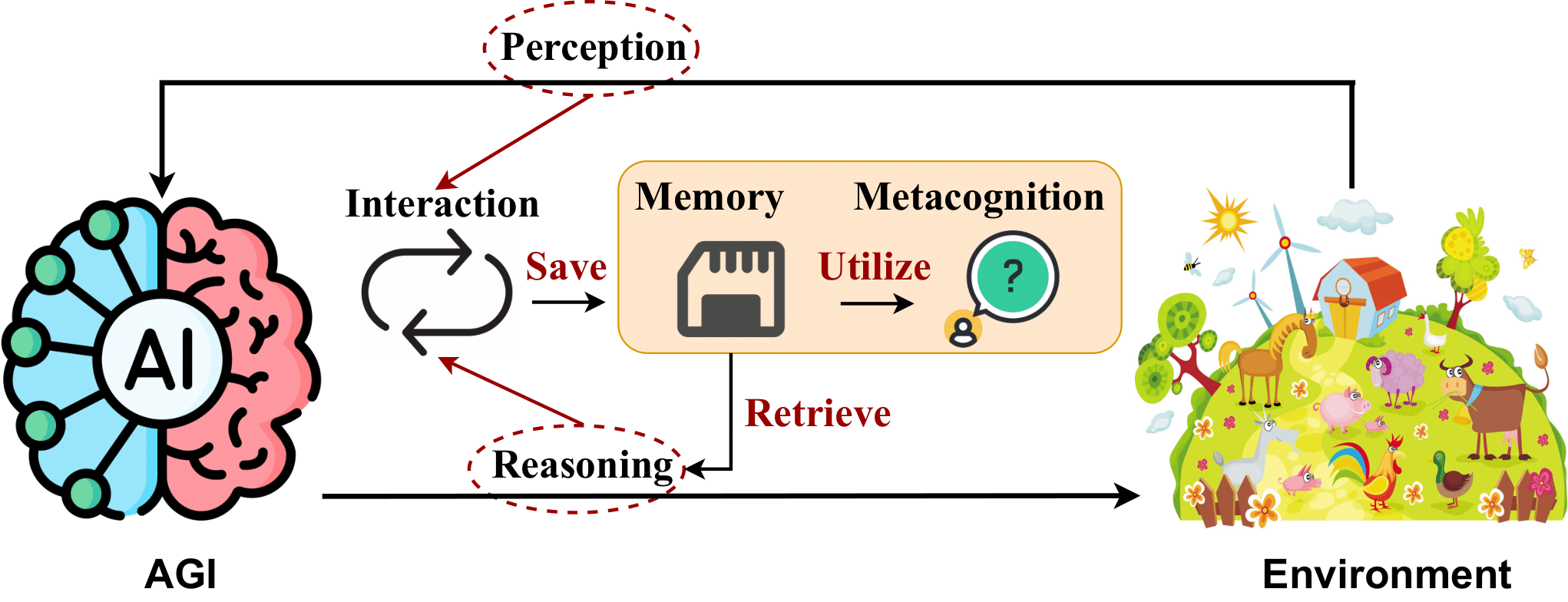

->論文の枠組み設計。 <-

1. はじめに

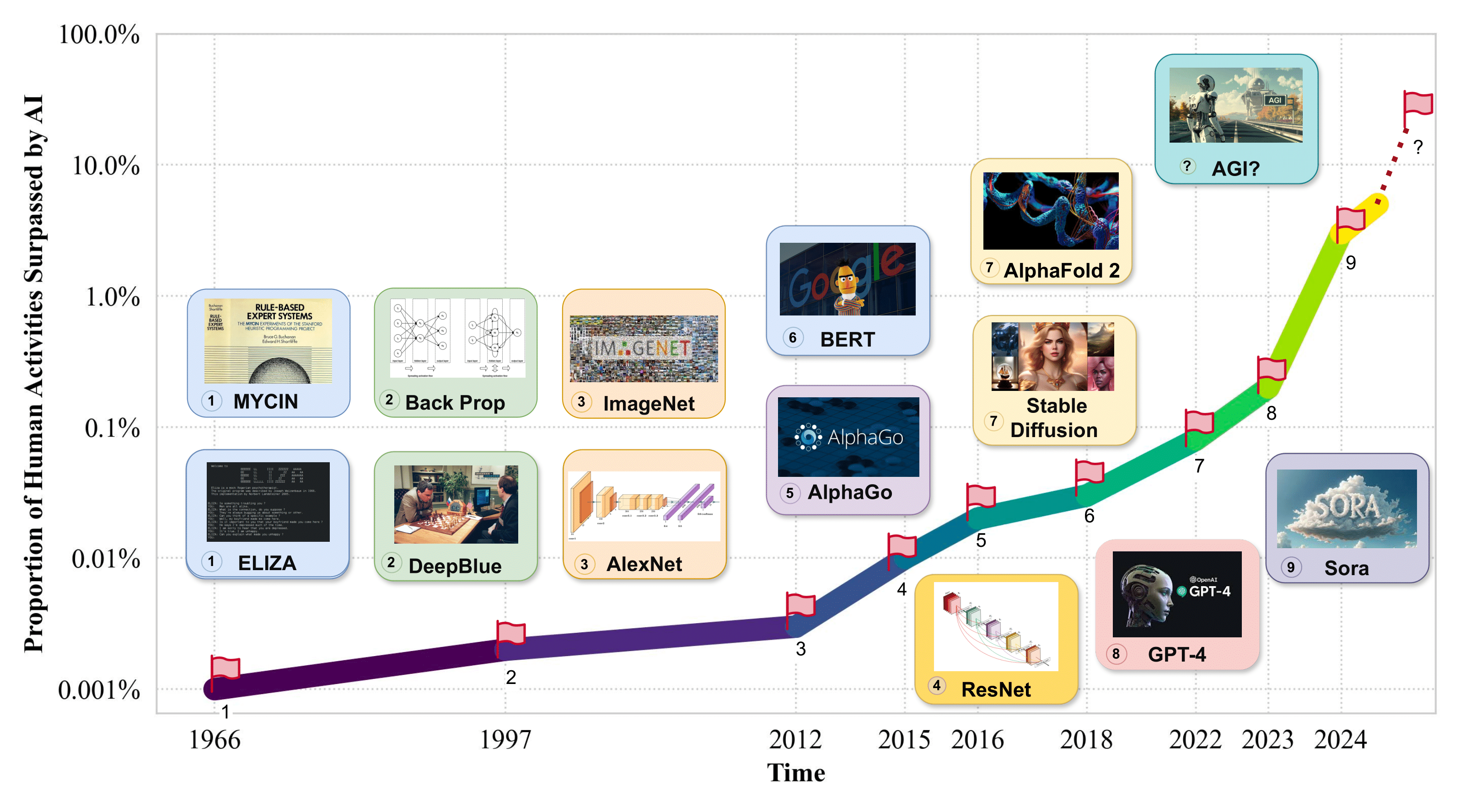

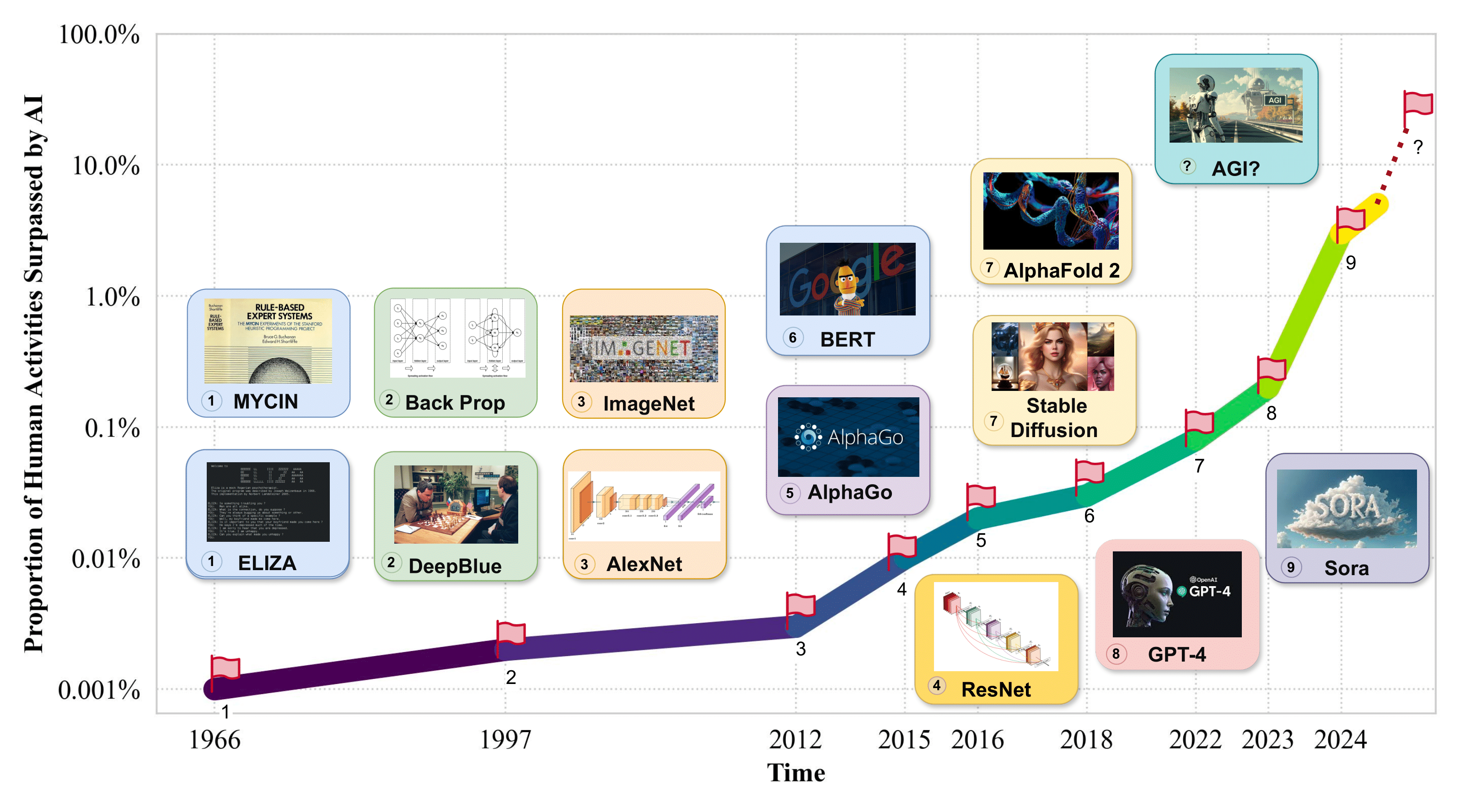

->人間の活動の割合が AI を上回る。 <-

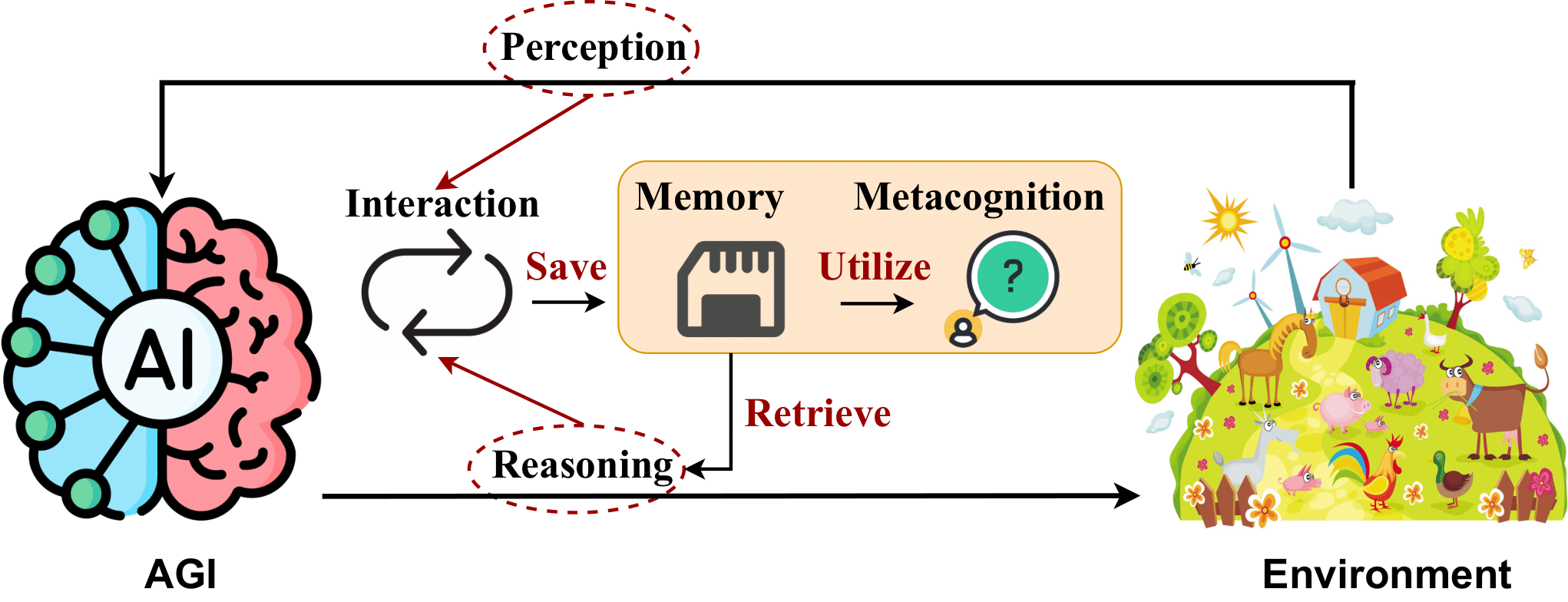

2. AGI Internal: AGI の精神を明らかにする

2.1 AI の認識

- Flamingo: 少数ショット学習のための視覚言語モデル。 Jean-Baptiste Alayrac et al. NeurIPS 2022。[論文]

- BLIP-2: 凍結画像エンコーダーと大規模言語モデルを使用した言語画像事前トレーニングのブートストラップ。ジュンナン・リーら。 ICML 2023。[論文]

- SPHINX: マルチモーダル大規模言語モデルの重み、タスク、および視覚的埋め込みの共同混合。リン・ツィイー 他EMNLP 2023. [論文]

- 視覚的な指示のチューニング。 Haotian Liu et al. NeurIPS 2023。[論文]

- GPT4Tools: 自己指導によるツールの使用を大規模言語モデルに教える。楊瑞 他NeurIPS 2023。[論文]

- Otter: インコンテキスト命令チューニングを備えたマルチモーダル モデル。ボー・リーら。 arXiv 2023. [論文]

- VideoChat: チャット中心のビデオの理解。 KunChang Li et al. arXiv 2023. [論文]

- mPLUG-Owl: モジュール化により、大規模な言語モデルにマルチモダリティが与えられます。 Qinghao Yeら。 arXiv 2023. [論文]

- マルチモーダル大規模言語モデルに関する調査。シュカン・インら。 arXiv 2023. [論文]

- PandaGPT: 1 つのモデルで指示 - すべてに従ってください。 Yixuan Suら。 arXiv 2023. [論文]

- LLaMA アダプター: ゼロ初期化アテンションによる言語モデルの効率的な微調整。張任瑞ら。 arXiv 2023. [論文]

- Gemini: 高度な機能を備えたマルチモーダル モデルのファミリー。ロハン・アニルら。 arXiv 2023. [論文]

- Shikra: マルチモーダル LLM の参照対話マジックを解き放つ。 Keqin Chen et al. arXiv 2023. [論文]

- ImageBind: 1 つの埋め込みスペースですべてをバインドします。ロヒット・ギルダールら。 CVPR 2023。[論文]

- MobileVLM : モバイル デバイス用の高速、強力、オープンなビジョン言語アシスタント。 Xiangxiang Chuら。 arXiv 2023. [論文]

- 大規模な言語モデルに優れたビジュアル トークナイザーを実現するには何が必要ですか? 。 Guangzhi Wang et al. arXiv 2023. [論文]

- MiniGPT-4: 高度な大規模言語モデルによる視覚言語理解を強化します。 Deyao Zhu et al. ICLR 2024. [論文]

- LanguageBind: 言語ベースのセマンティック アライメントによるビデオ言語の事前トレーニングを N モダリティに拡張します。ビン・ジューら。 ICLR 2024. [論文]

2.2 AI推論

- 思考連鎖プロンプトは、大規模な言語モデルで推論を引き出します。ジェイソン・ウェイらNeurIPS 2022。[論文]

- 心の神経理論?大規模LMにおける社会的知性の限界について。マールテン・サップら。 EMNLP 2022. [論文]

- 内なる独白: 言語モデルを使用した計画による身体化された推論。黄文龍ら。 CoRL 2022. [論文]

- 自然言語生成における幻覚に関する調査。 Ziwei Ji et al. ACM コンピューティング調査 2022。[論文]

- ReAct: 言語モデルでの推論と行動の相乗効果。姚舜宇 他ICLR 2023. [論文]

- 分解されたプロンプト: 複雑なタスクを解決するためのモジュール式アプローチ。トゥシャール・コートら。 ICLR 2023. [論文]

- 複雑さに基づいた複数ステップの推論のプロンプト。ヤオ・フーら。 ICLR 2023. [論文]

- 最も少ないプロンプトから最も多いプロンプトにより、大規模な言語モデルで複雑な推論が可能になります。デニー・チョウ他ICLR 2023. [論文]

- 大規模言語モデルでの推論に向けて: 調査。ジエ・ファンら。 ACL 所見 2023。[論文]

- ProgPrompt: 大規模言語モデルを使用した状況依存ロボット タスク プランの生成。イシカ・シンら。 ICRA 2023. [論文]

- 言語モデルによる推論は、世界モデルによる計画です。シボ・ハオ他EMNLP 2023. [論文]

- 大規模視覚言語モデルにおける物体幻覚の評価。 Yifan Li他EMNLP 2023. [論文]

- Tree of Thoughts: 大規模な言語モデルを使用した意図的な問題解決。姚舜宇 他NeurIPS 2023。[論文]

- 自己洗練: 自己フィードバックによる反復的な洗練。アマン・マダーンら。 NeurIPS 2023。[論文]

- 反射: 言語強化学習を備えた言語エージェント。ノア・シンら。 NeurIPS 2023。[論文]

- 説明、説明、計画、選択: 大規模な言語モデルを使用した対話型計画により、オープンワールドのマルチタスク エージェントが可能になります。 Zihao Wangら。 NeurIPS 2023。[論文]

- LLM+P: 最適な計画能力による大規模言語モデルの強化。ボー・リウら。 arXiv 2023. [論文]

- 言語モデル、エージェント モデル、および世界モデル: 機械の推論と計画の法則。 Zhiting Hu et al. arXiv 2023. [論文]

- MMToM-QA: 心の質問応答のマルチモーダル理論。 Chuanyang Jin et al. arXiv 2024. [論文]

- 思考のグラフ: 大規模な言語モデルを使用した複雑な問題の解決。 Maciej Besta et al. AAAI 2024. [論文]

- GSM8K で >97% を達成: 問題を深く理解することで、LLM は完璧な推論者になります。 Qihuang Zhong et al. arXiv 2024. [論文]保留中

2.3 AIメモリ

- オープンドメインの質問応答のための密なパッセージの検索。ウラジミール・カルプキンら。 EMNLP 2020. [論文]

- 知識集約型 NLP タスクのための検索拡張生成。パトリック・ルイスら。 NeurIPS 2020。[論文]

- REALM: 検索拡張言語モデルの事前トレーニング。ケルビン・グーらICML 2020. [論文]

- 検索拡張により、会話中の幻覚が軽減されます。カート・シャスターらEMNLP 調査結果 2021。[論文]

- 数兆のトークンから取得して言語モデルを改善する。セバスチャン・ボルゴーら。 ICML 2022. [論文]

- 生成エージェント: 人間の行動のインタラクティブなシミュレーション。パク・ジュンソンほかUIST 2023。[論文]

- 言語エージェントの認知アーキテクチャ。セオドア・R・サマーズら。 TMLR 2024. [論文]

- Voyager: 大規模な言語モデルを備えたオープンエンドの組み込みエージェント。 Guanzhi Wang et al. arXiv 2023. [論文]

- 大規模言語モデルベースのエージェントの記憶メカニズムに関する調査。 Zeyu Zhangら。 arXiv 2024. [論文]

- 再帰的要約により、大規模な言語モデルでの長期的な対話記憶が可能になります。 Qingyue Wang et al. arXiv 2023. [論文]保留中

2.4 AI メタ認知

- 暗黙知の外部化と組織学習におけるメタ能力の考察。ジョティ・チョードリーらHICSS 2006. [論文]

- 進化した自己教師付きニューラル ネットワークの進化した自己教育による自律型インテリジェンス。ナム・レ。 arXiv 2019. [論文]

- 事前トレーニングされた言語モデルをより優れた少数回学習器にします。 Tianyu Gao他ACL 2021. [論文]

- 言語モデルの性格特性の特定と操作。グラハム・キャロンら。 arXiv 2022. [論文]

- Brainish: 知性と意識のためのマルチモーダル言語の形式化。ポール・リャンらarXiv 2022. [論文]

- 理論的コンピューターサイエンスの観点から見た意識の理論: 意識チューリングマシンからの洞察。レノア・ブルームら。 PNAS 2022。[論文]

- WizardLM: 大規模な言語モデルが複雑な命令に従うことができるようにする。 Can Xuら。 arXiv 2023. [論文]

- Self-Instruct: 言語モデルと自己生成された命令の調整。 Yizhong Wangら。 ACL 2023。[論文]

- ReST と ReAct: マルチステップ推論 LLM エージェントの自己改善が融合しました。レナト・アクシトフら。 arXiv 2023. [論文]

- 大規模言語モデルの文化心理学: ChatGPT は全体論的思考者ですか、それとも分析的思考者ですか? 。 Chuanyang Jin et al. arXiv 2023. [論文]

- 人工知能における意識: 意識の科学からの洞察。パトリック・バトリン他arXiv 2023. [論文]

- 大規模言語モデルにおける心理学的スケールの信頼性の再検討。 Jen-tse Huang他arXiv 2023. [論文]

- 事前トレーニングされた言語モデルでの性格の評価と誘導。 Guangyuan Jiang et al. NeurIPS 2024。[論文]

- AGI のレベル: AGI への道における運用化の進捗。メレディス・リンゲル・モリスほかarXiv 2024. [論文]保留中

- 調査、統合、活用: タスク間エージェントの自己進化のための一般的な戦略。チェン・チアンら。 arXiv 2024. [論文]保留中

3. AGI インターフェース: AGI で世界を繋ぐ

3.1 AI とデジタル世界のインターフェース

- 混合イニシアティブ ユーザー インターフェイスの原則。エリック・ホーヴィッツ。 SIGCHI 1999. [論文]

- 大規模言語モデルベースのエージェントの台頭と可能性: 調査。 Zhiheng Xiら。 arXiv 2023. [論文]

- 基礎モデルを使用したツール学習。チン・ユジアらarXiv 2023. [論文]

- Creator: ツールの作成を通じて、大規模な言語モデルの抽象的推論と具体的推論を解きほぐします。チェン・チアンら。 arXiv 2023. [論文]

- AppAgent: スマートフォン ユーザーとしてのマルチモーダル エージェント。趙陽ら。 arXiv 2023. [論文]

- Mind2Web: Web のジェネラリスト エージェントを目指して。 Xiang Dengら。 NeurIPS ベンチマーク 2023。[論文]

- ToolQA: 外部ツールを使用した LLM 質問応答用のデータセット。 Yuchen Zhuangら。 arXiv 2023. [論文]

- 生成エージェント: 人間の行動のインタラクティブなシミュレーション。パク・ジュンソン ほかarXiv 2023. [論文]

- ツール形成者: 言語モデルはツールの使い方を自ら学習できます。ティモ・シックら。 arXiv 2023. [論文]

- Gorilla: 大規模な API に接続された大規模な言語モデル。シシル・G・パティルら。 arXiv 2023. [論文]

- Voyager: 大規模な言語モデルを備えたオープンエンドの具体化されたエージェント。 Guanzhi Wang et al. arXiv 2023. [論文]

- OS-Copilot: 自己改善を備えたジェネラリスト コンピュータ エージェントに向けて。 Zhiyong Wuら。 arXiv 2024. [論文]

- WebArena: 自律エージェントを構築するための現実的な Web 環境。 Shuyan Zhou 他ICLR 2024. [論文]

- ツール作成者としての大規模な言語モデル。蔡天楽 他ICLR 2024. [論文]

3.2 AI と物理世界のインターフェース

- アマゾンのピッキングチャレンジから得た教訓: ロボットシステム構築の 4 つの側面。クレメンス・エップナーら。 RSS 2016. [論文]

- Perceiver-Actor: ロボット操作のためのマルチタスク トランスフォーマー。モヒト・シュリダールら。 arXiv 2022. [論文]

- Vima: マルチモーダル プロンプトを使用した一般的なロボット操作。ユンファン・ジャンら。 arXiv 2022. [論文]

- 私の言うとおりにではなく、できる限りのことをしてください: 言語をロボットのアフォーダンスにグラウンディングします。マイケル・アンら。 arXiv 2022. [論文]

- Voxposer: 言語モデルを使用したロボット操作のための構成可能な 3D 値マップ。黄文龍ら。 arXiv 2023. [論文]

- MotionGPT: 外国語としての人間の動き。 Biao Jiang et al. arXiv 2023. [論文]

- Rt-2: 視覚-言語-アクション モデルは、ウェブの知識をロボット制御に転送します。アンソニー・ブローハンら。 arXiv 2023. [論文]

- 現実世界のオブジェクトへの移動。テオフィル・ジャーベットら。サイエンス・ロボティクス 2023。[論文]

- Lm-nav: 言語、視覚、およびアクションの大規模な事前トレーニング済みモデルを使用したロボット ナビゲーション。ドゥルブ・シャーら。 CRL 2023。[論文]

- Palm-e: 具現化されたマルチモーダル言語モデル。ダニー・ドリース他arXiv 2023. [論文]

- LLM-Planner: 大規模な言語モデルを使用した身体化されたエージェントのための少数ショットのグラウンデッド プランニング。ソン・チャンヒ他ICCV 2023。[論文]

- Instruct2Act: 大規模言語モデルを使用したロボット アクションへのマルチモダリティ命令のマッピング。 Siyuan Huang他arXiv 2023. [論文]

- DROID: 大規模な野生のロボット操作データセット。アレクサンダー・カザツキーら。 arXiv 2024. [論文]

- BEHAVIOR-1K: 1,000 の日常アクティビティと現実的なシミュレーションを備えた人間中心の身体化 AI ベンチマーク。 Chengshu Li et al. arXiv 2024. [論文]

3.3 AI とインテリジェンスのインターフェース

3.3.1 AI エージェントへの AI インターフェース

- 反事実的なマルチエージェントポリシーの勾配。ヤコブ・フェルスターら。 AAAI 2018. [論文]

- 大規模な言語モデルからの説明により、小規模な推論がより適切になります。 Shiyang Liら。 arXiv 2022. [論文]

- コンテキスト内学習の蒸留: 事前トレーニングされた言語モデルの少数ショット学習能力の転送。 Yukun Huangら。 arXiv 2022. [論文]

- Autoagents: エージェントを自動生成するためのフレームワーク。グアンヤオ・チェンらarXiv 2023. [論文]

- ネストされたマルチエージェント推論のためのニューラル償却推論。クナル・ジャーら。 arXiv 2023. [論文]

- 大規模言語モデルの知識の蒸留。 Yuxian Gu et al. arXiv 2023. [論文]

- Metagpt: マルチエージェント協調フレームワークのためのメタ プログラミング。シルイ・ホンら。 arXiv 2023. [論文]

- 説明、説明、計画、選択: 大規模な言語モデルを使用した対話型の計画により、オープンワールドのマルチタスク エージェントが可能になります。 Zihao Wangら。 arXiv 2023. [論文]

- Agentverse: マルチエージェントのコラボレーションを促進し、エージェントの新たな動作を調査します。ウェイズ・チェンら。 arXiv 2023. [論文]

- 自然言語に基づいた心の社会におけるマインドストーム。諸葛明チェンら。 arXiv 2023. [論文]

- Jarvis-1: メモリ拡張されたマルチモーダル言語モデルを備えたオープンワールド マルチタスク エージェント。 Zihao Wangら。 arXiv 2023. [論文]

- 象徴的な思考連鎖の蒸留: 小さなモデルでも段階的に「考える」ことができます。リウニアン・ハロルド・リー 他ACL 2023。[論文]

- 段階的に蒸留していきます!トレーニング データが少なく、モデル サイズが小さい場合でも、大規模な言語モデルよりも優れたパフォーマンスを発揮します。 Cheng-Yu Hsieh他arXiv 2023. [論文]

- 弱から強への一般化: 弱い監督で強力な能力を引き出す。コリン・バーンズら。 arXiv 2023. [論文]

- 高品質の教育会話を拡張することにより、チャット言語モデルを強化します。ニン・ディンら。 arXiv 2023. [論文]

- GAIA: 一般的な AI アシスタントのベンチマーク。グレゴワール・ミアロン他ICLR 2024. [論文]

- Voyager: 大規模な言語モデルを備えたオープンエンドの具体化されたエージェント。 Guanzhi Wang et al. arXiv 2023. [論文]

- キャメル: 大規模言語モデル社会の「心」探求のためのコミュニケーションエージェント。 Guohao Liら。 arXiv 2023. [論文]

- 複数の報酬を蒸留して自己合理化を調整する。サハナ・ラムナスら。 arXiv 2023. [論文]

- ビジョンのスーパーアライメント: ビジョン基盤モデルの弱から強への一般化。郭建源ら。 arXiv 2024. [論文]

- WebArena: 自律エージェントを構築するための現実的な Web 環境。 Shuyan Zhou他ICLR 2024. [論文]

- 人間の監督を最小限に抑えながら、原則に基づいてゼロから言語モデルを自己調整します。 Zhiqing Sun et al. NeurIPS 2024。[論文]

- Mind2web: Web のジェネラリスト エージェントを目指して。 Xiang Dengら。 NeurIPS 2024。[論文]

- 一般的なコンピュータ制御に向けて: ケーススタディとしてのレッド・デッド・リデンプション ii のマルチモーダル・エージェント。ウェイハオ・タンら。 arXiv 2024. [論文]

3.3.2 AI と人間のインターフェース

- 人間と AI のインタラクションに関するガイドライン。サレマ・アメルシら。 CHI 2019. [論文]

- 生成 AI アプリケーションの設計原則。ジャスティン・D・ワイズらCHI 2024. [論文]

- Graphologue: インタラクティブな図を使用した大規模言語モデルの応答の探索。 Peiling Jiang et al. UIST 2023。[論文]

- Sensecape: 大規模な言語モデルを使用したマルチレベルの探索とセンスメイキングの有効化。 Sangho Suh et al. UIST 2023。[論文]

- 大規模な言語モデル出力のセンスメイキングをサポートします。ケイティ・イロンカ・ゲロ他CHI 2024. [論文]

- Luminate: 人間と AI の共創のための大規模言語モデルを使用した設計空間の構造化生成と探索。 Sangho Suh et al. CHI 2024. [論文]

- AI チェーン: 大規模な言語モデル プロンプトを連鎖することによる、透過的で制御可能な人間と AI の相互作用。 Tongshuang Wu et al. CHI 2022. [論文]

- Promptify: 大規模な言語モデルを使用した対話型プロンプト探索によるテキストから画像への生成。スティーブン・ブレイドら。 CHI 2023. [論文]

- ChainForge: プロンプト エンジニアリングおよび LLM 仮説テスト用のビジュアル ツールキット。イアン・アラウジョら。 CHI 2024. [論文]

- CoPrompt: 共同自然言語プログラミングにおけるプロンプトの共有と参照のサポート。李峰ら。 CHI 2024. [論文]

- 大規模な言語モデルを使用した UI モックアップに対する自動フィードバックの生成。 Peitong Duan et al. CHI 2024. [論文]

- Rambler: LLM 支援要点操作による音声による執筆のサポート。スーザン・リンら。 CHI 2024. [論文]

- 大規模な言語モデルの Extended Reality への埋め込み: インクルージョン、エンゲージメント、およびプライバシーの機会と課題。エフェ・ボズキルら。 arXiv 2024. [論文]

- GenAssist: 画像生成をアクセス可能にする。許ミナ 他UIST 2023。[論文]

- 「入力が少ないほど良い」: AI 言語モデルが AAC ユーザーのコミュニケーションをどのように強化または妨げるか。ステファニー・バレンシア 他CHI 2023. [論文]

- 人間と AI のインタラクションの設計が独特に難しいかどうか、なぜ、どのように難しいかを再検討する。銭楊ら。 CHI 2020. [論文]

4. AGI システム: AGI のメカニズムの実装

4.2 スケーラブルなモデルのアーキテクチャ

- 法外に大規模なニューラル ネットワーク: まばらにゲートされた専門家の混合層。ノーム・シャジーアら。 arXiv 2017. [論文]

- トランスフォーマーは RNN (線形アテンションを備えた高速自己回帰トランスフォーマー) です。アンゲロス・カタロプロスら。 arXiv 2020. [論文]

- Longformer: Long-Document Transformer 。イズ・ベルタジーらarXiv 2020. [論文]

- LightSeq: Transformers 用の高性能推論ライブラリ。王暁輝ら。 arXiv 2021. [論文]

- スイッチ トランスフォーマー: シンプルで効率的なスパース性を備えた 1 兆パラメータ モデルへのスケーリング。ウィリアム・フェダスら。 arXiv 2022. [論文]

- 構造化状態空間を使用した長いシーケンスの効率的なモデル化。アルバート・グーらarXiv 2022. [論文]

- MegaBlocks: 複数の専門家による効率的なスパース トレーニング。トレバー・ゲイルら。 arXiv 2022. [論文]

- コンピューティングに最適な大規模言語モデルのトレーニング。ジョーダン・ホフマンらarXiv 2022. [論文]

- 基礎モデルの効果的なロングコンテキスト スケーリング。ウェンハン・シオンら。 arXiv 2023. [論文]

- ハイエナ階層: より大規模な畳み込み言語モデルに向けて。マイケル・ポーリらarXiv 2023. [論文]

- Stanford Alpaca: 指示に従う LLaMA モデル。ロハン・タオリ他GitHub 2023。 [コード]

- Rwkv: トランスフォーマー時代に向けた RNN の再発明。ボー・ペンら。 arXiv 2023. [論文]

- Deja Vu: 推論時の効率的な LLM のコンテキストのスパース性。 Zichang Liuら。 arXiv 2023. [論文]

- Flash-LLM: 非構造化スパース性を使用した、コスト効率が高く効率の高い大規模な生成モデル推論を可能にします。シア・ハオジュン他arXiv 2023. [論文]

- ByteTransformer: 可変長入力用に強化された高性能トランスフォーマー。 Yujia Zhai他arXiv 2023. [論文]

- Tutel: 大規模な適応的な専門家の混合。ファン・チャンホ他arXiv 2023. [論文]

- Mamba: 選択的状態空間を使用した線形時間シーケンス モデリング。アルバート・グー、トリ・ダオ。 arXiv 2023. [論文]

- ハングリー・ハングリー・カバ: 状態空間モデルによる言語モデリングに向けて。ダニエル・Y・フーらarXiv 2023. [論文]

- Retentive Network: 大規模言語モデル用の Transformer の後継。 Sun Yutao et al. ArXiv、2023 年。

- ハイブリッド アーキテクチャの機構設計とスケーリング。マイケル・ポーリらarXiv 2024. [論文]

- 自己回帰言語モデルの知識蒸留の再考。 Qihuang Zhong et al. arXiv 2024. [論文]

- DB-LLM: 効率的な LLM のための正確なデュアル 2 値化。ホン・チェンら。 arXiv 2024. [論文]

- クロスレイヤーアテンションによる Transformer Key-Value キャッシュ サイズの削減。ウィリアム・ブランドンら。 arXiv 2024.[論文]

- キャッシュは 1 回だけ: 言語モデルのデコーダ-デコーダ アーキテクチャYutao Sun他arXiv 2024. [論文]

4.3 大規模な訓練

- サブリニアなメモリコストでディープネットをトレーニングします。 Tianqi Chen et al. arXiv 2016. [論文]

- ディープ ニューラル ネットワークのデータとモデルの並列処理を超えて。 Zhihao Jiaら。 arXiv 2018. [論文]

- GPipe: パイプライン並列処理を使用した巨大ニューラル ネットワークの効率的なトレーニング。黄延平ら。 arXiv 2019. [論文]

- NLP のためのパラメータ効率の高い転移学習。ニール・ホールズビーらICML 2019.論文

- Megatron-LM: モデル並列処理を使用した数十億のパラメーター言語モデルのトレーニング。モハマド・シューイビら。 arXiv 2020. [論文]

- Alpa: 分散深層学習のためのオペレーター間およびオペレーター内の並列処理の自動化。 Lianmin Zheng et al. arXiv 2022. [論文]

- DeepSpeed 推論: 前例のない規模でのトランスフォーマー モデルの効率的な推論を可能にします。レザ・ヤズダニ・アミナバディ 他arXiv 2022. [論文]

- 過学習を伴わない記憶: 大規模言語モデルのトレーニング ダイナミクスの分析。クシャル・ティルマラら。 arXiv 2022. [論文]

- SWARM 並列処理: 大規模モデルのトレーニングは驚くほど通信効率が高くなります。マックス・リャビニンら。 arXiv 2023. [論文]

- さまざまなスケールにわたる言語モデルのトレーニングの軌跡。夏孟州ら。 arXiv 2023. [論文]

- HexGen: 異種分散環境における基盤モデルの生成推論。ヨウヘ・ジャンら。 arXiv 2023. [論文]

- FusionAI: 大規模な消費者レベルの GPU を使用した LLM の分散トレーニングとデプロイ。 Zhenheng Tang et al. arXiv 2023. [論文]

- ほぼ無限のコンテキストに対するブロック単位のトランスフォーマーを使用して注意を喚起します。ハオ・リウら。 arXiv 2023. [論文]

- Pythia: トレーニングとスケーリングにわたって大規模な言語モデルを分析するためのスイート。ステラ・ビダーマンらarXiv 2023. [論文]

- 保証付きのアクティベーション圧縮を使用して、低速ネットワーク上で言語モデルを微調整します。 Jue Wang et al. arXiv 2023. [論文]

- LLaMA アダプター: ゼロ初期化アテンションによる言語モデルの効率的な微調整。張任瑞ら。 arXiv 2023. [論文]

- QLoRA: 量子化 LLM の効率的な微調整。ティム・デットマーズら。 arXiv 2023. [論文]

- PagedAttendance を使用した大規模言語モデルの効率的なメモリ管理。クォン・ウソク ほかarXiv 2023. [論文]

- Infinite-LLM: Disttention および Distributed KVCache を使用した長いコンテキスト向けの効率的な LLM サービス。ビン・リンら。 arXiv 2024. [論文]

- OLMo: 言語モデルの科学を加速する。ダーク・グローネフェルドら。 arXiv 2024. [論文]

- 大規模深層学習モデルの効率的なトレーニングについて: 文献レビュー。リー・シェンら。 arXiv 2023. [論文]保留中

4.4 推論手法

- Flashアテンション: IO 認識を備えた高速でメモリ効率の高い正確なアテンション。トリ・ダオら。 NeurIPS 2022。[論文]

- ドラフトと検証: 自己投機的デコーディングによるロスレス大規模言語モデルの高速化。ジャン・ジュンら。 arXiv 2023. [論文]

- 効率的な生成大規模言語モデルの提供に向けて: アルゴリズムからシステムまでの調査。 Xupeng Miaoら。 arXiv 2023. [論文]

- FlashDecoding++: GPU での大規模言語モデル推論の高速化。ケ・ホンら。 arXiv 2023. [論文]

- 投機的デコーディングによるトランスフォーマーからの高速推論。ヤニフ・リヴァイアサンら。 arXiv 2023. [論文]

- 大規模な言語モデルに対応する高速分散推論。ウー・ビンヤンら。 arXiv 2023. [論文]

- S-LoRA: 数千の同時 LoRA アダプターにサービスを提供します。イン・シェンら。 arXiv 2023. [論文]

- TensorRT-LLM: 最適化された大規模言語モデル推論のための TensorRT ツールボックス。エヌビディア。 GitHub 2023。 [コード]

- Punica: マルチテナント LoRA サービス。 Lequn Chen et al. arXiv 2023. [論文]

- S$^3: 生成推論中の GPU 使用率を高めてスループットを向上させます。ユンホ・ジンほかarXiv 2023. [論文]

- 数千の微調整された LLM に拡張できるマルチ LoRA 推論サーバー。プレディベース。 GitHub 2023。 [コード]

- プロンプト ルックアップ デコード。アプールフ・サクセナ。 GitHub 2023。 [コード]

- FasterTransformer 。エヌビディア。 GitHub 2021. [論文]

- DeepSpeed-FastGen: MII および DeepSpeed-Inference を介した LLM 用の高スループット テキスト生成。コナー・ホームズら。 arXiv 2024. [論文]

- SpecInfer: ツリーベースの推論と検証による生成大規模言語モデルの高速化。 Xupeng Miaoら。 arXiv 2024. [論文]

- Medusa: 複数のデコード ヘッドを備えたシンプルな LLM 推論高速化フレームワーク。蔡天楽 他arXiv 2024. [論文]

- モデルは何を破棄すべきかを示します: LLM の適応 KV キャッシュ圧縮。スユ・ゲら。 ICLR 2024. [論文]

- アテンション シンクを備えた効率的なストリーミング言語モデル。 Guangxuan Xiaoら。 ICLR 2024. [論文]

- DeFT: 効率的なツリー検索ベースの LLM 推論のための IO 認識を備えたフラッシュ ツリー アテンション。ヤオ・ジンウェイら。 arXiv 2024. [論文]

- SGLang を使用した大規模な言語モデルの効率的なプログラミング。 Lianmin Zheng et al. arXiv 2023. [論文]

- 速度: 効率的なデコードのための投機的パイプライン実行。コールマン・フーパーらarXiv 2023. [論文]

- Sequoia: スケーラブルで堅牢なハードウェア対応の投機的デコーディング。 Zhuoming Chen et al. arXiv 2024. [論文]保留中

4.5 コストと効率

- デモンストレーション、検索、予測: 知識集約型 NLP のための検索モデルと言語モデルの構築。オマル・ハッタブら。 arXiv 2023. [論文]

- 自動機械学習: 方法、システム、課題。フランク・ヒッターら。シュプリンガー出版社、2019 年。

- モデル スープ: 複数の微調整されたモデルの重みを平均することで、推論時間を増加させることなく精度が向上します。ミッチェル・ワーツマンら。 arXiv 2022. [論文]

- Shapley によるデータ デバッグはエンドツーエンドの機械学習パイプラインよりも重要です。ボージャン・カルラシュら。 arXiv 2022. [論文]

- 大規模言語モデル生成推論のためのコスト効率の高いハイパーパラメータの最適化。チー・ワンら。 arXiv 2023. [論文]

- 大規模な言語モデルは人間レベルのプロンプト エンジニアです。周永超ら。 arXiv 2023. [論文]

- タスクサブスペース内のモデルのマッチングによるマージ。デレク・タムら。 arXiv 2023. [論文]

- タスク演算によるモデルの編集。ガブリエル・イルハルコら。 arXiv 2023. [論文]

- PriorBand: 深層学習時代の実践的なハイパーパラメータの最適化。 Neeratyoy Mallik et al. arXiv 2023. [論文]

- マルチモーダルモデルマージの実証的研究。 Yi-Lin Sung et al. arXiv 2023. [論文]

- DSPy: 宣言型言語モデル呼び出しを自己改善パイプラインにコンパイルする。オマル・ハッタブら。 arXiv 2023. [論文]

- FrugalGPT: コストを削減し、パフォーマンスを向上させながら大規模な言語モデルを使用する方法。 Lingjiao Chen et al. arXiv 2023. [論文]

- 効率的な LLM を推論するためのタンデムトランスフォーマー。アイシュワリヤー PS et al. arXiv 2024. [論文]

- AIOS: LLM エージェント オペレーティング システム。カイ・メイら。 arXiv 2024. [論文]

- LoraHub: 動的な LoRA 構成による効率的なクロスタスクの一般化。 Chengsong Huang et al. arXiv 2024. [論文]

- 大規模言語モデル時代の AutoML: 現在の課題、将来の機会とリスク。アレクサンダー・トルネデら。 arXiv 2024. [論文]

- 専門家を 1 つに統合: 専門家混合の計算効率の向上。シュワイ・ヘら。 EMNLP 2023. [論文]保留中

4.6 コンピューティングプラットフォーム

- TVM: 深層学習用の自動化されたエンドツーエンド最適化コンパイラー。 Tianqi Chen et al. arXiv 2018. [論文]

- TPU v4: 組み込みのハードウェア サポートを備えた機械学習用の光学的に再構成可能なスーパーコンピューター。ノーマン P. ジュッピ 他arXiv 2023. [論文]

5. AGI の調整: AGI がさまざまなニーズを確実に満たすようにする

5.1 AGI アライメントへの期待

- 人間との互換性: 人工知能と制御の問題。スチュアート・ラッセル。バイキング、2019年。

- 人工知能、価値観、調整。イアソン・ガブリエル心と機械、2020年。[論文]

- 言語エージェントの調整。ザカリー・ケントン他arXiv、2021. [論文]

- 価値学習の問題。ネイト・ソアレス。機械知能研究所技術報告書[論文]

- AIの安全性における具体的な問題。ダリオ・アモデイらarXiv、2016年。[論文]

- 言語モデルによる危害の倫理的および社会的リスク。ローラ・ヴァイディンガーら。 arXiv、2021年。[論文]

- 確率的オウムの危険性について: 言語モデルは大きすぎる可能性がありますか? 。エミリー・M・ベンダーらFAccT 2021. [論文]

- AI 倫理ガイドラインの世界的な状況。アンナ・ジョビンらNature Machine Intelligence、2019年。[論文]

- 大規模言語モデルにおける永続的な反イスラムバイアス。アブバカール・アビッドら。 AIES、2021年。[論文]

- ジェンダーを含めた相互参照の解決に向けて。ヤン・トリスタ・カオ他ACL、2020年。[論文]

- 自然言語処理の社会的影響。ダーク・ホーヴィら。 ACL 2016. [論文]

- TruthfulQA: モデルが人間の虚偽をどのように模倣するかを測定します。ステファニー・リン他ACL 2022。[論文]

- GPT-3 と高度な神経言語モデルの急進化のリスク。クリス・マクガフィー他arXiv、2020年。[論文]

- LLM 時代の AI の透明性: 人間中心の研究ロードマップ。 Q.ベラ・リャオら。 arXiv 2023. [論文]

- 専門知識と役割を超えて: 解釈可能な機械学習の関係者とそのニーズを特徴付けるフレームワーク。ハリニ・スレシュら。 CHI 2021. [論文]

- 生成 AI のセキュリティ リスクの特定と軽減。クラーク・バレットら。 arXiv、2023年。[論文]

- LLM エージェントは自律的に Web サイトをハッキングできます。リチャード・ファング他arXiv、2024年。[論文]

- ディープフェイク、骨相学、監視など! AI プライバシー リスクの分類。ハオピン・リー他CHI 2024. [論文]

- AI 時代のプライバシー。ソーヴィク・ダスら。 ACM のコミュニケーション、2023 年。[論文]

5.2 現在のアライメント技術

- 人間のフィードバックを使って要約する方法を学びます。ニサン・スティエノンら。 NeurIPS 2020。[論文]

- 考え直してみるのが最善です。テキスト編集から人間の価値観と再調整する方法を学びます。 Ruibo Liu et al. NeurIPS 2022。[論文]

- 人間のフィードバックによる指示に従うように言語モデルをトレーニングします。欧陽龍ら。 NeurIPS 2022。[論文]

- 内なる悪魔を解き放つ: 言語モデルの自己解毒。 Canwen Xuら。 AAAI 2022. 論文

- 生成言語モデルを人間の価値観に合わせる。 Ruibo Liu et al. NAACL 2022. [論文]

- 人間のフィードバックからの強化学習を使用して、有益で無害なアシスタントをトレーニングします。ユンタオ・バイら。 arXiv 2022. [論文]

- AI の憲法: AI フィードバックによる無害性。ユンタオ・バイら。 arXiv 2022. [論文]

- Raft: 生成基盤モデルの調整のための報酬ランク付け微調整。ドン・ハンゼら。 arXiv 2023. [論文]

- アドバンテージベースのオフライン ポリシー グラデーションによる言語モデルの改善。アシュトシュ・バヘティら。 arXiv 2023. [論文]

- 大規模な言語フィードバックによる言語モデルのトレーニング。ジェレミー・シューラー 他arXiv 2023. [論文]

- 人間の好みからの学習を理解するための一般的な理論的パラダイム。モハマド・ゲシュラギ・アザールら。 arXiv 2023. [論文]

- ステップごとに確認してみましょう。ハンター・ライトマンら。 arXiv 2023. [論文]

- 人間のフィードバックからの強化学習の未解決の問題と基本的な制限。スティーブン・キャスパーらarXiv 2023. [論文]

- 合成フィードバックによる大規模な言語モデルの調整。キム・ソンドン他arXiv 2023. [論文]

- RLAIF: AI フィードバックによる人間のフィードバックからの強化学習の拡張。ハリソン・リー 他arXiv 2023. [論文]

- 人間の調整のための優先順位の最適化。フェイファン・ソング他arXiv 2023. [論文]

- マルチエージェントディベートによる言語モデルの事実性と推論の改善。 Yilun Duら。 arXiv 2023. [論文]

- 大規模な言語モデルの調整: 調査。シェン・ティアンハオらarXiv 2023. [論文]

- 直接的な好みの最適化: 言語モデルは密かに報酬モデルです。ラファエル・ラファイロフら。 NeurIPS 2024。[論文]

- リマ: 調整には、少ないほど効果的です。 Chuting Zhou et al. NeurIPS 2024。[論文]

5.3 AGI アライメントへのアプローチ方法

- 言語による危害の倫理的および社会的リスク。メラー・ヴァイディンガーら。 arXiv 2021. [論文]

- 北京AI安全性国際コンセンサス。北京人工知能アカデミー。 2024年。[論文]

- ブラックボックスを開けずに反事実的な説明: 自動化された意思決定と GDPR 。サンドラ・ワハターら。ハーバード法学ジャーナル、2017年。[論文]

- 報酬モデリングを介したスケーラブルエージェントアライメント:研究の方向。 Jan Leike et al。 Arxiv 2018。[紙]

- 人工知能に倫理を構築します。 Han Yu et al。 IJCAI2018。Paper

- 人間の互換性:人工知能とコントロールの問題。スチュアートラッセル。バイキング、2019年。[紙]

- 責任ある人工知能:AIを責任ある方法で開発および使用する方法。バージニア・ディナーム。 Springer Nature、2019。[紙]

- 機械倫理:倫理的AIおよび自律システムの設計とガバナンス。アランF.ウィンフィールドら。 IEEEの議事録、2019年。[論文]

- 協同AIのオープンな問題。 Allan Dafoe et al。 Arxiv 2020。[紙]

- 人工知能、価値、およびアライメント。イアソン・ガブリエル。心と機械、2020年。[紙]

- 協同組合AI:マシンは共通の基盤を見つけることを学ぶ必要があります。 Allan Dafoe et al。自然2021。[紙]

- 機械の道徳、道徳的進歩、迫り来る環境災害。 Ben Kenward et al。 arxiv2021。[紙]

- AI研究のXリスク分析。 Dan Hendrycks et al。 arxiv2022。[紙]

- スケーラブル監視のためのタスク分解(AGISF蒸留) 。 Charbel-RaphaëlSegerie。ブログ2023。[ブログ]

- 弱くて強力な一般化:監督が弱い強力な能力を引き出す。 Collin Burns、 et al。 arxiv2023。[紙]

- 言語モデルは誰の意見を反映していますか? 。 Shibani Santurkar et al。 ICML 2023。[紙]

- AIアライメント:包括的な調査。 Jiaming Ji et al。 arxiv2023。[紙]

- 人間のフィードバックからの強化学習の未解決の問題と基本的な制限。 Stephen Casper et al。 arxiv2023。[紙]

- ベースLLMSのロック解除スペル:コンテキスト内学習を介してアライメントを再考します。ビル・ユシェン・リン等。 arxiv2023。[紙]

- 大規模な言語モデルアライメント:調査。 Tianhao Shen et al。 arxiv2023。[紙]

6。AGIロードマップ:責任を持ってAGIに近づいています

6.1 AIレベル:人工知能の進化のチャート

- 人工的な一般情報の火花:GPT-4を使用した初期の実験。 SébastienBubecket al。 arxiv2023。[紙]

- AGIのレベル:AGIへのパスでの進捗状況の運用。メレディス・リンゲル・モリス等。 arxiv2024。[紙]

6.2 AGI評価

6.2.1 AGI評価への期待

- 機械学習のエネルギーと二酸化炭素排出量の体系的な報告に向けて。ピーター・ヘンダーソン等。 Journal of Machine Learning Research、2020。

- グリーンAI 。 ACMのRoy Schwartz Communications、2020。

- コードでトレーニングされた大きな言語モデルの評価。マークチェン等。ジャーナルなし、2021。

- 大規模なWebtext Corporaの文書化:巨大なクリーンクロールされたコーパスに関するケーススタディ。 Jesse Dodge et al。 arxiv2021。[紙]

- 基礎モデルの機会とリスクについて。 Rishi Bommasani et al。 arxiv2021。[紙]

- メタ学習ニューラルネットワークを介した人間のような系統的一般化。 Brenden M Lake et al。自然、2023。[紙]

- スーパーベンチは、オープンでLLMを測定しています:重要な分析。スーパーベンチチーム。 ARXIV 2023。

- 言語モデルのホリスティック評価。 Percy Liang et al。 arxiv2023。[紙]

6.2.2現在の評価とその制限

- 分隊:テキストの機械的理解のための100,000以上の質問。 Pranav Rajpurkar et al。 Arxiv 2016。[紙]

- Triviaqa:読解力のための大規模な遠い監視付きチャレンジデータセット。マンダルジョシら。 Arxiv 2017。[紙]

- Coqa:会話の質問回答チャレンジ。 Siva Reddy et al。計算言語学会協会のトランザクション、2019年。

- 正確で信頼性が高く、速い堅牢性評価。 Wieland Brendel et al。 Neurips 2019。[紙]

- 大規模なマルチタスク言語の理解の測定。 Dan Hendrycks et al。 Arxiv 2020。[紙]

- データセットシフトに対するモデルの堅牢性と安定性の評価。 Adarsh Subbaswamy et al。人工知能と統計に関する国際会議、2021年に発表。論文

- MMDialog:マルチモーダルオープンドメイン会話に向けた大規模なマルチターンダイアログデータセット。 Jiazhan Feng et al。 arxiv2022。[紙]

- 自己内容:自己生成命令を備えた言語モデルを調整します。 Yizhong Wang et al。 arxiv2022。[紙]

- スーパーナチュラルインストラクション:1600以上のNLPタスクに関する宣言命令による一般化。 Yizhong Wang et al。 arxiv2022。[紙]

- GPT-4V(ISION)における幻覚のホリスティック分析:バイアスと干渉の課題。 Chenhang Cui et al。 arxiv2023。[紙]

- 大規模な言語モデルの指示に対する堅牢性を評価します。 Yuansheng Ni et al。 arxiv2023。[紙]

- ガイア:一般的なAIアシスタントのベンチマーク。 GrégoireMialon et al。 arxiv2023。[紙]

- 深いモデルの堅牢性のための包括的な評価フレームワーク。 Jun Guo et al。パターン認識、2023。[紙]

- Agieval:基礎モデルを評価するための人間中心のベンチマーク。ワンジュン・チャン等。 arxiv2023。[紙]

- MMMU:エキスパートAGIのための大規模なマルチディシップラインマルチモーダルの理解と推論ベンチマーク。 Xiang et al。 arxiv2023。[紙]

- 文学的な観点から大きな言語モデルの創造性を評価します。マレー・シャナハン等arxiv2023。[紙]

- エージェントベンチ:LLMの評価。 Xiao Liu et al。 ICLR 2024。[紙]

- 大規模な言語モデルにおける創造性の評価と理解。 Yunpu Zhao et al。 arxiv2024。[紙]

- MTベンチとチャットボットアリーナでLLM-As-A-Judgeを判断します。 Lianmin Zheng et al。ニューリップス2024。[紙]

6.5 AGI開発中のさらなる考慮事項

- 大規模な言語モデルのアライメントと安全性を保証する際の基本的な課題。 Usman Anwar et al。 arxiv2024。[紙]

- 言語モデルの合成データで学んだベストプラクティスと教訓。 Ruibo Liu et al。 arxiv2024。[紙]

- AIエージェントの社会的知能の進歩:技術的な課題と未解決の質問。 Leena Mathur et al。 arxiv2024。[紙]

7。ケーススタディ

科学の発見と研究のための7.1 AI

- Alphafoldによる非常に正確なタンパク質構造予測。ジャンパー、ジョン等。自然、2021。[紙]

- 自動科学的発見:方程式の発見から自律発見システムまで。 Kramer、Stefan et al。 arxiv2023。[紙]

- ディープラーニングベースのシーケンスモデルを使用した非コードバリアントの効果の予測。周、Jian et al。 Nature Method、2015。

- 視覚脱アニメーションを介して物理学を見ることを学ぶ。ウー、ジアジュン等。 Neurips 2017。[紙]

- リアルタイムの重力波検出およびパラメーター推定のための深い学習:高度なLIGOデータの結果。ジョージ、ダニエル等。物理文字B、2018年。[紙]

- 敵対的なニューラルネットワークを備えた量子相遷移を特定します。レム、バート・ジャン等。 Nature Physics、2019。[Paper]

- Openagi:LLMがドメインの専門家に会うとき。 Ge、Yingqiang et al。ニューリップス、2023。[紙]

- 暗黒物質から畳み込みネットワークを備えた銀河まで。 Zhang、Xinyue et al。 Arxiv 2019。[紙]

- Alphazero Deep Explorationを使用した量子ダイナミクスのグローバルな最適化。 Dalgaard、Mogens et al。 NPJ Quantum Information、2020。[紙]

- 生物医学視覚処理のために時間構造を活用することを学ぶ。 Shruthi Bannur et al。 CVPR、2023。[論文]

- Mathbert:数学教育における一般的なNLPタスクの事前に訓練された言語モデル。シェン、Jia Tracy et al。 arxiv2021。[紙]

- 言語モデルを使用した分子最適化。 Maziarz、Krzysztof et al。 arxiv2022。[紙]

- Retrotrae:原子環境と変圧器のレトロシンセティック翻訳。 UCAK、Umit Volkan et al。ジャーナルなし、2022。[紙]

- Scholarbert:Biggerが常に優れているとは限りません。 Hong、Zhi et al。 arxiv2022。[紙]

- Galactica:科学の大規模な言語モデル。テイラー、ロス等。 arxiv2022。[紙]

- 正式な数学の声明カリキュラム学習。 Polu、Stanislas et al。 arxiv2022。[紙]

- 言語モデルで証明する定理の共同トレーニングを証明します。ジェシー・マイケル・ハン等。 ICLR 2022。[紙]

- 言語モデルの定量的推論の問題を解決します。 Lewkowycz、Aitor et al。 arxiv2022。[紙]

- Biogpt:生物医学のテキスト生成とマイニングのための生成事前訓練トランス。 Luo、Renqian et al。バイオインフォマティクスのブリーフィング、2022。

- Chemcrow:化学ツールを使用した大規模な言語モデルを増強します。 Bran、Andres M et al。 arxiv2023。[紙]

- 大規模な言語モデルを使用した自律化学研究。 Boiko、Daniil et al。自然、2023。[紙]

- 大規模な言語モデルの緊急自律科学研究能力。 Daniil A. Boiko et al。 arxiv2023。[紙]

- MathPrompter:大規模な言語モデルを使用した数学的推論。イマニ、島、他第61回計算言語学会協会の年次総会(第5巻:産業トラック)の議事録で発表されました。

- 生物医学視覚処理のために時間構造を活用することを学ぶ。 Shruthi Bannur et al。 arxiv2023。[紙]

- 科学のためのLLMS:コード生成およびデータ分析のための使用。ネジャール、モハメド等arxiv2023。[紙]

- Medagents:ゼロショット医療推論の協力者としての大規模な言語モデル。 Xiangru Tang et al。 arxiv2024。[紙]

7.2生成視覚インテリジェンス

- 非平衡熱力学を使用した深い教師の学習。 Jascha Sohl-Dickstein et al。 ICML 2015。[紙]

- データ分布の勾配を推定することによる生成モデリング。 Yang Song et al。 Neurips 2019。[紙]

- 拡散確率モデルを除去します。ジョナサン・ホー等Neurips2020。[紙]

- 確率的微分方程式によるスコアベースの生成モデリング。 Yang Song et al。 ICLR 2021。[紙]

- グライド:テキスト誘導拡散モデルを使用したフォトリアリスティックな画像生成と編集に向けて。アレックス・ニコル等。 ICML 2022。[紙]

- SDEDIT:確率的微分方程式を使用したガイド付き画像合成と編集。 Chenlin Meng et al。 ICLR 2022。[紙]

- ビデオ拡散モデル。ジョナサン・ホー等ニューリップス2022。[紙]

- クリップレイテントを使用した階層的なテキストコンディショナル画像生成。 Aditya Ramesh et al。 arxiv2022。[紙]

- 分類器のない拡散ガイダンス。ジョナサン・ホー等arxiv2022。[紙]

- パレット:画像間拡散モデル。 Chitwan Saharia et al。 Siggraph2022。[紙]

- 潜在的な拡散モデルを使用した高解像度画像合成。ロビン・ロムバッハ等。 CVPR 2022。[紙]

- テキスト間拡散モデルに条件付きコントロールを追加します。 Lvmin Zhang et al。 ICCV 2023。[紙]

- トランスを使用したスケーラブルな拡散モデル。 William Peebles et al。 ICCV 2023。[紙]

- シーケンシャルモデリングにより、大きなビジョンモデルのスケーラブルな学習が可能になります。 Yutong Bai et al。 arxiv2023。[紙]

- 世界のシミュレータとしてのビデオ生成モデル。ティム・ブルックスら。 Openai 2024。[紙]

7.3世界モデル

- 視覚脱アニメーションを介して物理学を見ることを学ぶ。ウー、ジアジュン等。 Neurips 2017。[紙]

- 安定性保証による安全なモデルベースの強化学習。 Berkenkamp、Felix et al。 Neurips、2017。[紙]

- SIMNET:物理的推論のためのシミュレーションベースの世界モデルを学習します。 Vicol、Paul、Menapace et al。 ICLR 2022。[紙]

- Dreamix:繰り返しの時空混合によるDreamFusion 。 Khalifa、Anji et al。 arxiv2022。[紙]

- インターネット規模の知識を備えた補強学習を通じて、汎用AIエージェントを具体化しました。 Guo、Xiaoxiao et al。 arxiv2022。[紙]

- VQGAN-CLIP:自然言語ガイダンスを使用したドメイン画像の生成と編集を開きます。クロウソン、キャサリン。 arxiv2022。[紙]

- 自律マシンインテリジェンスへの道。 Lecun Yann OpenReview、2022。[Paper]

- 言語モデルは世界モデルを満たしています:具体化された体験は言語モデルを強化します。 Jiannan Xiang et al。ニューリップス2023。[紙]

- 世界モデルを通じて多様なドメインをマスターする。 Hafner、Danijar et al。 arxiv2023。[紙]

- 検索によるマルチモーダルモデルの取得。リード、スコット等。 arxiv2023。[紙]

- ゼロショットプランナーとしての言語モデル:具体化されたエージェントのための実用的な知識を抽出します。ドハン、デイビッド等。 arxiv2023。[紙]

- 言語モデル、エージェントモデル、および世界モデル:機械の推論と計画に関する法律。 Zhiting Hu et al。 arxiv2023。[紙]

- 言語モデルの推論は、世界モデルを計画しています。 Hao、Shibo et al。 arxiv2023。[紙]

- Metasim:合成データセットを生成することを学ぶ。 Zhang、Yuxuan et al。 arxiv2023。[紙]

- 100万の長さのビデオと指輪の言語に関する世界モデル。 Hao Liu et al。 arxiv2024。[紙]

- Genie:生成的インタラクティブ環境。ジェイク・ブルース等arxiv2024。[紙]

7.4分散型LLM

- 花びら:大規模なモデルの共同推論と微調整。 Alexander Borzunov et al。 arxiv2022。[紙]

- 深い学習のためのブロックチェーン:レビューとオープンチャレンジ。経済の時代。クラスターコンピューティング2021。[論文]

- FlexGen:単一のGPUを使用した大規模な言語モデルのハイスループット生成推論。 Ying Sheng et al。 arxiv2023。[紙]

- 不均一環境での基礎モデルの分散トレーニング。 Binhang Yuan et al。 arxiv2023。[紙]

コーディング用7.5 AI

- コード生成モデルの評価のためのフレームワーク。ベン・アラル等。 Github、2023。[コード]

- コードでトレーニングされた大きな言語モデルの評価。マークチェン等。 arxiv2021。[紙]

- 大規模な言語モデルを使用したプログラム統合。ジェイコブオースティンら。 arxiv2021。[紙]

- アルファコードを使用した競合レベルのコード生成。 Yujia Li et al。科学、2022年。[紙]

- 中央を埋めるための言語モデルの効率的なトレーニング。 Mohammad Bavarian et al。 arxiv2022。[紙]

- サンタコーダー:星に手を伸ばさないでください! 。 Loubna Ben Allal et al。心、2023。[紙]

- Starcoder:ソースがあなたと一緒にいることができますように! 。 Raymond Li et al。 arxiv2023。[紙]

- コンパイラ最適化のための大規模な言語モデル。クリス・カミンズ等。 arxiv2023。[紙]

- 教科書はあなたが必要とするすべてです。 Suriya Gunasekar et al。 arxiv2023。[紙]

- インターコード:実行フィードバックを使用したインタラクティブコーディングの標準化とベンチマーク。ジョン・ヤン等。 arxiv2023。[紙]

- 高品質の単体テスト生成のための自動フィードバックからの強化学習。ベンジャミン・スティーンホークら。 arxiv2023。[紙]

- Incoder:コードの充填と合成の生成モデル。ダニエル・フリード等。 arxiv2023。[紙]

- 大規模な言語モデルを使用して、分解されたCコードを改良します。 Wai Kin Wong et al。 arxiv2023。[紙]

- SWEベンチ:言語モデルは実世界を解決できます