ナム・ヒョンジン* 1 、ダニエル・ソンホ・ジョン* 1 、ムン・ギョンシク2 、イ・ギョンム1

![]()

![]()

1ソウル大学、 2コーデックアバター研究室、メタ

(*均等貢献)

CONTHO は、人間とオブジェクトの接触を正確な再構築の重要な信号として利用することで、3D の人間とオブジェクトを共同で再構築します。この目的を達成するために、私たちは 2 つのトラックで別々に研究されてきた「3D 人体-物体再構築」と「人体-物体接触推定」の 2 つの異なるタスクを 1 つの統一されたフレームワークに統合します。

Anaconda 仮想環境を使用することをお勧めします。 PyTorch >=1.10.1 および Python >= 3.7.0 をインストールします。最新の CONTHO モデルは、Python 3.9.13、PyTorch 1.10.1、CUDA 10.2 でテストされています。

環境をセットアップする

# Initialize conda environment conda create -n contho python=3.9 conda activate contho # Install PyTorch conda install pytorch==1.10.1 torchvision==0.11.2 torchaudio==0.10.1 cudatoolkit=10.2 -c pytorch # Install all remaining packages pip install -r requirements.txt

Google Drive または Onedrive からbase_data準備し、 ${ROOT}/data/base_dataとして配置します。

事前トレーニングされたチェックポイントを Google Drive または OneDrive からダウンロードします。

最後は走ってください

python main/demo.py --gpu 0 --checkpoint {CKPT_PATH}以下のようなdataのディレクトリ構造に従う必要があります。

${ROOT}

|-- data

| |-- base_data

| | |-- annotations

| | |-- backbone_models

| | |-- human_models

| | |-- object_models

| |-- BEHAVE

| | |-- dataset.py

| | |-- sequences

| | | |-- Date01_Sub01_backpack_back

| | | |-- Date01_Sub01_backpack_hand

| | | |-- ...

| | | |-- Date07_Sub08_yogamat

| |-- InterCap

| | |-- dataset.py

| | |-- sequences

| | | |-- 01

| | | |-- 02

| | | |-- ...

| | | |-- 10 Data01~Data07 シーケンスを BEHAVE データセットから${ROOT}/data/BEHAVE/sequencesにダウンロードします。

(オプション 1) ダウンロード ページから BEHAVE データセットを直接ダウンロードします。

(オプション 2) 以下のスクリプトを実行します。

scripts/download_behave.sh

InterCap データセットから RGBD_Images.zip と Res.zip を${ROOT}/data/InterCap/sequencesにダウンロードします。

(オプション 1) ダウンロード ページから InterCap データセットを直接ダウンロードします。

(オプション 2) 以下のスクリプトを実行します。

scripts/download_intercap.sh

Google Drive または Onedrive から Base_data をダウンロードします。

(オプション) BEHAVE (Google Drive | OneDrive) および InterCap (Google Drive | OneDrive) データセット用にリリースされたチェックポイントをダウンロードします。

BEHAVE または InterCap データセットで CONTHO をトレーニングするには、次を実行してください。

python main/train.py --gpu 0 --dataset {DATASET}BEHAVE または InterCap データセットで CONTHO を評価するには、次を実行してください。

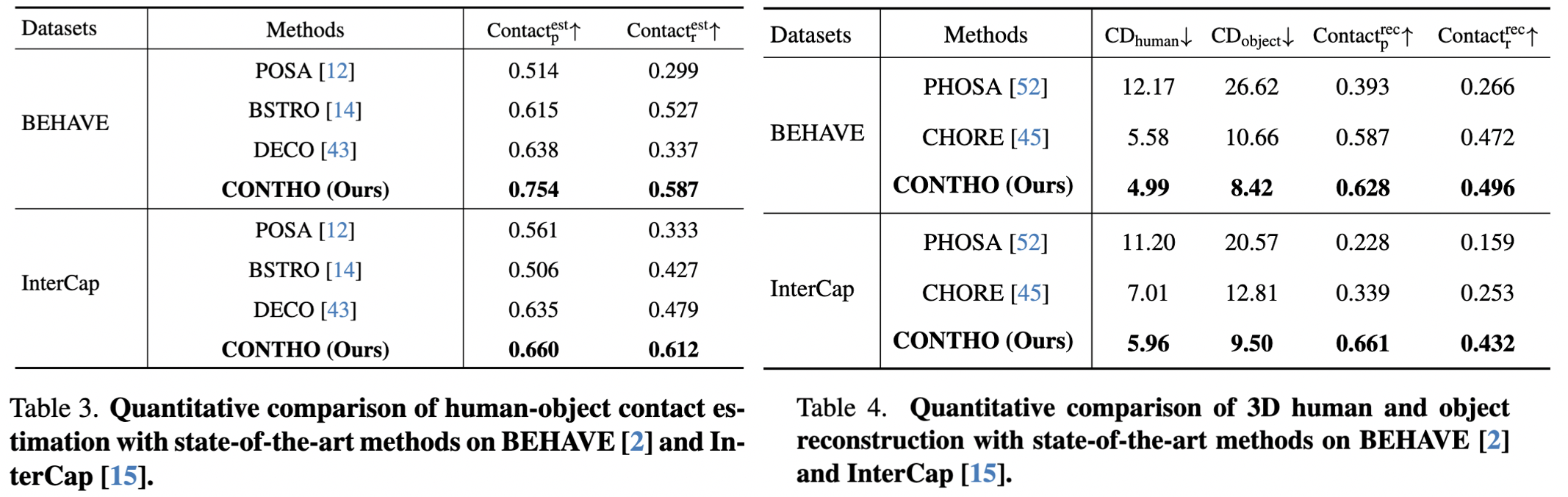

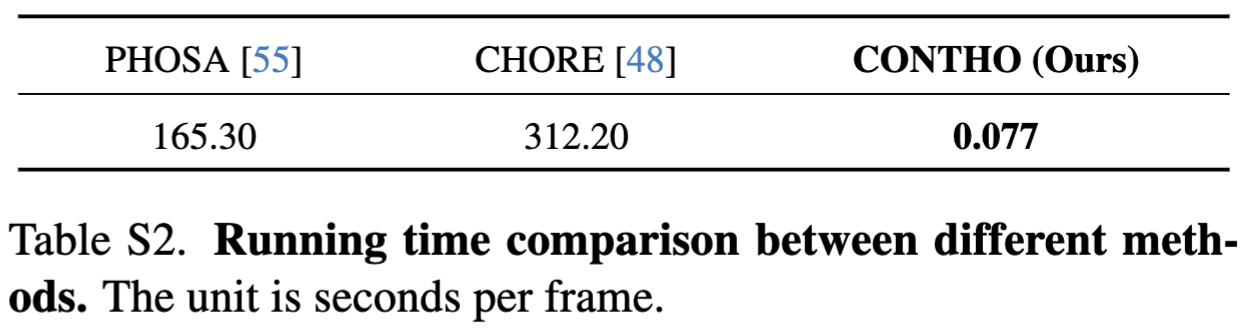

python main/test.py --gpu 0 --dataset {DATASET} --checkpoint {CKPT_PATH}ここではCONTHOの実績を報告します。

CONTHO は、高速かつ正確な3D 人間とオブジェクトの再構築フレームワークです。

RuntimeError: ブール テンソルを使用した減算、 -演算子はサポートされていません。マスクを反転しようとしている場合は、代わりに~またはlogical_not()演算子を使用してください。リファレンスを確認してください。

bash: scripts/download_behave.sh: 権限が拒否されました: リファレンスを確認してください。

感謝します:

3D ヒューマン メッシュ再構築用の Hand4Whole。

BEHAVE のトレーニングとテスト用の CHORE。

データセットのダウンロード スクリプト用の InterCap。

野外実験セットアップ用の DECO。

@inproceedings{nam2024contho,

title = {Joint Reconstruction of 3D Human and Object via Contact-Based Refinement Transformer},

author = {Nam, Hyeongjin and Jung, Daniel Sungho and Moon, Gyeongsik and Lee, Kyoung Mu},

booktitle = {Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition},

year = {2024}

}