AI を使用してオフラインでドキュメントをチャットします。システムからデータが流出することはありません。インターネット接続は、ツールのインストールと AI モデルのダウンロードの場合のみ必要です。 PrivateGPT に基づいていますが、より多くの機能があります。

コンテンツ

chatdocs.yml経由で高度に構成可能| 拡大 | 形式 |

|---|---|

.csv | CSV |

.docx 、 .doc | Word文書 |

.enex | EverNote |

.eml | 電子メール |

.epub | EPub |

.html | HTML |

.md | マークダウン |

.msg | 見通しメッセージ |

.odt | 文書テキストを開く |

.pdf | PDF形式(PDF) |

.pptx 、 .ppt | パワーポイントドキュメント |

.txt | テキストファイル(UTF-8) |

以下を使用してツールをインストールします。

pip install chatdocs以下を使用して AI モデルをダウンロードします。

chatdocs downloadインターネット接続なしでオフラインで実行できるようになりました。

以下を使用して、チャットするドキュメントを含むディレクトリを追加します。

chatdocs add /path/to/documents処理されたドキュメントはデフォルトで

dbディレクトリに保存されます。

以下を使用してドキュメントとチャットします。

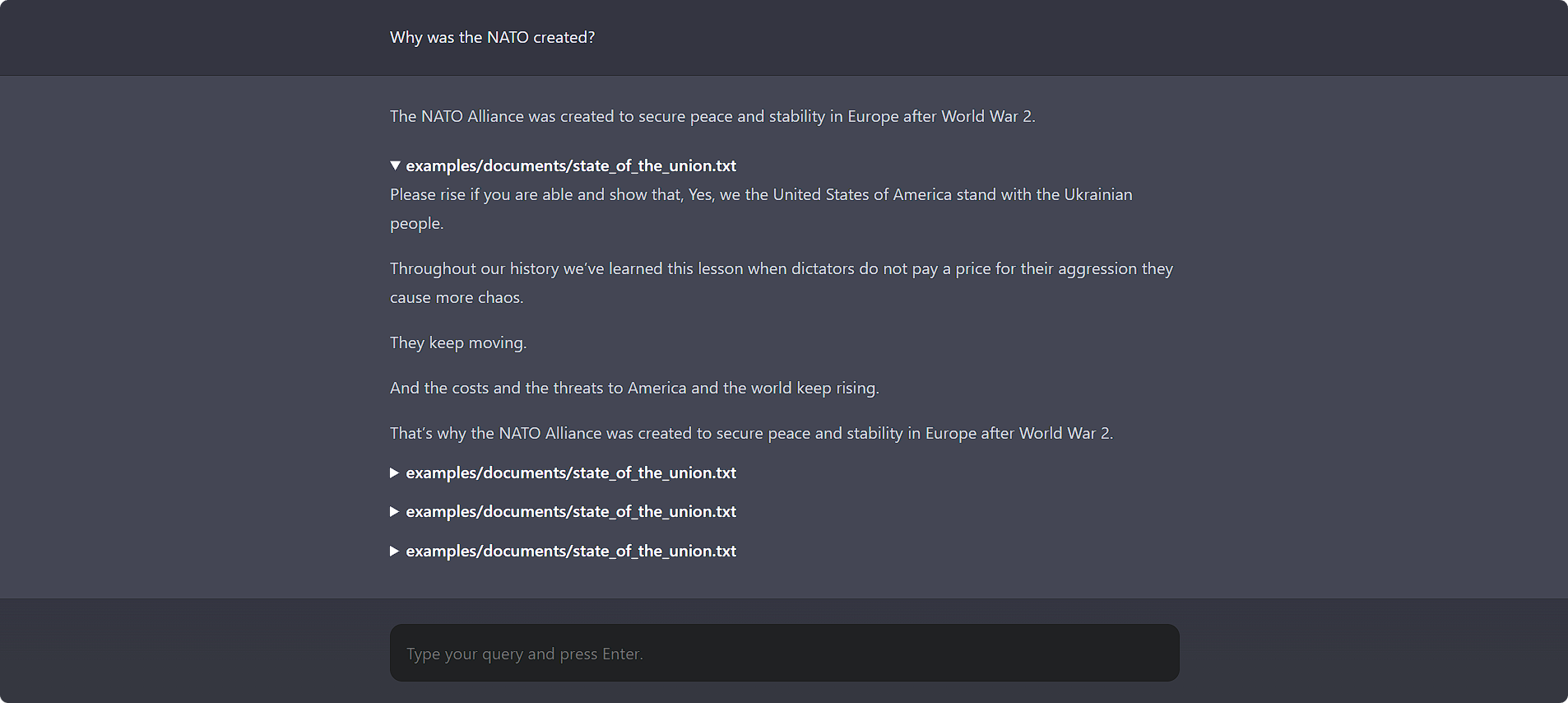

chatdocs uiブラウザで http://localhost:5000 を開いて Web UI にアクセスします。

また、優れたコマンドライン インターフェイスも備えています。

chatdocs chat

すべての構成オプションは、 chatdocs.yml構成ファイルを使用して変更できます。何らかのディレクトリにchatdocs.ymlファイルを作成し、そのディレクトリからすべてのコマンドを実行します。参考として、デフォルトのchatdocs.ymlファイルを参照してください。

ファイル全体をコピーする必要はありません。デフォルトの設定とマージされるため、変更したい設定オプションを追加するだけです。たとえば、構成オプションの一部のみを変更するtests/fixtures/chatdocs.ymlを参照してください。

埋め込みモデルを変更するには、 chatdocs.ymlに次の内容を追加して変更します。

embeddings :

model : hkunlp/instructor-large注:埋め込みモデルを変更する場合は、

dbディレクトリを削除し、ドキュメントを再度追加します。

CTransformers (GGML/GGUF) モデルを変更するには、 chatdocs.ymlに以下を追加して変更します。

ctransformers :

model : TheBloke/Wizard-Vicuna-7B-Uncensored-GGML

model_file : Wizard-Vicuna-7B-Uncensored.ggmlv3.q4_0.bin

model_type : llama注:新しいモデルを初めて追加するときは、使用する前に

chatdocs downloadを実行してモデルをダウンロードします。

既存のローカル モデル ファイルを使用することもできます。

ctransformers :

model : /path/to/ggml-model.bin

model_type : llama使用するには? Transformers モデルの場合は、以下をchatdocs.ymlに追加します。

llm : huggingface ?を変更するにはTransformers モデルを作成するには、 chatdocs.ymlに次の内容を追加および変更します。

huggingface :

model : TheBloke/Wizard-Vicuna-7B-Uncensored-HF注:新しいモデルを初めて追加するときは、使用する前に

chatdocs downloadを実行してモデルをダウンロードします。

GPTQ モデルを使用するには ? Transformers の場合は、以下を使用して必要なパッケージをインストールします。

pip install chatdocs[gptq]埋め込みモデルの GPU (CUDA) サポートを有効にするには、以下をchatdocs.ymlに追加します。

embeddings :

model_kwargs :

device : cudaここの手順に従って、CUDA を有効にして PyTorch を再インストールする必要がある場合があります。

CTransformers (GGML/GGUF) モデルの GPU (CUDA) サポートを有効にするには、以下をchatdocs.ymlに追加します。

ctransformers :

config :

gpu_layers : 50以下を使用して CUDA ライブラリをインストールする必要がある場合があります。

pip install ctransformers[cuda]? の GPU (CUDA) サポートを有効にするにはTransformers モデルの場合は、以下をchatdocs.ymlに追加します。

huggingface :

device : 0ここの手順に従って、CUDA を有効にして PyTorch を再インストールする必要がある場合があります。

マサチューセッツ工科大学