[?ハグフェイス] [? OpenXLab] [?論文] [ プロジェクトページ]

オープンソースの大規模言語モデル (LLM) は、さまざまな NLP タスクで大きな成功を収めていますが、エージェントとして動作する場合には API ベースのモデルよりもはるかに劣っています。エージェントの能力を一般的な LLM にどのように統合するかが、重大かつ緊急の問題になります。この論文では、まず 3 つの重要な観察結果を紹介します。(1) 現在のエージェント トレーニング コーパスは、次の形式とエージェント推論の両方の形式に絡み合っており、トレーニング前のデータの分布から大幅に変化しています。 (2) LLM は、エージェントのタスクに必要な機能に関して異なる学習速度を示します。 (3) 現在のアプローチでは、幻覚を導入することでエージェントの能力を向上させる際に副作用があります。上記の調査結果に基づいて、エージェントの LANguage モデルを効果的に微調整するための Agent-FLAN を提案します。 Agent-FLAN は、トレーニング コーパスの慎重な分解と再設計により、Llama2-7B がさまざまなエージェント評価データセット全体で以前の最高の成果を 3.5% 上回るパフォーマンスを実現できるようにします。 Agent-FLAN は、包括的に構築された陰性サンプルにより、確立された評価ベンチマークに基づいて幻覚の問題を大幅に軽減します。さらに、LLM の一般的な機能をわずかに向上させながら、モデル サイズをスケーリングする際の LLM のエージェント機能を一貫して向上させます。

Agent-FLANシリーズは、Agent-FLANの論文で提案されているデータ生成パイプラインを適用することにより、AgentInstructとToolbench上で微調整されており、さまざまなエージェントタスクとツールの利用に強力な能力を備えています~

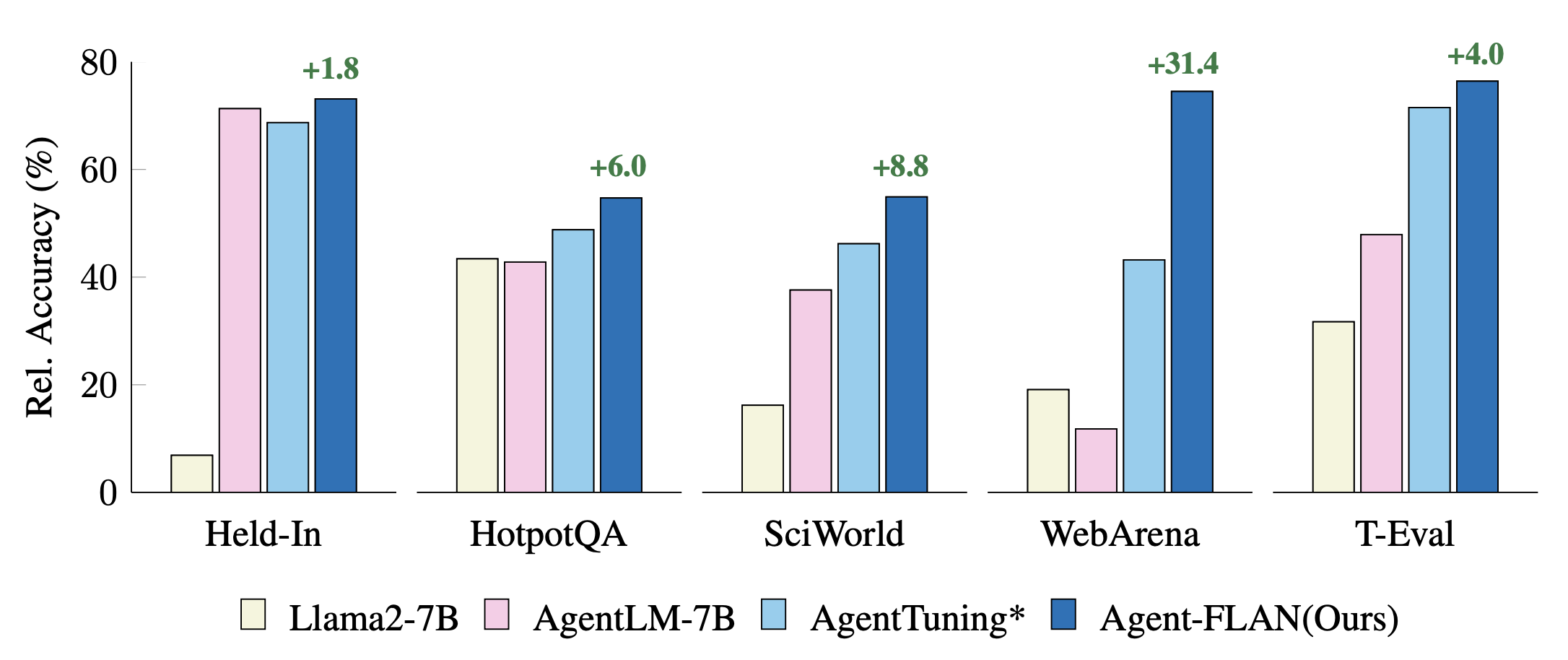

ホールドインタスクとホールドアウトタスクに関する最近のエージェントチューニングアプローチの比較。パフォーマンスは GPT-4 の結果で正規化され、視覚化が向上します。 * は、公平な比較のための再実装を示します。

Agent-FLAN は、Llama2-chat シリーズの AgentInstruct、ToolBench、ShareGPT データセットの混合トレーニングによって生成されます。

モデルは、Llama-2-chat の会話形式に従い、テンプレート プロトコルは次のとおりです。

dict ( role = 'user' , begin = '<|Human|>െ' , end = ' n ' ),

dict ( role = 'system' , begin = '<|Human|>െ' , end = ' n ' ),

dict ( role = 'assistant' , begin = '<|Assistant|>െ' , end = 'ി n ' ),7B モデルは、Huggingface および OpenXLab モデル ハブで利用できます。

| モデル | ハグフェイスリポジトリ | OpenXLab リポジトリ |

|---|---|---|

| エージェント-FLAN-7B | モデルリンク | モデルリンク |

Agent-FLAN データセットは、Huggingface データセット ハブでも利用できます。

| データセット | ハグフェイスリポジトリ |

|---|---|

| エージェント-FLAN | データセットリンク |

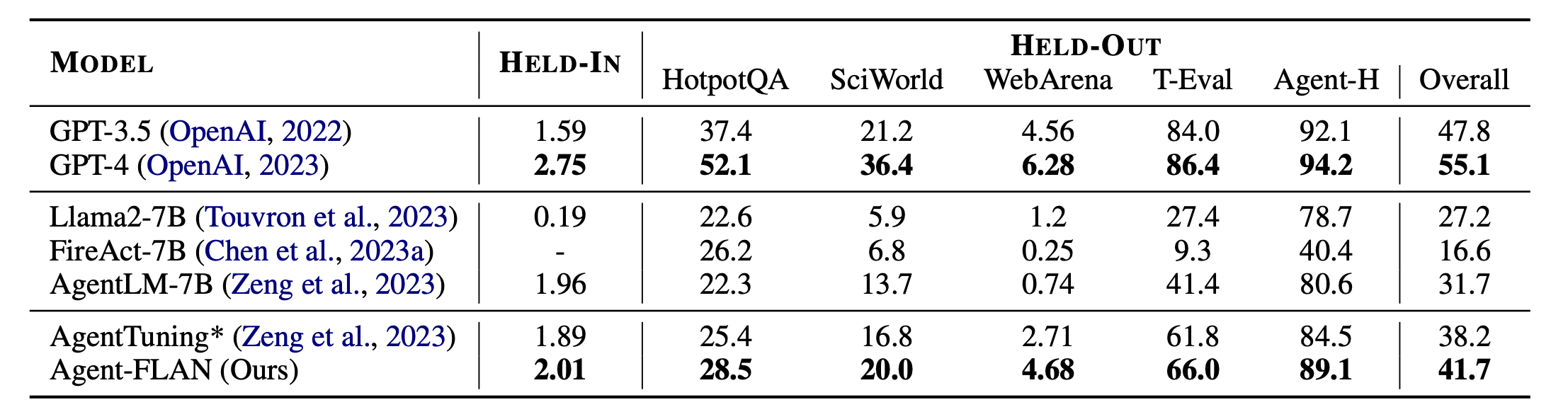

Agent-FLANの主な結果。 Agent-FLAN は、ホールドイン タスクとホールドアウト タスクの両方において、以前のエージェント チューニング アプローチよりも大幅に優れたパフォーマンスを発揮します。 * は、公平な比較のために同じ量のトレーニング データを使用して再実装したことを示します。 FireAct は AgentInstruct データセットでトレーニングしないため、HELD-IN セットでのパフォーマンスは省略します。太字: API ベースのオープンソース モデルの最高のもの。

Agent-FLAN は Lagent と T-Eval を使用して構築されています。彼らの素晴らしい仕事に感謝します!

このプロジェクトがあなたの研究に役立つと思われる場合は、次の引用を検討してください。

@article{chen2024agent,

title={Agent-FLAN: Designing Data and Methods of Effective Agent Tuning for Large Language Models},

author={Chen, Zehui and Liu, Kuikun and Wang, Qiuchen and Zhang, Wenwei and Liu, Jiangning and Lin, Dahua and Chen, Kai and Zhao, Feng},

journal={arXiv preprint arXiv:2403.12881},

year={2024}

}

このプロジェクトは、Apache 2.0 ライセンスに基づいてリリースされています。