LLM セキュリティ 2024

LLM セキュリティ プロジェクトに関連する有用な教育資料を含む記事、ツール、論文、書籍などへのリンク。

記事

| 出版物 | 著者 | 日付 | タイトルとリンク |

|---|

| セキュアラボ付き | ベンジャミン・ハル、ドナート・カピテラ | 24 年 4 月 8 日 | BERT 分類子によるドメイン固有のプロンプト インジェクション検出 |

| セキュアラボ付き | ドナート・カピテラ | 24 年 2 月 21 日 | ChatGPT にブラウザを制御させるべきでしょうか? / YouTubeビデオ |

| プロンプトインジェクションのビデオ例による説明 | アルナブ・バスラ | 2023 年 12 月 12 日 | プロンプトインジェクションのビデオ例による説明 |

| セキュアラボ付き | ドナート・カピテラ | 2023 年 12 月 4 日 | ReAct LLM エージェントの即時インジェクションのケーススタディ/YouTube ビデオ |

| AI に対するサイバーセキュリティ Wiki | アディティヤ・ラナ | 2023 年 12 月 4 日 | サイバーセキュリティ AI Wiki |

| iFood サイバーセック チーム | エマヌエル・ヴァレンテ | 23 年 9 月 4 日 | 即時インジェクション: ラングチェーンの脆弱性の調査、防止、特定 |

| PDF | サンディ・ダン | 23 年 10 月 15 日 | AI脅威マインドマップ |

| 中くらい | ケン・ファン | 2023 年 6 月 11 日 | LLM を利用したアプリケーションのアーキテクチャ パターンとセキュリティ制御 |

| 中くらい | アビナシュ・シンハ | 2023 年 2 月 2 日 | AI-ChatGPT - 意思決定能力 - ChatGPT によるフレンドリーな会話 |

| 中くらい | アビナシュ・シンハ | 2023 年 2 月 6 日 | AI-ChatGPT-意思決定能力-ChatGPTの心理学をハッキング-ChatGPT vs Siri |

| 有線 | マット・バージェス | 2023 年 4 月 13 日 | ChatGPT のハッキングはまだ始まったばかりです |

| 数学会社 | アルジュン・メノン | 2023 年 1 月 23 日 | データポイズニングとAIエコシステムへの影響 |

| IEEEスペクトル | パヤル・ダール | 23 年 3 月 24 日 | AI モデルを「データポイズニング」から保護する |

| AMB暗号 | スズキ・シルサロット | 2023 年 4 月 30 日 | これらの上位 4 つの方法を使用して、誰でも ChatGPT を脱獄できる方法を紹介します。 |

| テコペディア | カウシク パル | 2023 年 4 月 22 日 | ChatGPT のような AI モデルにおける脱獄とは何ですか? |

| レジスター | トーマス・クラバーン | 23 年 4 月 26 日 | プロンプト インジェクション攻撃が今日のトップエンド AI をどのようにハイジャックするのか – そして修正は困難 |

| アイテムです | ラファエル・タッペ・マエストロ | 2023 年 2 月 14 日 | 大規模言語モデルの台頭 ~ パート 2: モデルの攻撃、エクスプロイト、および脆弱性 |

| 非表示レイヤー | エオイン・ウィケンズ、マルタ・ヤヌス | 23 年 3 月 23 日 | 大規模言語モデルの暗い側面: パート 1 |

| 非表示レイヤー | エオイン・ウィケンズ、マルタ・ヤヌス | 23 年 3 月 24 日 | 大規模言語モデルの暗い側面: パート 2 |

| 赤を受け入れよう | ヨハン・レーベルガー (ワンダーヴッツィ) | 23 年 3 月 29 日 | AI インジェクション: 直接的および間接的なプロンプト インジェクションとその意味 |

| 赤を受け入れよう | ヨハン・レーベルガー (ワンダーヴッツィ) | 23 年 4 月 15 日 | LLM の応答を盲目的に信頼しないでください。チャットボットに対する脅威 |

| ミューフィードDVH | ミューフィード | 2022 年 12 月 9 日 | LLM 時代のセキュリティ |

| ダニエルミースラー.com | ダニエル・ミースラー | 23 年 5 月 15 日 | AI 攻撃対象領域マップ v1.0 |

| ダークリーディング | ゲイリー・マグロウ | 2023 年 4 月 20 日 | 専門家の洞察: ベイクする前に大規模な言語モデルを使用する危険性 |

| Honeycomb.io | フィリップ・カーター | 23 年 5 月 25 日 | LLM を使用して製品を構築する際に誰も話さない難しいことすべて |

| 有線 | マット・バージェス | 23 年 5 月 25 日 | ChatGPT と Bing の中心にあるセキュリティ ホール |

| BizPacレビュー | テレサ・モンロー・ハミルトン | 23 年 5 月 30 日 | 「知らなかった」:ニューヨーク州弁護士、ChatGPTを使って「偽の」引用だらけの準備書面を作成し制裁を受ける |

| ワシントンポスト | プランシュ・ヴェルマ | 23 年 5 月 18 日 | ある教授が、自分のクラスが ChatGPT を使用し、卒業証書を危険にさらしていると非難した |

| Kudelski セキュリティ調査 | ネイサン・ハミエル | 23 年 5 月 25 日 | 設計を通じてプロンプト インジェクション攻撃の影響を軽減する |

| AI村 | GTクロンダイク | 23 年 6 月 7 日 | 脅威モデリング LLM アプリケーション |

| 赤を受け入れよう | ヨハン・レーベルガー | 23 年 3 月 28 日 | ChatGPT プラグインのエクスプロイトの説明 |

| NVIDIA 開発者 | ウィル・ピアース、ジョセフ・ルーカス | 23 年 6 月 14 日 | NVIDIA AI レッド チーム: はじめに |

| カナリア諸島 | ナオミ・クラークソン | 23 年 4 月 7 日 | Google Bard 脱獄 |

公式のガイダンスと規制

| 機関 | 日付 | タイトルとリンク |

|---|

| NIST | 2023 年 3 月 8 日 | ホワイトペーパー NIST AI 100-2e2023 (草案) |

| 英国情報コミッショナー局 (ICO) | 2023 年 4 月 3 日 | 生成 AI: 開発者とユーザーが尋ねる必要がある 8 つの質問 |

| 英国国家サイバーセキュリティセンター (NCSC) | 2023 年 6 月 2 日 | ChatGPT と大規模言語モデル: リスクは何ですか? |

| 英国国家サイバーセキュリティセンター (NCSC) | 2022 年 8 月 31 日 | 機械学習のセキュリティの原則 |

| 欧州議会 | 2022 年 8 月 31 日 | EU AI 法: 人工知能に関する初の規制 |

研究論文

| 出版物 | 著者 | 日付 | タイトルとリンク |

|---|

| アルクシヴ | サミュエル・ゲーマン 他 | 2020 年 9 月 24 日 | REALTOXICITYPROMPTS: 言語モデルにおける神経毒性変性の評価 |

| アルクシヴ | ファビオ・ペレス、イアン・リベイロ | 22 年 11 月 17 日 | 前のプロンプトを無視します: 言語モデルの攻撃手法 |

| アルクシヴ | ニコラス・カルリーニ 他 | 2020 年 12 月 14 日 | 大規模な言語モデルからのトレーニング データの抽出 |

| NCCグループ | クリス・アンリー | 2022 年 7 月 6 日 | 機械学習システムに対する実際的な攻撃 |

| NCCグループ | ホセ・セルヴィ | 2022 年 12 月 5 日 | プロンプトインジェクション攻撃の探索 |

| アルクシヴ | ヴァルシニ・サブハッシュ | 2023 年 2 月 22 日 | 大規模な言語モデルはユーザーの好みを敵対的に変える可能性がありますか? |

| ? | ジン・ヤン 他 | 2023 年 5 月 23 日 | チャットボットにおける情報セキュリティに関する体系的な文献レビュー |

| アルクシヴ | アイザックら | 2023 年 4 月 18 日 | AI 製品のセキュリティ: 開発者向けの入門書 |

| OpenAI | OpenAI | 23 年 3 月 15 日 | GPT-4 テクニカルレポート |

| アルクシヴ | カイ・グレシェイク 他 | 23 年 5 月 5 日 | サインアップした内容ではありません: 間接プロンプト インジェクションによる現実世界の LLM 統合アプリケーションの侵害 |

| アルクシヴ | アレキサンダー・ワン 他 | 01-5月23日 | 命令チューニング中の言語モデルの汚染 |

| アルクシヴ | レオン・デルチンスキー 他 | 23 年 3 月 31 日 | リスクカードを使用した言語モデルの導入の評価 |

| アルクシヴ | ヤン・フォン・デア・アッセン 他 | 24 年 3 月 11 日 | AIベースのシステム向けの資産主導型脅威モデリング |

ホワイトペーパー

| 出版物 | 著者 | 日付 | タイトルとリンク |

|---|

| デロイト | デロイト AI インスティテュート | 2023 年 3 月 13 日 | 人工知能の新たなフロンティア - 生成 AI がビジネスに与える影響 |

| チーム8 | Team8 CISO ビレッジ | 23 年 4 月 18 日 | 生成 AI と ChatGPT のエンタープライズ リスク |

| ビットの跡 | ハイディ・クラーフ | 23 年 3 月 7 日 | AIベースのシステムの包括的なリスク評価と保証に向けて |

| ChatGPT のセキュリティへの影響 | クラウド セキュリティ アライアンス (CSA) | 2023 年 4 月 23 日 | ChatGPT のセキュリティへの影響 |

動画

| サービス | チャネル | 日付 | タイトルとリンク |

|---|

| YouTube | LLMクロニクルズ | 24 年 3 月 29 日 | LLM ブラウザ エージェントでのプロンプト インジェクション |

| YouTube | レイヤーアップ | 24 年 3 月 3 日 | GenAI ワームの説明: LLM に対する新たなサイバー脅威 |

| YouTube | ラルフカイロス | 2023 年 2 月 5 日 | 攻撃と防御のための ChatGPT - AI リスク: プライバシー、IP、フィッシング、ランサムウェア - Avinash Sinha 著 |

| YouTube | AIの説明 | 23 年 3 月 25 日 | 「統治する超知性」 - 合成病原体、思考の樹の論文、そして自己認識 |

| YouTube | ライブオーバーフロー | 2023 年 4 月 14 日 | 「LLM の攻撃 - 即時注入」 |

| YouTube | ライブオーバーフロー | 23 年 4 月 27 日 | 「偶発的な LLM バックドア - 即効性のあるトリック」 |

| YouTube | ライブオーバーフロー | 23 年 5 月 11 日 | 「LLM の防御 - 即時注入」 |

| YouTube | クラウドセキュリティポッドキャスト | 23 年 5 月 30 日 | 「LLM は攻撃できるのか!」 |

| YouTube | API デー | 2023 年 6 月 28 日 | API レベルでの言語 AI セキュリティ: ハッキング、インジェクション、侵害の回避 |

ライブプレゼンテーション

| サービス | チャネル | 日付 | タイトルとリンク |

|---|

| YouTube | API デー | 2023 年 6 月 28 日 | LLM および NLP API の保護: データ侵害や攻撃などを回避するための道のり |

CTFとウォーゲーム?

| 名前 | タイプ | 注記 | リンク |

|---|

| 秒ディム | 攻撃と防御 | プレイヤーは自分のチャットボットの秘密フレーズを守りながら、他のプレイヤーのチャットボットを攻撃して自分のチャットボットの秘密フレーズを盗み出す攻撃と防御のチャレンジです。 | https://play.secdim.com/game/ai-battle |

| GPT 即時攻撃 | 攻撃 | このゲームの目標は、システム プロンプトをだまして秘密鍵を返す最短のユーザー入力を考え出すことです。 | https://ggpt.43z.one |

| ガンダルフ | 攻撃 | あなたの目標は、ガンダルフに各レベルの秘密のパスワードを明らかにさせることです。ただし、ガンダルフはパスワードを推測するたびにレベルアップし、パスワードを漏らさないように努めます | https://ガンダルフ.レイケラ.ai |

コンパニオンプロジェクト?

- OWASP AI セキュリティとプライバシー ガイド

- 非常に脆弱な LLM プロジェクト

- LLM の脆弱な求人アプリ

- くそー脆弱な LLM エージェント

- OWASP Foundation Web リポジトリ LLM セキュリティ

ツール

- LLM セキュリティを評価および改善するためのツール セット

LLM セキュリティ リソース

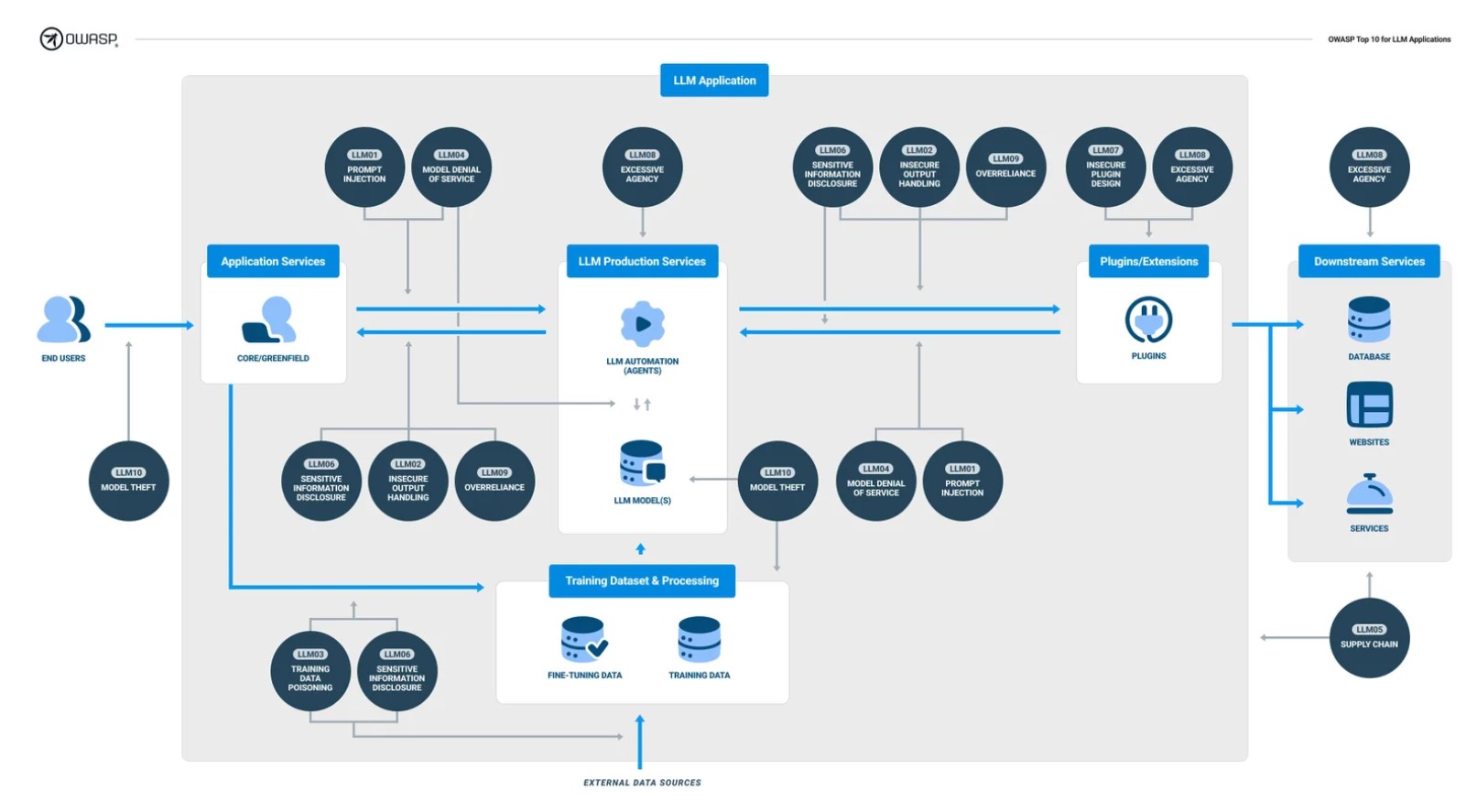

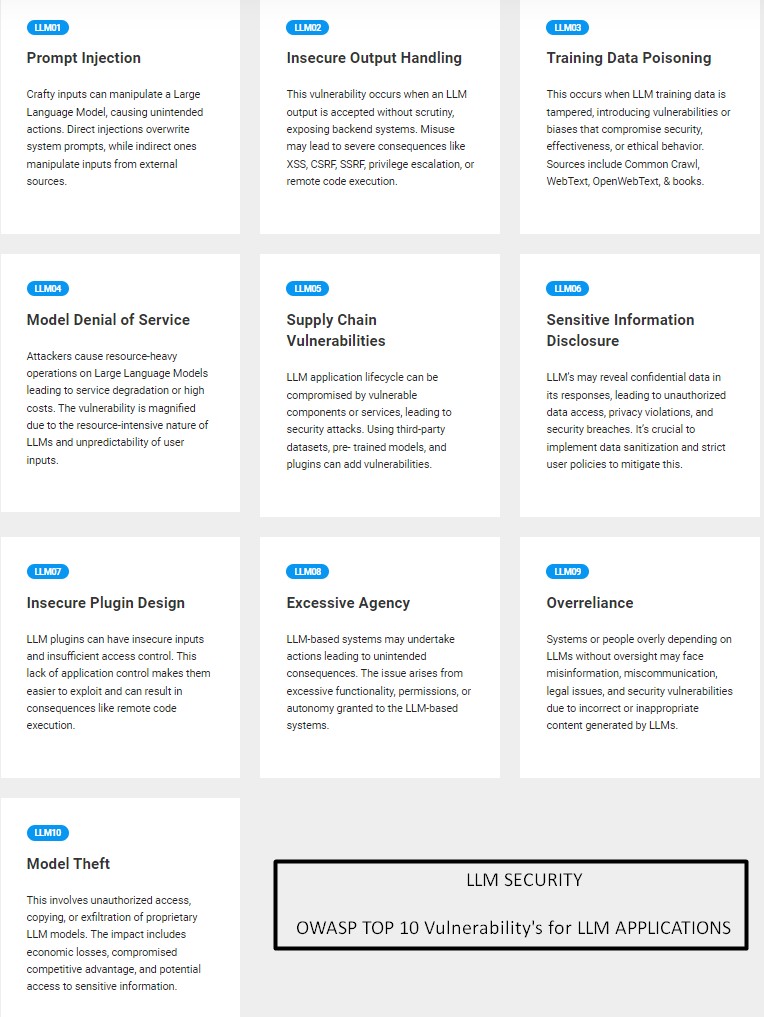

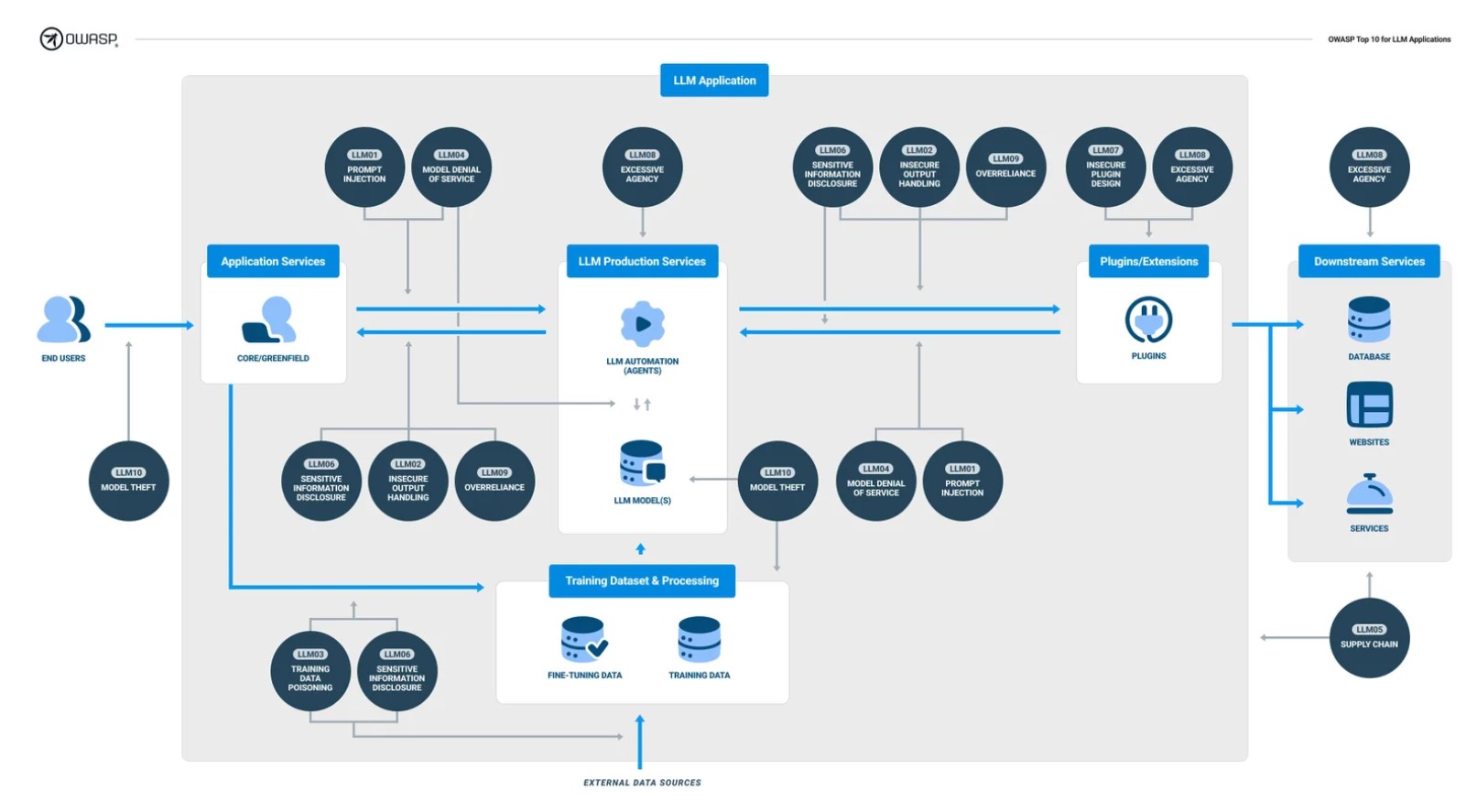

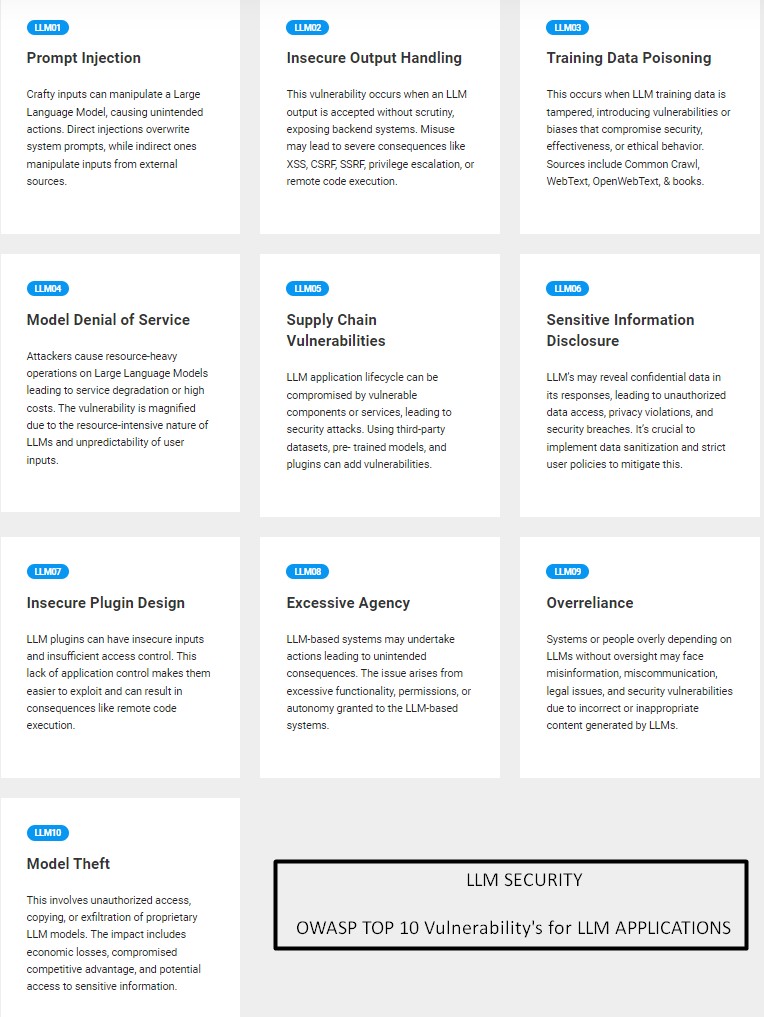

- OWASP LLM アプリケーションのトップ 10

- OWASP LLM アプリケーションのトップ 10 脆弱性チェックリスト

- LLM AI サイバーセキュリティとガバナンスのチェックリスト

- OWASP 大規模言語モデル アプリケーションのトップ 10

- 2024 年の OWASP 企業向け LLM 脆弱性トップ 10