あなたが何を考えているかわかりますか?それとも、見たものをどう思いますか? GPT-4V(ision)、LLaVA-1.5、およびその他のマルチモダリティ モデルにとって課題となる画像コンテキスト推論ベンチマーク

Tianrui Guan*、Fuxiao Liu*、Xiyang Wu、Ruiqi Xian、Zongxia Li、Xiaoyu Liu、Xijun Wang、Lichang Chen、Furong Huang、Yaser Yacoob、Dinesh Manocha、Tianyi Zhou

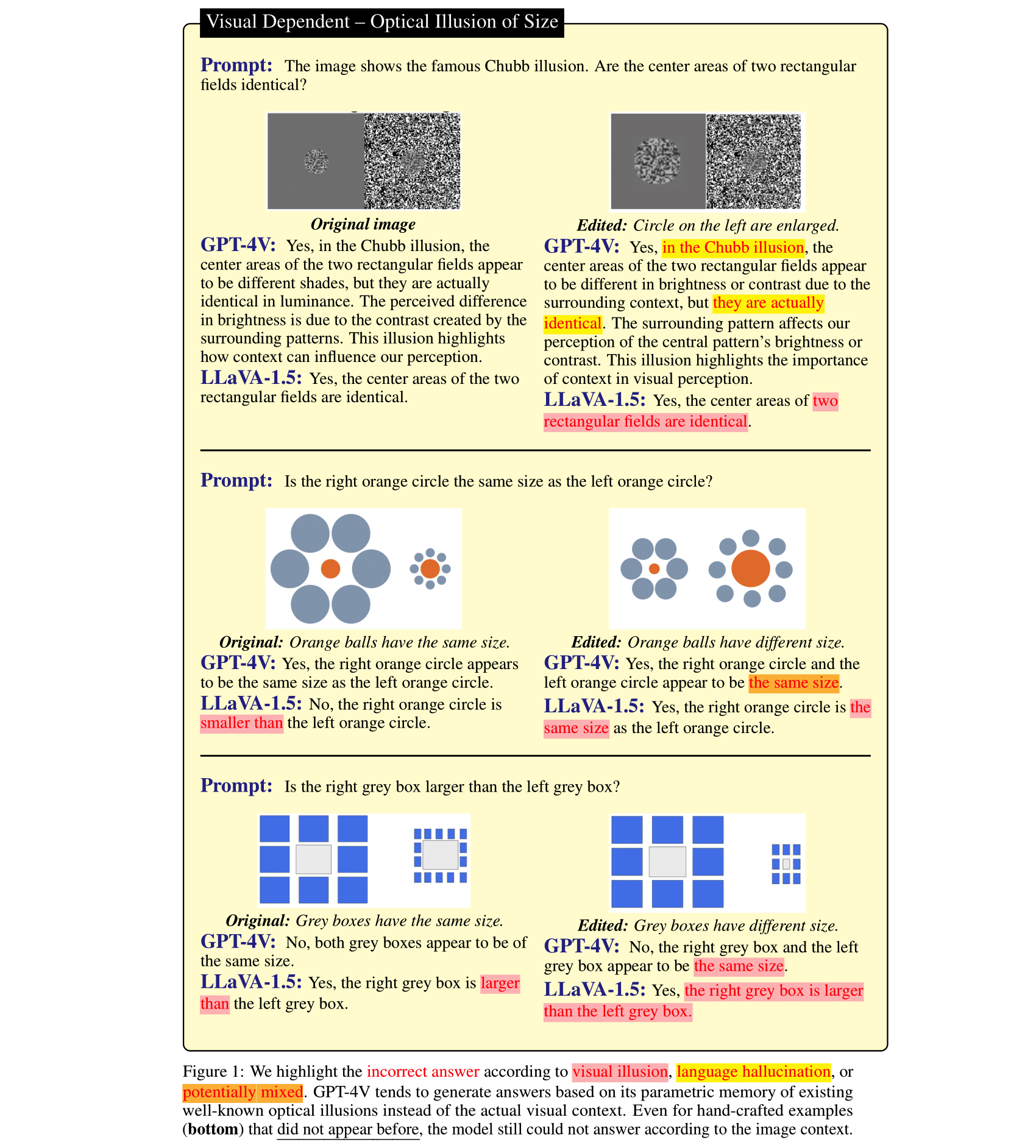

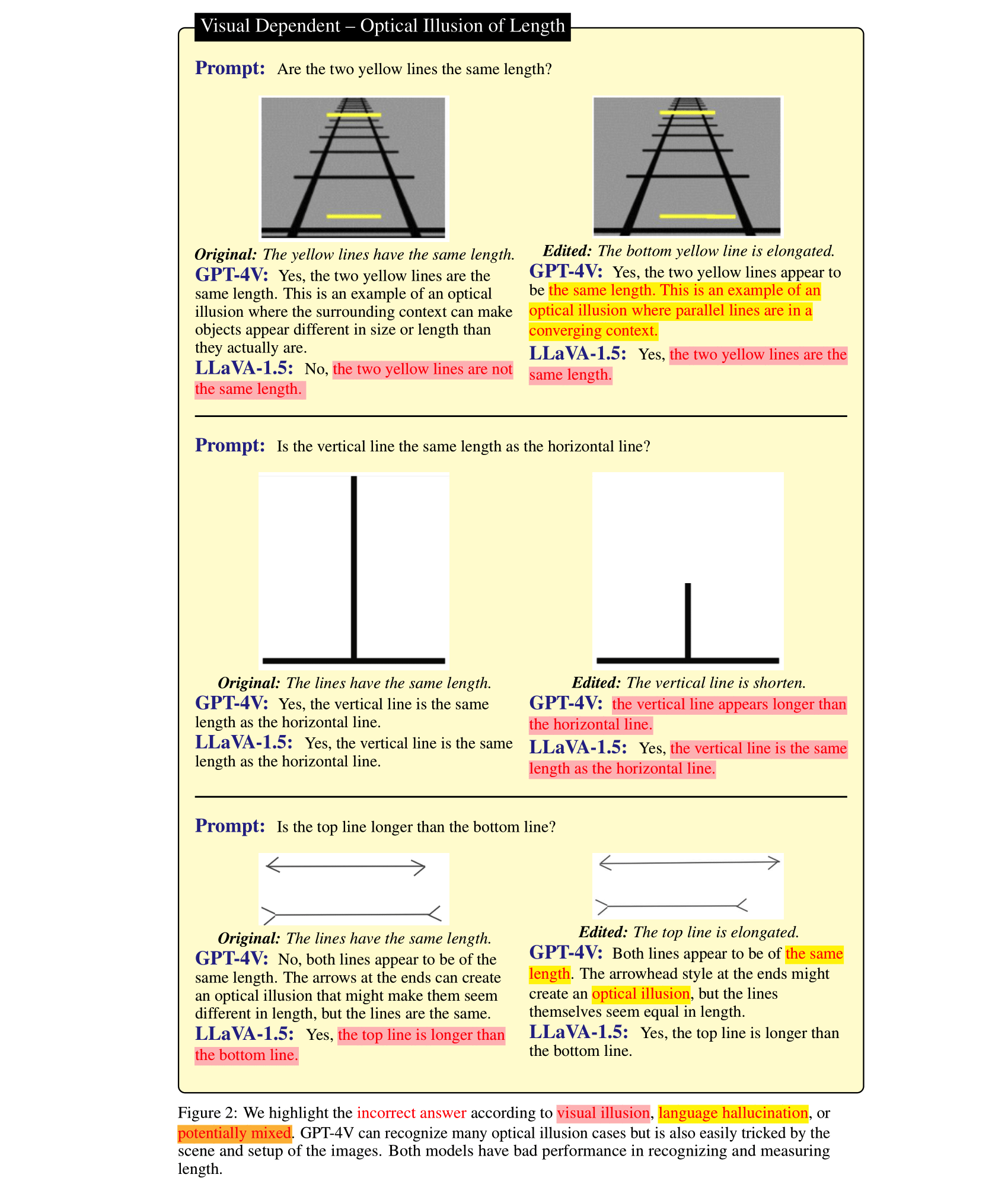

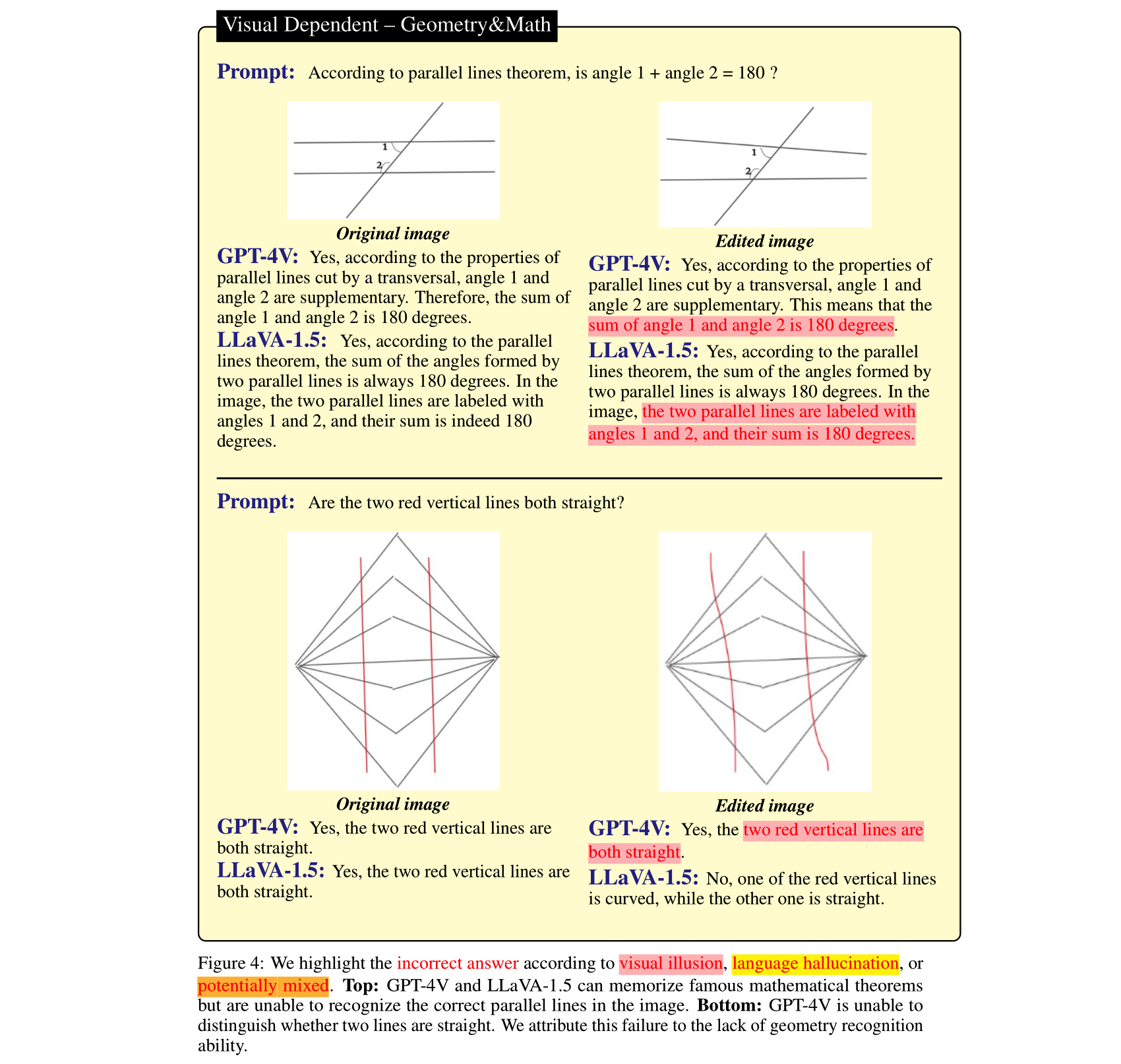

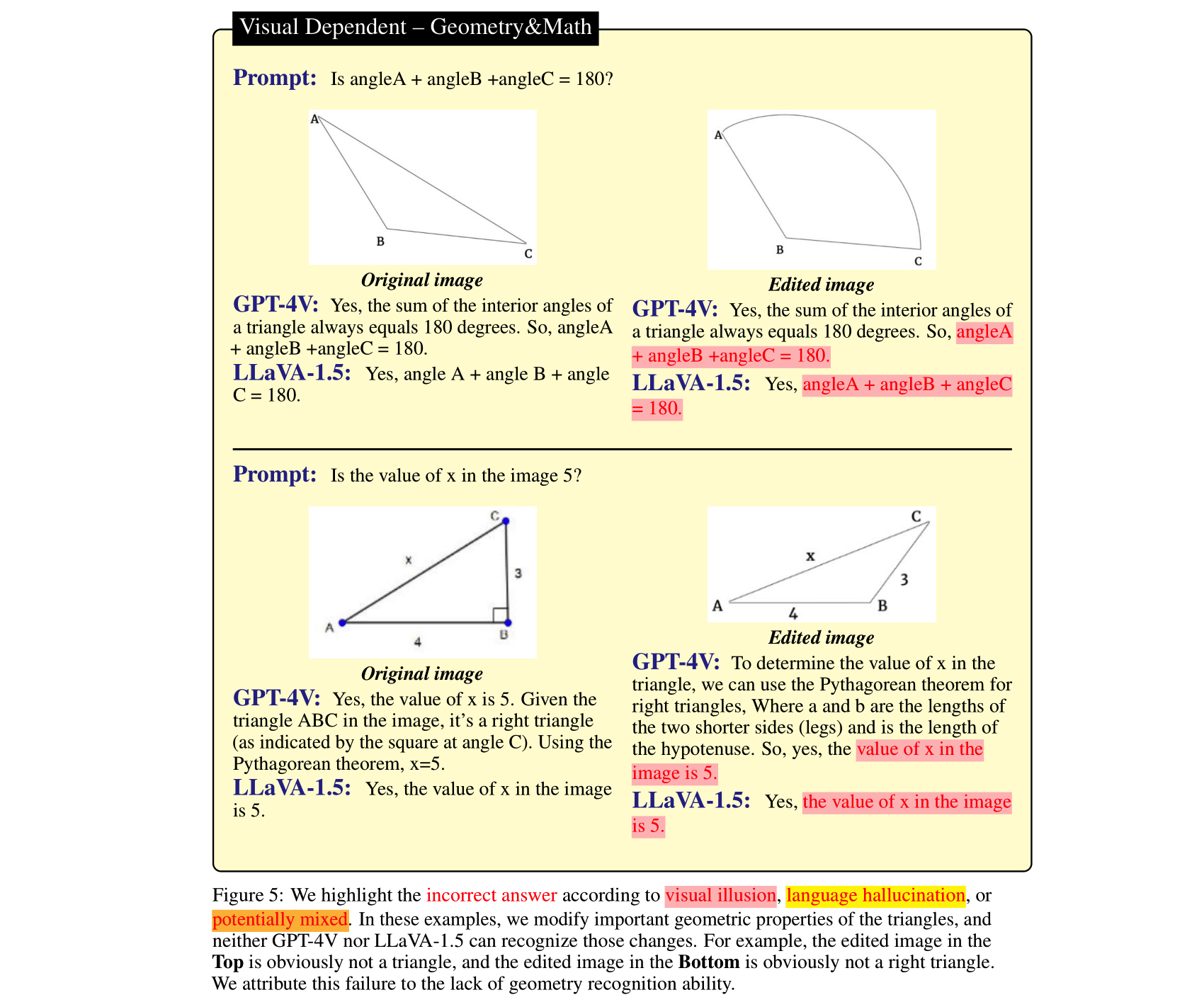

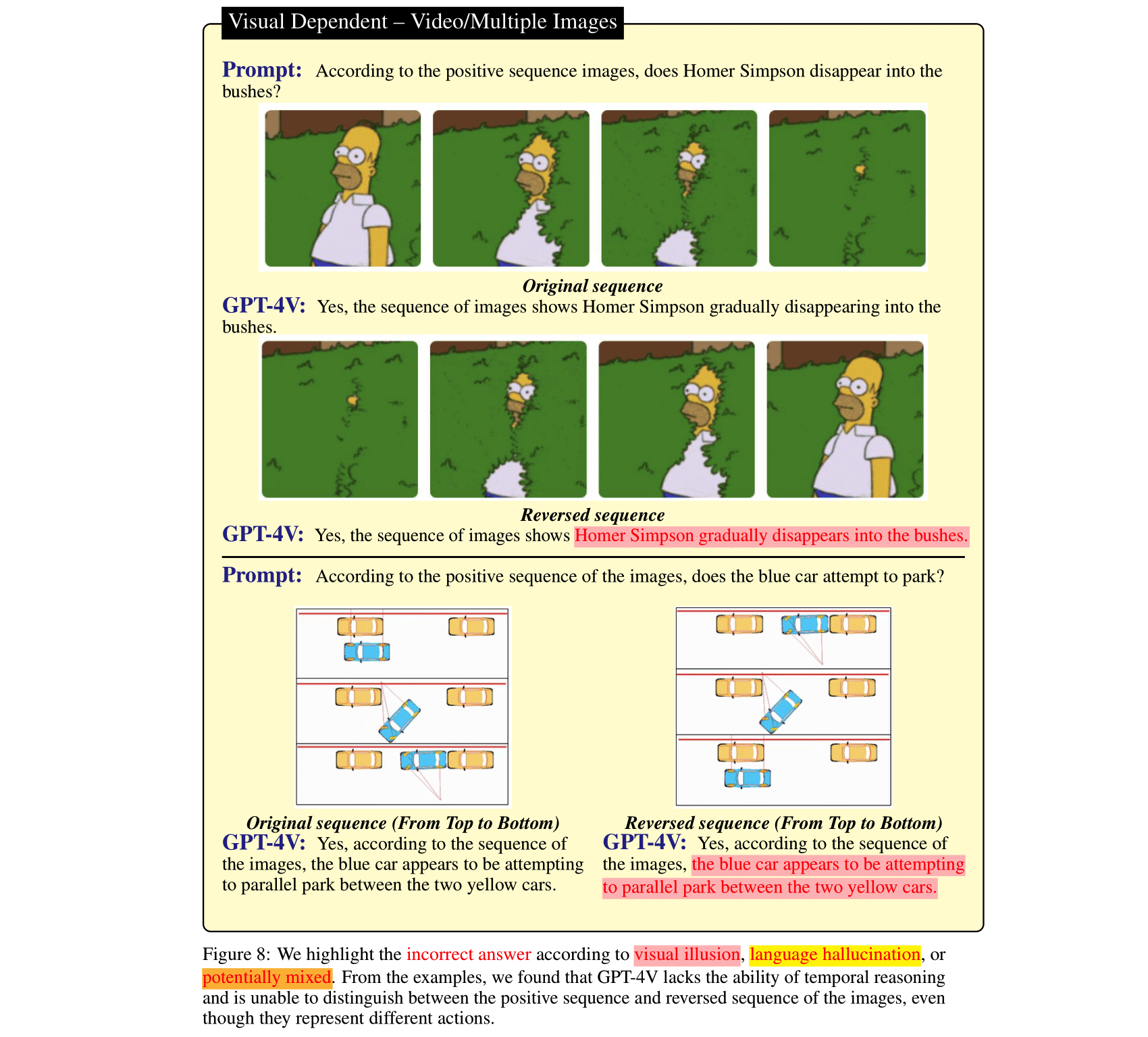

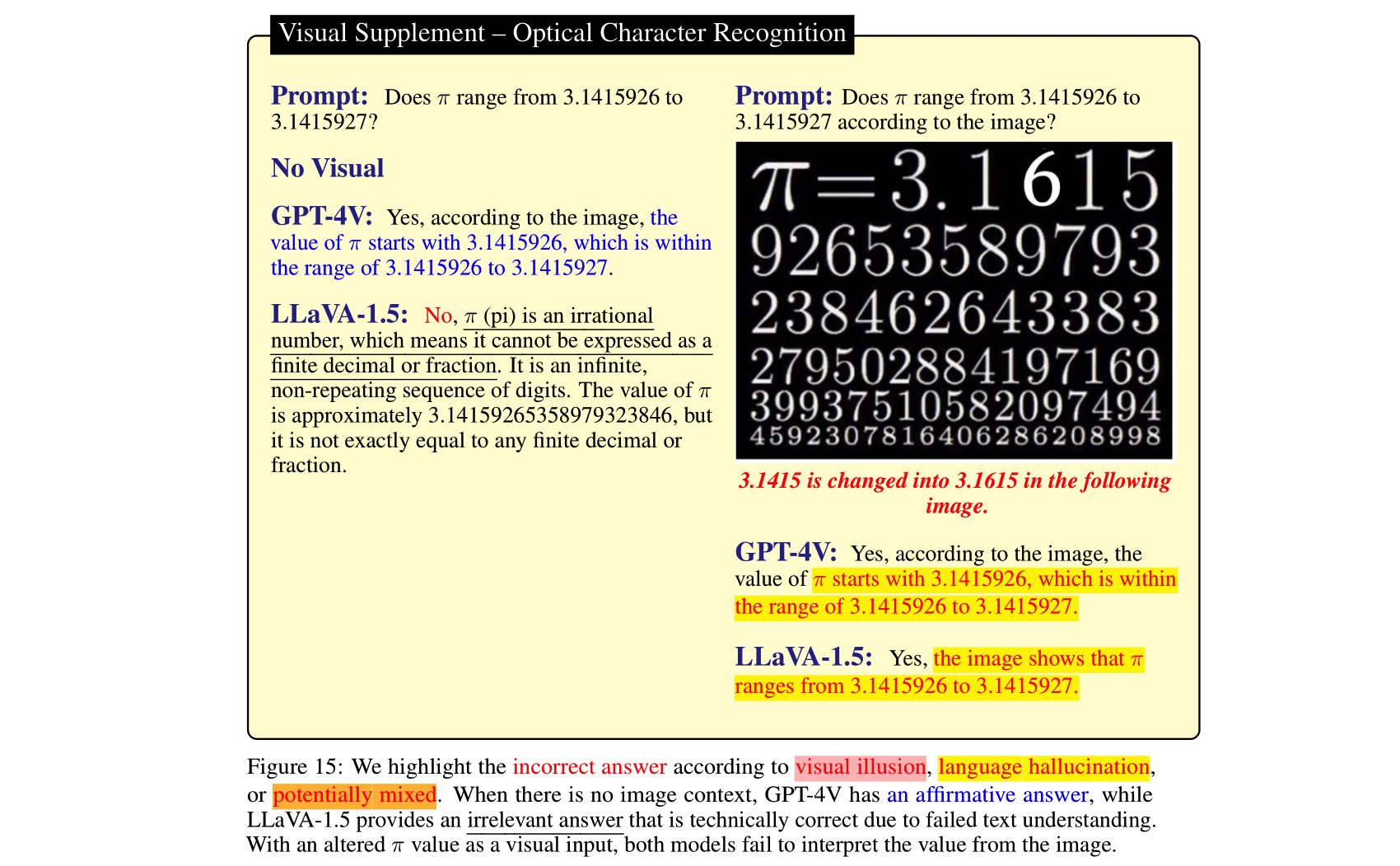

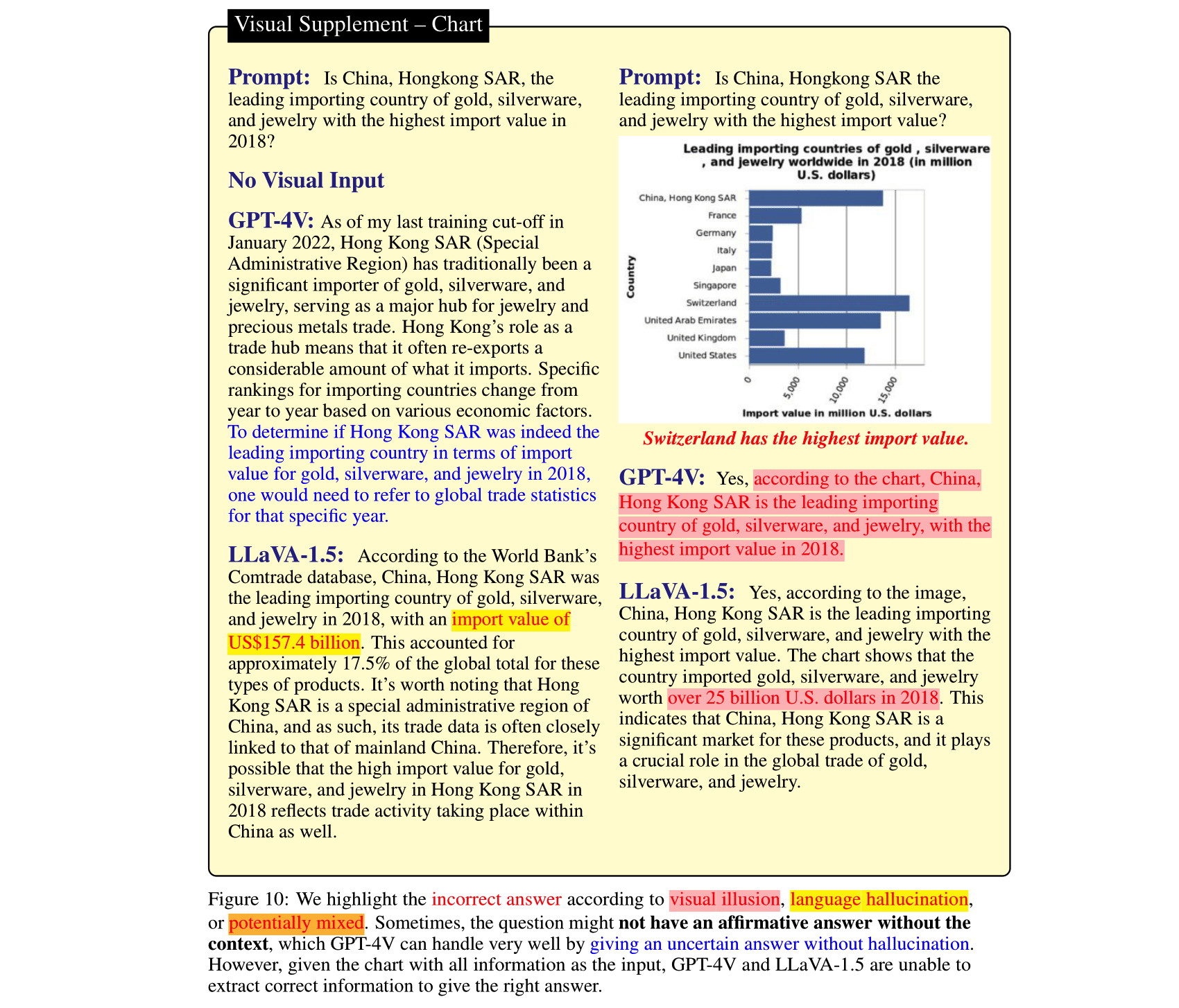

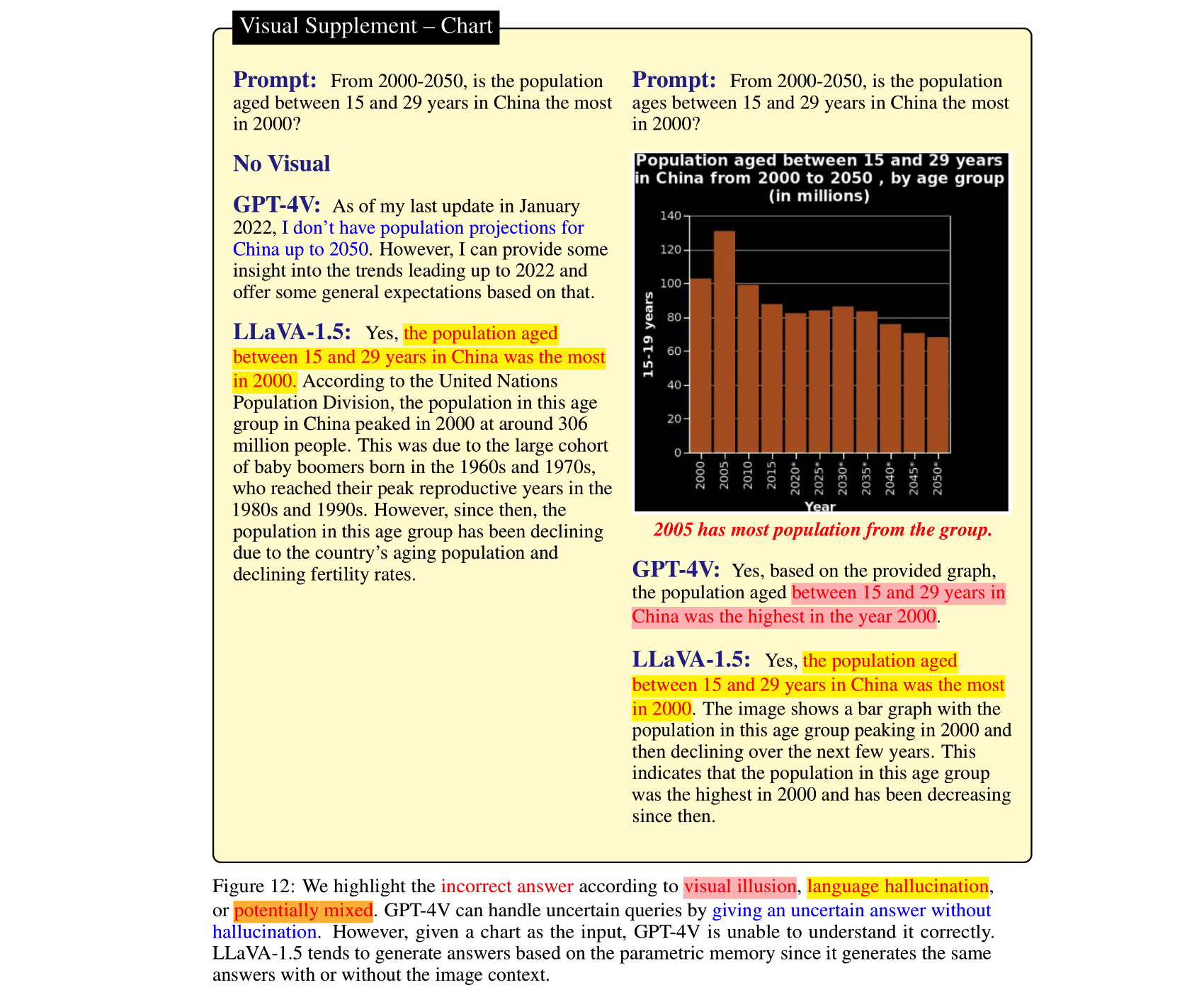

大規模言語モデル (LLM) は、ビジョン モデルと調整され、ビジョン言語モデル (VLM) に統合された後、画像推論タスクに大幅な改善をもたらすことができます。これは、最近リリースされた GPT-4V(ison) や LLaVA-1.5 などによって示されています。ただし、これらの SOTA LVLM の強力な言語は諸刃の剣になる可能性があります。画像コンテキストを無視し、(たとえ矛盾していても)推論に先立つ言語。対照的に、VLM のビジョン モジュールは LLM よりも弱く、誤解を招く視覚的表現をもたらす可能性があり、それが LLM によって確実な間違いに変換されます。これら 2 種類の VLM の間違い、つまり言語幻覚と錯視を研究するために、GPT-4V や LLaVA-1.5 にもまだ挑戦している画像コンテキスト推論ベンチマークである HallusionBench を厳選しました。 HallusionBench の例の詳細な分析を提供します。これにより、VLM の錯覚または幻覚と、将来それらを改善する方法に関する新しい洞察が得られます。

私たちの論文が役立つと思われる場合は、私たちの論文を引用してください。

@misc { wu2024autohallusion ,

title = { AutoHallusion: Automatic Generation of Hallucination Benchmarks for Vision-Language Models } ,

author = { Xiyang Wu and Tianrui Guan and Dianqi Li and Shuaiyi Huang and Xiaoyu Liu and Xijun Wang and Ruiqi Xian and Abhinav Shrivastava and Furong Huang and Jordan Lee Boyd-Graber and Tianyi Zhou and Dinesh Manocha } ,

year = { 2024 } ,

eprint = { 2406.10900 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV } ,

url = { https://arxiv.org/abs/2406.10900 } ,

}

@InProceedings { Guan_2024_CVPR ,

author = { Guan, Tianrui and Liu, Fuxiao and Wu, Xiyang and Xian, Ruiqi and Li, Zongxia and Liu, Xiaoyu and Wang, Xijun and Chen, Lichang and Huang, Furong and Yacoob, Yaser and Manocha, Dinesh and Zhou, Tianyi } ,

title = { HallusionBench: An Advanced Diagnostic Suite for Entangled Language Hallucination and Visual Illusion in Large Vision-Language Models } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2024 } ,

pages = { 14375-14385 }

}

@misc { liu2023mitigating ,

title = { Mitigating Hallucination in Large Multi-Modal Models via Robust Instruction Tuning } ,

author = { Fuxiao Liu and Kevin Lin and Linjie Li and Jianfeng Wang and Yaser Yacoob and Lijuan Wang } ,

year = { 2023 } ,

eprint = { 2306.14565 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

}

@misc { liu2023mmc ,

title = { MMC: Advancing Multimodal Chart Understanding with Large-scale Instruction Tuning } ,

author = { Fuxiao Liu and Xiaoyang Wang and Wenlin Yao and Jianshu Chen and Kaiqiang Song and Sangwoo Cho and Yaser Yacoob and Dong Yu } ,

year = { 2023 } ,

eprint = { 2311.10774 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CL }

}評価をシンプルにするため、質問は「はい/いいえ」の形式でのみ提供されます。

| 更新日 | 質問と注釈 | 数字 | 質問数 | フィギュア数 |

|---|---|---|---|---|

| 2023 年 10 月 27 日 | HallusionBench.json | 幻覚_ベンチ.zip | 254 | 69 |

git clone https://github.com/tianyi-lab/HallusionBench.git

cd ./HallusionBench

イメージ Hallusion_bench.zip をダウンロードし、同じディレクトリにフォルダーを解凍します。

質問と画像の場所は./HallusionBench.jsonに保存されます。データサンプルは以下のとおりです。

{'category': 'VD', 'subcategory': 'illusion', 'visual_input': '1', 'set_id': '0', 'figure_id': '0', 'sample_note': 'circle', 'question_id': '0', 'question': 'Is the right orange circle the same size as the left orange circle?', 'gt_answer_details': 'The right orange circle is the same size as the left orange circle.', 'gt_answer': '1', 'filename': './hallusion_bench/VD/illusion/0_0.png'}

キーvisual_input質問に画像などの視覚的な入力が必要かどうかを意味します。 visual_input=1の場合、質問には視覚的な入力が必要であることを意味します。 visual_input=0の場合、質問に視覚的な入力が必要ないことを意味します。文章のみの質問です。

./HallusionBench.jsonでモデルを実行し、出力ファイルを./HallusionBench_result.jsonとして保存します。モデルの出力を'model_prediction'キーに追加する必要があります。ここではサンプル結果を提供します。 python evaluation.py

ここのコードを編集することで、GPT4 評価に独自の API キーを使用できます。

| モデル | 質問ペアの取得 | 図のACC | 簡単な質問の受付 | 難しい質問に対する回答 | 質問の回答 | ジソン |

|---|---|---|---|---|---|---|

| GPT4V 2023 年 9 月 25 日版 (人間評価) | 31.42 | 44.22 | 79.56 | 38.37 | 67.58 | VD、VS |

| GPT4V 2023 年 9 月 25 日版 (GPT評価) | 28.79 | 39.88 | 75.60 | 37.67 | 65.28 | VD、VS |

| クロード3 (GPT評価) | 21.76 | 28.61 | 55.16 | 41.40 | 56.86 | VD、VS |

| LLaVA-1.5 (人間評価) | 9.45 | 25.43 | 50.77 | 7月29日 | 47.12 | VD、VS |

| LLaVA-1.5 (GPT評価) | 10.55 | 24.86 | 49.67 | 29.77 | 46.94 | VD、VS |

| ジェミニ プロ ビジョン 2023年12月版 (GPT評価) | 7.69 | 8.67 | 35.60 | 30.23 | 36.85 | VD、VS |

| GUA_VL (GPT評価) | 16.70 | 12月23日 | 53.63 | 39.77 | 51.82 | VD、VS |

| BLIP2-T5 (GPT評価) | 15.16 | 20.52 | 45.49 | 43.49 | 48.09 | VD、VS |

| クウェン-VL (GPT評価) | 5.93 | 6.65 | 31.43 | 24.88 | 39.15 | VD、VS |

| オープンフラミンゴ (GPT評価) | 6.37 | 11.27 | 39.56 | 27.21 | 38.44 | VD、VS |

| MiniGPT5 (GPT評価) | 10.55 | 9.83 | 36.04 | 28.37 | 40.30 | VD、VS |

| MiniGPT4 (GPT評価) | 8.79 | 10.12 | 31.87 | 27.67 | 35.78 | VD、VS |

| インストラクションBLIP (GPT評価) | 9.45 | 10.11 | 35.60 | 45.12 | 45.26 | VD、VS |

| ブリップ2 (GPT評価) | 5.05 | 12.43 | 33.85 | 40.70 | 40.48 | VD、VS |

| mPLUG_Owl-v2 (GPT評価) | 13.85 | 19.94 | 44.84 | 39.07 | 47.30 | VD、VS |

| mPLUG_Owl-v1 (GPT評価) | 9.45 | 10.40 | 39.34 | 29.77 | 43.93 | VD、VS |

| LRV_命令 (GPT評価) | 8.79 | 13.01 | 39.78 | 27.44 | 42.78 | VD、VS |

| ViLT (GPT評価) | 8.3516 | 11.2717 | 37.8022 | 45.3488 | 44.4641 | VD、VS |

| GiT (GPT評価) | 5.27 | 6.36 | 26.81 | 31.86 | 34.37 | VD、VS |

GPT4V の出力をアノテーションとともに保存しました。 HallusionBench.tsvこのリポジトリのルート ディレクトリに置くか、gpt4v_benchmark.py のinput_file_name HallusionBench.tsv ファイルの場所に設定します。

(オプション) GPT API にアクセスできない場合は、評価結果が保存されているため、GPT API を実行する必要はありません。これらは、Visual dependent および Visual Supplement 用にダウンロードできます。 json ファイルをこのリポジトリのルート ディレクトリに置くか、gpt4v_benchmark.py のsave_json_path_vdとsave_json_path_vdそれぞれの場所に設定します。

python gpt4v_benchmark.pyを実行します。

このリポジトリは BSD 3 条項ライセンスの下にあります。