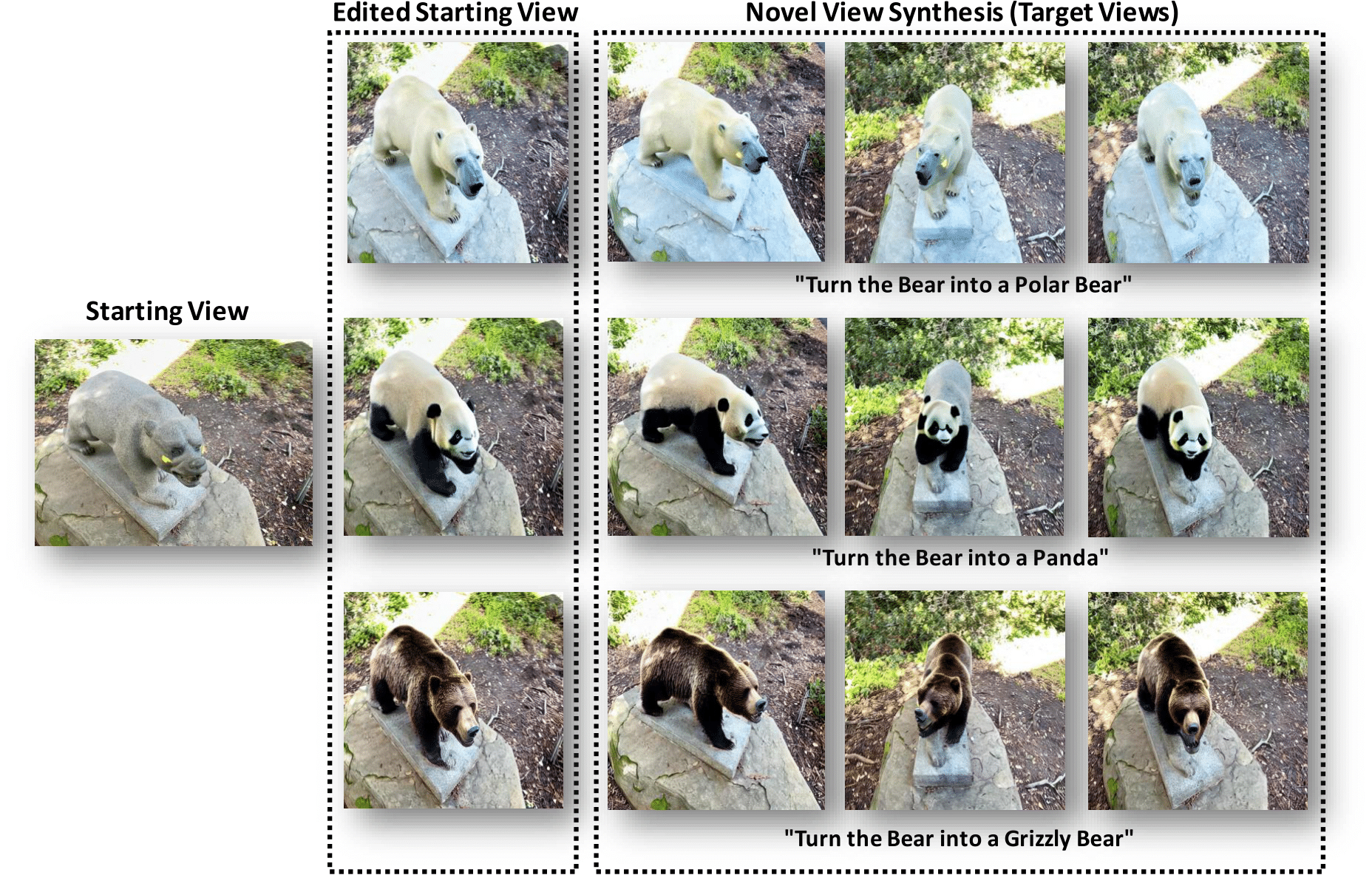

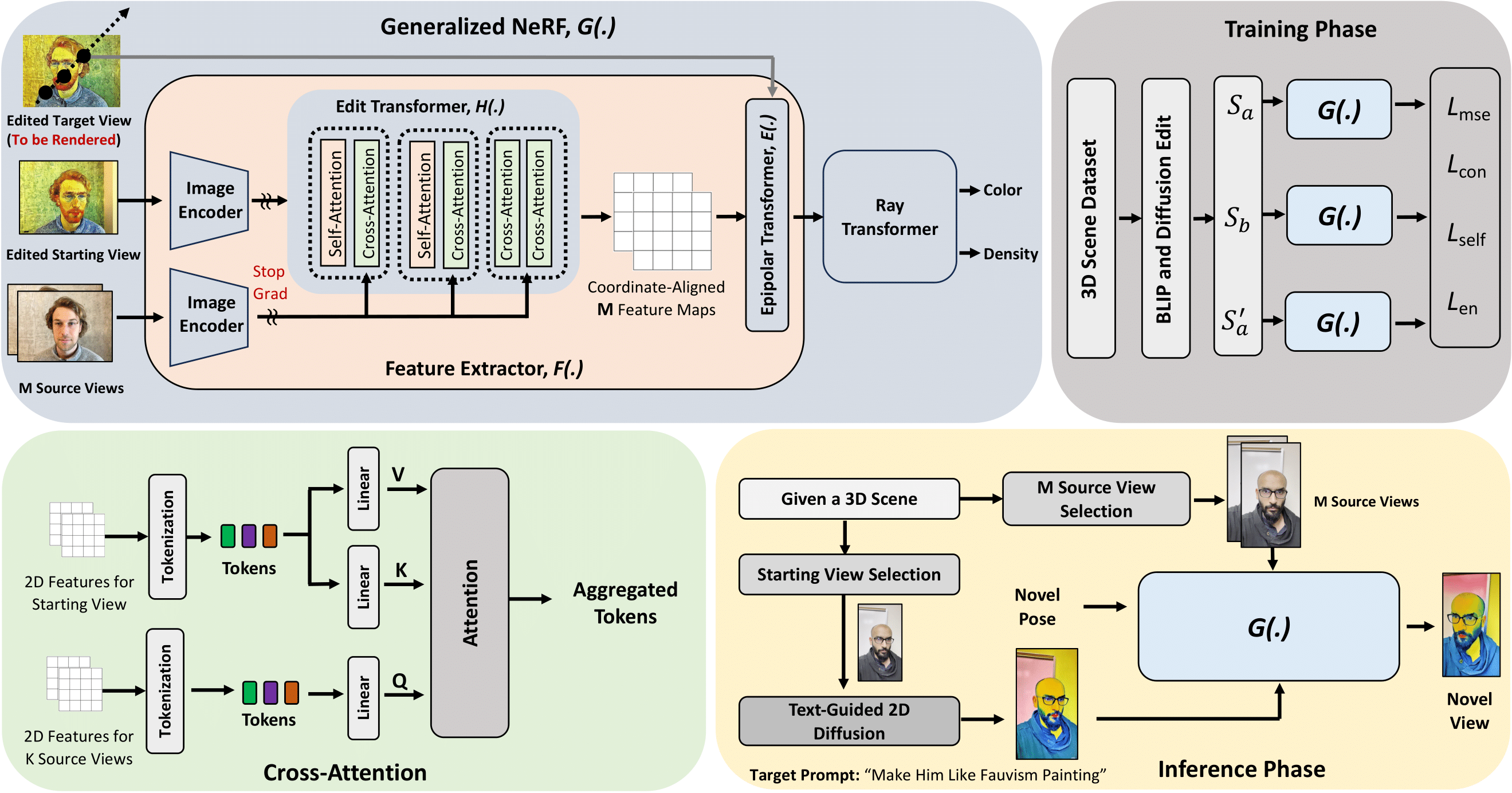

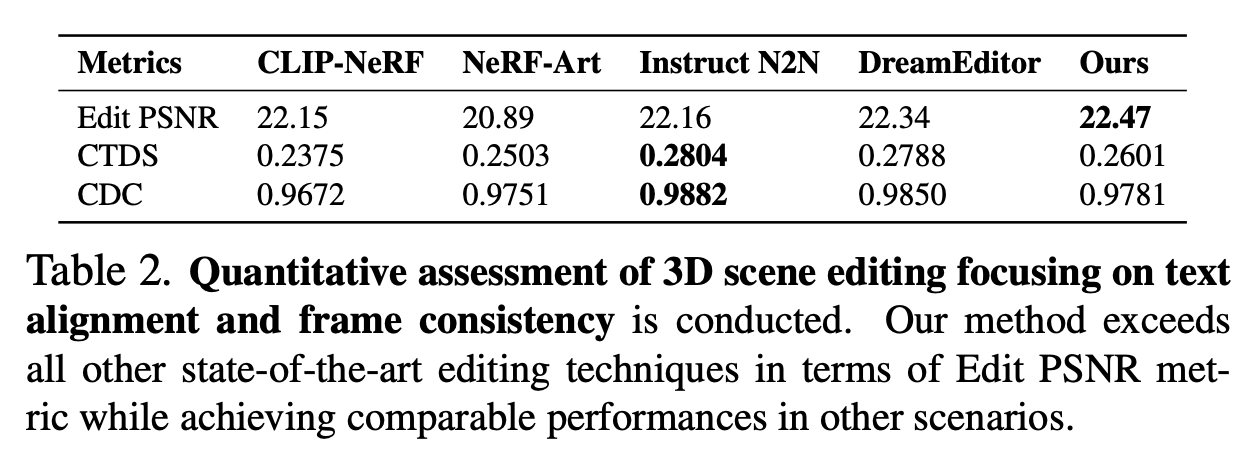

Free-Editor を使用すると、3D シーンの1 つのビューのみを編集して、3D シーンを編集できます。編集はトレーニング不要で、わずか3 分で完了します。 70分の代わりに! SOTAで。

ようこそご覧ください?最新のアップデートについてはこのリポジトリを参照してください。

✅ [2023.12.21] : arXiv で論文 Free-Editor を公開しました。

✅ [2023.12.18] : プロジェクトページを公開しました。

次のことを行ってください-

conda create --name nerfstudio -y python=3.9

conda activate nerfstudio

python -m pip install --upgrade pip pip uninstall torch torchvision functorch tinycudann conda install -c " nvidia/label/cuda-11.8.0 " cuda-toolkit pip install torch==2.1.2+cu118 torchvision==0.16.2+cu118 --extra-index-url https://download.pytorch.org/whl/cu118 pip install ninja git+https://github.com/NVlabs/tiny-cuda-nn/ # subdirectory=bindings/torch git clone https://github.com/DiffSK/configobj.git

cd configobj

python setup.py install pip install nerfstudio git clone https://github.com/nerfstudio-project/nerfstudio.git

cd nerfstudio

pip install --upgrade pip setuptools

pip install -e . ns-download-data nerfstudio --capture-name=poster ns-train nerfacto --data data/nerfstudio/poster If you start seeing on your linux terminal that it started training, then it means everything is good to go!

場合によっては、追加の依存関係もインストールする必要があります。

他のデータセットをダウンロードするには、このリンクにアクセスしてください - https://huggingface.co/datasets/yangtaointernship/RealEstate10K-subset/tree/main

ここで、「synthetic_scenes.zip」はディープボクセルデータです。

「nerf_synthetic」と Blender データセットはおそらく同じデータセットです。

「frames.zip」は、RealEstate10K データセットの 200 シーンから抽出されたフレームです。 「train.zip」はカメラファイルです。

Shiny Dataset については、https://nex-mpi.github.io/ にアクセスしてください。

スペース データセットの場合、

git clone https://github.com/augmentedperception/spaces_dataset conda deactivate

conda create --name nerfbase

conda activate nerfbase

pip install nerfbaselinesサンプル データセットをダウンロードします。例えば、

ガーデン シーンをキャッシュ フォルダーにダウンロードします。

mdkir data

cd data

mkdir nerf_dataset

cd nerf_dataset

nerfbaselines download-dataset external://mipnerf360/garden nerfbaselines download-dataset external://nerfstudio nerfbaselines download-dataset external://mipnerf360/kitchen -o kitchen git clone https://huggingface.co/Salesforce/blip2-opt-2.7b小さいバージョンを使用したい場合は、これを使用してください

from transformers import BlipProcessor, BlipForConditionalGeneration

processor = BlipProcessor.from_pretrained( " Salesforce/blip-image-captioning-base " )

model = BlipForConditionalGeneration.from_pretrained( " Salesforce/blip-image-captioning-base " ) git clone https://huggingface.co/stabilityai/stable-diffusion-3-medium huggingface-cli login python src/fedit/dataset_creation.py python train.py

この作品は多くの素晴らしい研究成果とオープンソース プロジェクトに基づいて構築されています。共有してくれたすべての著者に感謝します。

私たちの論文とコードが研究に役立つと思われる場合は、スターと引用を与えることを検討してください。

@misc { karim2023freeeditor ,

title = { Free-Editor: Zero-shot Text-driven 3D Scene Editing } ,

author = { Nazmul Karim and Umar Khalid and Hasan Iqbal and Jing Hua and Chen Chen } ,

year = { 2023 } ,

eprint = { 2312.13663 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

}