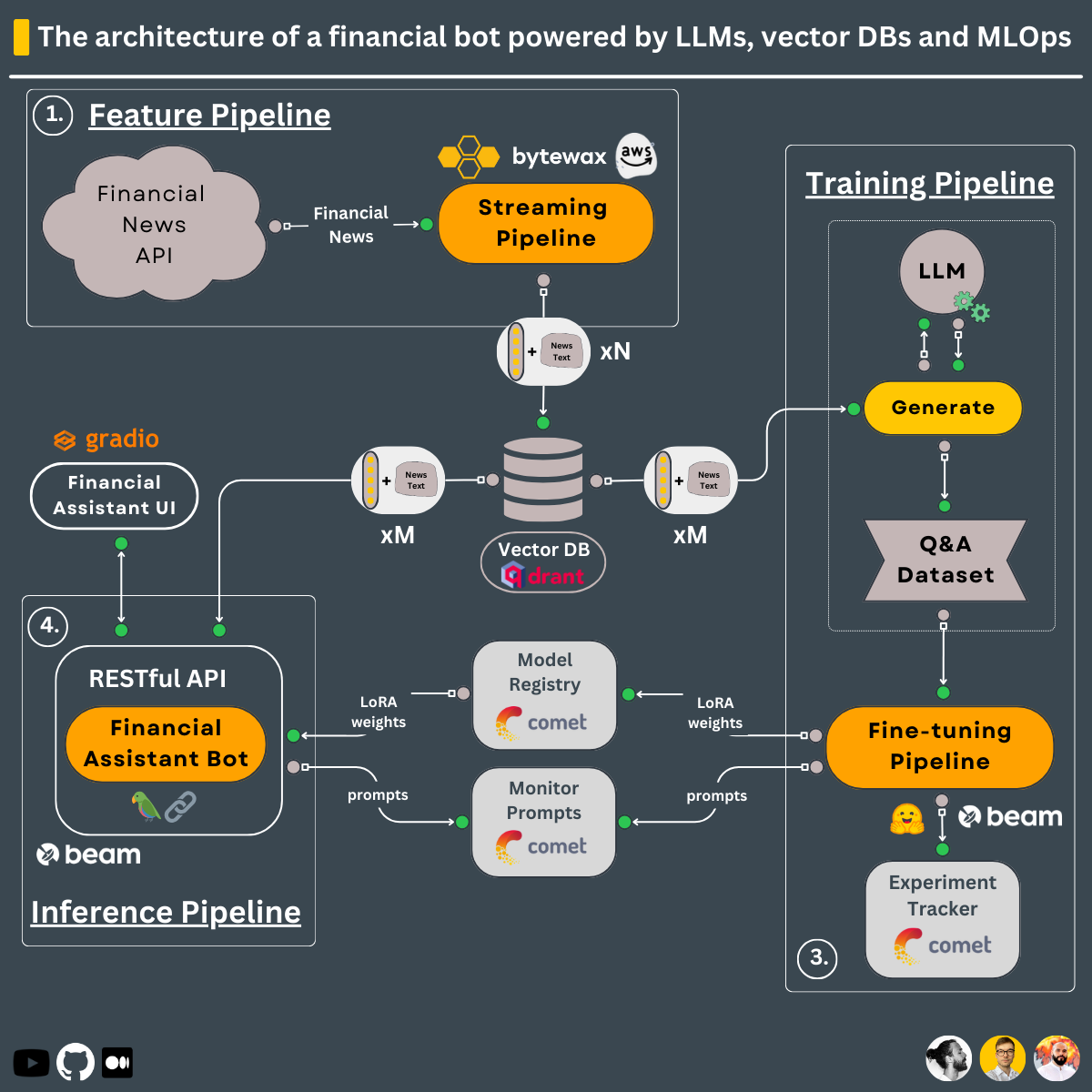

3 パイプライン設計を使用して、このコースで構築する方法を学習します↓

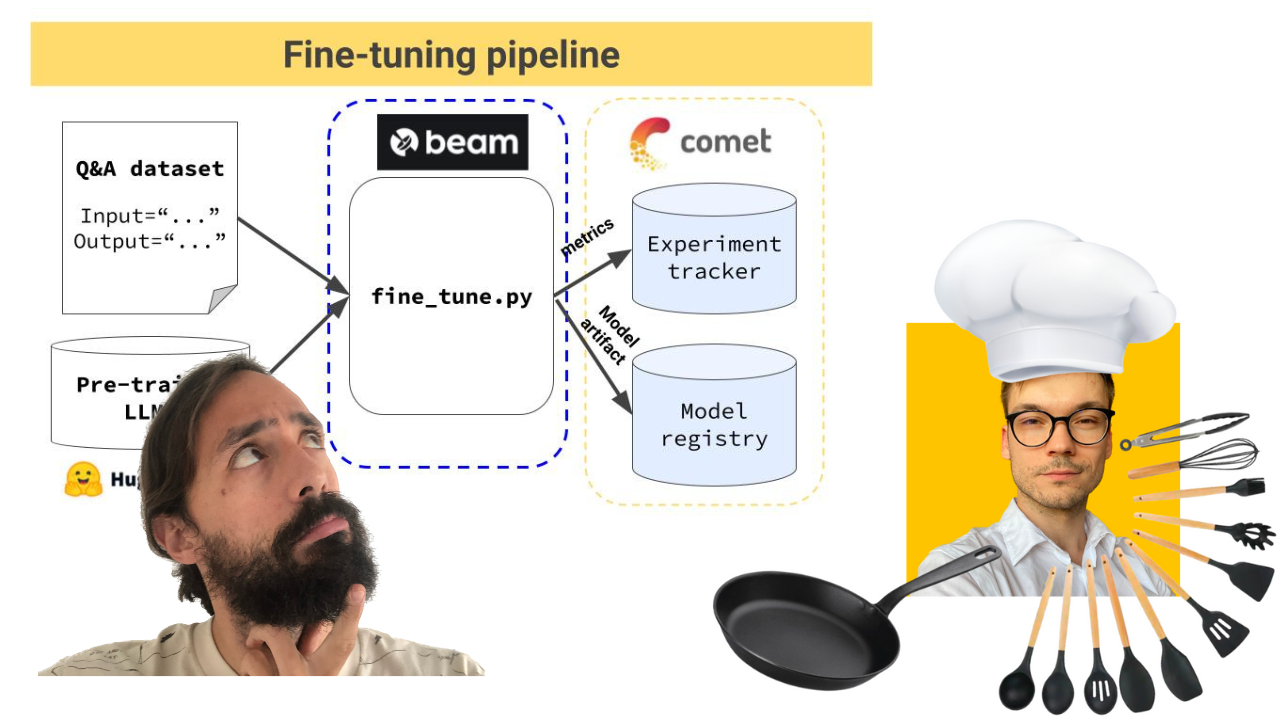

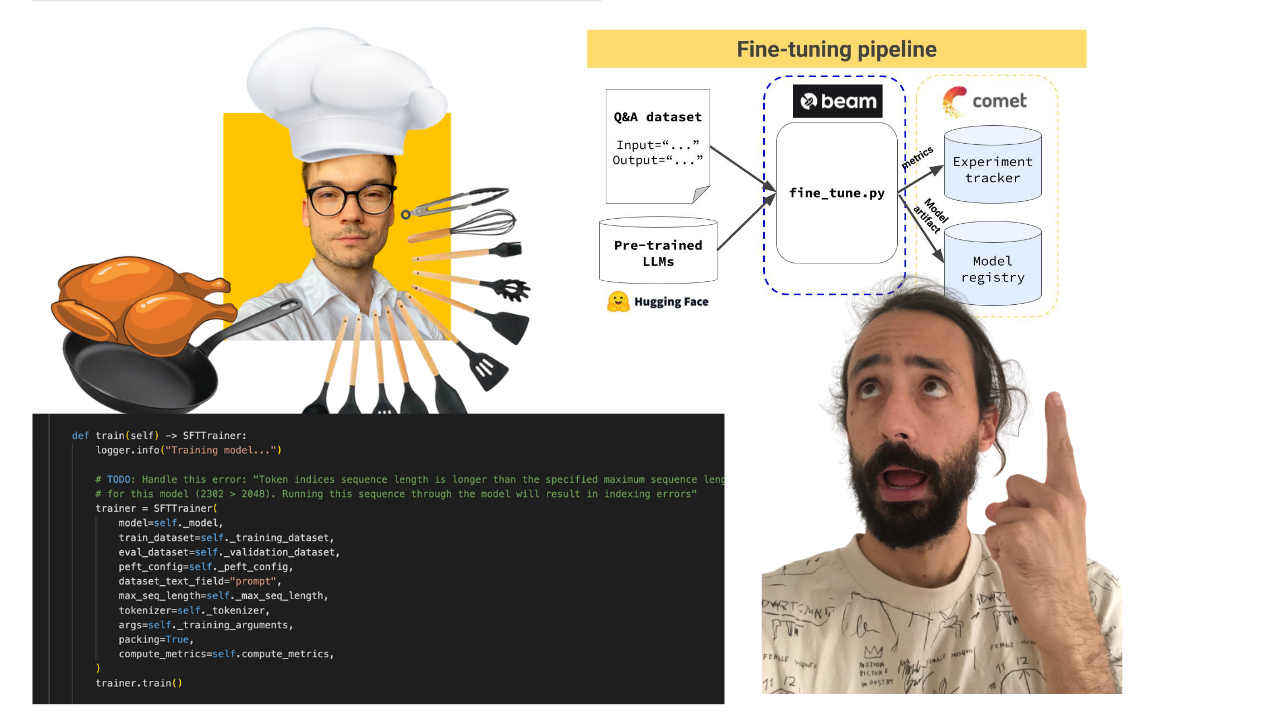

次のようなトレーニング パイプライン:

トレーニング パイプラインは、サーバーレス GPU インフラストラクチャとして Beam を使用してデプロイされます。

-> modules/training_pipelineディレクトリの下にあります。

注:最小ハードウェア要件を満たしていない場合でも、心配する必要はありません。トレーニング パイプラインを Beam のサーバーレス インフラストラクチャにデプロイし、そこで LLM をトレーニングする方法を示します。

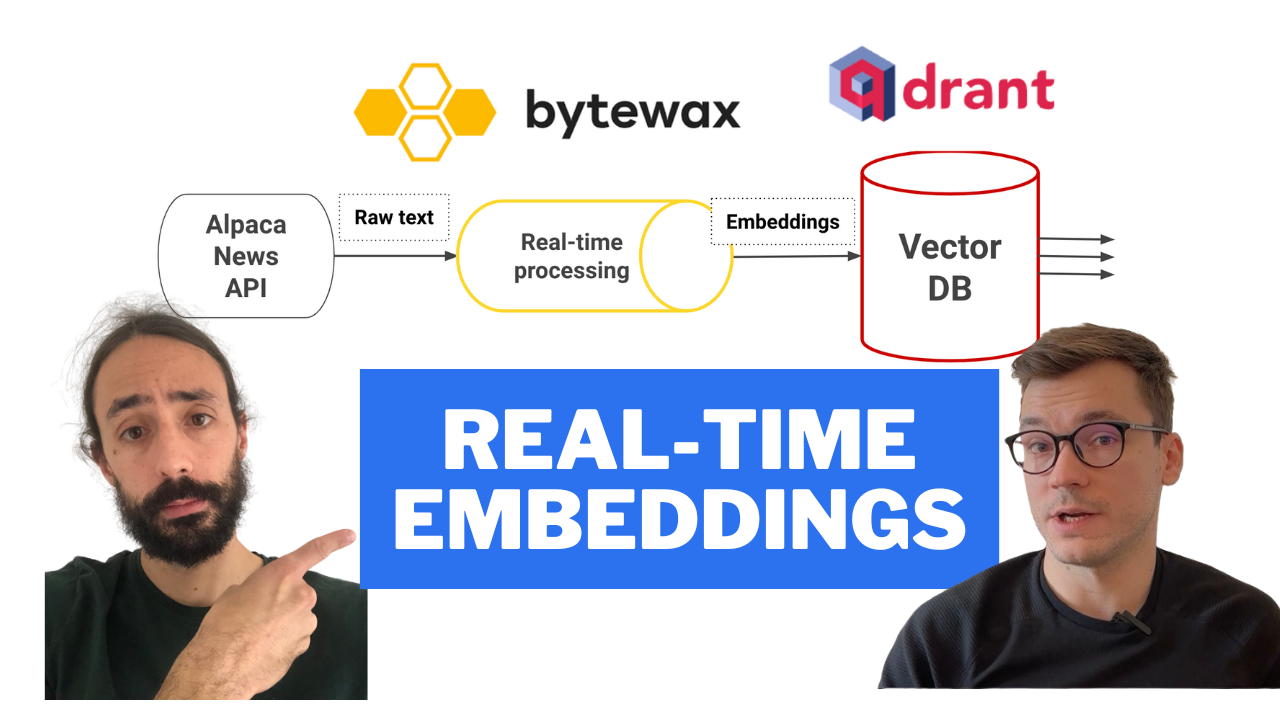

次のようなリアルタイム機能パイプライン:

ストリーミング パイプラインは、GitHub アクションに組み込まれた CI/CD パイプラインを使用して、AWS EC2 マシンに自動的にデプロイされます。

-> modules/streaming_pipelineディレクトリの下にあります。

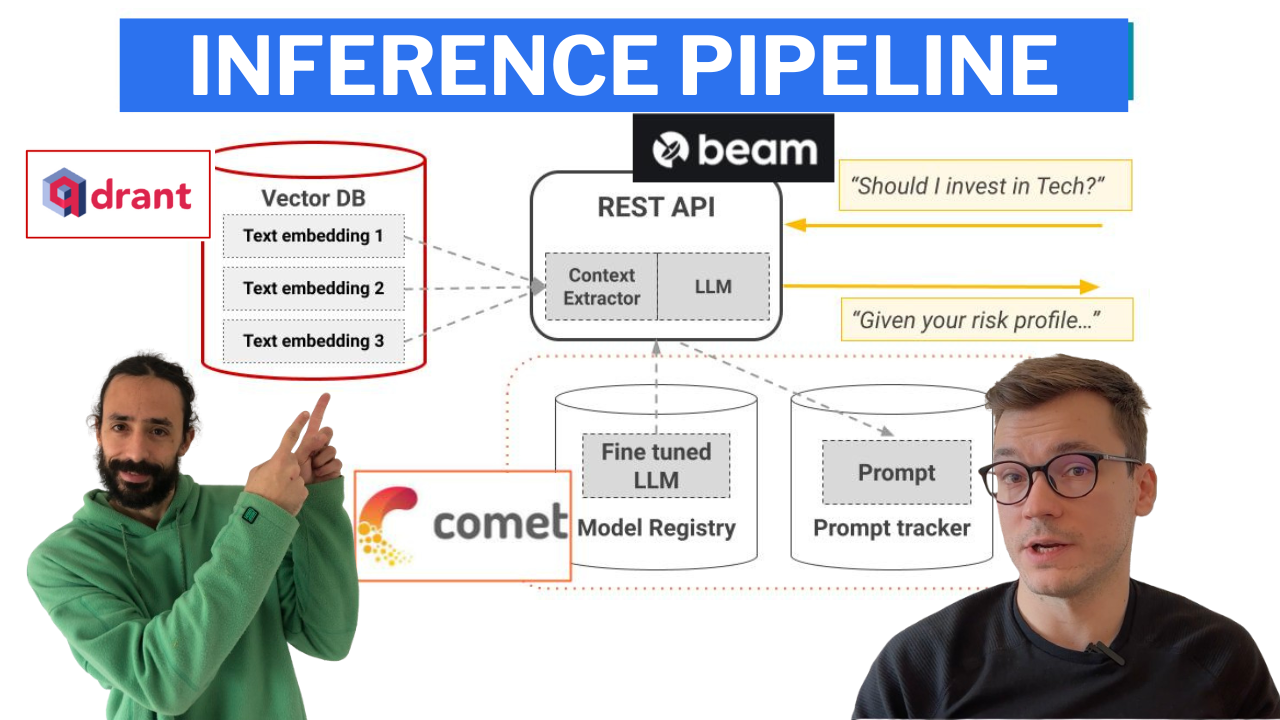

LangChain を使用して次のようなチェーンを作成する推論パイプライン。

推論パイプラインは、サーバーレス GPU インフラストラクチャとしての Beam を RESTful API として使用してデプロイされます。また、デモ用に UI の下にラップされており、Gradio で実装されています。

-> modules/financial_botディレクトリの下にあります。

注:最小ハードウェア要件を満たしていない場合でも、心配する必要はありません。推論パイプラインを Beam のサーバーレス インフラストラクチャにデプロイし、そこから LLM を呼び出す方法を示します。

GPT3.5使用して財務 Q&A データセットを生成し、財務条件の使用と財務に関する質問への回答に特化するようにオープンソース LLM を微調整しました。 GPT3.5などの大きな LLM を使用して、より小さな LLM (Falcon 7B など) をトレーニングするデータセットを生成することは、蒸留による微調整として知られています。

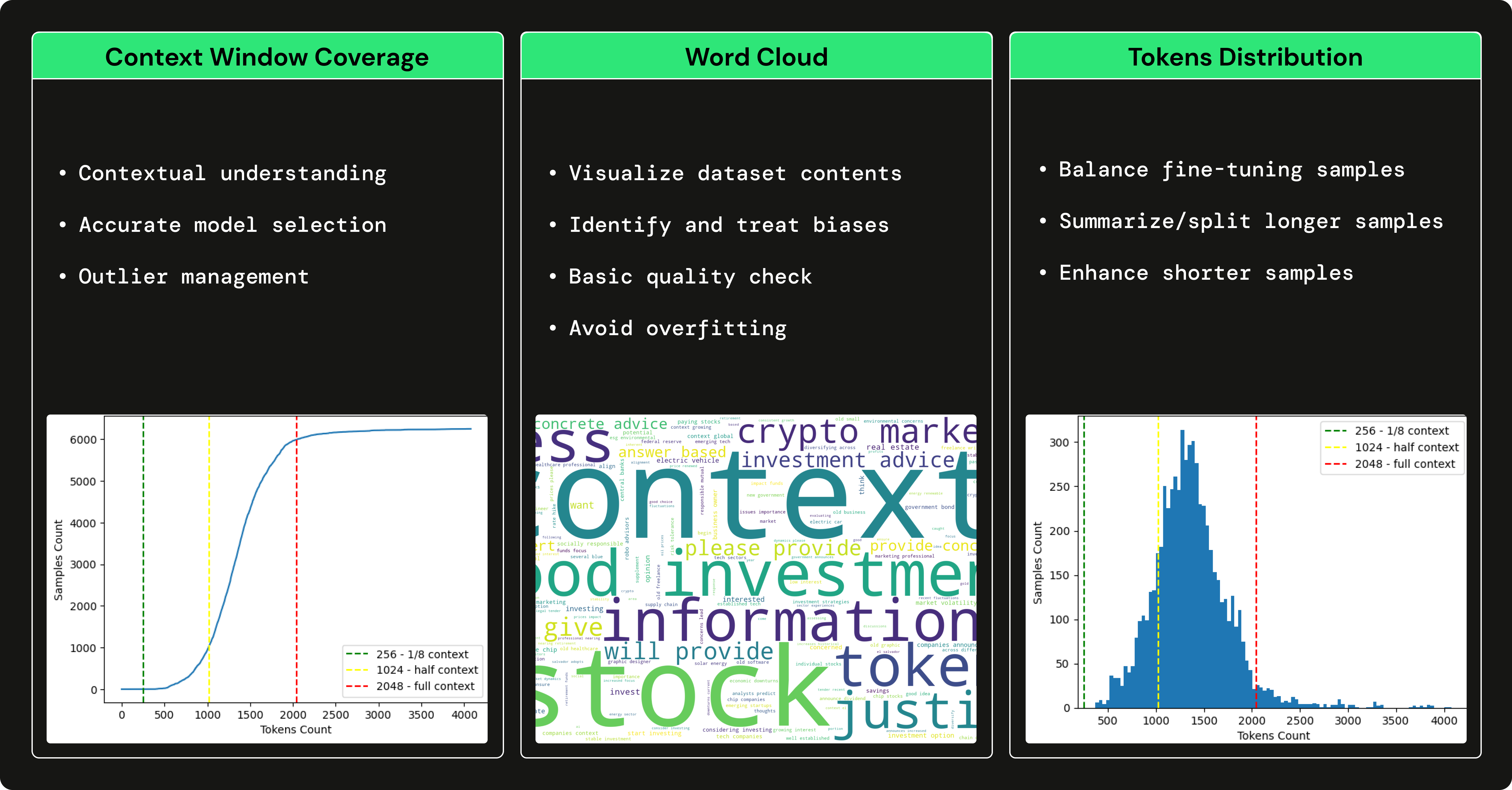

→ 財務 Q&A データセットをどのように生成したかを理解するには、Pau Labarta が書いたこの記事を参照してください。

→ 財務 Q&A データセットの完全な分析を確認するには、Alexandru Razvant が作成したコースの dataset_analysis サブセクションを確認してください。

モジュールに入る前に、コース用に追加の外部ツールをいくつかセットアップする必要があります。

注:必要なものはすべてのモジュールで示されるため、モジュールごとに設定できます。

financial news data source

このドキュメントに従って、無料アカウントを作成し、このコース内で必要な API キーを生成する方法を説明します。

注: Alpaca データ接続 1 回は無料です。

serverless vector DB

Qdrant にアクセスして、無料アカウントを作成します。

その後、このドキュメントに従って、このコース内で必要となる API キーを生成する方法を説明します。

注: Qdrant のフリーミアム プランのみを使用します。

serverless ML platform

Comet ML にアクセスして、無料アカウントを作成します。

その後、このガイドに従って、コース内で必要となる API KEY と新しいプロジェクトを生成します。

注: Comet ML のフリーミアム プランのみを使用します。

serverless GPU compute | training & inference pipelines

Beam に移動し、無料アカウントを作成します。

その後、インストール ガイドに従って CLI をインストールし、Beam 資格情報を使用して構成する必要があります。

Beam について詳しくは、こちらの入門ガイドをご覧ください。

注:無料のコンピューティング時間は最大 10 時間です。その後は、使用した分だけお支払いいただきます。 Nvidia GPU > 8 GB VRAM を使用していて、トレーニングおよび推論パイプラインをデプロイしたくない場合、Beam の使用はオプションです。

Poetry を使用する場合、Poetry 仮想環境内で Beam CLI を見つけるのに問題がありました。これを修正するには、Beam をインストールした後、次のように Poetry のバイナリを指すシンボリックリンクを作成します。

export COURSE_MODULE_PATH= < your-course-module-path > # e.g., modules/training_pipeline

cd $COURSE_MODULE_PATH

export POETRY_ENV_PATH= $( dirname $( dirname $( poetry run which python ) ) )

ln -s /usr/local/bin/beam ${POETRY_ENV_PATH} /bin/beam cloud compute | feature pipeline

AWS に移動し、アカウントを作成し、認証情報のペアを生成します。

その後、AWS CLI v2.11.22 をダウンロードしてインストールし、認証情報を使用して設定します。

注:使用した分だけお支払いいただきます。 t2.small EC2 VM のみをデプロイします。これは、1 時間あたりわずか~$0.023です。機能パイプラインをデプロイしたくない場合、AWS の使用はオプションです。

すべてのモジュールには依存関係とスクリプトがあります。本番環境の設定では、すべてのモジュールにリポジトリがありますが、この使用例では、学習目的ですべてを 1 か所にまとめています。

したがって、各モジュールの README を個別に調べて、インストール方法と使用方法を確認してください。

このコースを最大限に活用するために、このリポジトリを複製し、これまでに行ったことをすべて複製することを強くお勧めします。

各モジュールのビデオ講義、記事、および README ドキュメントには、段階的な手順が記載されています。

楽しく学習しましょう!

GitHub コード (MIT ライセンスに基づいてリリース) とビデオ講義 (YouTube でリリース) は完全に無料です。常にそうなります。

Medium のレッスンは、Medium の有料ウォールの下でリリースされます。すでにお持ちの場合は無料です。それ以外の場合は、記事を読むために月額 5 ドルを支払う必要があります。

コース中に質問や問題がある場合は、必要なことをすべて詳しく説明できるこのリポジトリに問題を作成することをお勧めします。

それ以外の場合は、LinkedIn で教師に連絡することもできます。

ビデオを見るにはここをクリックしてください?

ビデオを見るにはここをクリックしてください?

ビデオを見るにはここをクリックしてください?

ビデオを見るにはここをクリックしてください?

ビデオを見るにはここをクリックしてください?

To understand the entire code step-by-step, check out our articles ↓

このコースは、MIT ライセンスに基づいてリリースされたオープンソース プロジェクトです。したがって、ライセンスを配布し、私たちの成果を認めている限り、このプロジェクトを安全にクローンまたはフォークして、必要なもの (大学のプロジェクト、大学の学位プロジェクトなど) のインスピレーションの源として使用できます。

| パウ・ラバルタ・バジョ |シニア ML および MLOps エンジニア 主な先生。ビデオレッスンの人。 リンクトイン ツイッター/X ユーチューブ 現実世界の ML ニュースレター 現実世界の ML サイト |

| アレクサンドル・ラズヴァント |シニア ML エンジニア 二代目シェフ。舞台裏のエンジニア。 リンクトイン ニューラリープ |

| ポール・イウスティン |シニア ML および MLOps エンジニア メインシェフ。ビデオレッスンにランダムに現れる男たち。 リンクトイン ツイッター/X ML ニュースレターのデコード 個人サイト | ML および MLOps ハブ |