ニュース |インストール |クイックスタート |コミュニティ |プロジェクト |モデル一覧 |寄稿者 |引用 |ライセンス

英語 | 中国語

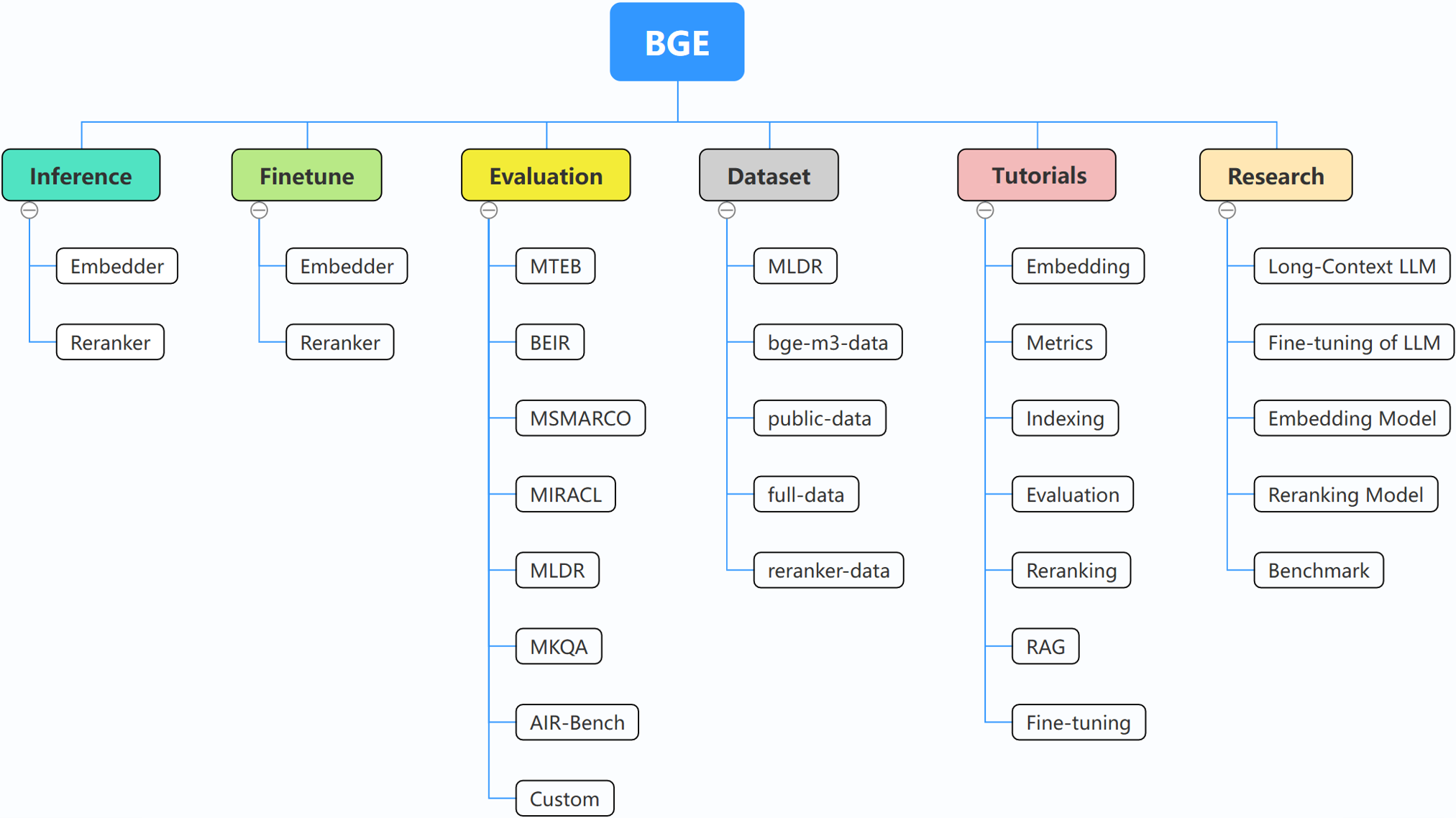

BGE (BAAI General Embedding) は、検索拡張 LLM に焦点を当てており、現在次のプロジェクトで構成されています。

2024 年 10 月 29 日: ? BGE 用の WeChat グループを作成しました。 QRコードをスキャンしてグループチャットに参加してください!アップデートや新しいリリースに関する直接のメッセージを入手するには、または質問やアイデアがある場合は、今すぐご参加ください。

2024 年 10 月 22 日: 別の興味深いモデルである OmniGen をリリースします。これは、さまざまなタスクをサポートする統合画像生成モデルです。 OmniGen は、ControlNet、IP アダプター、姿勢検出や顔検出などの補助モデルなどの追加のプラグインを必要とせずに、複雑な画像生成タスクを実行できます。

2024 年 9 月 10 日: MemoRAGの紹介、メモリにインスピレーションを得た知識発見を基盤とした RAG 2.0 に向けた一歩 (リポジトリ: https://github.com/qhjqhj00/MemoRAG、論文: https://arxiv.org/pdf/) 2409.05591v1)

2024 年 9 月 2 日: チュートリアルのメンテナンスを開始。コンテンツは積極的に更新され、充実していきますので、ご期待ください。

2024 年 7 月 26 日: 新しい埋め込みモデル bge-en-icl をリリースします。これは、コンテキスト内学習機能を組み込んだ埋め込みモデルで、タスク関連のクエリと応答の例を提供することで、より意味的に豊富なクエリをエンコードし、セマンティクスをさらに強化できます。埋め込みの表現能力。

2024 年 7 月 26 日: 新しい埋め込みモデル bge-multilingual-gemma2 をリリースします。これは gemma-2-9b に基づく多言語埋め込みモデルで、複数の言語と多様なダウンストリーム タスクをサポートし、多言語ベンチマーク (MIRACL、MTEB-fr) で新しい SOTA を達成します。 、MTEB-pl)。

2024 年 7 月 26 日: 新しい軽量リランカー bge-reranker-v2.5-gemma2-lightweight をリリースします。これは、gemma-2-9b に基づく軽量リランカーであり、トークン圧縮と層ごとの軽量操作をサポートしており、コストを節約しながら良好なパフォーマンスを確保できます。かなりの量のリソース。

BAAI/bge-reranker-baseおよびBAAI/bge-reranker-largeをリリースします。埋め込みモデルによって返された上位 k 個のドキュメントを再ランク付けするために、それらを使用または微調整することをお勧めします。bge-*-v1.5埋め込みモデルをリリースして、類似度分布の問題を軽減し、命令なしでの検索能力を強化します。bge-large-* (BAAI General Embedding の略) モデルをリリースし、 MTEB および C-MTEB ベンチマークで 1 位にランクされました。 ? ?モデルを微調整したくない場合は、finetune の依存関係なしでパッケージをインストールできます。

pip install -U FlagEmbedding

モデルを微調整したい場合は、finetune 依存関係を含むパッケージをインストールできます。

pip install -U FlagEmbedding[finetune]

リポジトリのクローンを作成してインストールする

git clone https://github.com/FlagOpen/FlagEmbedding.git

cd FlagEmbedding

# If you do not want to finetune the models, you can install the package without the finetune dependency:

pip install .

# If you want to finetune the models, you can install the package with the finetune dependency:

# pip install .[finetune]

編集可能モードでの開発の場合:

# If you do not want to finetune the models, you can install the package without the finetune dependency:

pip install -e .

# If you want to finetune the models, you can install the package with the finetune dependency:

# pip install -e .[finetune]

まず、BGE 埋め込みモデルの 1 つをロードします。

from FlagEmbedding import FlagAutoModel

model = FlagAutoModel.from_finetuned('BAAI/bge-base-en-v1.5',

query_instruction_for_retrieval="Represent this sentence for searching relevant passages:",

use_fp16=True)

次に、いくつかの文をモデルにフィードし、その埋め込みを取得します。

sentences_1 = ["I love NLP", "I love machine learning"]

sentences_2 = ["I love BGE", "I love text retrieval"]

embeddings_1 = model.encode(sentences_1)

embeddings_2 = model.encode(sentences_2)

埋め込みを取得したら、内積によって類似度を計算できます。

similarity = embeddings_1 @ embeddings_2.T

print(similarity)

詳細については、エンベッダー推論、リランカー推論、エンベッダー ファインチューン、リランカー フィンチューン、評価を参照してください。

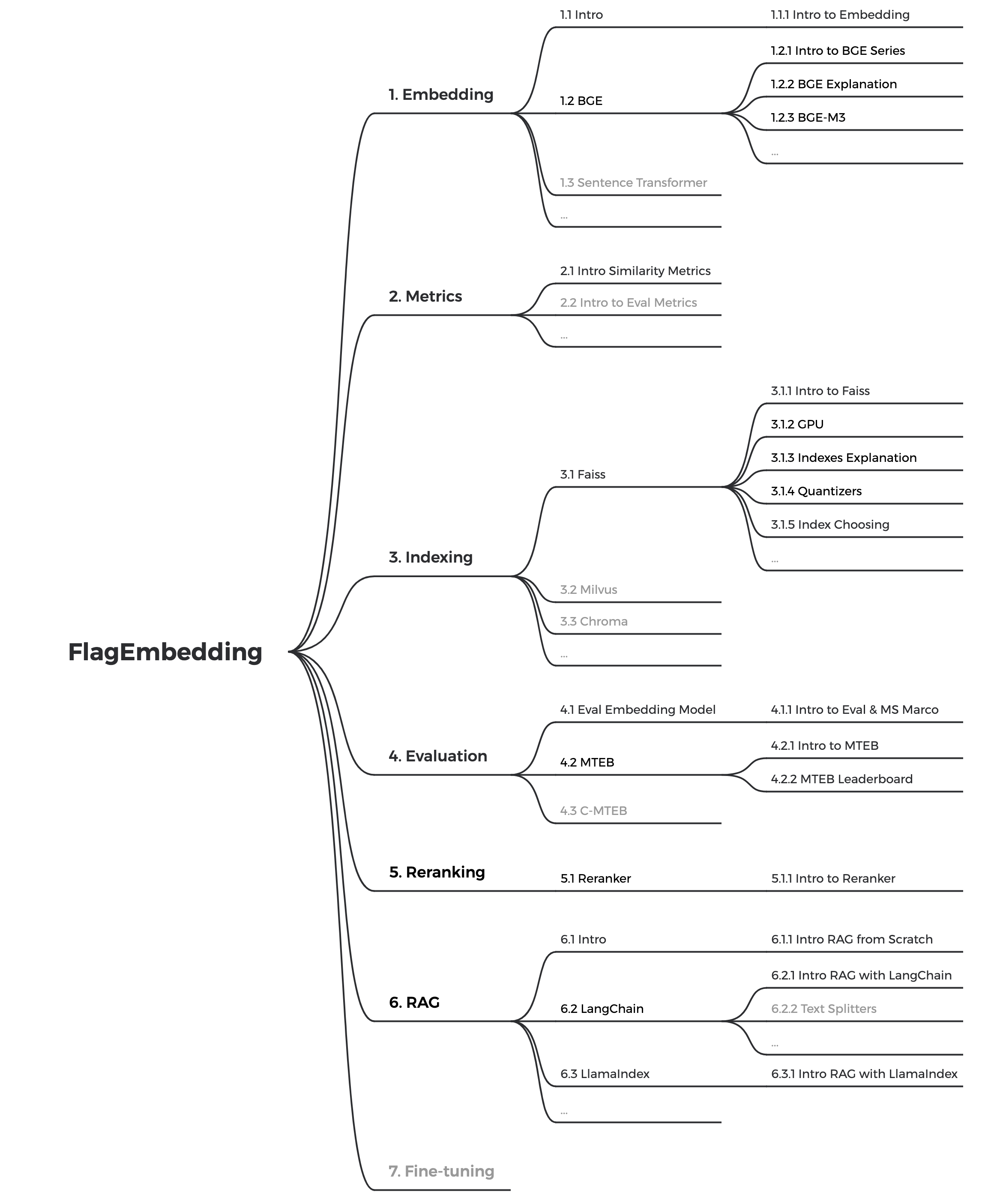

関連する概念に慣れていない場合は、チュートリアルを確認してください。存在しない場合はお知らせください。

BGE に関連するさらに興味深いトピックについては、研究をご覧ください。

私たちは BGE と FlagEmbedding のコミュニティを積極的に維持しています。ご提案やアイデアがありましたらお知らせください。

現在、チュートリアルを更新中です。テキスト検索と RAG に関する初心者向けの包括的で詳細なチュートリアルを作成することを目指しています。乞うご期待!

次のコンテンツは今後数週間以内にリリースされます。

bge BAAI general embeddingの略です。

| モデル | 言語 | 説明 | 検索用のクエリ命令 |

|---|---|---|---|

| BAAI/bge-en-icl | 英語 | コンテキスト内学習機能を備えた LLM ベースの埋め込みモデル。いくつかのショットの例に基づいてモデルの可能性を最大限に活用できます。 | 与えられたタスクに基づいて、指示と数ショットの例を自由に提供します。 |

| BAAI/bge-multilingual-gemma2 | 多言語対応 | さまざまな言語とタスクでトレーニングされた、LLM ベースの多言語埋め込みモデル。 | 与えられたタスクに基づいて指示を出します。 |

| BAAI/bge-m3 | 多言語対応 | 多機能性(密検索、疎検索、マルチベクトル(colbert))、多言語性、多粒度(8192トークン) | |

| LMカクテル | 英語 | LM-Cocktail の結果を再現するために使用できる微調整されたモデル (Llama および BGE) | |

| BAAI/llm-embedder | 英語 | LLM の多様な検索拡張ニーズをサポートする統合埋め込みモデル | READMEを参照 |

| BAAI/bge-reranker-v2-m3 | 多言語対応 | 軽量のクロスエンコーダー モデルで、強力な多言語機能を備え、展開が簡単で、推論が高速です。 | |

| BAAI/bge-reranker-v2-gemma | 多言語対応 | 多言語コンテキストに適したクロスエンコーダー モデルは、英語能力と多言語能力の両方で優れたパフォーマンスを発揮します。 | |

| BAAI/bge-reranker-v2-minicpm-layerwise | 多言語対応 | クロスエンコーダ モデルは多言語コンテキストに適しており、英語と中国語の両方の習熟度で良好に機能し、出力用のレイヤーを自由に選択できるため、推論の高速化が容易になります。 | |

| BAAI/bge-reranker-v2.5-gemma2-lightweight | 多言語対応 | クロスエンコーダー モデルは多言語コンテキストに適しており、英語と中国語の両方の習熟度で優れたパフォーマンスを発揮し、出力用のレイヤーの選択、圧縮率、およびレイヤーの圧縮を自由に行うことができるため、推論の高速化が容易になります。 | |

| BAAI/bge-reranker-large | 中国語と英語 | クロスエンコーダモデルは精度は高いが効率は低い | |

| BAAI/bge-reranker-base | 中国語と英語 | クロスエンコーダモデルは精度は高いが効率は低い | |

| BAAI/bge-large-en-v1.5 | 英語 | より合理的な類似度分布を備えたバージョン 1.5 | Represent this sentence for searching relevant passages: |

| BAAI/bge-base-en-v1.5 | 英語 | より合理的な類似度分布を備えたバージョン 1.5 | Represent this sentence for searching relevant passages: |

| BAAI/bge-small-en-v1.5 | 英語 | より合理的な類似度分布を備えたバージョン 1.5 | Represent this sentence for searching relevant passages: |

| BAAI/bge-large-zh-v1.5 | 中国語 | より合理的な類似度分布を備えたバージョン 1.5 | 为这个句子生成表示以用于检索相关文章: |

| BAAI/bge-base-zh-v1.5 | 中国語 | より合理的な類似度分布を備えたバージョン 1.5 | 为这个句子生成表示以用于检索相关文章: |

| BAAI/bge-small-zh-v1.5 | 中国語 | より合理的な類似度分布を備えたバージョン 1.5 | 为这个句子生成表示以用于检索相关文章: |

| BAAI/bge-large-en | 英語 | テキストをベクトルにマッピングする埋め込みモデル | Represent this sentence for searching relevant passages: |

| BAAI/bge-base-en | 英語 | 基本スケールのモデルですが、 bge-large-enと同様の機能を備えています | Represent this sentence for searching relevant passages: |

| BAAI/bge-small-en | 英語 | 小型モデルながら競争力のある性能 | Represent this sentence for searching relevant passages: |

| BAAI/bge-large-zh | 中国語 | テキストをベクトルにマッピングする埋め込みモデル | 为这个句子生成表示以用于检索相关文章: |

| BAAI/bge-base-zh | 中国語 | 基本スケールのモデルですが、 bge-large-zhと同様の機能を備えています | 为这个句子生成表示以用于检索相关文章: |

| BAAI/bge-small-zh | 中国語 | 小型モデルながら競争力のある性能 | 为这个句子生成表示以用于检索相关文章: |

すべての貢献者の尽力に感謝するとともに、新しいメンバーの参加を温かく歓迎します。

このリポジトリが役立つと思われる場合は、スターと引用を付けることを検討してください。

@misc{bge_m3,

title={BGE M3-Embedding: Multi-Lingual, Multi-Functionality, Multi-Granularity Text Embeddings Through Self-Knowledge Distillation},

author={Chen, Jianlv and Xiao, Shitao and Zhang, Peitian and Luo, Kun and Lian, Defu and Liu, Zheng},

year={2023},

eprint={2309.07597},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

@misc{cocktail,

title={LM-Cocktail: Resilient Tuning of Language Models via Model Merging},

author={Shitao Xiao and Zheng Liu and Peitian Zhang and Xingrun Xing},

year={2023},

eprint={2311.13534},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

@misc{llm_embedder,

title={Retrieve Anything To Augment Large Language Models},

author={Peitian Zhang and Shitao Xiao and Zheng Liu and Zhicheng Dou and Jian-Yun Nie},

year={2023},

eprint={2310.07554},

archivePrefix={arXiv},

primaryClass={cs.IR}

}

@misc{bge_embedding,

title={C-Pack: Packaged Resources To Advance General Chinese Embedding},

author={Shitao Xiao and Zheng Liu and Peitian Zhang and Niklas Muennighoff},

year={2023},

eprint={2309.07597},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

FlagEmbedding は MIT ライセンスに基づいてライセンスされています。