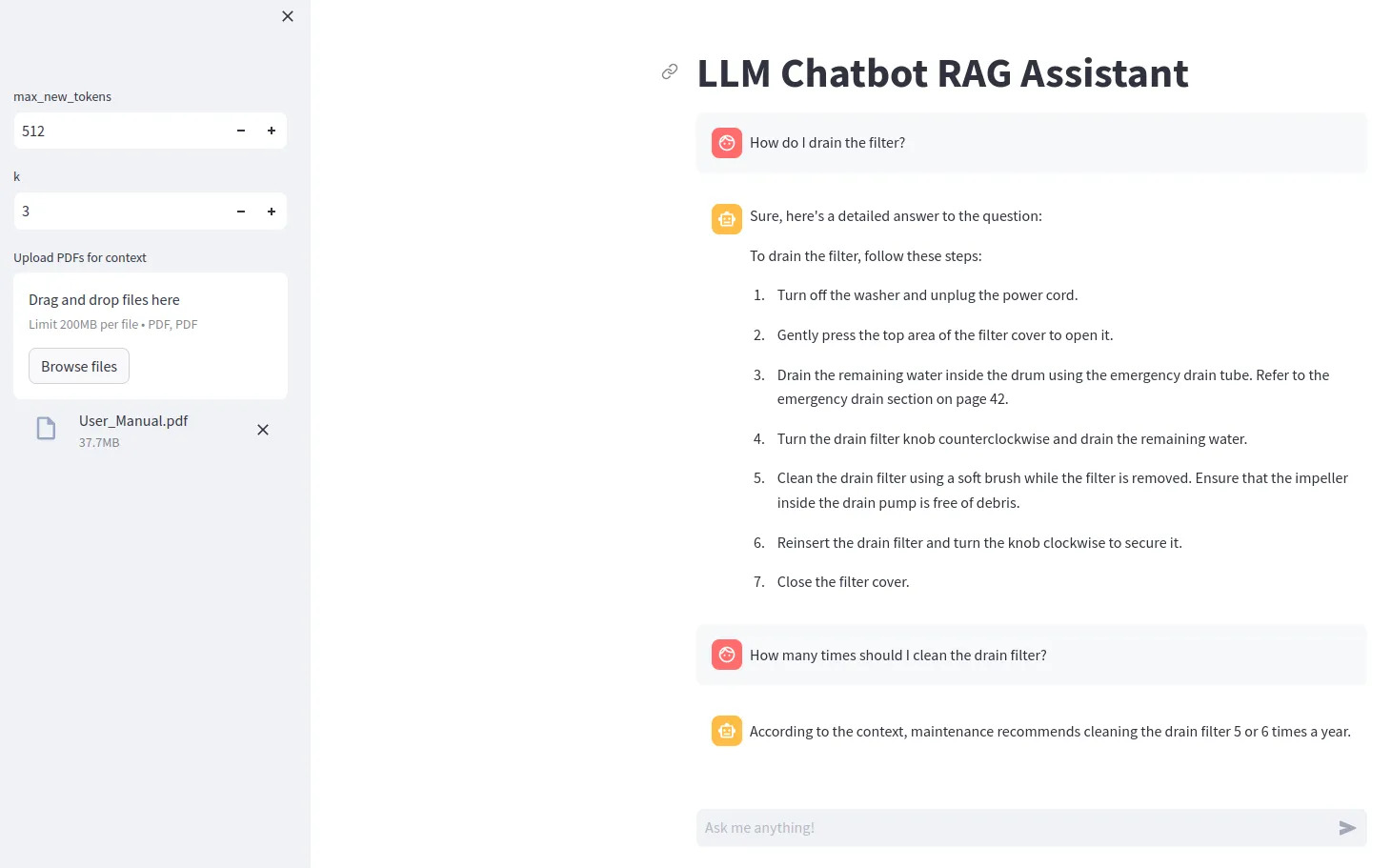

llm chatbot rag

1.0.0

特定の LLM モデル (Gemma など) を使用するには、 ACCESS_TOKEN=<your hugging face token>という行を含む .env ファイルを作成する必要があります。

pip install -r requirements.txtを使用して依存関係をインストールします。

streamlit run src/app.py

ビットサンドバイト量子化を使用するには、Nvidia GPU が必要です。必ず最初に NVIDIA Toolkit をインストールしてから、PyTorch をインストールしてください。

GPU が Python で利用可能かどうかを確認するには、次のようにします。

import torch

print(torch.cuda.is_available())

互換性のある GPU がない場合は、モデルにdevice="cpu"を設定し、量子化構成を削除してみてください。