Alfresco AI フレームワークは、 Java と Spring AI を活用して AI 機能を Alfresco に統合するように設計された堅牢なフレームワークです。 AI と機械学習モデルを使用して、Alfresco のドキュメント コンテンツを処理、分析、強化するための一連のツールとサービスを提供します。

注: 最終リリースはまだ利用できないため、このプロジェクトでは Spring AI SNAPSHOT バージョンを使用します。

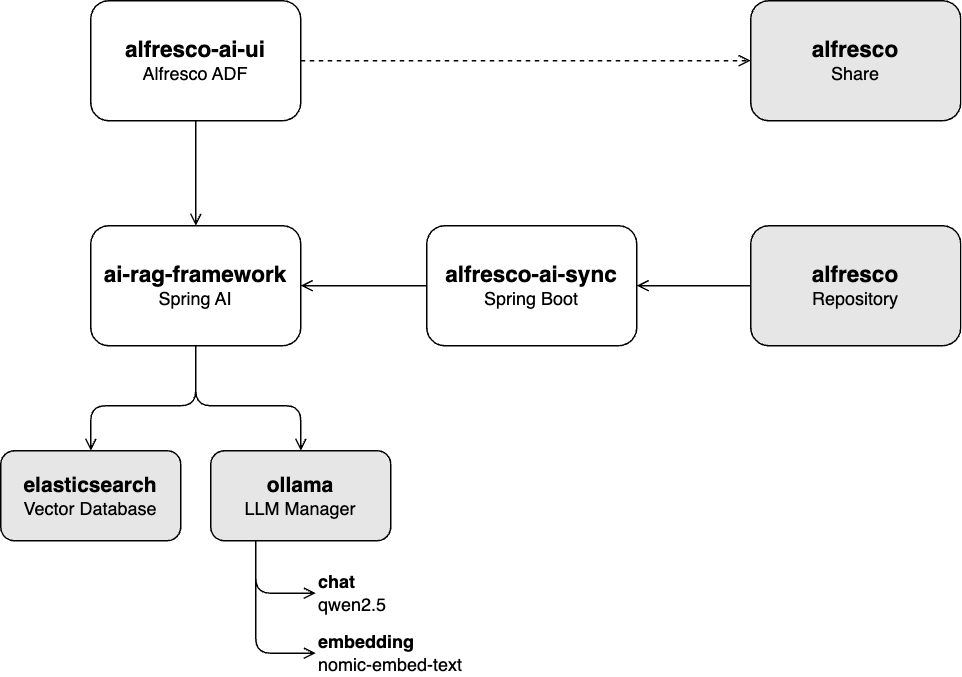

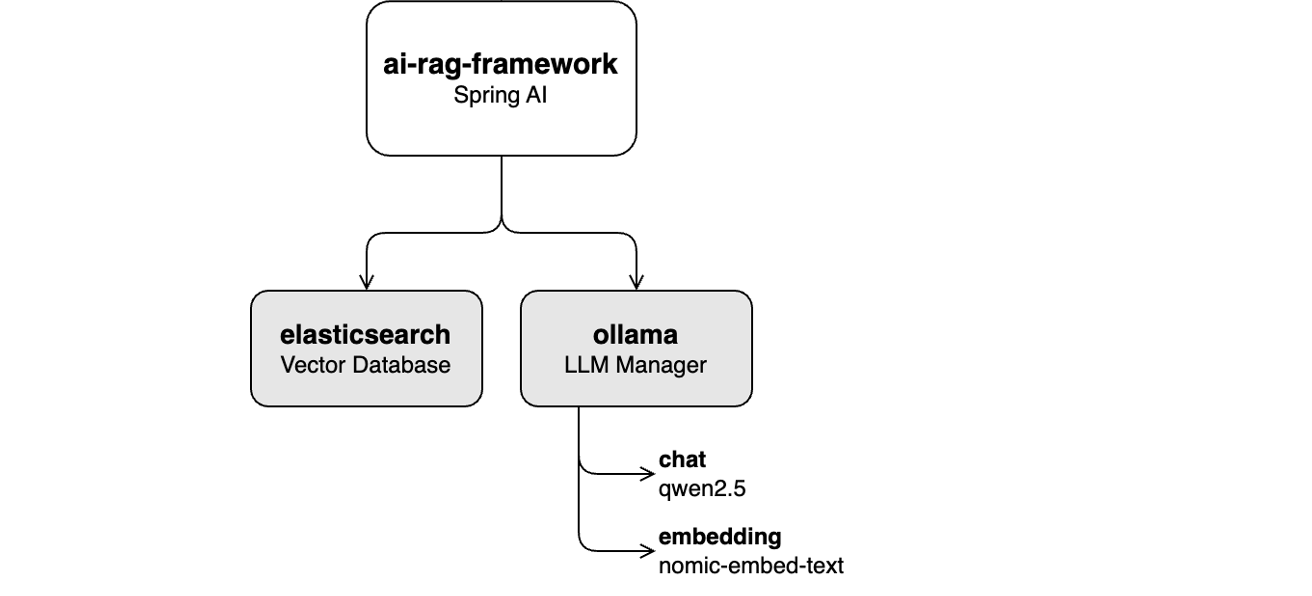

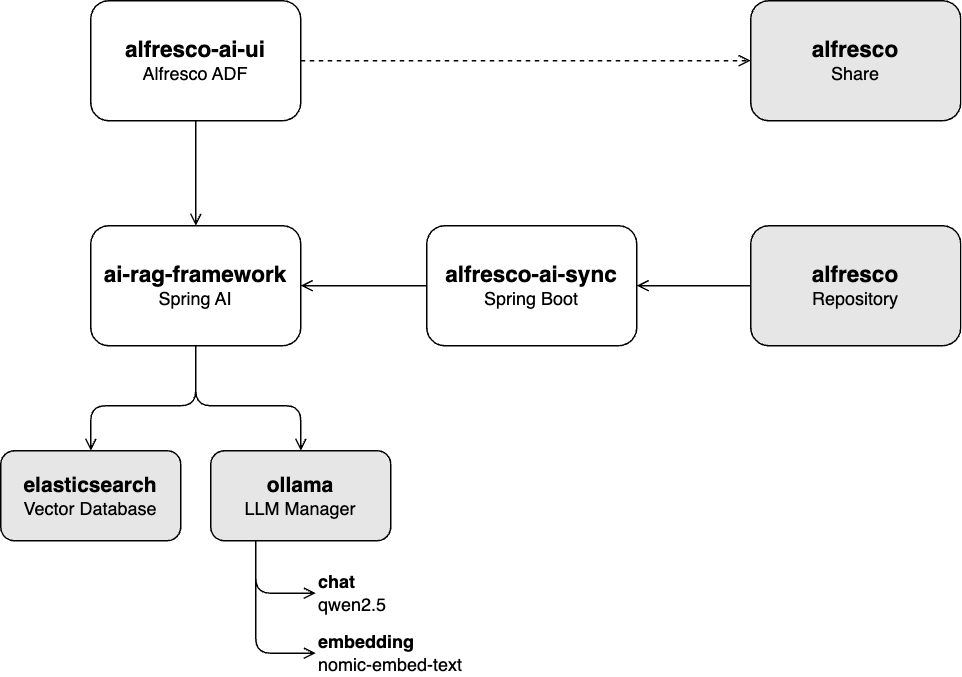

ai-rag-フレームワーク:

Spring AI 上に構築された REST API は、ドキュメントを Generative AI (GenAI) モデルに取り込み、検索拡張生成 (RAG) チャット サービスを提供します。

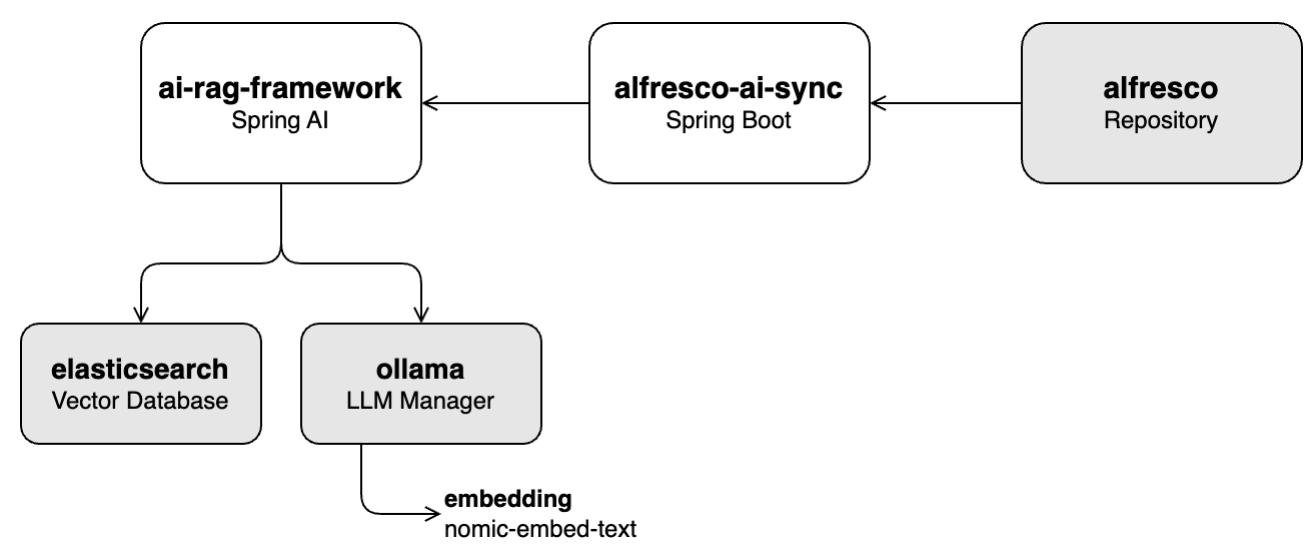

屋外AI同期:

Alfresco Java SDK 上に構築されたサービス。Alfresco リポジトリからドキュメントを取得し、 ai-rag-framework API を通じてベクター データベースに取り込みます。

ai-rag-frameworkサービス屋外アイウイ:

ai-rag-frameworkによって提供される RAG チャット サービスと対話するための、Alfresco ADF 上に構築されたユーザー インターフェイス。

ai-rag-frameworkサービスが実行されている必要がありますalfresco-docker : コンテナ指向の Alfresco Community 23.3 デプロイメント

この一連のチュートリアルでは、データの取り込み、チャットの統合、システム全体の操作など、プロジェクトの主要な機能について説明します。

このラボでは、Alfresco に保存されているナレッジ ベースから選択したコンテンツをVector データベース(Elasticsearch) に入力する方法を学習します。これには、Ollama 経由で埋め込みモジュールnomic-embed-text使用してコンテンツからベクトルを抽出することが含まれます。

「ラボ 1: インジェスト パイプライン」に従ってラボを開始します。

このラボでは、Share や ADF などの Alfresco UI アプリを使用して、Ollama 経由でLLM qwen2.5とのチャット機能を有効にすることに焦点を当てています。このプロセスには、Ollama 経由で埋め込みモジュールnomic-embed-text使用してユーザーのプロンプトをベクターに変換し、ベクター データベース(Elasticsearch) で関連するコンテンツを検索することが含まれます。取得されたテキストはLLMにコンテキストを提供するために使用され、より正確な応答を生成するのに役立ちます。

このラボは、「ラボ 2: チャット機能」に従って開始してください。

このラボでは、すべてのコンポーネント (取り込みおよびチャット機能) をライブ Alfresco リポジトリと統合します。リポジトリに変更があるとシステムがVector データベースを自動的に更新するため、手動介入の必要がなくなります。

このラボは、「ラボ 3: すべてのコンポーネントを一緒に実行する」に従って開始できます。

このプロジェクトは、Apache License 2.0 に基づいてライセンスされています。詳細については、LICENSE ファイルを参照してください。

コンテンツ管理と AI ドメインにおけるオープンソース イニシアティブへの継続的なサポートと貢献に、Alfresco チームと Hyland チームに特に感謝します。