Ruby で AI を活用したテキストと画像を生成するための Amazon Bedrock API とのシームレスな統合 ? + ?。 Amazon Bedrock API。

Amazon Bedrock は、主要な AI スタートアップ企業や Amazon の FM を API 経由で利用できるようにするフルマネージド サービスです。そのため、幅広い FM から選択して、ユースケースに最適なモデルを見つけることができます。

アプリケーションの Gemfile に次の行を追加します。

gem "ruby-amazon-bedrock" , "~> 0.2.4"そして、以下を実行します。

$ bundle installまたは次のようにインストールします。

$ gem install ruby-amazon-bedrock -v 0.2.4そして次のように要求します:

require "amazon_bedrock" Amazon Bedrock を使用するには、他の AWS サービスと同様に、安全な認証情報が必要です。 AWS IAM (Identity and Access Management) https://us-east-1.console.aws.amazon.com/iam からキーを取得します。

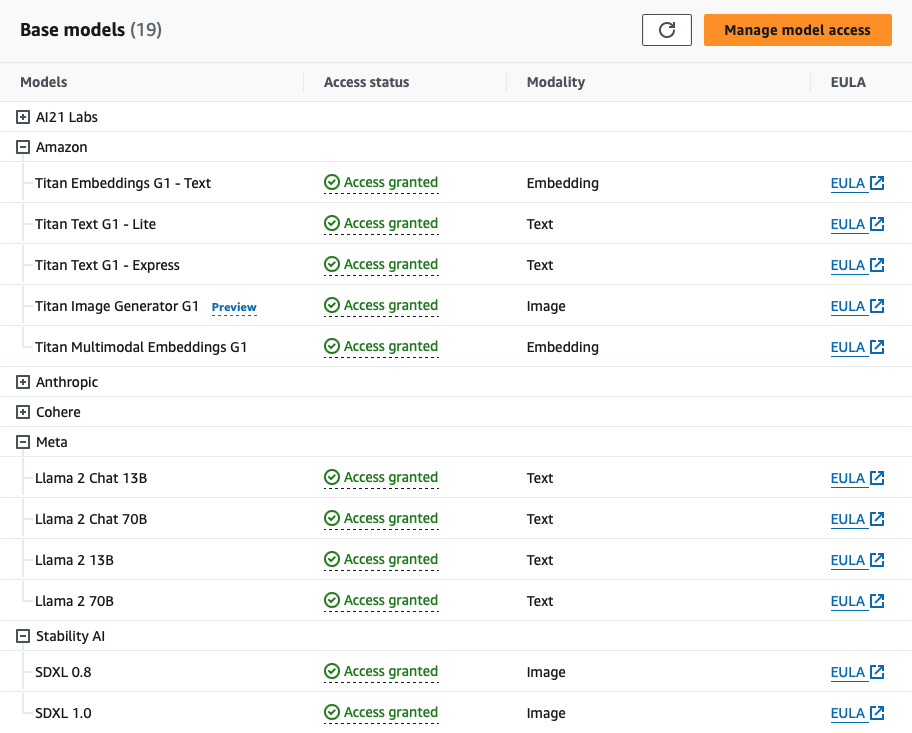

Bedrock を使用するには、Bedrock の FM へのアクセスをリクエストする必要があります。これを行うには、正しい IAM 権限が必要です。特定のモデルでは、アクセスをリクエストする前に、まずユースケースの詳細を送信する必要がある場合があります。

ruby-amazon-bedrock gem を Amazon Bedrock と組み合わせて使用すると、Amazon Bedrock サービスの使用に関連するコストが発生する可能性があることに注意してください。ユーザーは、Amazon Bedrock の使用によって生じるすべての費用に対して単独で責任を負います。価格の詳細については、こちらをご覧ください

AWS IAM 認証情報を渡してクライアントをインスタンス化します。

client = RubyAmazonBedrock :: Client . new (

region : "AWS_REGION" ,

access_key_id : "AWS_ACCESS_KEY_ID" ,

secret_access_key : "AWS_SECRET_ACCESS_KEY"

)または、アカウントの資格情報を含む.env.sample .envファイルにコピーし、 ENV変数を使用します。注: この手順はrspecを使用してテストを実行するために必要です。

client = RubyAmazonBedrock :: Client . new (

region : ENV [ "AWS_REGION" ] ,

access_key_id : ENV [ "AWS_ACCESS_KEY_ID" ] ,

secret_access_key : ENV [ "AWS_SECRET_ACCESS_KEY" ]

)profileキーワード引数を渡すことで、AWS 名前付きプロファイルを使用することもできます。名前付きプロファイルを使用する場合、 region 、 access_key_id 、およびaccess_token指定は必要ありません。

client = RubyAmazonBedrock :: Client . new (

profile : "AWS_PROFILE"

) options 引数は、追加のモデル固有の構成を許可することでメソッドの柔軟性を高めます。明示的に指定しない場合、メソッドはデフォルトで標準のモデル パラメーターのセットを使用します。モデルのオプションのパラメーターの詳細を確認できます。

Amazon Bedrock は、主要な AI スタートアップ企業や Amazon の FM を API 経由で利用できるようにするフルマネージド サービスです。そのため、幅広い FM から選択して、ユースケースに最適なモデルを見つけることができます。

企業は、AI21 の主要な LLM である Jurassic ファミリーを使用して、既存の組織データを活用した生成的な AI 主導のアプリケーションとサービスを構築します。 Jurassic は、長文および短文のテキスト生成、状況に応じた質問応答、要約、分類など、業界を超えたユースケースをサポートします。 Jurassic は自然言語の指示に従うように設計されており、Web テキストの膨大なコーパスでトレーニングされており、英語に加えて 6 つの言語をサポートしています。もっと見る ...

これらのモデルのオプションは次のとおりです。

{

temperature : 0.5 , # float

max_tokens : 200 , # integer

stop_sequences : [ ] , # [string]

top_p : 0.5 , # float

count_penalty : 0 , # integer

presence_penalty : 0 , # integer

frequency_penalty : 0 # integer

}パラメーターのデータ型と値に関する詳細なドキュメントについては、[詳細を参照...][https://docs.aws.amazon.com/bedrock/latest/userguide/model-parameters-jurassic2.html] を参照してください。

AI21 モデルの呼び出し方法:

ジュラシック-2 ウルトラ

サポート: オープンブックの質問への回答、要約、草稿の作成、情報の抽出、アイデアの作成

言語: 英語、スペイン語、フランス語、ドイツ語、ポルトガル語、イタリア語、オランダ語

client . invoke_model ( id : 'ai21.j2-ultra-v1' , prompt : "What's natural language processing?" , options : { } )

# Response

{ :id => 1234 ,

:prompt =>

{ :text => "Describe how an LLM works" ,

:tokens =>

[ { :generatedToken => { :token => "▁Describe" , :logprob => - 10.674324035644531 , :raw_logprob => - 10.674324035644531 } ,

:completions =>

[ { :data =>

{ :text =>

" n Natural language processing (NLP) is a field of computer science, artificial intelligence, and linguistics concerned with the interactions between computers and human (natural) languages, in particular how to program computers to process and analyze large amounts of natural language data. The goal of NLP is to provide computers with the ability to read, understand, and generate human language." ,

:tokens =>

[ { :generatedToken => { :token => "<|newline|>" , :logprob => 0.0 , :raw_logprob => - 0.00046850196667946875 } ,ジュラシック 2 ミッド

client . invoke_model ( id : 'ai21.j2-mid-v1' , prompt : "What's GenAI?" , options : { } )

# Response

{ :id => 1234 ,

:prompt =>

{ :text => "What's GenAI?" ,

:tokens =>

[ { :generatedToken => { :token => "▁What's" , :logprob => - 9.553738594055176 , :raw_logprob => - 9.553738594055176 } ,

:topTokens => nil ,

:textRange => { :start => 0 , :end => 6 } } ,

:completions =>

[ { :data =>

{ :text =>

" n GenAI is a proposed standard for a generic AI language, which would allow AI systems to communicate and reason with each other in a common language. The goal of GenAI is to create a universal language that can be used by all AI systems, regardless of their specific task or underlying architecture. This would make it easier for AI systems to work together and learn from each other, and it would also make it easier for humans to interact with and understand AI systems." ,

:tokens =>

[ { :generatedToken => { :token => "<|newline|>" , :logprob => 0.0 , :raw_logprob => - 0.0009662011871114373 } ,Amazon Titan Foundation モデルは大規模なデータセットで事前トレーニングされており、強力な汎用モデルになっています。これらをそのまま使用することも、大量のデータに注釈を付けることなく、特定のタスク向けに独自のデータを使用してモデルを微調整することによってカスタマイズすることもできます。もっと見る ...

これらのモデルのオプションは次のとおりです。

{

temperature : 0.5 , # float

top_p : 0.5 , # float

max_tokens : 512 , # integer

stop_sequences : [ ] # [string]

}パラメータのデータ型と値に関する詳細なドキュメントについては、[詳細を参照...][https://docs.aws.amazon.com/bedrock/latest/userguide/model-parameters-titan-text.html] を参照してください。

Amazon Titan テキストモデルを呼び出す方法:

Titan Text G1 - Lite

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=amazon.titan-text-lite-v1

サポート: テキスト生成、コード生成、リッチ テキスト形式、オーケストレーション (エージェント)、微調整。

client . invoke_model ( id : 'amazon.titan-text-lite-v1' , prompt : 'Generate a story about rubies and gems' , options : { } )

# Response

{ :inputTextTokenCount => 8 ,

:results =>

[ { :tokenCount => 294 ,

:outputText =>

" n Once upon a time, there was a king who was very fond of rubies and gems. He had a collection of the most beautiful rubies and gems ..." ,

:completionReason => "FINISH" } ] }タイタンテキスト G1 - エクスプレス

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=amazon.titan-text-express-v1

client . invoke_model ( id : 'amazon.titan-text-express-v1' , prompt : 'Generate a post about cats formatted with HTML tags' , options : { } )

# Response

{ :inputTextTokenCount => 9 ,

:results =>

[ { :tokenCount => 330 ,

:outputText =>

" n <h1>Cats</h1> n n Cats are small, furry, carnivorous mammals that are loved by many people around the world. They come in a variety of colors, shapes, and sizes, and have unique personalities that make them great companions. n n " ,

:completionReason => "FINISH" } ] }サポート: テキスト生成、コード生成、リッチ テキスト形式、オーケストレーション (エージェント)、微調整

Anthropic は、会話、要約、Q&A、ワークフロー自動化、コーディングなどを目的として構築された大規模言語モデルの Claude ファミリーを提供します。初期の顧客は、Claude は有害な出力を生成する可能性がはるかに低く、会話が容易で、より操作しやすいため、より少ない労力で目的の出力を得ることができると報告しています。クロードは、性格、口調、行動について指示することもできます。

これらのモデルのオプションは次のとおりです。

{

temperature : 0.3 , # float

top_p : 0.5 , # float

top_k : 0.5 , # float

max_tokens : 1000 , # integer

stop_sequences : [ ] # [string]

}パラメータのデータ型と値に関する詳細なドキュメントについては、[詳細を参照...][https://docs.aws.amazon.com/bedrock/latest/userguide/model-parameters-claude.html] を参照してください。

人間モデルを呼び出す方法:

クロードインスタント 1.2

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=anthropic.claude-instant-v1

サポート: 質問応答、情報抽出、PII の削除、コンテンツ生成、多肢選択分類、ロールプレイ、テキストの比較、要約、引用付きの文書 Q&A

client . invoke_model ( id : 'anthropic.claude-instant-v1' , prompt : 'What is a neural network?' )

# Response

{ :completion =>

" A neural network is a type of machine learning model inspired by the human brain. The key elements of neural networks are: n n - Neurons..."

: stop_reason = > "stop_sequence" ,

:stop => " n n Human:" }クロード 1.3

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=anthropic.claude-v1

サポート: 質問応答、情報抽出、PII の削除、コンテンツ生成、多肢選択分類、ロールプレイ、テキストの比較、要約、引用付きの文書 Q&A

client . invoke_model ( id : 'anthropic.claude-v1' , prompt : "You will be acting as a AI customer success agent for a company called Acme Dynamics." )

# Response

{ :completion =>

" Okay, thanks for providing the context. My name is Claude, I'm an AI assistant created by Anthropic to be helpful, harmless, and honest. How can I assist you as a customer success agent for Acme Dynamics today?" ,

:stop_reason => "stop_sequence" ,

:stop => " n n Human:" }クロード2

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=anthropic.claude-v2

サポート: 質問応答、情報抽出、PII の削除、コンテンツ生成、多肢選択分類、ロールプレイ、テキストの比較、要約、引用付きの文書 Q&A

client . invoke_model ( id : 'anthropic.claude-v2' , prompt : "I'm going to provide some text. I want to remove all person

ally identifying information from this text and replace it with XXX. It's very important that PII such as names, phone numbers,

and home and email addresses, get replaced with XXX." )

# Response

{ :completion =>

" Here is the text with personally identifying information replaced with XXX: n n XXX lives at XXX in the city of XXX. XXX can be reached at phone..." ,

:stop_reason => "stop_sequence" ,

:stop => " n n Human:" }Cohere モデルは、ビジネス ユースケース向けのテキスト生成モデルです。 Cohere モデルは、テキスト生成、要約、コピーライティング、対話、抽出、質問応答など、信頼性の高いビジネス アプリケーションをサポートするデータでトレーニングされています。

コマンド モデルのオプションは次のとおりです。

{

temperature : 0.3 , # float

top_p : 0.5 , # float

top_k : 0.5 , # float

max_tokens : 1000 , # integer

stop_sequences : [ ] , # [string]

num_generations : 2 , # integer

return_likelihoods : 'ALL' , # string

stream : true , # boolean

truncate : 'END' # srtring

}パラメータのデータ型と値に関する詳細なドキュメントについては、[詳細を参照...][https://docs.aws.amazon.com/bedrock/latest/userguide/model-parameters-cohere-command.html] を参照してください。

Cohereコマンド・モデルを呼び出す方法:

指示

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=cohere.command-text-v14

サポート: 要約、コピーライティング、対話、抽出、質問応答。

client . invoke_model ( id : 'cohere.command-text-v14' , prompt : 'Generate a twit about why Ruby on Rails is a great tool for building a startup. Write a few hashtags' )

# Response

{ :generations =>

[ { :finish_reason => "COMPLETE" ,

:id => "b82658a5-8f36-4a94-a1f1-7802aa418904" ,

:text =>

" Sure! Here's a tweet: n n Ruby on Rails is a powerful framework for building web applications. It is highly scalable, has robust community support, and is the perfect choice for startups looking to build fast and ship often. #RoR #RubyOnRails #Startup #Tech #Efficient n n What do you think?" } ] ,

:id => "d5d5149f-ea5a-47ae-ae37-8324882b06c7" ,

:prompt => "Generate a twit about why Ruby on Rails is a great tool for building a startup. Write a few hashtags:" }コマンドライト

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=cohere.command-light-text-v14

サポート: 要約、コピーライティング、対話、抽出、質問応答。

client . invoke_model ( id : 'cohere.command-light-text-v14' , prompt : 'Generate a facebook post about GenAI models available at Amazon Bedrock' )

# Response

{ :generations =>

[ { :finish_reason => "MAX_TOKENS" ,

:id => "b58eaa37-915e-4f26-b37c-6b4875516648" ,

:text =>

" Introducing the latest innovation at Amazon Bedrock - our state-of-the-art GenAI models! ? n n Our team has been working tirelessly to bring you the best in artificial intelligence, and we're excited to share the results with you. With our GenAI models, you can now: n n - Develop applications that can understand and respond to human language with incredible accuracy, thanks to our state-of-the-art Large Language Models (LLMs). n -" } ] ,

:id => "0d2f2c74-cae9-434b-b5d5-f44aaeb1a587" ,

:prompt => "Generate a facebook post about GenAI models available at Amazon Bedrock:" }埋め込みモデルのオプションは次のとおりです。

{

input_type : 'classification' , # string

truncate : 'END' # string

}パラメータのデータ型と値に関する詳細なドキュメントについては、[詳細を参照...][https://docs.aws.amazon.com/bedrock/latest/userguide/model-parameters-embed.html] を参照してください。

Cohere埋め込みモデルを呼び出す方法:

英語を埋め込む

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=cohere.embed-english-v3

サポート: セマンティック検索、検索拡張生成 (RAG)、分類、クラスタリング。

# WIP

# client.invoke_model(id: 'cohere.embed-english-v3', prompt: 'Your prompt goes here ...')多言語を埋め込む

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=cohere.embed-multilingual-v3

# WIP

# client.invoke_model(id: 'cohere.embed-multilingual-v3', prompt: 'Your prompt goes here ...')Meta は、大規模な言語モデルの力を解き放つことを目指しています。 Llama の最新バージョンは、あらゆる規模の個人、クリエイター、研究者、企業がアクセスできるようになり、責任を持ってアイデアを実験、革新、拡張できるようになりました。

これらのモデルのオプションは次のとおりです。

{

max_tokens : 128 , # integer

temperature : 0.9 , # float

top_p : 0.7 # float

}メタモデルを呼び出す方法:

ラマ 2 チャット 13B

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=meta.llama2-13b-chat-v1

サポート: Llama 2 は英語での商用および研究での使用を目的としています。微調整されたチャット モデルは、チャット ベースのアプリケーションを対象としています。

client . invoke_model ( id : 'meta.llama2-13b-chat-v1' , prompt : 'Generate an Instagram Post about the Metaverse' )

# Resopnse

{ :generation =>

" n n Hey #Instagram community! I'm super excited to share my latest discovery with you all - the #Metaverse! ? n n Have you heard of it? It's like a virtual world where you can be anyone and do anything! ? From exploring new planets to attending virtual concerts, the possibilities are endless! ? n n I've been spending some time in the #Metaverse lately, and let me tell you, it's a game changer! Not only is it a ton of fun, but it's also a great way to connect with people from all over the world. ? n n I've made some amazing friends in the #Metaverse, and we've had some incredible adventures together! ?? n n So, what are you waiting for? Come join me in the #Metaverse and let's explore this amazing virtual world together! ? n n #Metaverse #VirtualReality #VR #Gaming #Adventure #Fun #Community #Friends #Instagram #SocialMedia" ,

:prompt_token_count => 11 ,

:generation_token_count => 275 ,

:stop_reason => "stop" }ラマ 2 チャット 70B

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=meta.llama2-70b-chat-v1

サポート: Llama 2 は英語での商用および研究での使用を目的としています。微調整されたチャット モデルは、チャット ベースのアプリケーションを対象としています。

client . invoke_model ( id : 'meta.llama2-70b-chat-v1' , prompt : 'Generate a Facebook add to promote a new website that is selling Ruby on Rails and AI courses' )

# Response

{ :generation =>

". n n The ad should be targeted at people who are interested in learning Ruby on Rails and AI, and should highlight the benefits of taking the courses on the website. n n Here is a sample ad that could be used to promote the website: n n Headline: Unlock Your Potential with Ruby on Rails and AI Courses n n Body: Are you interested in learning Ruby on Rails and AI? Look no further! Our website offers a range of courses that will teach you everything you need to know to get started with these exciting technologies. n n Our Ruby on Rails courses will show you how to build powerful web applications using the popular framework, while our AI courses will teach you the fundamentals of machine learning and deep learning. ..." ,

:prompt_token_count => 22 ,

:generation_token_count => 512 ,

:stop_reason => "length" }Stability AI は、世界をリードするオープンソースの生成人工知能企業であり、公共部門および民間部門のパートナーと協力して、次世代インフラストラクチャを世界中のユーザーに提供しています。

これらのモデルのオプションは次のとおりです。

{

cfg_scale : 20 , # integer

seed : 1 , # integer

steps : 10 # integer

}安定性 AI モデルを呼び出す方法:

SDXL0.8

https://us-east-1.console.aws.amazon.com/bedrock/home?region=us-east-1#/providers?model=stability.stable-diffusion-xl-v0

サポート: 画像生成、画像編集

client . invoke_model ( id : 'stability.stable-diffusion-xl-v0' , prompt : 'Generate an image of an orca jumping out of the water' , options : { file_path : 'path/to/your/image.jpg' } )

# NOTE: If file_path is not provided the image will be saved at 'image.jpg'

# Success Response

{

result : :success ,

file_path : 'path/to/your/image.jpg'

}

# Failure Response

{

result : :failure ,

error : ErrorClass

}生成された画像の例

SDXL1.0

client . invoke_model ( id : 'stability.stable-diffusion-xl-v1' , prompt : 'Generate an image of a white gold ring with a ruby on it' , options : { file_path : 'path/to/your/image.jpg' } )

# NOTE: If file_path is not provided the image will be saved at 'image.jpg'

# Success Response

{

result : :success ,

file_path : 'path/to/your/image.jpg'

}

# Failure Response

{

result : :failure ,

error : ErrorClass

}生成された画像の例