Cloudgrep はクラウド ストレージを検索します。

現在、AWS S3、Azure Storage、または Google Cloud Storage で、オプションで gzip (.gz) または zip (.zip) で圧縮されたログ ファイルの検索をサポートしています。

簡単な例:

./cloudgrep --bucket test-s3-access-logs --query 9RXXKPREHHTFQD77

python3 cloudgrep.py -b test-s3-access-logs -q 9RXXKPREHHTFQD77

単純な Azure の例:

python3 cloudgrep.py -an some_account -cn some_container -q my_search

簡単な Google の例:

python3 cloudgrep.py -gb my-gcp-bucket -q my_search

結果を JSON として出力する単純な CloudTrail ログの例:

python3 cloudgrep.py -b test-s3-access-logs -q 9RXXKPREHHTFQD77 -lt cloudtrail -jo

簡単なカスタム ログの例:

python3 cloudgrep.py -b test-s3-access-logs -q 9RXXKPREHHTFQD77 -lf json -lp Records

より複雑な例:

python3 cloudgrep.py -b test-s3-access-logs --prefix "logs/" --filename ".log" -q 9RXXKPREHHTFQD77 -s "2023-01-09 20:30:00" -e "2023-01-09 20:45:00" --file_size 10000 --debug

出力をファイルに保存します。

python3 cloudgrep.py -b test-s3-access-logs -q 9RXXKPREHHTFQD77 --hide_filenames > matching_events.log

出力例:

[2023-11-30 13:37:12,416] - Bucket is in region: us-east-2 : Search from the same region to avoid egress charges.

[2023-11-30 13:37:12,417] - Searching 11 files in test-s3-access-logs for 9RXXKPREHHTFQD77...

{"key_name": "access2023-01-09-20-34-20-EAC533CB93B4ACBE", "line": "abbd82b5ad5dc5d024cd1841d19c0cf2fd7472c47a1501ececde37fe91adc510 bucket-72561-s3bucketalt-1my9piwesfim7 [09/Jan/2023:19:20:00 +0000] 1.125.222.333 arn:aws:sts::000011110470:assumed-role/bucket-72561-myResponseRole-1WP2IOKDV7B4Y/1673265251.340187 9RXXKPREHHTFQD77 REST.GET.BUCKET - "GET /?list-type=2&prefix=-collector%2Fproject-&start-after=&encoding-type=url HTTP/1.1" 200 - 946 - 33 32 "-" "Boto3/1.21.24 Python/3.9.2 Linux/5.10.0-10-cloud-amd64 Botocore/1.24.46" - aNPuHKw== SigV4 ECDHE-RSA-AES128-GCM-SHA256 AuthHeader bucket-72561-s3bucketalt-1my9piwesfim7.s3.us-east-2.amazonaws.com TLSv1.2 - -"}

usage: cloudgrep.py [-h] [-b BUCKET] [-an ACCOUNT_NAME] [-cn CONTAINER_NAME] [-gb GOOGLE_BUCKET] [-q QUERY]

[-v FILE] [-y YARA] [-p PREFIX] [-f FILENAME] [-s START_DATE] [-e END_DATE]

[-fs FILE_SIZE] [-pr PROFILE] [-d] [-hf] [-lt LOG_TYPE] [-lf LOG_FORMAT]

[-lp LOG_PROPERTIES] [-jo JSON_OUTPUT]

CloudGrep searches is grep for cloud storage like S3 and Azure Storage. Version: 1.0.5

options:

-h, --help show this help message and exit

-b BUCKET, --bucket BUCKET

AWS S3 Bucket to search. E.g. my-bucket

-an ACCOUNT_NAME, --account-name ACCOUNT_NAME

Azure Account Name to Search

-cn CONTAINER_NAME, --container-name CONTAINER_NAME

Azure Container Name to Search

-gb GOOGLE_BUCKET, --google-bucket GOOGLE_BUCKET

Google Cloud Bucket to Search

-q QUERY, --query QUERY

Text to search for. Will be parsed as a Regex. E.g. example.com

-v FILE, --file FILE File containing a list of words or regular expressions to search for. One per line.

-y YARA, --yara YARA File containing Yara rules to scan files.

-p PREFIX, --prefix PREFIX

Optionally filter on the start of the Object name. E.g. logs/

-f FILENAME, --filename FILENAME

Optionally filter on Objects that match a keyword. E.g. .log.gz

-s START_DATE, --start_date START_DATE

Optionally filter on Objects modified after a Date or Time. E.g. 2022-01-01

-e END_DATE, --end_date END_DATE

Optionally filter on Objects modified before a Date or Time. E.g. 2022-01-01

-fs FILE_SIZE, --file_size FILE_SIZE

Optionally filter on Objects smaller than a file size, in bytes. Defaults to 100 Mb.

-pr PROFILE, --profile PROFILE

Set an AWS profile to use. E.g. default, dev, prod.

-d, --debug Enable Debug logging.

-hf, --hide_filenames

Dont show matching filenames.

-lt LOG_TYPE, --log_type LOG_TYPE

Return individual matching log entries based on pre-defined log types, otherwise

custom log_format and log_properties can be used. E.g. cloudtrail.

-lf LOG_FORMAT, --log_format LOG_FORMAT

Define custom log format of raw file to parse before applying search logic. Used if

--log_type is not defined. E.g. json.

-lp LOG_PROPERTIES, --log_properties LOG_PROPERTIES

Define custom list of properties to traverse to dynamically extract final list of log

records. Used if --log_type is not defined. E.g. [Records].

-jo JSON_OUTPUT, --json_output JSON_OUTPUT

Output as JSON.

次のコマンドでインストールします: pip3 install -r requirements.txtまたは、ここから最新のコンパイル済みリリースをダウンロードします

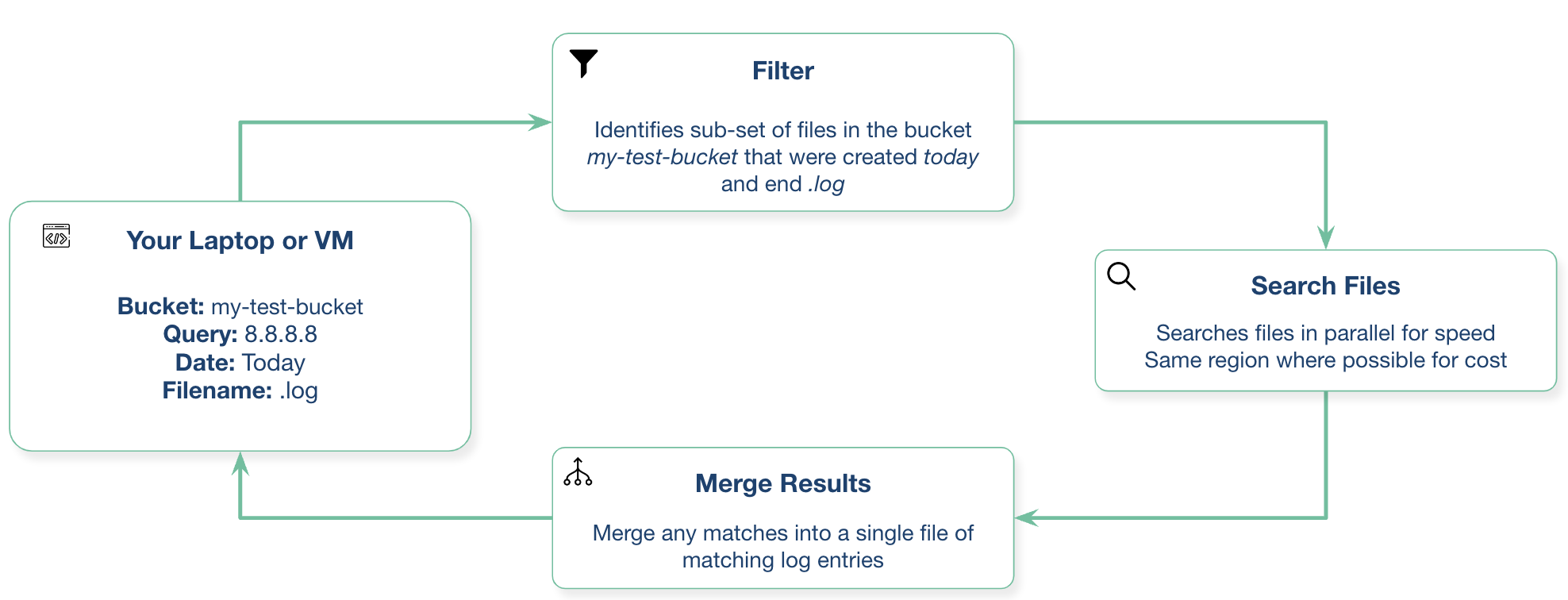

これは、ローカルのラップトップから、またはクラウド プロバイダーの仮想マシンから実行できます。

これにはPython3.10以降が必要です

docker build -t cloudgrep .

実行方法: docker run --rm -ti cloudgrep

環境変数を渡すには、たとえば AWS の場合: docker run --rm --env-file <(env|grep AWS) -ti cloudgrep

システムは S3 バケットにアクセスする必要があります。たとえば、ラップトップで実行している場合は、AWS CLI を設定する必要があります。 EC2 上で実行している場合は、おそらくインスタンス プロファイルが最良の選択です。

S3 の VPC エンドポイントを備えた S3 バケットと同じリージョン内の EC2 インスタンスで実行すると、下り料金を回避できます。さまざまな方法で認証できます。

Azure で認証する最も簡単な方法は、最初に以下を実行することです。

az login

これにより、ブラウザー ウィンドウが開き、Azure へのログインを求められます。

サービス アカウントを作成し、認証情報ファイルをダウンロードして、次のように設定する必要があります。

export GOOGLE_APPLICATION_CREDENTIALS="/Users/creds.json"

このプロジェクトへの貢献を歓迎します。プルリクエスト経由で追加してください。

将来的には次のような取り組みが考えられます。

質問や提案がある場合は、GitHub の問題を開いてください。これは正式にサポートされている Cado Security 製品ではありません。