Ollama 用のモダンで使いやすいクライアント。すべてをローカル ネットワーク内でプライベートに保ちながら、最高のエクスペリエンスをお楽しみください。

|  |  |  |

|---|

重要

このアプリはデバイス上で Ollama サーバーをホストせず、API エンドポイントを使用して Ollama サーバーに接続します。オラマって知らないの?詳細については、ollam.com をご覧ください。

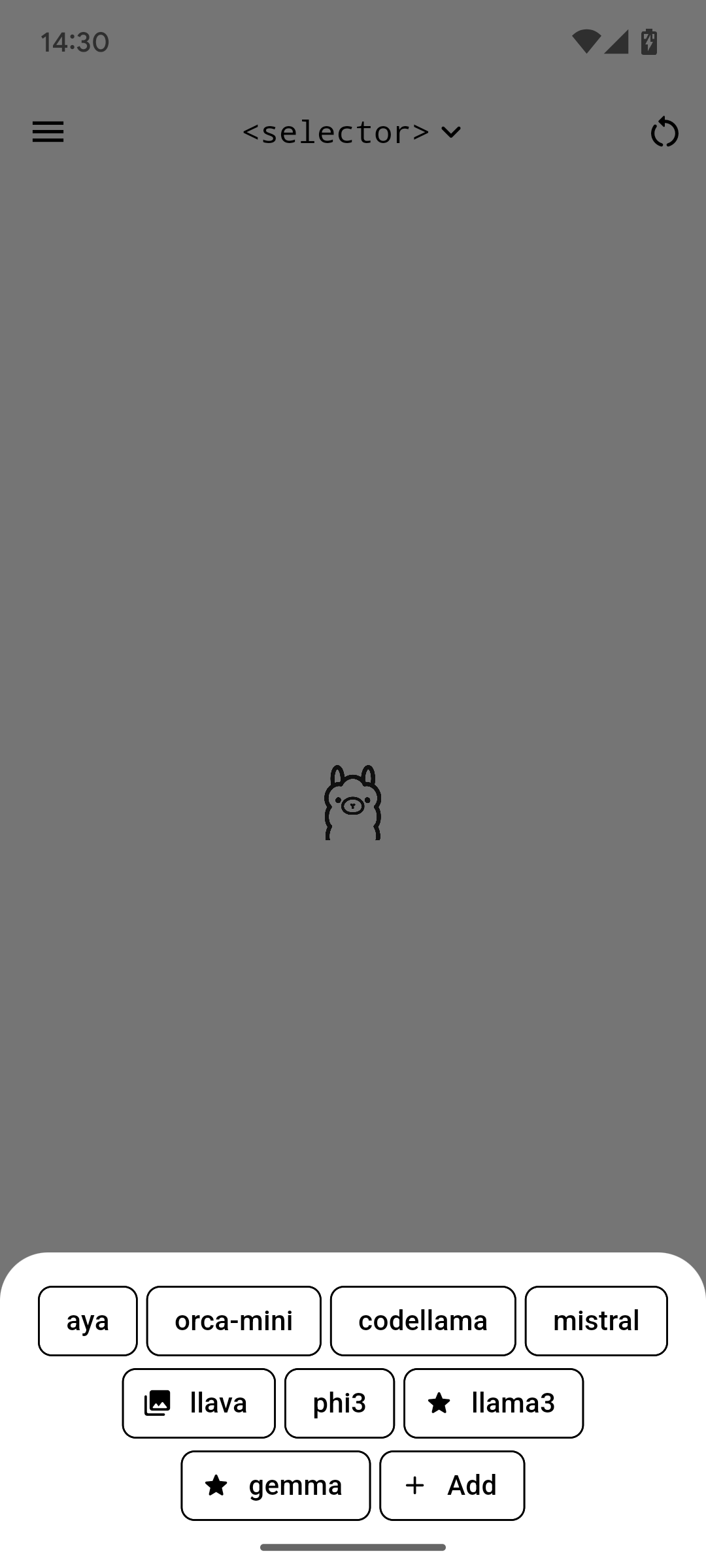

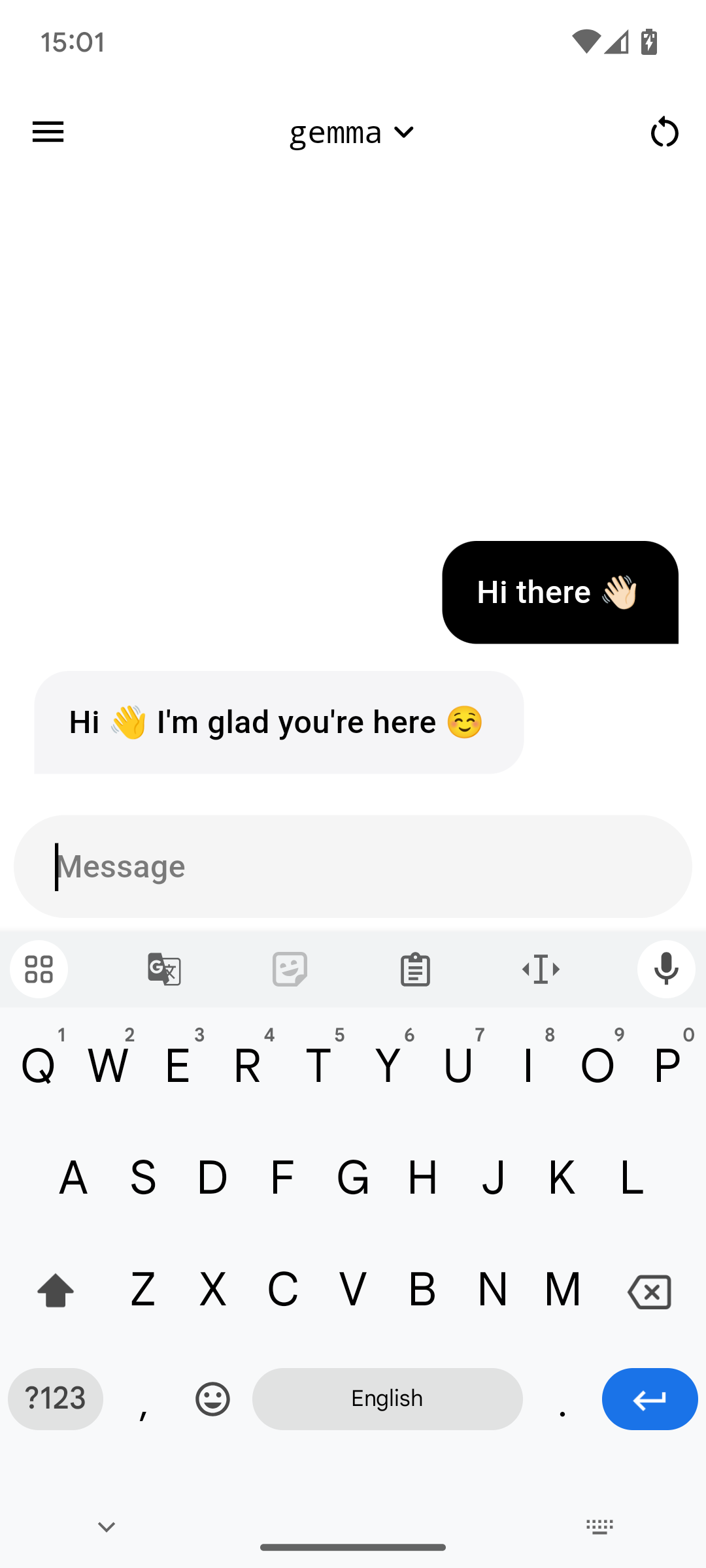

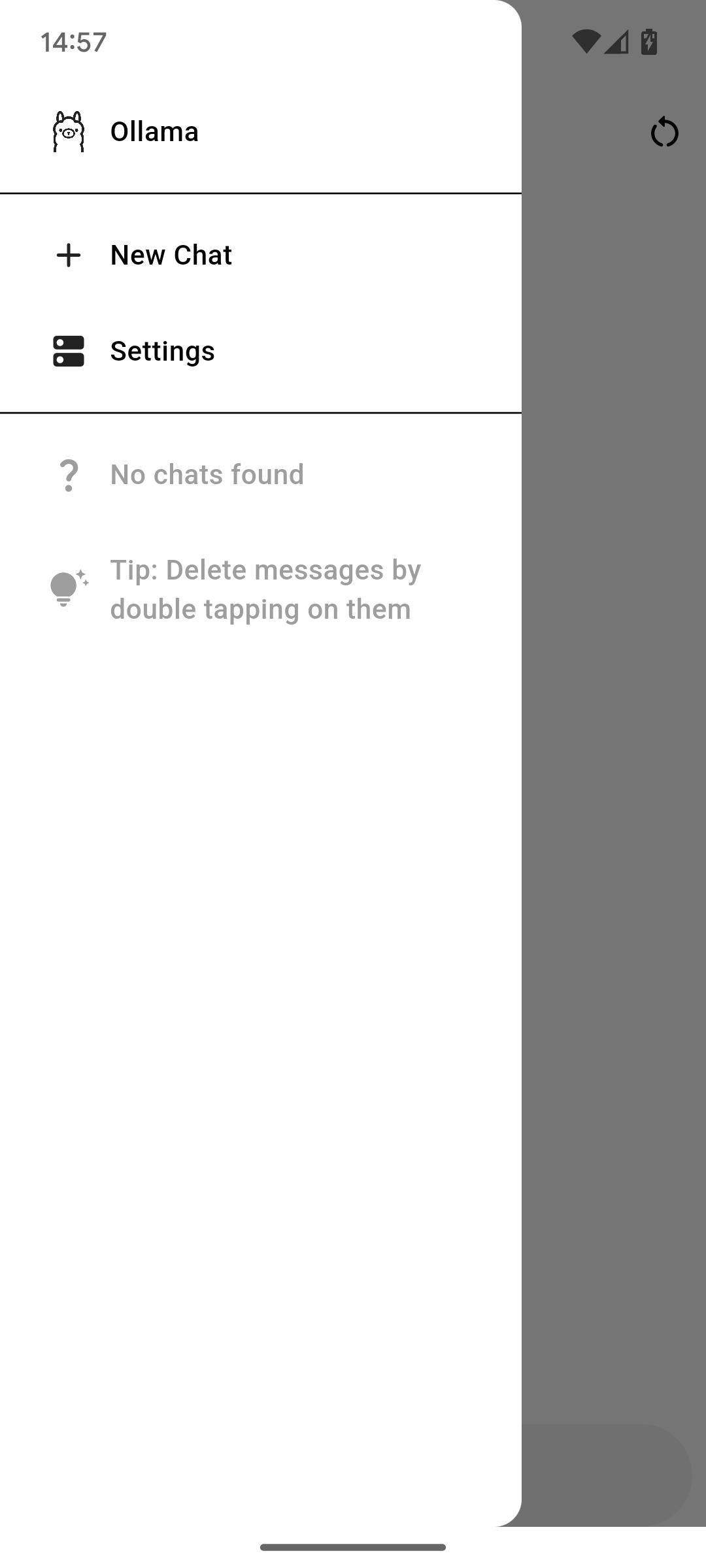

ollama app可能な限りオープンであるため、非常にシンプルで直感的なインターフェイスを備えています。すべては箱から出してすぐに機能するので、次の手順に従うだけです。

ollama appの最新の推奨バージョンは、[リリース] タブにあります。正しい実行可能ファイルをデバイスにダウンロードしてインストールします。デスクトップ プラットフォームにインストールする場合は、デスクトップ用ollama appで以下にリストされている手順に従う必要がある場合もあります。

または、次のストアのいずれかからアプリをダウンロードすることもできます。

これで、 ollama appが正常にインストールされました。ここで、初期セットアップに進むか、以下のセットアップに進みます。

警告

これはまだ実験的な機能です。一部の機能が意図したとおりに動作しない場合があります。エラーが発生した場合は、新しい問題レポートを作成してください。

実験的なデスクトップ サポートを使用する予定がある場合は、留意する必要があることがいくつかあります。

Windows バージョンはインストーラーの形式で提供されており、最新リリースに添付されています。署名されていないため、[さらに表示] > [とにかく実行] を押して Windows Defender 画面を閉じる必要がある場合があります。

Windows アプリ データは、 C:Users[user]AppDataRoamingJHubi1 ollama appに保存されます。

Linux バージョンはポータブルな実行可能ファイルの形式で提供されており、最新リリースに添付されています。起動するには、解凍したフォルダーで./ollamaを実行します。

アプリの起動時に、 error while loading shared libraries: libgtk-3.so.0: cannot open shared object fileのようなメッセージが表示された場合は、次のコマンドを実行します。

sudo apt-get updatesudo apt-get upgradesudo apt-get install packagekit-gtk3-module Linux アプリのデータは/home/[user]/.local/share/ollamaに保存されます。

最も難しい部分はホストのセットアップです。詳細については、その方法に関する wiki ガイドを参照してください。設定後は、通常は再度入力する必要はありません。

これで完了です。ローカル AI とチャットを開始して楽しんでください。

ヒント

新しい音声モードが実験的機能として利用可能になりました。詳細については、ドキュメントをご覧ください。

コンポーネント、設定、機能などのドキュメントは、このリポジトリの Wiki ページに移動されました。そこにある手順は将来のバージョンで更新される予定です。まだご質問がありますか?気軽に問題を開いてください。

このプロジェクトをさらに良くするのに協力してくれませんか?素晴らしいですね、いつも助けていただけるとありがたいです。

ollama app 、単一のコードベースを複数のターゲット プラットフォームで実行できるように設計された最新で堅牢なフロントエンド フレームワークである Flutter を使用して作成されます。フレームワーク自体は Dart プログラミング言語に基づいています。

詳細については、貢献ガイドをご覧ください。