セットアップなしで、コンピューター上でローカルに生成言語モデルを使用してチャットできます。 LocalChat は、llama.cpp 上に構築された、シンプルでセットアップが簡単なオープンソースのローカル AI チャットです。技術的な知識は必要なく、ユーザーは自分のマシン上で ChatGPT のような動作を体験できます。完全に GDPR に準拠しており、誤って情報が漏洩する心配もありません。 macOS、Windows、または Linux 用の LocalChat をここからダウンロードします。

目次

概要 |理論的根拠 |システム要件 |クイックスタート |ドキュメント

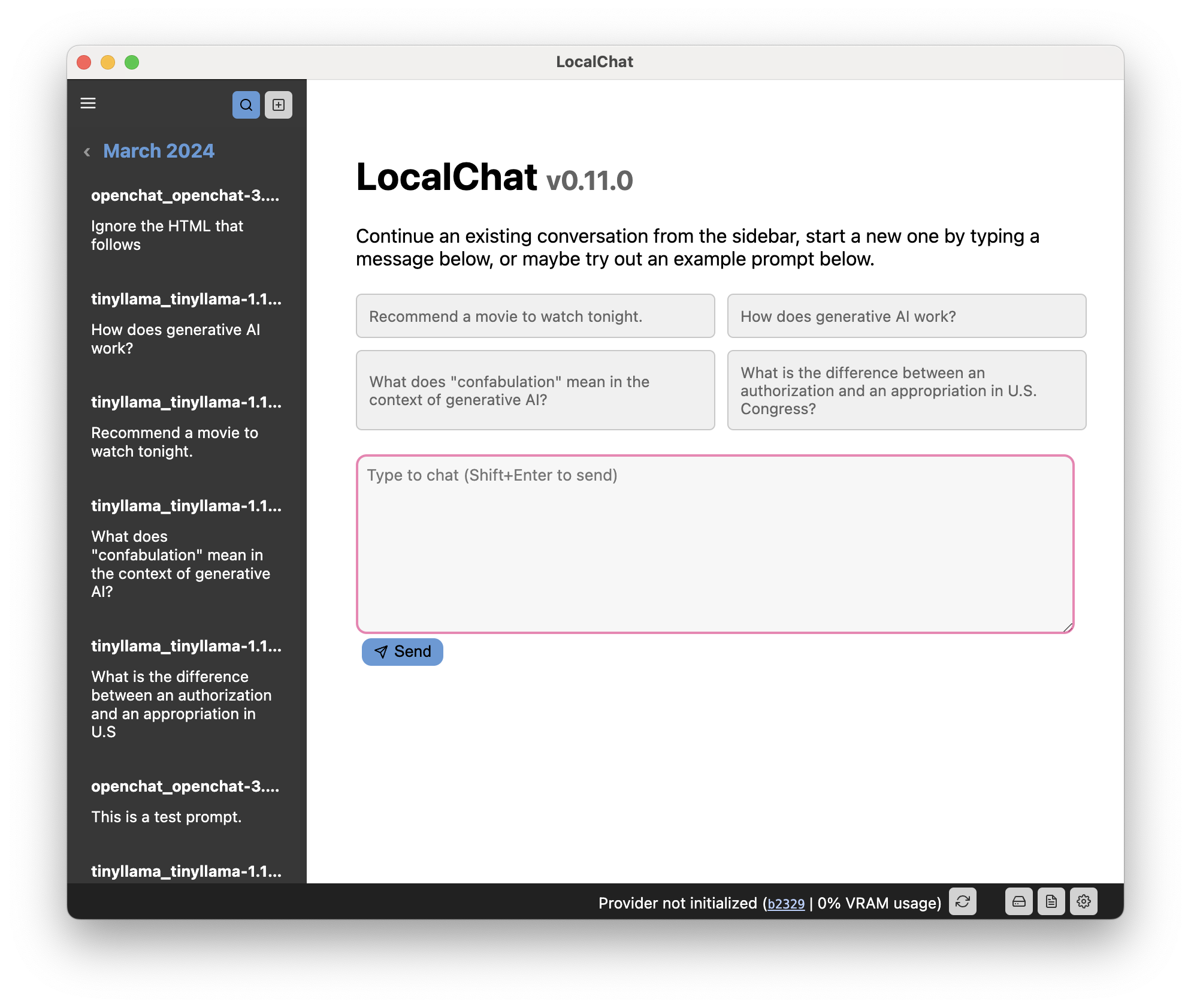

LocalChat は、生成大規模言語モデル (LLM)と対話するためのチャットのようなインターフェイスを提供します。見た目も操作感もチャット会話と同じですが、コンピュータ上でローカルに行われます。データがクラウド サーバーに送信されることはありません。

ChatGPT にほぼ似た外観と操作性を備えた、非常に有能な生成言語モデルがすでにいくつかあります。主な違いは、これらのモデルはローカルで実行され、無差別重量であることです。

重要

おそらくすでにご存知のとおり、LLM とのチャットは非常に自然に感じられるかもしれませんが、モデルは依然として確率的です。つまり、プロンプト内の他の内容に基づいて、次に考えられる単語が生成されます。 LLM には、時間、因果関係、文脈、そして言語学者が語用論と呼ぶものの感覚がありません。したがって、彼らは決して起こらなかった出来事をでっち上げたり、まったく異なる出来事の事実を混同したり、真っ向から嘘をつく傾向があります(「幻覚」として知られています)。これらのモデルが出力できるコードや計算にも同じことが当てはまります。このように言われています:

このモデルは注意してご自身の責任で使用してください。それはおもちゃであり、信頼できるものではないことに注意してください。

ChatGPT が 2022 年 11 月にローンチされたとき、私は非常に興奮しましたが、同時に慎重でもありました。私は GPT-3 の機能に非常に感銘を受けましたが、このモデルは独自のものであり、たとえそうでなかったとしてもローカルで実行することは不可能であるという事実を痛感していました。プライバシーを意識するヨーロッパ国民として、私は、いつでもアクセスを遮断できる数十億ドル規模の企業に依存するという考えが好きではありません。

このため、私は GPT を実際に試すことができず、避けられない、より小型で優れたツールの開発を待つことにしました。今では、すべての条件を満たすモデルがいくつかあります。それらはローカルで実行され、 ChatGPT のように感じられます。量子化 (基本的に解像度が低下し、ある程度の品質が低下します) を使用すると、古いハードウェアでも実行できます。

ただし、LLM の経験がない場合、LLM を実行するのは困難です。

このアプリが存在する理由は、(a) これを自分で実装して人間工学的にどのように機能するかを確認したかったこと、および (b) PyTorch のセットアップを気にせずにこれらのものを操作するための非常に単純なレイヤーを提供したかったことです。現地ではトランスフォーマー。

アプリをインストールし、モデルをダウンロードするだけで、すぐに使用できます。

このアプリを実行するには、ある程度新しいコンピューターが必要です。ただし、このアプリは電力を大量に消費することで有名な LLM に依存しています。したがって、コンピュータのハードウェアによって、実行できるモデルが決まります。

「通常」サイズのモデルでは、1 ワードあたり 1 秒以上待つ場合を除き、6 ~ 18 GB のビデオ メモリを備えた専用のグラフィック カードが必要になる可能性があります。

現在、多くのモデルは量子化された形式で提供されているため、古いハードウェアや性能の低いハードウェアでも大きなモデルを利用できます。量子化により、大きすぎるモデルであっても、品質をあまり損なうことなく、システム要件が大幅に削減されることがあります (ただし、メリットはモデルによって異なる場合があります)。

重要

大規模な言語モデルであるため、応答の生成には少し時間がかかります。したがって、特にコンピューターに専用の GPU がない場合は、しばらくお待ちいただくか、より小さいモデルを試してください。

ヒント

完全なドキュメントはアプリの Web サイトでご覧いただけます。

ユーザー インターフェイスは、次の 3 つの主要なコンポーネントに分かれています。

このコードは GNU GPL 3.0 を通じてライセンスされています。詳細については、LICENSE ファイルを参照してください。