優れた監査アルゴリズム

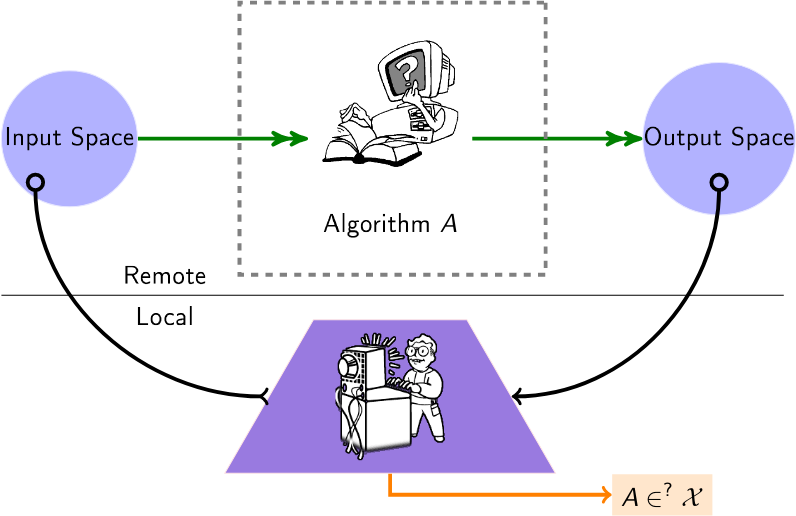

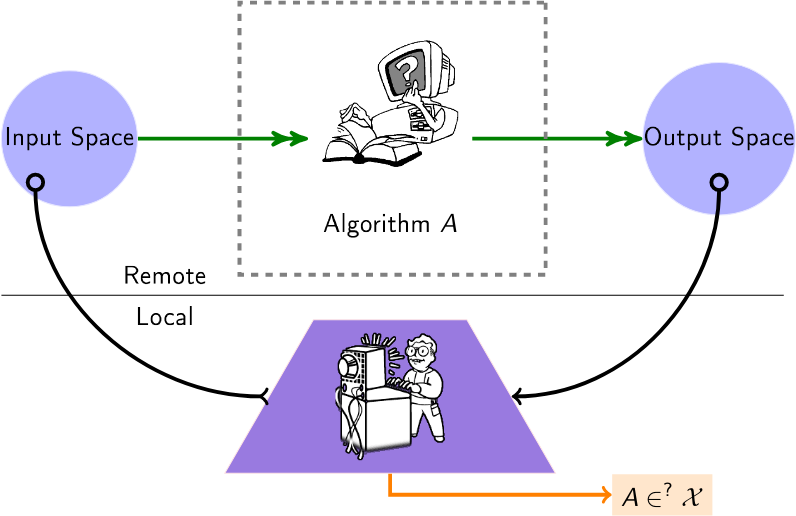

ブラックボックス アルゴリズムを監査するためのアルゴリズムの厳選されたリスト。現在、多くのアルゴリズム (推奨、スコアリング、分類) はサードパーティのプロバイダーで運用されており、ユーザーや機関はデータをどのように操作するかについてまったく洞察を持っていません。したがって、このリストの監査アルゴリズムは、「ブラックボックス」セットアップと呼ばれるこのセットアップに適用されます。このセットアップでは、監査人がこれらのリモート アルゴリズムについて何らかの洞察を得る必要があります。

ユーザーは、リモート アルゴリズムにクエリを実行して (たとえば、利用可能な API を通じて)、そのアルゴリズムに関する情報を推測します。

コンテンツ

- 論文

- 関連イベント(カンファレンス/ワークショップ)

論文

2024年

- ローカル説明の監査は困難 - (NeurIPS)監査説明のクエリが (法外に) 複雑になります。

- LLM はグラフも幻覚します: 構造的観点 - (複雑なネットワーク) LLM に既知のグラフをクエリし、位相的幻覚を研究します。構造的幻覚のランクを提案します。

- マルチエージェントコラボレーションによる公平性監査 - (ECAI)複数のエージェントが連携して動作し、それぞれが異なるタスクに対して同じプラットフォームを監査することを考慮します。

- アルゴリズム監査分野のマッピング: 研究傾向、言語的および地理的格差を特定する体系的な文献レビュー - (Arxiv)アルゴリズム監査研究の体系的なレビューとその方法論的アプローチの傾向の特定。

- FairProof: ニューラル ネットワークの機密性と証明可能な公平性 - (Arxiv) Zero-Knowledge Proofs などの暗号化ツールを使用した従来の監査に代わるパラダイムを提案します。は、小規模なニューラル ネットワークの公平性を検証するための FairProof と呼ばれるシステムを提供します。

- 一部の AI モデルは操作されており、監査が困難ですか? - (SATML) Rademacher の複雑さを使用して、ブラックボックス監査の難しさを対象モデルの容量に関連付けます。

- 言語分類モデルに対するメンバーシップ推論攻撃の改善 - (ICLR)監査モードで分類子に対するメンバーシップ推論攻撃を実行するためのフレームワークを提供します。

- Auditing Fairness by Betting - (Neurips) [コード]ブラックボックス分類器またはリグレッサーからの受信データの継続的な監視を可能にするシーケンシャル メソッド。

2023年

- 1 回のトレーニング実行によるプライバシー監査 - (NeurIPS - 最優秀論文) 1 回のトレーニング実行で差分プライベート機械学習システムを監査するスキーム。

- 反事実的推論による無意識下での公平性の監査 - (情報処理と管理)規制に準拠しているブラックボックス モデルがまだ偏っているかどうかを明らかにする方法を示します。

- XAudit : 説明による監査の理論的考察 - (Arxiv)監査における説明の役割を形式化し、モデルの説明が監査に役立つかどうか、またどのように役立つかを調査します。

- Keeping Up with the Language Models: Robustness-Bias Interplay in NLI Data and Models - (Arxiv)言語モデル自体を使用して監査データセットの有効期間を延長する方法を提案します。また、現在のバイアス監査メトリクスの問題を発見し、代替案を提案します。これらの代替案は、モデルの脆弱性が以前のバイアス スコアを表面的に増加させたことを強調しています。

- Online Fairness Auditing through Iterative Refinement - (KDD)公平性メトリクスの推定に関連する確率的保証の推論を自動化する適応プロセスを提供します。

- 言語モデルのデコード アルゴリズムの盗用 - (CCS) LLM のデコード アルゴリズムの型とハイパーパラメータを盗みます。

- YouTube のウサギの穴のモデリング - (SNAM) YouTube のウサギの穴にユーザーを閉じ込めるダイナミクスをモデル化し、この囲いの尺度を提供します。

- 誤情報フィルター バブルに対する YouTube のレコメンデーション アルゴリズムの監査 - (レコメンダー システムのトランザクション) 「バブルを破る」、つまりレコメンデーションからバブルの囲いを戻すには何が必要か。

- Yelp のビジネス ランキングとレビュー推奨システムを公平性のレンズで監査する - (Arxiv) Yelp のビジネス ランキングとレビュー推奨システムの公平性を、人口統計的均等、エクスポージャ、および分位線形回帰やロジスティック回帰などの統計テストを使用して監査します。

- Confidential-PROFITT: Confidential PROof of FaIr Training of Trees - (ICLR)監査対象サーバー上で公平性の証明を取得するための、ゼロ知識証明プロトコルとともに公正なデシジョン ツリー学習アルゴリズムを提案します。

- スケールアップ: スケールされた予測一貫性の分析による効率的なブラックボックス入力レベルのバックドア検出 - (ICLR)サービスとしての機械学習 (MLaaS) アプリケーションのブラックボックス設定でのバックドア検出を考慮します。

2022年

- Two-Face: 商用顔認識システムの敵対的監査 - (ICWSM)複数のシステム API およびデータセットに対して敵対的監査を実行し、多くの懸念すべき観察を行います。

- 検索エンジン監査のスケールアップ: アルゴリズム監査の実践的な洞察 - (Journal of Information Science) (コード)仮想エージェントによるシミュレートされたブラウジング動作を使用して、複数の検索エンジンを監査します。

- 石灰の皮: アーキテクチャに依存しないモデルの距離に向けて - (ICLR) LIME を使用して 2 つのリモート モデル間の距離を測定します。

- Active Fairness Auditing - (ICML)クエリ効率の高い方法で ML モデルの人口統計的パリティを推定できるクエリベースの監査アルゴリズムの研究。

- 分散を見てください! Sobol ベースの感度分析による効率的なブラック ボックスの説明 - (NeurIPS) Sobol インデックスは、画像領域間の高次の相互作用と、分散のレンズを通して (ブラック ボックス) ニューラル ネットワークの予測への寄与をキャプチャする効率的な方法を提供します。

- Your Echos are Heard: Amazon スマート スピーカー エコシステムの追跡、プロファイリング、および広告ターゲティング - (arxiv) Amazon Echo システムと広告ターゲティング アルゴリズム間のリンクを推測します。

2021年

- 審判員もプレーヤーの場合: 電子商取引マーケットプレイスでのプライベート ラベル製品の推奨におけるバイアス - (FAccT) Amazon のプライベート ラベル製品は推奨事項で不公平なシェアを獲得しているため、サードパーティ製品と比較して有利ですか?

- 日常的なアルゴリズム監査: 有害なアルゴリズム動作を表面化する日常ユーザーの力を理解する - (CHI)ユーザーによる「日常的なアルゴリズム監査」について主張します。

- データ最小化コンプライアンスのためのブラックボックス予測モデルの監査 - (NeurIPS)限られた数のクエリを使用して、予測モデルが満たすデータ最小化のレベルを測定します。

- シャドウ禁止に関する記録をより正確に設定する - (情報コム) (コード) Twitter でのシャドウ禁止の可能性 (つまり、モデレーション ブラック ボックス アルゴリズム) を検討し、いくつかの仮説の確率を測定します。

- 大規模言語モデルからのトレーニング データの抽出 - (USENIX セキュリティ) GPT-2 モデルのトレーニング データから逐語的なテキスト シーケンスを抽出します。

- FairLens: ブラックボックス臨床意思決定支援システムの監査 - (情報処理および管理)さまざまなマルチラベル分類の不一致尺度を比較することにより、臨床 DSS における潜在的な公平性の問題を検出および説明するためのパイプラインを提供します。

- Twitter 上のアルゴリズム バイアスの監査 - (WebSci)。

- ベイジアン アルゴリズムの実行: 相互情報を使用したブラック ボックス関数の計算可能なプロパティの推定 - (ICML)ブラック ボックス アルゴリズムからプロパティを抽出するための、予算制約付きのベイジアン最適化手順。

2020年

- ブラック ボックス リッパー: 生成進化アルゴリズムを使用したブラック ボックス モデルのコピー - (NeurIPS)ブラック ボックス ニューラル モデルの機能を複製しますが、クエリの量に制限はありません (教師/生徒スキームおよび進化的検索を介して)。 。

- 過激化経路の監査 - (FAT*)静的チャネル推奨のランダム ウォークを使用して、互いからの過激化チャネルの到達可能性を調査します。

- グラフ ニューラル ネットワーク上の敵対的モデルの抽出 - (グラフ上の深層学習に関する AAAI ワークショップ: 方法論とアプリケーション) GNN モデルの抽出を紹介し、そのための予備的なアプローチを示します。

- リモートの説明可能性は用心棒問題に直面しています - (Nature Machine Intelligence volume 2、pages529–539) (コード)リモート AI の決定の説明にある不可能性 (1 つのリクエストによる) または発見の難しさを示します。

- GeoDA: ブラック ボックス敵対的攻撃のための幾何学的フレームワーク - (CVPR) (コード)純粋なブラックボックス セットアップ (勾配なし、推論クラスのみ) で、モデルを欺くための敵対的サンプルを作成します。

- The Imitation Game: Algorithm Selectionby Exploiting Black-Box Recommender - (Netys) (コード)リモートのより適切に訓練されたアルゴリズムの決定を模倣することにより、ローカルの推奨アルゴリズムをパラメーター化します。

- ニュースキュレーションシステムの監査:Apple News のアルゴリズムと編集ロジックを検証するケーススタディ - (ICWSM)社会技術ニュースキュレーションシステムとしての Apple News の監査研究 (トレンド記事セクション)。

- 監査アルゴリズム: 学んだ教訓とデータ最小化のリスクについて - (AIES) Telefónica が開発した健康推奨アプリの実践的な監査 (主にバイアスに基づく)。

- 大規模な言語モデルからのトレーニング データの抽出 - (arxiv)言語モデルをクエリすることによって、トレーニング データ抽出攻撃を実行して、個々のトレーニング サンプルを復元します。

2019年

- リモート ニューラル ネットワーク ウォーターマークのための敵対的フロンティア ステッチング - (ニューラル コンピューティングとアプリケーション) (代替実装)リモート機械学習モデルが「漏洩」しているかどうかを確認します。リモート モデルへの標準 API リクエストを通じて、ゼロを抽出します (または抽出しません)。ビット ウォーターマーク。貴重なモデル (大規模なディープ ニューラル ネットワークなど) にウォーターマークを付けるために挿入されました。

- ノックオフ ネット: ブラック ボックス モデルの機能を盗む - (CVPR)攻撃者がブラックボックスの相互作用 (画像入力、予測出力) のみに基づいて、そのような「被害者」モデルの機能をどの程度盗むことができるかを尋ねます。

- ブラック ボックスを開く: Google のトップ ストーリー アルゴリズムの監査 - (Flairs-32)ニュース発行者の選択とランキングに関するアルゴリズムの選択についての洞察を提供する、Google のトップ ストーリー パネルの監査

- 標的型ブラックボックス回避攻撃を効果的かつ効率的にする - (arXiv)攻撃者がディープ ニューラル ネットワークに対する標的型回避攻撃に対してクエリ バジェットを最適に使用する方法を調査します。

- 広告オークションにおけるインセンティブの互換性を測定するためのオンライン学習 - (WWW)ブラックボックス オークション プラットフォームのインセンティブの互換性 (IC) メカニズム (リグレット) を測定します。

- TamperNN: Efficient Tampering Detection of Deployed Neural Nets - (ISSRE)リモートで実行される分類子モデルの改ざんを検出できる入力を作成するアルゴリズム。

- アーキテクチャのヒントを聞いたエッジデバイスにおけるニューラルネットワークモデル抽出攻撃 - (arxiv)バススヌーピングからのメモリアクセスイベントの取得を通じて、LSTM-CTCモデルによる層順序識別、メモリアクセスパターンに従った層トポロジ接続、および層次元推定を介してデータ量の制約があるため、攻撃の開始点と同様のネットワーク アーキテクチャを正確に復元できることが実証されています。

- ラベルなし複合データを使用して保護されたディープ ニューラル ネットワークから知識を盗む - (ICNN)ソフトマックス出力が完全に隠蔽されている場合でも、ブラック ボックス モデルを攻撃して知識を抽出するために使用できる複合手法。

- 背景知識調整による敵対的設定におけるニューラル ネットワーク反転 - (CCS)元のモデルの逆として機能する反転モデルのトレーニングに基づく、敵対的設定におけるモデル反転アプローチ。元のトレーニング データに関する完全な知識がなくても、より一般的なデータ分布から抽出された補助サンプルで反転モデルをトレーニングすることによって、正確な反転が可能です。

2018年

- ブラックボックスを開けずに反事実的な説明: 自動化された意思決定と GDPR - (Harvard Journal of Law & Technology) x に関する決定を説明するには、反事実、つまり決定を変更する x に最も近い点を見つけます。

- Distill-and-Compare: Auditing Black-Box Models using Transparent Model Distillation - (AIES)ブラック ボックス モデルを教師として扱い、ブラック ボックス モデルによって割り当てられたリスク スコアを模倣するように透明な学生モデルをトレーニングします。

- リバース エンジニアリング ブラック ボックス ニューラル ネットワークに向けて - (ICLR) (コード)特定の入力に対する応答パターンを分析することにより、リモート ニューラル ネットワーク モデルの内部ハイパーパラメーター (層数、非線形活性化タイプなど) を推測します。

- 敵対的ドメインのブラック ボックス分類子に対するデータ駆動型の探索的攻撃 - (ニューロコンピューティング)リモート分類子モデルをリバース エンジニアリングします (CAPTCHA テストを回避するためなど)。

- xGEMs: ブラック ボックス モデルを説明するためのサンプルの生成 - (arXiv)教師なしの暗黙的な生成モデルをトレーニングすることにより、ブラック ボックス モデル内のバイアスを検索します。次に、データ多様体に沿ってデータ サンプルを摂動させることにより、ブラック ボックス モデルの動作を定量的に要約します。

- ランダム ウォーク ベースのノード類似性からネットワークを学習する - (NIPS)ランダム ウォークの通勤時間を観察することによってグラフを反転します。

- ブラックボックス モデルから機械学習ファミリーを特定する - (CAEPIA)返された予測の背後にある機械学習モデルの種類を特定します。

- タイミング サイド チャネルを介したニューラル ネットワークの盗用 - (arXiv)クエリを使用したタイミング攻撃によるモデルの盗用/近似。

- Copycat CNN: ランダムなラベルなしデータで自白を説得することによる知識の盗用 - (IJCNN) (コード)ランダムな自然画像 (ImageNet および Microsoft-COCO) を使用してブラック ボックス モデル (CNN) の知識をクエリすることによって、知識を盗みます。

- 政治関連の検索エンジン結果ページのパーソナライゼーションと構成の監査 - (WWW)パーソナライゼーションと構成を調査するために、参加者を調査し、検索エンジン結果ページ (SERP) とオートコンプリートの提案を収集するための Chrome 拡張機能。

2017年

- Uncovering Influence Cookbook : Reverse Engineering the Topological Impact in Peer Ranking Services - (CSCW)ピア ランキング サービスでどの中心性メトリクスが使用されているかを特定することを目的としています。

- レコメンデーションのトポロジカルな側面: バイアス検出へのモデルとアプリケーション - (複雑なネットワーク)ユーザーに推奨されるアイテムのバイアス検出フレームワークを提案します。

- 機械学習モデルに対するメンバーシップ推論攻撃 - (セキュリティとプライバシーに関するシンポジウム)機械学習モデルとレコードが与えられた場合、このレコードがモデルのトレーニング データセットの一部として使用されたかどうかを判断します。

- 機械学習に対する実践的なブラックボックス攻撃 - (アジア CCS)リモート サービスが敵対的分類攻撃に対してどれほど脆弱かを理解します。

2016年

- 定量的入力影響によるアルゴリズムの透明性: 学習システムの理論と実験 - (IEEE S&P) Shapley 値を使用して、モデルに対するフィーチャの個別、結合、および周辺の影響を評価します。

- 間接的な影響のためのブラック ボックス モデルの監査 - (ICDM)データセットから変数を「賢く」削除し、精度のギャップを確認することで、ブラック ボックス モデルに対する変数の影響を評価します。

- ブラック ボックス モデルのバイアスを診断するための反復直交特徴投影 - (FATML ワークショップ)ブラック ボックス モデルを分析するために特徴ランキングを実行します。

- オンライン フリーランス マーケットプレイスのバイアス: TaskRabbit からの証拠 - (dat ワークショップ) TaskRabbit の検索アルゴリズム ランクを測定します。

- 予測 API を介した機械学習モデルの盗用 - (Usenix セキュリティ) (コード)リモート サービスで使用されている機械学習モデルを抽出することを目的としています。

- 「なぜ信頼すべきですか?」分類子の予測の説明 - (arXiv) (コード)データ インスタンスを中心にサンプリングすることにより、ブラックボックス分類子モデルを説明します。

- Back in Black: サニタイザーとフィルターの正式なブラック ボックス分析に向けて - (セキュリティとプライバシー)サニタイザーとフィルターのブラック ボックス分析。

- 定量的入力の影響によるアルゴリズムの透明性: 学習システムの理論と実験 - (セキュリティとプライバシー)観察されたシステムの出力に対する入力の影響の程度を捕捉する手段を紹介します。

- Amazon マーケットプレイスのアルゴリズム価格設定の実証分析 - (WWW) (コード)アルゴリズム価格設定を検出する方法論を開発し、それを実証的に使用して Amazon マーケットプレイスでのアルゴリズム価格設定の蔓延と動作を分析します。

2015年

- Certifying and Removing Disparate Impact - (SIGKDD)バイアスがないことを証明する SVM ベースの方法と、データセットからバイアスを除去する方法を提案します。

- Uber のボンネットの下を覗く - (IMC) Uber の急騰価格アルゴリズムの実装の詳細を推測します。

2014年

- ブラック ボックスの覗き見: ランダム化による分類器の探索 - (データ マイニングと知識発見ジャーナル) (コード)予測サンプルの出力ラベルを変更せずに並べ替えることができる特徴のグループを見つけます

- XRay: 微分相関による Web の透明性の強化 - (USENIX セキュリティ)特定の広告、推奨事項、または価格をターゲティングするためにどのユーザー プロファイル データが使用されたかを監査します。

2013年

- Web 検索のパーソナライゼーションの測定 - (WWW) Web 検索結果のパーソナライゼーションを測定する方法を開発します。

- 監査: 結果依存のクエリ コストによるアクティブ ラーニング - (NIPS)負のラベルのみを支払うバイナリ分類器から学習します。

2012年

- 凸型分類器を回避するためのクエリ戦略 - (JMLR)凸型分類器の回避方法。回避の複雑さを考慮します。

2008年

- Privacy Oracle: ブラック ボックス差分テストによるアプリケーション リークを発見するシステム - (CCS) Privacy Oracle: リモート サーバーへの送信におけるアプリケーションの個人情報の漏洩を明らかにするシステム。

2005年

- 敵対的学習 - (KDD)メンバーシップ クエリを使用した、リモート線形分類器のリバース エンジニアリング。

関連イベント

2024年

- 第 1 回監査と人工知能に関する国際会議

- 規制可能な ML ワークショップ (RegML'24)

2023年

- AI のテスト、監査、およびコンテストにおけるユーザーの関与をサポート (CSCW ユーザー AI 監査)

- アルゴリズムのアルゴリズム監査に関するワークショップ (WAAA)

- 規制可能な ML ワークショップ (RegML'23)