Pytorch での Vision Transformer の実装。これは、単一のトランスフォーマー エンコーダーのみを使用してビジョン分類における SOTA を実現する簡単な方法です。重要性については、Yannic Kilcher のビデオでさらに説明されています。ここでコードを書くことはあまりありませんが、注意革命を促進するために、全員のためにレイアウトしておくとよいでしょう。

事前トレーニング済みモデルを使用した Pytorch 実装については、Ross Wightman のリポジトリをここで参照してください。

公式の Jax リポジトリはここにあります。

ここには、研究科学者の Junho Kim によって作成された tensorflow2 の翻訳も存在します。

エンリコ・シッポレによる亜麻の翻訳!

$ pip install vit-pytorch import torch

from vit_pytorch import ViT

v = ViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

img = torch . randn ( 1 , 3 , 256 , 256 )

preds = v ( img ) # (1, 1000) image_size : int.patch_size : int.image_size patch_sizeで割り切れる必要があります。n = (image_size // patch_size) ** 2 、 nは16 より大きくなければなりません。num_classes : int.dim : int.nn.Linear(..., dim)後の出力テンソルの最後の次元。depth : 整数heads : int.mlp_dim : int.channels : int、デフォルトは3 。dropout : [0, 1]の間の浮動小数点、デフォルトは0. 。emb_dropout : [0, 1]の間の浮動小数点数、デフォルトは0 。pool : 文字列、 clsトークン プーリングまたはmeanプーリングのいずれか元の論文の同じ著者の何人かによる最新情報では、より速く、より優れたトレーニングを可能にするViTの簡素化が提案されています。

これらの簡略化には、2D 正弦波位置埋め込み、グローバル平均プーリング (CLS トークンなし)、ドロップアウトなし、バッチ サイズ 4096 ではなく 1024、RandAugment および MixUp 拡張の使用が含まれます。また、最後の単純なリニアが元の MLP ヘッドより大幅に劣っていないことも示しています。

以下のようにSimpleViTインポートすることで利用できます。

import torch

from vit_pytorch import SimpleViT

v = SimpleViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 16 ,

mlp_dim = 2048

)

img = torch . randn ( 1 , 3 , 256 , 256 )

preds = v ( img ) # (1, 1000)

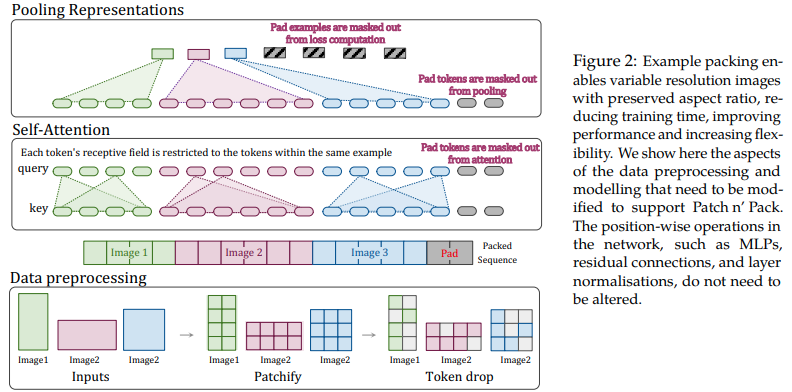

この論文では、可変長シーケンスのアテンションとマスキングの柔軟性を活用して、単一のバッチにパックされた複数の解像度の画像をトレーニングすることを提案します。これらは、アーキテクチャとデータ読み込みがさらに複雑になることだけを犠牲にして、はるかに高速なトレーニングと向上した精度を実証します。これらは、因数分解された 2D 位置エンコーディング、トークン ドロップ、およびクエリ キーの正規化を使用します。

次のように使用できます

import torch

from vit_pytorch . na_vit import NaViT

v = NaViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1 ,

token_dropout_prob = 0.1 # token dropout of 10% (keep 90% of tokens)

)

# 5 images of different resolutions - List[List[Tensor]]

# for now, you'll have to correctly place images in same batch element as to not exceed maximum allowed sequence length for self-attention w/ masking

images = [

[ torch . randn ( 3 , 256 , 256 ), torch . randn ( 3 , 128 , 128 )],

[ torch . randn ( 3 , 128 , 256 ), torch . randn ( 3 , 256 , 128 )],

[ torch . randn ( 3 , 64 , 256 )]

]

preds = v ( images ) # (5, 1000) - 5, because 5 images of different resolution aboveまたは、フレームワークが特定の最大長を超えない可変長のシーケンスに画像を自動的にグループ化したい場合

images = [

torch . randn ( 3 , 256 , 256 ),

torch . randn ( 3 , 128 , 128 ),

torch . randn ( 3 , 128 , 256 ),

torch . randn ( 3 , 256 , 128 ),

torch . randn ( 3 , 64 , 256 )

]

preds = v (

images ,

group_images = True ,

group_max_seq_len = 64

) # (5, 1000)最後に、ネストされたテンソルを使用して NaViT のフレーバーを利用したい場合 (これにより、多くのマスキングとパディングが完全に省略されます)、バージョン2.5使用していることを確認し、次のようにインポートします。

import torch

from vit_pytorch . na_vit_nested_tensor import NaViT

v = NaViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0. ,

emb_dropout = 0. ,

token_dropout_prob = 0.1

)

# 5 images of different resolutions - List[Tensor]

images = [

torch . randn ( 3 , 256 , 256 ), torch . randn ( 3 , 128 , 128 ),

torch . randn ( 3 , 128 , 256 ), torch . randn ( 3 , 256 , 128 ),

torch . randn ( 3 , 64 , 256 )

]

preds = v ( images )

assert preds . shape == ( 5 , 1000 )

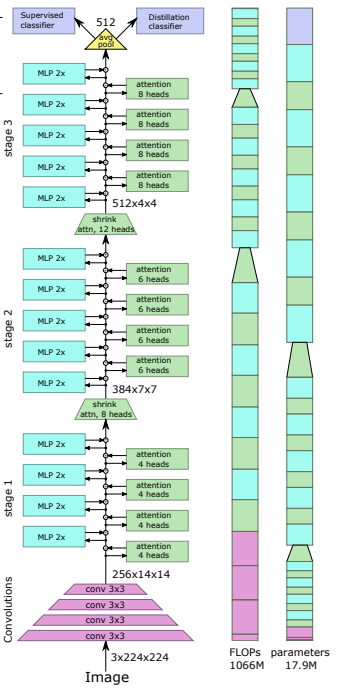

最近の論文では、畳み込みネットからビジョン トランスフォーマーへの知識の蒸留に蒸留トークンを使用すると、小型で効率的なビジョン トランスフォーマーが得られることが示されました。このリポジトリは、蒸留を簡単に行う手段を提供します。

元。 Resnet50 (または任意の教師) からビジョン トランスフォーマーへの蒸留

import torch

from torchvision . models import resnet50

from vit_pytorch . distill import DistillableViT , DistillWrapper

teacher = resnet50 ( pretrained = True )

v = DistillableViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 8 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

distiller = DistillWrapper (

student = v ,

teacher = teacher ,

temperature = 3 , # temperature of distillation

alpha = 0.5 , # trade between main loss and distillation loss

hard = False # whether to use soft or hard distillation

)

img = torch . randn ( 2 , 3 , 256 , 256 )

labels = torch . randint ( 0 , 1000 , ( 2 ,))

loss = distiller ( img , labels )

loss . backward ()

# after lots of training above ...

pred = v ( img ) # (2, 1000) DistillableViTクラスは、フォワード パスの処理方法を除いてViTと同一であるため、蒸留トレーニングの完了後にパラメーターをViTにロードして戻すことができるはずです。

DistillableViTインスタンスで便利な.to_vitメソッドを使用して、 ViTインスタンスを取得することもできます。

v = v . to_vit ()

type ( v ) # <class 'vit_pytorch.vit_pytorch.ViT'> この論文は、ViT がより深いところ (過去 12 層) で注意を払うのに苦労していることを指摘し、解決策としてソフトマックス後の各頭部の注意を混合すること (Re-attention と呼ばれる) を提案しています。この結果は、NLP のトーキング ヘッズの論文と一致しています。

次のように使用できます

import torch

from vit_pytorch . deepvit import DeepViT

v = DeepViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

img = torch . randn ( 1 , 3 , 256 , 256 )

preds = v ( img ) # (1, 1000) この論文では、より深度の視覚変換器をトレーニングすることの難しさも指摘し、2 つの解決策を提案しています。まず、残差ブロックの出力をチャネルごとに乗算することを提案します。 2 番目に、パッチを相互に対応させ、CLS トークンが最後の数層のパッチにのみ対応できるようにすることを提案します。

彼らはトーキング・ヘッズも追加し、改善点を指摘している

このスキームは次のように使用できます

import torch

from vit_pytorch . cait import CaiT

v = CaiT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 12 , # depth of transformer for patch to patch attention only

cls_depth = 2 , # depth of cross attention of CLS tokens to patch

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1 ,

layer_dropout = 0.05 # randomly dropout 5% of the layers

)

img = torch . randn ( 1 , 3 , 256 , 256 )

preds = v ( img ) # (1, 1000)

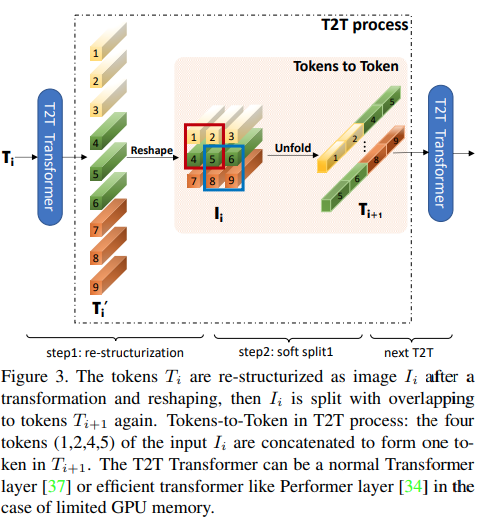

この論文では、最初のいくつかのレイヤーが展開によって画像シーケンスをダウンサンプリングし、上の図に示すように各トークン内の画像データが重複するようにすることを提案しています。 ViTのこのバリアントは次のように使用できます。

import torch

from vit_pytorch . t2t import T2TViT

v = T2TViT (

dim = 512 ,

image_size = 224 ,

depth = 5 ,

heads = 8 ,

mlp_dim = 512 ,

num_classes = 1000 ,

t2t_layers = (( 7 , 4 ), ( 3 , 2 ), ( 3 , 2 )) # tuples of the kernel size and stride of each consecutive layers of the initial token to token module

)

img = torch . randn ( 1 , 3 , 224 , 224 )

preds = v ( img ) # (1, 1000) CCT は、シーケンス プーリングをパッチして実行する代わりに畳み込みを使用することにより、コンパクトなトランスフォーマーを提案しています。これにより、CCT の精度が高く、パラメーターの数が少なくなります。

これは 2 つの方法で使用できます

import torch

from vit_pytorch . cct import CCT

cct = CCT (

img_size = ( 224 , 448 ),

embedding_dim = 384 ,

n_conv_layers = 2 ,

kernel_size = 7 ,

stride = 2 ,

padding = 3 ,

pooling_kernel_size = 3 ,

pooling_stride = 2 ,

pooling_padding = 1 ,

num_layers = 14 ,

num_heads = 6 ,

mlp_ratio = 3. ,

num_classes = 1000 ,

positional_embedding = 'learnable' , # ['sine', 'learnable', 'none']

)

img = torch . randn ( 1 , 3 , 224 , 448 )

pred = cct ( img ) # (1, 1000)あるいは、レイヤーの数、アテンション ヘッドの数、mlp 比、および埋め込み次元を事前に定義する、いくつかの事前定義されたモデル[2,4,6,7,8,14,16]の 1 つを使用することもできます。

import torch

from vit_pytorch . cct import cct_14

cct = cct_14 (

img_size = 224 ,

n_conv_layers = 1 ,

kernel_size = 7 ,

stride = 2 ,

padding = 3 ,

pooling_kernel_size = 3 ,

pooling_stride = 2 ,

pooling_padding = 1 ,

num_classes = 1000 ,

positional_embedding = 'learnable' , # ['sine', 'learnable', 'none']

)公式リポジトリには、事前トレーニングされたモデルのチェックポイントへのリンクが含まれています。

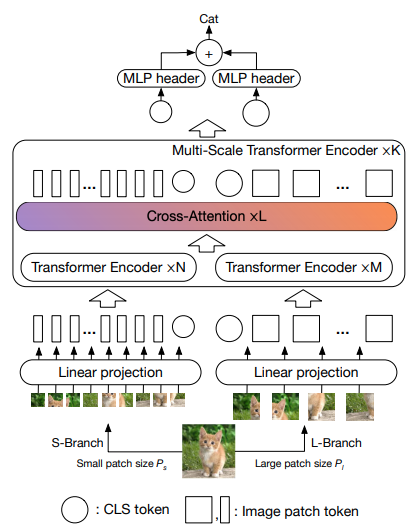

この論文では、2 つのビジョン トランスフォーマーが異なるスケールで画像を処理し、時々 1 つを相互に処理することを提案します。これらは、ベース ビジョン トランスフォーマーの改良点を示しています。

import torch

from vit_pytorch . cross_vit import CrossViT

v = CrossViT (

image_size = 256 ,

num_classes = 1000 ,

depth = 4 , # number of multi-scale encoding blocks

sm_dim = 192 , # high res dimension

sm_patch_size = 16 , # high res patch size (should be smaller than lg_patch_size)

sm_enc_depth = 2 , # high res depth

sm_enc_heads = 8 , # high res heads

sm_enc_mlp_dim = 2048 , # high res feedforward dimension

lg_dim = 384 , # low res dimension

lg_patch_size = 64 , # low res patch size

lg_enc_depth = 3 , # low res depth

lg_enc_heads = 8 , # low res heads

lg_enc_mlp_dim = 2048 , # low res feedforward dimensions

cross_attn_depth = 2 , # cross attention rounds

cross_attn_heads = 8 , # cross attention heads

dropout = 0.1 ,

emb_dropout = 0.1

)

img = torch . randn ( 1 , 3 , 256 , 256 )

pred = v ( img ) # (1, 1000)

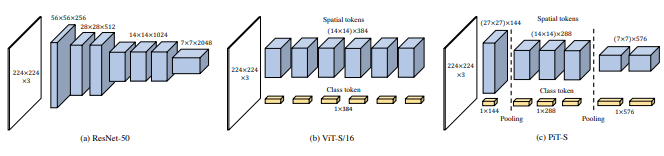

この論文では、深さ方向の畳み込みを使用したプーリング手順を通じてトークンをダウンサンプリングすることを提案しています。

import torch

from vit_pytorch . pit import PiT

v = PiT (

image_size = 224 ,

patch_size = 14 ,

dim = 256 ,

num_classes = 1000 ,

depth = ( 3 , 3 , 3 ), # list of depths, indicating the number of rounds of each stage before a downsample

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

# forward pass now returns predictions and the attention maps

img = torch . randn ( 1 , 3 , 224 , 224 )

preds = v ( img ) # (1, 1000)

この論文では、(1) パッチごとの投影の代わりに畳み込み埋め込み (2) 段階的なダウンサンプリング (3) 注意の追加の非線形性 (4) 初期の絶対位置バイアスの代わりに 2D 相対位置バイアス (5) など、多くの変更を提案しています。 )layernorm の代わりにバッチノルムを使用します。

公式リポジトリ

import torch

from vit_pytorch . levit import LeViT

levit = LeViT (

image_size = 224 ,

num_classes = 1000 ,

stages = 3 , # number of stages

dim = ( 256 , 384 , 512 ), # dimensions at each stage

depth = 4 , # transformer of depth 4 at each stage

heads = ( 4 , 6 , 8 ), # heads at each stage

mlp_mult = 2 ,

dropout = 0.1

)

img = torch . randn ( 1 , 3 , 224 , 224 )

levit ( img ) # (1, 1000)

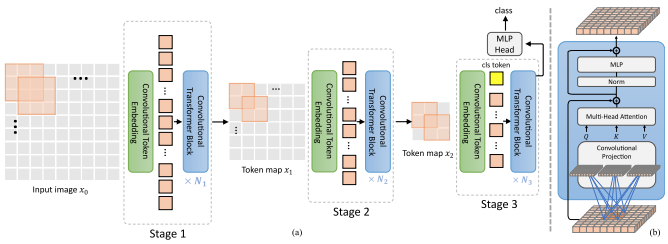

この論文では、混合畳み込みと注意を提案します。具体的には、畳み込みを使用して、画像/特徴マップを 3 段階で埋め込み、ダウンサンプリングします。 Depthwise-convoltion は、クエリ、キー、値を投影して注目を集めるためにも使用されます。

import torch

from vit_pytorch . cvt import CvT

v = CvT (

num_classes = 1000 ,

s1_emb_dim = 64 , # stage 1 - dimension

s1_emb_kernel = 7 , # stage 1 - conv kernel

s1_emb_stride = 4 , # stage 1 - conv stride

s1_proj_kernel = 3 , # stage 1 - attention ds-conv kernel size

s1_kv_proj_stride = 2 , # stage 1 - attention key / value projection stride

s1_heads = 1 , # stage 1 - heads

s1_depth = 1 , # stage 1 - depth

s1_mlp_mult = 4 , # stage 1 - feedforward expansion factor

s2_emb_dim = 192 , # stage 2 - (same as above)

s2_emb_kernel = 3 ,

s2_emb_stride = 2 ,

s2_proj_kernel = 3 ,

s2_kv_proj_stride = 2 ,

s2_heads = 3 ,

s2_depth = 2 ,

s2_mlp_mult = 4 ,

s3_emb_dim = 384 , # stage 3 - (same as above)

s3_emb_kernel = 3 ,

s3_emb_stride = 2 ,

s3_proj_kernel = 3 ,

s3_kv_proj_stride = 2 ,

s3_heads = 4 ,

s3_depth = 10 ,

s3_mlp_mult = 4 ,

dropout = 0.

)

img = torch . randn ( 1 , 3 , 224 , 224 )

pred = v ( img ) # (1, 1000)

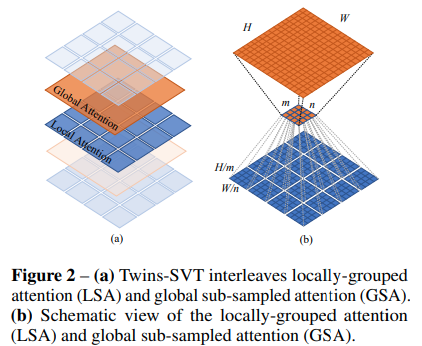

この論文では、位置エンコード ジェネレーター (CPVT で提案) とグローバル平均プーリングとともに、ローカル アテンションとグローバル アテンションを組み合わせて、シフト ウィンドウ、CLS トークン、位置埋め込みといった余分な複雑さを伴うことなく、Swin と同じ結果を達成することを提案します。

import torch

from vit_pytorch . twins_svt import TwinsSVT

model = TwinsSVT (

num_classes = 1000 , # number of output classes

s1_emb_dim = 64 , # stage 1 - patch embedding projected dimension

s1_patch_size = 4 , # stage 1 - patch size for patch embedding

s1_local_patch_size = 7 , # stage 1 - patch size for local attention

s1_global_k = 7 , # stage 1 - global attention key / value reduction factor, defaults to 7 as specified in paper

s1_depth = 1 , # stage 1 - number of transformer blocks (local attn -> ff -> global attn -> ff)

s2_emb_dim = 128 , # stage 2 (same as above)

s2_patch_size = 2 ,

s2_local_patch_size = 7 ,

s2_global_k = 7 ,

s2_depth = 1 ,

s3_emb_dim = 256 , # stage 3 (same as above)

s3_patch_size = 2 ,

s3_local_patch_size = 7 ,

s3_global_k = 7 ,

s3_depth = 5 ,

s4_emb_dim = 512 , # stage 4 (same as above)

s4_patch_size = 2 ,

s4_local_patch_size = 7 ,

s4_global_k = 7 ,

s4_depth = 4 ,

peg_kernel_size = 3 , # positional encoding generator kernel size

dropout = 0. # dropout

)

img = torch . randn ( 1 , 3 , 224 , 224 )

pred = model ( img ) # (1, 1000)

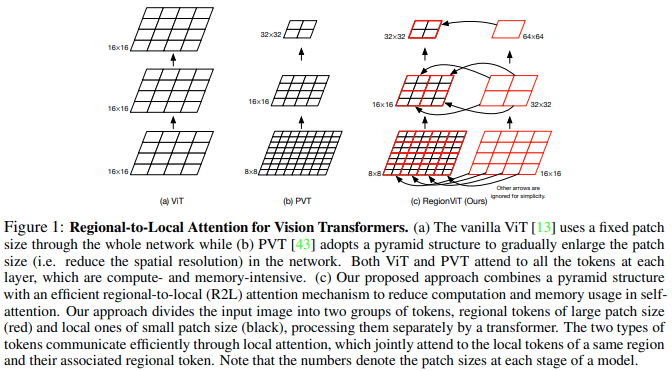

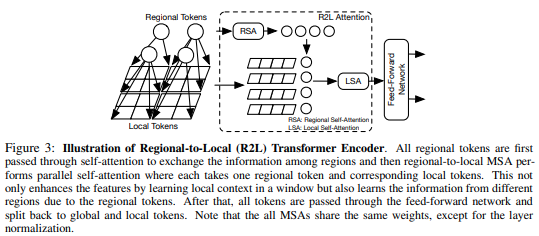

この論文は、特徴マップをローカル領域に分割し、それによってローカルトークンが互いに関与することを提案します。各ローカル リージョンには独自のリージョン トークンがあり、そのすべてのローカル トークンと他のリージョン トークンが処理されます。

次のように使用できます

import torch

from vit_pytorch . regionvit import RegionViT

model = RegionViT (

dim = ( 64 , 128 , 256 , 512 ), # tuple of size 4, indicating dimension at each stage

depth = ( 2 , 2 , 8 , 2 ), # depth of the region to local transformer at each stage

window_size = 7 , # window size, which should be either 7 or 14

num_classes = 1000 , # number of output classes

tokenize_local_3_conv = False , # whether to use a 3 layer convolution to encode the local tokens from the image. the paper uses this for the smaller models, but uses only 1 conv (set to False) for the larger models

use_peg = False , # whether to use positional generating module. they used this for object detection for a boost in performance

)

img = torch . randn ( 1 , 3 , 224 , 224 )

pred = model ( img ) # (1, 1000)

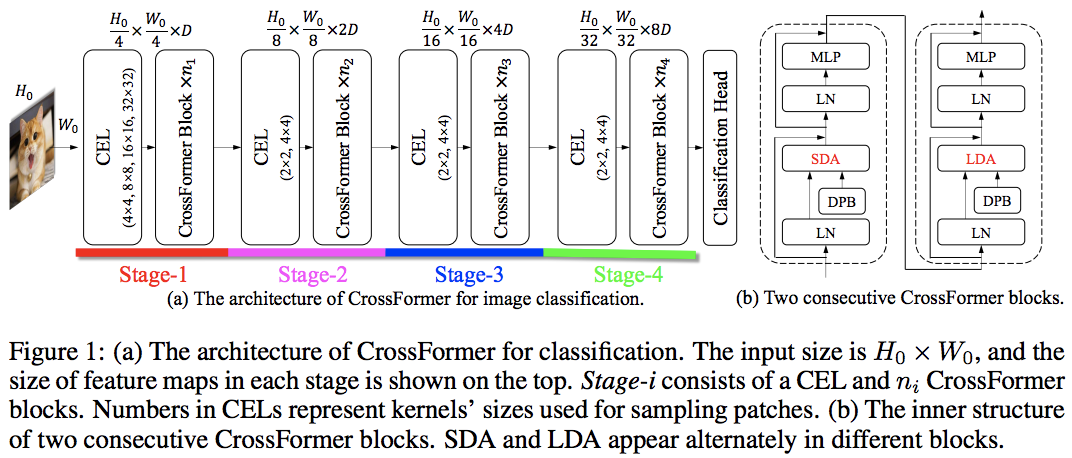

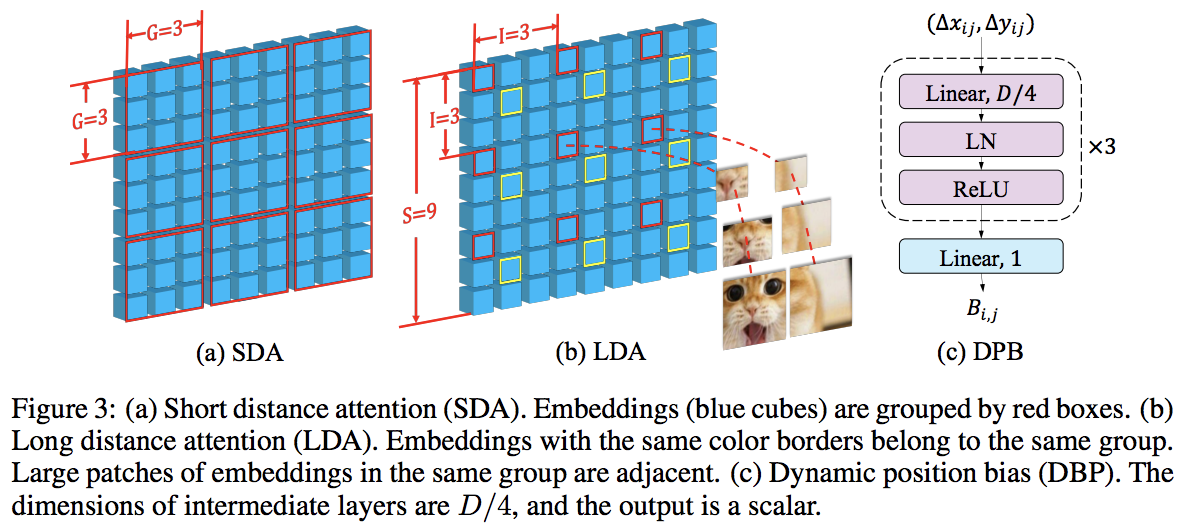

この論文は、ローカルとグローバルの注目を交互に利用して、PVT と Swin を破りました。グローバル アテンションは、軸方向のアテンションに使用されるスキームと同様に、複雑さを軽減するためにウィンドウ次元全体にわたって実行されます。

また、クロススケール埋め込み層もあり、すべてのビジョン トランスフォーマーを改善できる汎用層であることが示されました。動的相対位置バイアスも、ネットをより高い解像度の画像に一般化できるように定式化されました。

import torch

from vit_pytorch . crossformer import CrossFormer

model = CrossFormer (

num_classes = 1000 , # number of output classes

dim = ( 64 , 128 , 256 , 512 ), # dimension at each stage

depth = ( 2 , 2 , 8 , 2 ), # depth of transformer at each stage

global_window_size = ( 8 , 4 , 2 , 1 ), # global window sizes at each stage

local_window_size = 7 , # local window size (can be customized for each stage, but in paper, held constant at 7 for all stages)

)

img = torch . randn ( 1 , 3 , 224 , 224 )

pred = model ( img ) # (1, 1000)

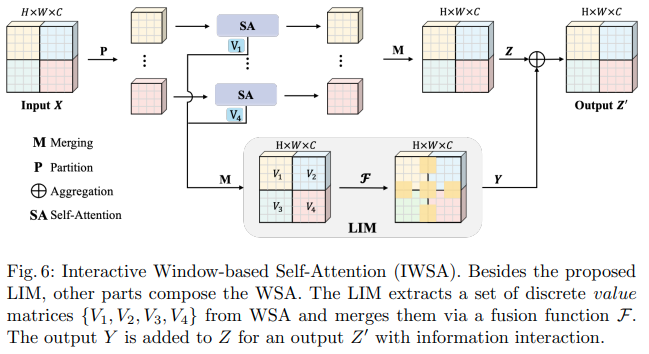

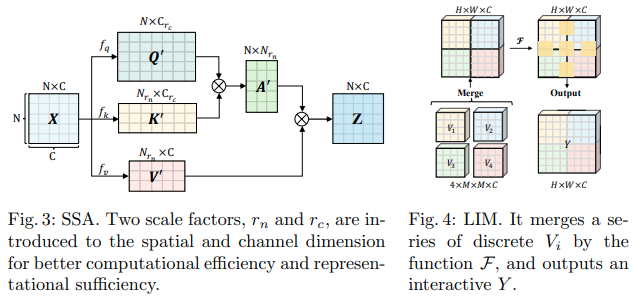

この Bytedance AI 論文では、スケーラブル セルフ アテンション (SSA) モジュールとインタラクティブ ウィンドウ セルフ アテンション (IWSA) モジュールを提案しています。 SSA は、クエリとキーの次元 ( ssa_dim_key ) を調整しながら、キー/値の特徴マップを何らかの係数 ( reduction_factor ) で削減することで、初期の段階で必要な計算を軽減します。 IWSA は、他のビジョン トランスフォーマー ペーパーと同様に、ローカル ウィンドウ内でセルフ アテンションを実行します。ただし、カーネル サイズ 3 の畳み込みを通過した値の残差が追加され、これを Local Interactive Module (LIM) と名付けました。

彼らはこの論文で、このスキームが Swin Transformer よりも優れており、Crossformer に対しても競合するパフォーマンスを示していると主張しています。

以下のように利用できます(例:ScalableViT-S)

import torch

from vit_pytorch . scalable_vit import ScalableViT

model = ScalableViT (

num_classes = 1000 ,

dim = 64 , # starting model dimension. at every stage, dimension is doubled

heads = ( 2 , 4 , 8 , 16 ), # number of attention heads at each stage

depth = ( 2 , 2 , 20 , 2 ), # number of transformer blocks at each stage

ssa_dim_key = ( 40 , 40 , 40 , 32 ), # the dimension of the attention keys (and queries) for SSA. in the paper, they represented this as a scale factor on the base dimension per key (ssa_dim_key / dim_key)

reduction_factor = ( 8 , 4 , 2 , 1 ), # downsampling of the key / values in SSA. in the paper, this was represented as (reduction_factor ** -2)

window_size = ( 64 , 32 , None , None ), # window size of the IWSA at each stage. None means no windowing needed

dropout = 0.1 , # attention and feedforward dropout

)

img = torch . randn ( 1 , 3 , 256 , 256 )

preds = model ( img ) # (1, 1000)

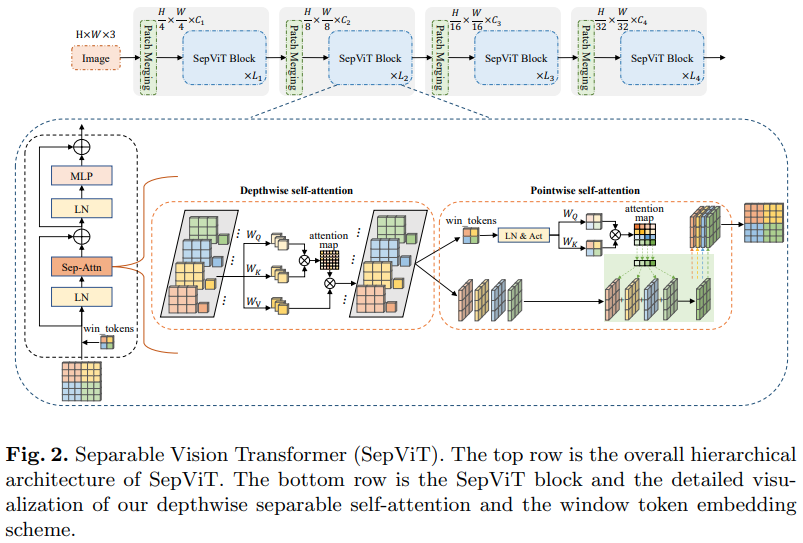

もう 1 つの Bytedance AI 論文では、モバイルネットの深さ方向に分離可能な畳み込みから主にインスピレーションを得ていると思われる、深さ方向-ポイント方向のセルフ アテンション レイヤーを提案しています。最も興味深い点は、上の図に示すように、深さ方向の自己注意ステージからの特徴マップを点単位の自己注意の値として再利用していることです。

グループ化されたアテンション レイヤーは目立ったものでも目新しさもなく、作成者はグループ セルフ アテンション レイヤーのウィンドウ トークンをどのように扱ったかが明確ではなかったため、この特定のSepViTアテンション レイヤーを備えたバージョンの SepViT のみを含めることにしました。しかもDSSA層だけでSwinに勝てたみたいです。

元。 SepViT-Lite

import torch

from vit_pytorch . sep_vit import SepViT

v = SepViT (

num_classes = 1000 ,

dim = 32 , # dimensions of first stage, which doubles every stage (32, 64, 128, 256) for SepViT-Lite

dim_head = 32 , # attention head dimension

heads = ( 1 , 2 , 4 , 8 ), # number of heads per stage

depth = ( 1 , 2 , 6 , 2 ), # number of transformer blocks per stage

window_size = 7 , # window size of DSS Attention block

dropout = 0.1 # dropout

)

img = torch . randn ( 1 , 3 , 224 , 224 )

preds = v ( img ) # (1, 1000)

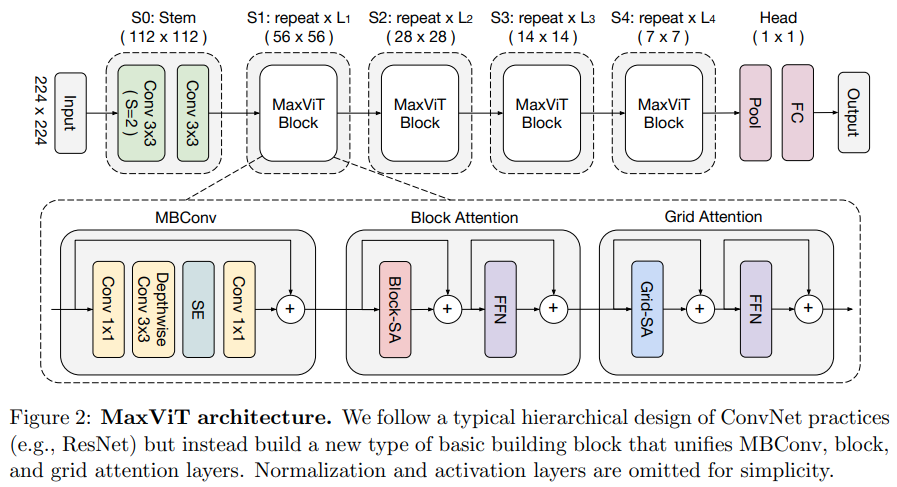

この論文では、畳み込み側から MBConv を使用し、次にブロック/グリッド軸方向スパース アテンションを使用する、ハイブリッド畳み込み/アテンション ネットワークを提案します。

彼らはまた、この特定のビジョン トランスフォーマーが生成モデル (GAN) に適していると主張しています。

元。マックスヴィット-S

import torch

from vit_pytorch . max_vit import MaxViT

v = MaxViT (

num_classes = 1000 ,

dim_conv_stem = 64 , # dimension of the convolutional stem, would default to dimension of first layer if not specified

dim = 96 , # dimension of first layer, doubles every layer

dim_head = 32 , # dimension of attention heads, kept at 32 in paper

depth = ( 2 , 2 , 5 , 2 ), # number of MaxViT blocks per stage, which consists of MBConv, block-like attention, grid-like attention

window_size = 7 , # window size for block and grids

mbconv_expansion_rate = 4 , # expansion rate of MBConv

mbconv_shrinkage_rate = 0.25 , # shrinkage rate of squeeze-excitation in MBConv

dropout = 0.1 # dropout

)

img = torch . randn ( 2 , 3 , 224 , 224 )

preds = v ( img ) # (2, 1000)

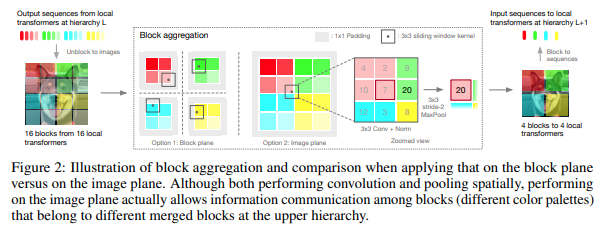

この文書では、階層を上に進むにつれて集合するローカル ブロックのトークン内のみに注目して、画像を階層段階で処理することにしました。集約はイメージ プレーンで行われ、境界を越えて情報を渡すことができるように畳み込みと後続の maxpool が含まれます。

以下のコードで利用できます(例:NesT-T)

import torch

from vit_pytorch . nest import NesT

nest = NesT (

image_size = 224 ,

patch_size = 4 ,

dim = 96 ,

heads = 3 ,

num_hierarchies = 3 , # number of hierarchies

block_repeats = ( 2 , 2 , 8 ), # the number of transformer blocks at each hierarchy, starting from the bottom

num_classes = 1000

)

img = torch . randn ( 1 , 3 , 224 , 224 )

pred = nest ( img ) # (1, 1000)

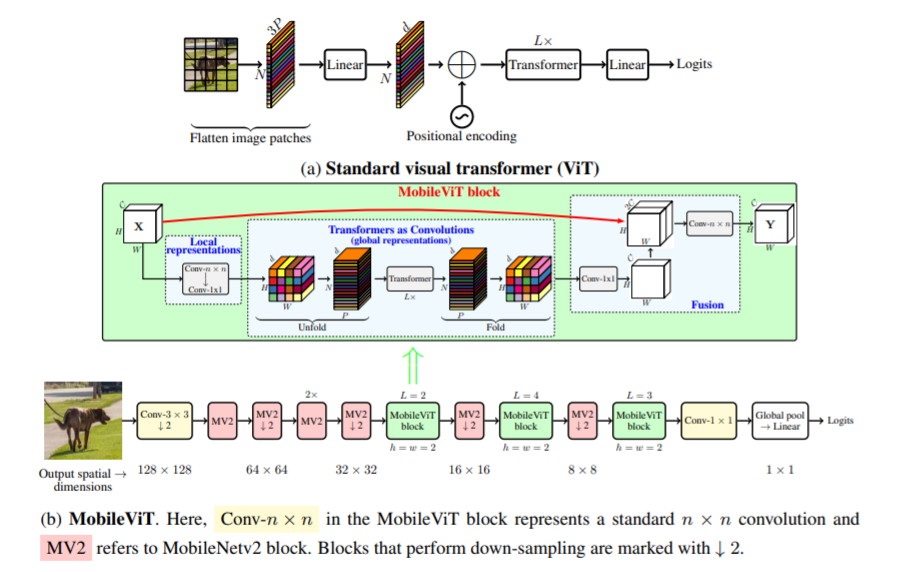

この文書では、モバイル デバイス用の軽量で汎用のビジョン トランスフォーマである MobileViT を紹介します。 MobileViT は、トランスフォーマーを使用したグローバルな情報処理について、別の視点を提供します。

次のコードで使用できます(例:mobilevit_xs)

import torch

from vit_pytorch . mobile_vit import MobileViT

mbvit_xs = MobileViT (

image_size = ( 256 , 256 ),

dims = [ 96 , 120 , 144 ],

channels = [ 16 , 32 , 48 , 48 , 64 , 64 , 80 , 80 , 96 , 96 , 384 ],

num_classes = 1000

)

img = torch . randn ( 1 , 3 , 256 , 256 )

pred = mbvit_xs ( img ) # (1, 1000)

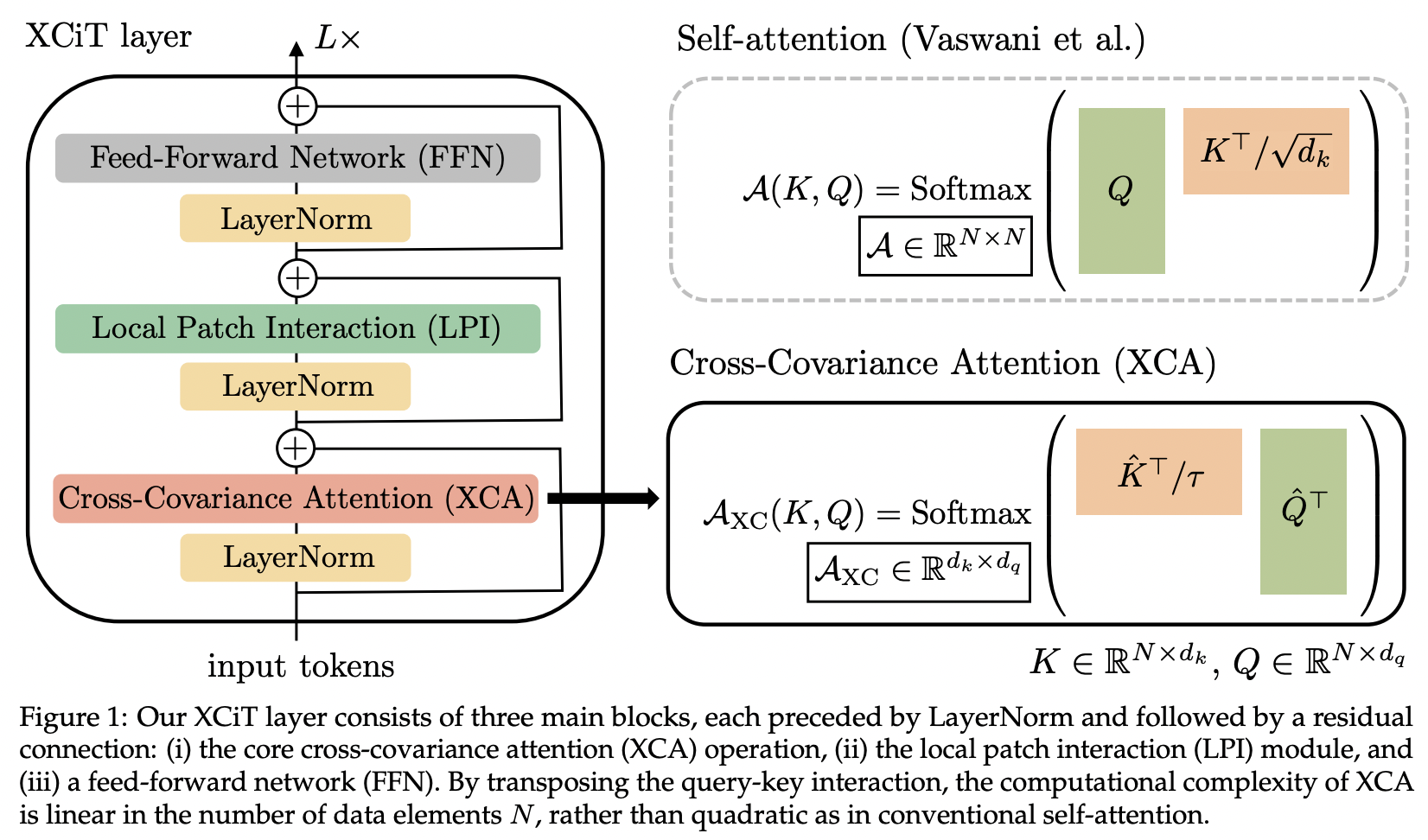

この論文では、相互共分散アテンション (略称 XCA) を紹介します。これは、空間次元ではなく、特徴次元全体にわたって注意を行うものと考えることができます (別の観点からは、動的な 1x1 畳み込み、カーネルは空間相関によって定義される注意マップになります)。

技術的には、これは、学習した温度でコサイン類似度の注意を実行する前に、クエリ、キー、値を単純に置き換えることに相当します。

import torch

from vit_pytorch . xcit import XCiT

v = XCiT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 12 , # depth of xcit transformer

cls_depth = 2 , # depth of cross attention of CLS tokens to patch, attention pool at end

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1 ,

layer_dropout = 0.05 , # randomly dropout 5% of the layers

local_patch_kernel_size = 3 # kernel size of the local patch interaction module (depthwise convs)

)

img = torch . randn ( 1 , 3 , 256 , 256 )

preds = v ( img ) # (1, 1000)

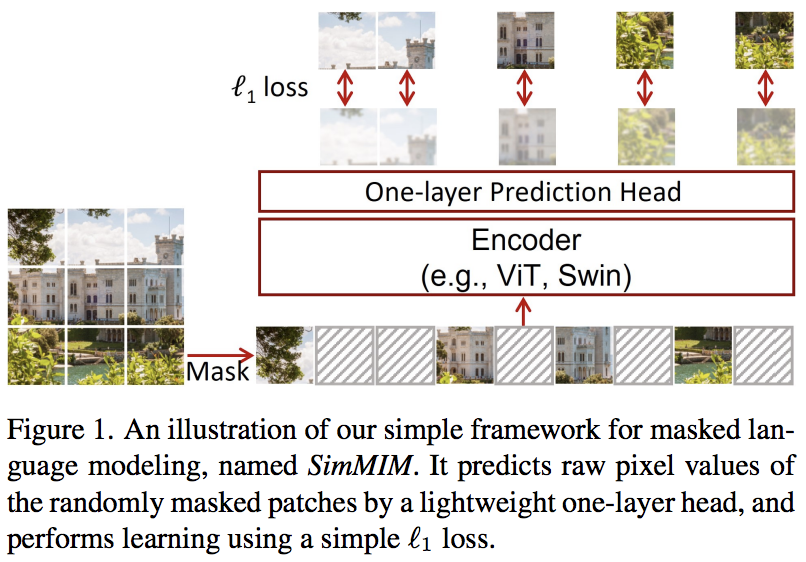

この論文では、マスクされたトークンからピクセル空間への線形投影のみを使用し、続いてマスクされたパッチのピクセル値による L1 損失を使用する、単純なマスクされたイメージ モデリング (SimMIM) スキームを提案します。結果は、他のより複雑なアプローチに匹敵します。

これは次のように使用できます

import torch

from vit_pytorch import ViT

from vit_pytorch . simmim import SimMIM

v = ViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 8 ,

mlp_dim = 2048

)

mim = SimMIM (

encoder = v ,

masking_ratio = 0.5 # they found 50% to yield the best results

)

images = torch . randn ( 8 , 3 , 256 , 256 )

loss = mim ( images )

loss . backward ()

# that's all!

# do the above in a for loop many times with a lot of images and your vision transformer will learn

torch . save ( v . state_dict (), './trained-vit.pt' )

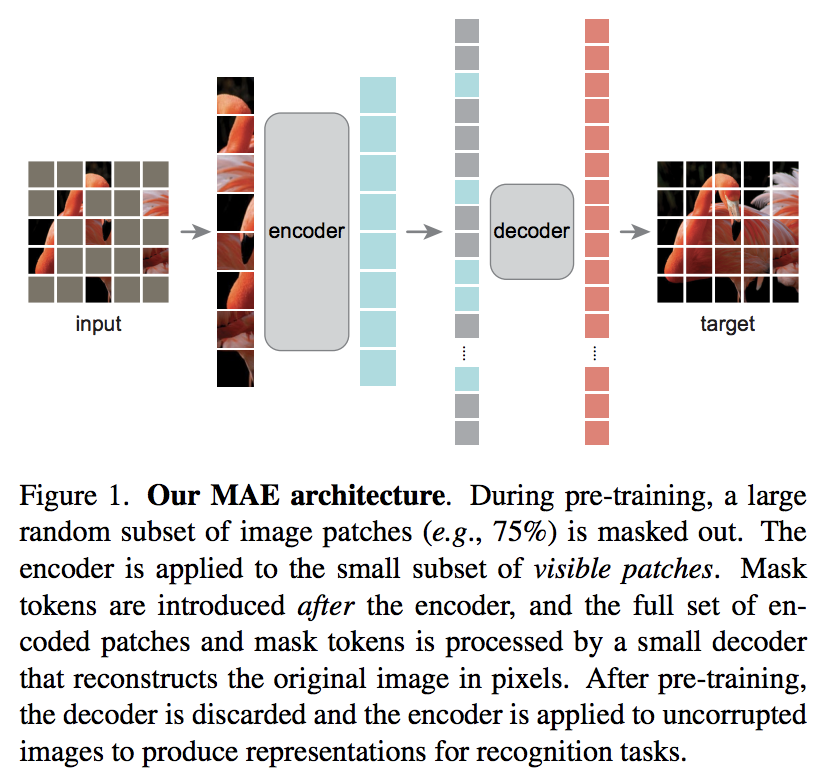

Kaiming He の新しい論文では、ビジョン トランスフォーマーがマスクされていないパッチのセットを処理し、より小さなデコーダーがマスクされたピクセル値の再構築を試みる単純なオートエンコーダー スキームを提案しています。

DeepReader の簡単な論文レビュー

レティシアとの AI コーヒーブレイク

次のコードで使用できます

import torch

from vit_pytorch import ViT , MAE

v = ViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 8 ,

mlp_dim = 2048

)

mae = MAE (

encoder = v ,

masking_ratio = 0.75 , # the paper recommended 75% masked patches

decoder_dim = 512 , # paper showed good results with just 512

decoder_depth = 6 # anywhere from 1 to 8

)

images = torch . randn ( 8 , 3 , 256 , 256 )

loss = mae ( images )

loss . backward ()

# that's all!

# do the above in a for loop many times with a lot of images and your vision transformer will learn

# save your improved vision transformer

torch . save ( v . state_dict (), './trained-vit.pt' )Zach のおかげで、次のコードを使用して、論文で紹介されているオリジナルのマスクされたパッチ予測タスクを使用してトレーニングできます。

import torch

from vit_pytorch import ViT

from vit_pytorch . mpp import MPP

model = ViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 8 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

mpp_trainer = MPP (

transformer = model ,

patch_size = 32 ,

dim = 1024 ,

mask_prob = 0.15 , # probability of using token in masked prediction task

random_patch_prob = 0.30 , # probability of randomly replacing a token being used for mpp

replace_prob = 0.50 , # probability of replacing a token being used for mpp with the mask token

)

opt = torch . optim . Adam ( mpp_trainer . parameters (), lr = 3e-4 )

def sample_unlabelled_images ():

return torch . FloatTensor ( 20 , 3 , 256 , 256 ). uniform_ ( 0. , 1. )

for _ in range ( 100 ):

images = sample_unlabelled_images ()

loss = mpp_trainer ( images )

opt . zero_grad ()

loss . backward ()

opt . step ()

# save your improved network

torch . save ( model . state_dict (), './pretrained-net.pt' )

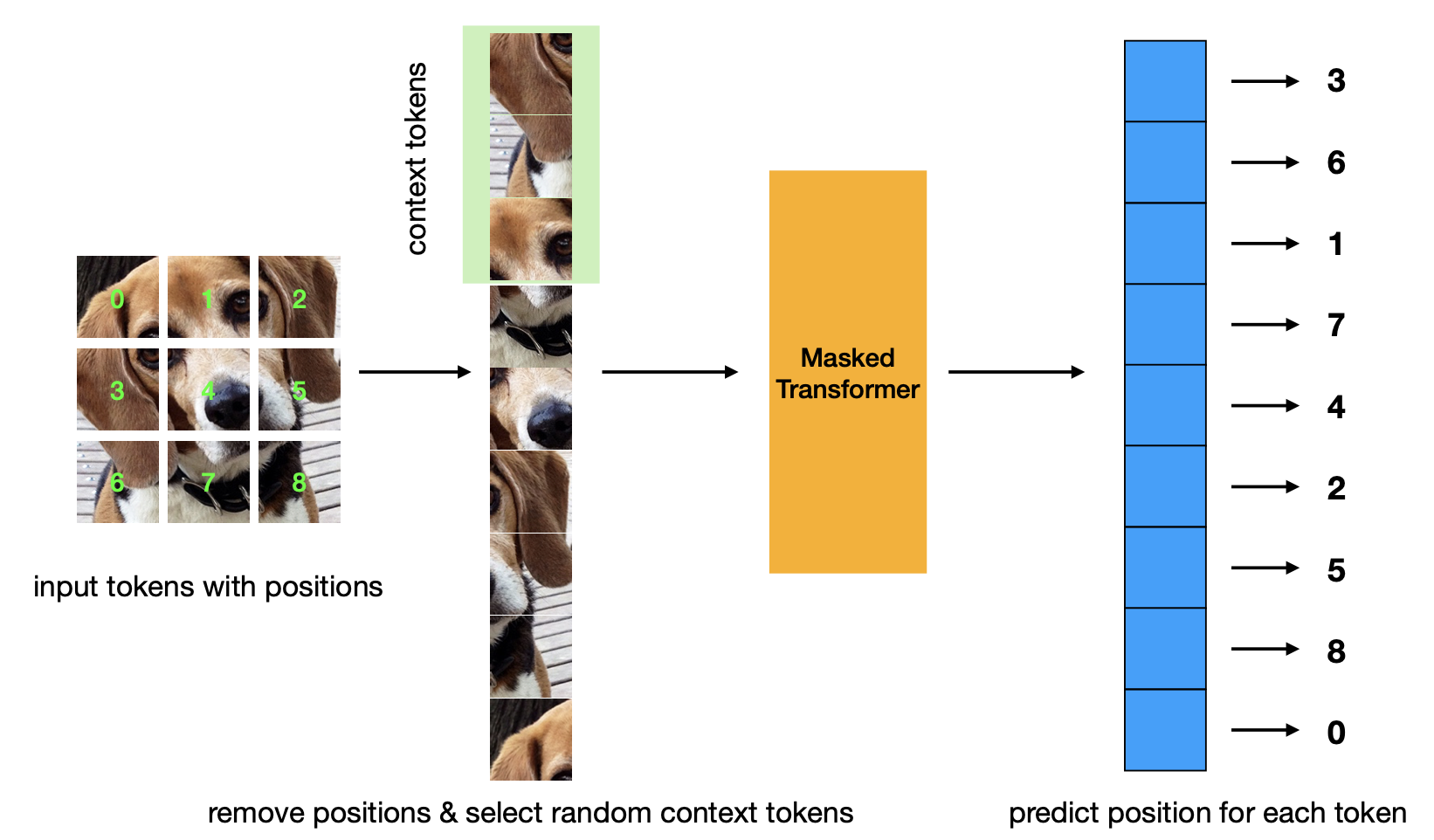

マスクされた位置予測の事前トレーニング基準を紹介する新しい論文。この戦略は、マスクされたオートエンコーダー戦略よりも効率的であり、同等のパフォーマンスを備えています。

import torch

from vit_pytorch . mp3 import ViT , MP3

v = ViT (

num_classes = 1000 ,

image_size = 256 ,

patch_size = 8 ,

dim = 1024 ,

depth = 6 ,

heads = 8 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

)

mp3 = MP3 (

vit = v ,

masking_ratio = 0.75

)

images = torch . randn ( 8 , 3 , 256 , 256 )

loss = mp3 ( images )

loss . backward ()

# that's all!

# do the above in a for loop many times with a lot of images and your vision transformer will learn

# save your improved vision transformer

torch . save ( v . state_dict (), './trained-vit.pt' )

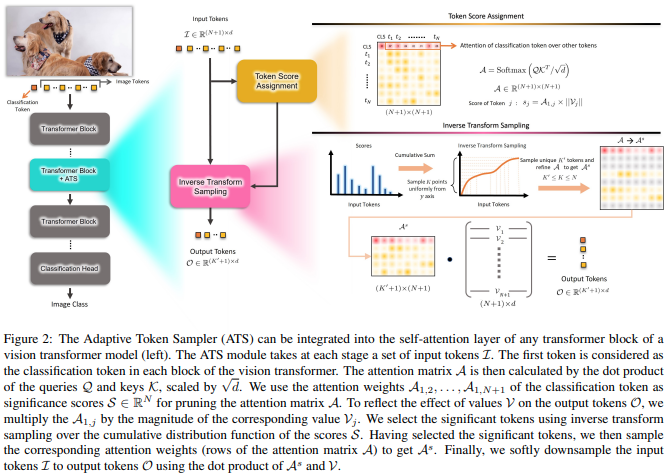

この論文は、異なる層で重要でないトークンを破棄する手段として、値ヘッドの基準によって再重み付けされた CLS アテンション スコアを使用することを提案します。

import torch

from vit_pytorch . ats_vit import ViT

v = ViT (

image_size = 256 ,

patch_size = 16 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

max_tokens_per_depth = ( 256 , 128 , 64 , 32 , 16 , 8 ), # a tuple that denotes the maximum number of tokens that any given layer should have. if the layer has greater than this amount, it will undergo adaptive token sampling

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

img = torch . randn ( 4 , 3 , 256 , 256 )

preds = v ( img ) # (4, 1000)

# you can also get a list of the final sampled patch ids

# a value of -1 denotes padding

preds , token_ids = v ( img , return_sampled_token_ids = True ) # (4, 1000), (4, <=8)

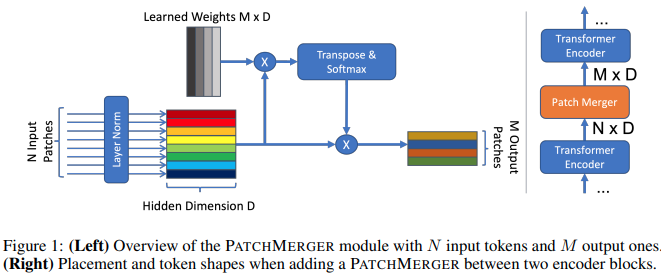

この論文では、パフォーマンスを犠牲にすることなくビジョン トランスフォーマーの任意の層でトークンの数を削減するための単純なモジュール (Patch Merger) を提案します。

import torch

from vit_pytorch . vit_with_patch_merger import ViT

v = ViT (

image_size = 256 ,

patch_size = 16 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 12 ,

heads = 8 ,

patch_merge_layer = 6 , # at which transformer layer to do patch merging

patch_merge_num_tokens = 8 , # the output number of tokens from the patch merge

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

img = torch . randn ( 4 , 3 , 256 , 256 )

preds = v ( img ) # (4, 1000) PatchMergerモジュールを単独で使用することもできます

import torch

from vit_pytorch . vit_with_patch_merger import PatchMerger

merger = PatchMerger (

dim = 1024 ,

num_tokens_out = 8 # output number of tokens

)

features = torch . randn ( 4 , 256 , 1024 ) # (batch, num tokens, dimension)

out = merger ( features ) # (4, 8, 1024)

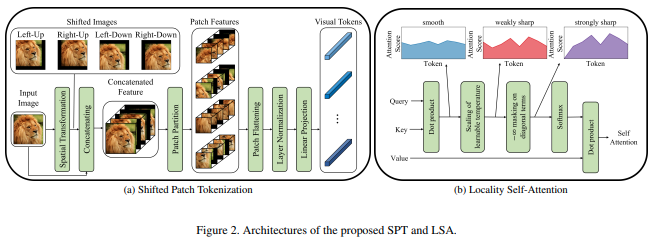

この論文では、画像を正規化してパッチに分割する前に、画像のシフトを組み込む新しい画像からパッチへの機能を提案します。他の変圧器の作業ではシフトが非常に役立つことがわかったので、さらなる調査のためにこれを含めることにしました。これには、学習された温度を含むLSAと、トークン自体への注目をマスクする機能も含まれます。

次のように使用できます。

import torch

from vit_pytorch . vit_for_small_dataset import ViT

v = ViT (

image_size = 256 ,

patch_size = 16 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

img = torch . randn ( 4 , 3 , 256 , 256 )

preds = v ( img ) # (1, 1000)このペーパーのSPTスタンドアロン モジュールとして使用することもできます。

import torch

from vit_pytorch . vit_for_small_dataset import SPT

spt = SPT (

dim = 1024 ,

patch_size = 16 ,

channels = 3

)

img = torch . randn ( 4 , 3 , 256 , 256 )

tokens = spt ( img ) # (4, 256, 1024) 多くのリクエストに応えて、ビデオや医療画像などで使用するために、このリポジトリ内のいくつかのアーキテクチャを 3D ViT に拡張し始める予定です。

2 つの追加ハイパーパラメータを渡す必要があります: (1) フレーム数framesと (2) フレーム次元に沿ったパッチ サイズframe_patch_size

まずは 3D ViT

import torch

from vit_pytorch . vit_3d import ViT

v = ViT (

image_size = 128 , # image size

frames = 16 , # number of frames

image_patch_size = 16 , # image patch size

frame_patch_size = 2 , # frame patch size

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 8 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

video = torch . randn ( 4 , 3 , 16 , 128 , 128 ) # (batch, channels, frames, height, width)

preds = v ( video ) # (4, 1000)3DシンプルViT

import torch

from vit_pytorch . simple_vit_3d import SimpleViT

v = SimpleViT (

image_size = 128 , # image size

frames = 16 , # number of frames

image_patch_size = 16 , # image patch size

frame_patch_size = 2 , # frame patch size

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 8 ,

mlp_dim = 2048

)

video = torch . randn ( 4 , 3 , 16 , 128 , 128 ) # (batch, channels, frames, height, width)

preds = v ( video ) # (4, 1000)CCTの3Dバージョン

import torch

from vit_pytorch . cct_3d import CCT

cct = CCT (

img_size = 224 ,

num_frames = 8 ,

embedding_dim = 384 ,

n_conv_layers = 2 ,

frame_kernel_size = 3 ,

kernel_size = 7 ,

stride = 2 ,

padding = 3 ,

pooling_kernel_size = 3 ,

pooling_stride = 2 ,

pooling_padding = 1 ,

num_layers = 14 ,

num_heads = 6 ,

mlp_ratio = 3. ,

num_classes = 1000 ,

positional_embedding = 'learnable'

)

video = torch . randn ( 1 , 3 , 8 , 224 , 224 ) # (batch, channels, frames, height, width)

pred = cct ( video )

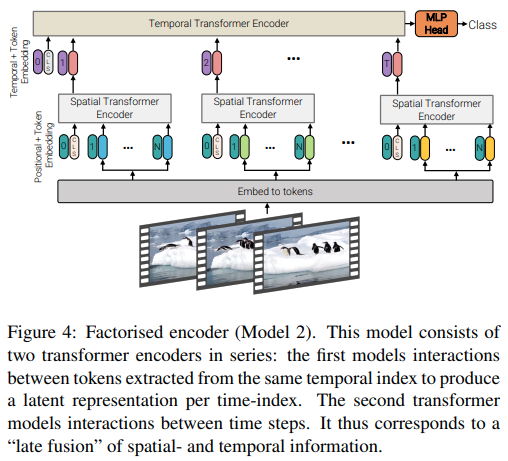

この論文では、ビデオの注目を効率的に高めるための 3 つの異なるタイプのアーキテクチャを提供します。主なテーマは、空間と時間を超えて注目を因数分解することです。このリポジトリには、因数分解されたエンコーダーと因数分解されたセルフアテンション バリアントが含まれています。因数分解されたエンコーダーのバリアントは、空間変換とそれに続く時間変換です。因数分解されたセルフ アテンション バリアントは、空間的および時間的セルフ アテンション レイヤーを交互に配置した時空間変換器です。

import torch

from vit_pytorch . vivit import ViT

v = ViT (

image_size = 128 , # image size

frames = 16 , # number of frames

image_patch_size = 16 , # image patch size

frame_patch_size = 2 , # frame patch size

num_classes = 1000 ,

dim = 1024 ,

spatial_depth = 6 , # depth of the spatial transformer

temporal_depth = 6 , # depth of the temporal transformer

heads = 8 ,

mlp_dim = 2048 ,

variant = 'factorized_encoder' , # or 'factorized_self_attention'

)

video = torch . randn ( 4 , 3 , 16 , 128 , 128 ) # (batch, channels, frames, height, width)

preds = v ( video ) # (4, 1000)

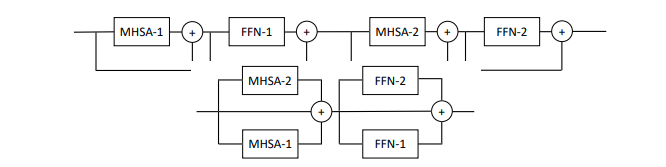

この論文では、層 (2 ブロック) ごとに複数のアテンション ブロックとフィードフォワード ブロックを並列化することを提案し、パフォーマンスを低下させることなくトレーニングが容易になると主張しています。

次のようにこのバリアントを試すことができます

import torch

from vit_pytorch . parallel_vit import ViT

v = ViT (

image_size = 256 ,

patch_size = 16 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 8 ,

mlp_dim = 2048 ,

num_parallel_branches = 2 , # in paper, they claimed 2 was optimal

dropout = 0.1 ,

emb_dropout = 0.1

)

img = torch . randn ( 4 , 3 , 256 , 256 )

preds = v ( img ) # (4, 1000)

この論文では、ビジョン トランスフォーマーの各層に学習可能なメモリ トークンを追加すると、(学習可能なタスク固有の CLS トークンとアダプター ヘッドに加えて) 微調整の結果が大幅に向上することが示されています。

次のように特別に変更したViTでこれを使用できます。

import torch

from vit_pytorch . learnable_memory_vit import ViT , Adapter

# normal base ViT

v = ViT (

image_size = 256 ,

patch_size = 16 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 8 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

img = torch . randn ( 4 , 3 , 256 , 256 )

logits = v ( img ) # (4, 1000)

# do your usual training with ViT

# ...

# then, to finetune, just pass the ViT into the Adapter class

# you can do this for multiple Adapters, as shown below

adapter1 = Adapter (

vit = v ,

num_classes = 2 , # number of output classes for this specific task

num_memories_per_layer = 5 # number of learnable memories per layer, 10 was sufficient in paper

)

logits1 = adapter1 ( img ) # (4, 2) - predict 2 classes off frozen ViT backbone with learnable memories and task specific head

# yet another task to finetune on, this time with 4 classes

adapter2 = Adapter (

vit = v ,

num_classes = 4 ,

num_memories_per_layer = 10

)

logits2 = adapter2 ( img ) # (4, 4) - predict 4 classes off frozen ViT backbone with learnable memories and task specific head

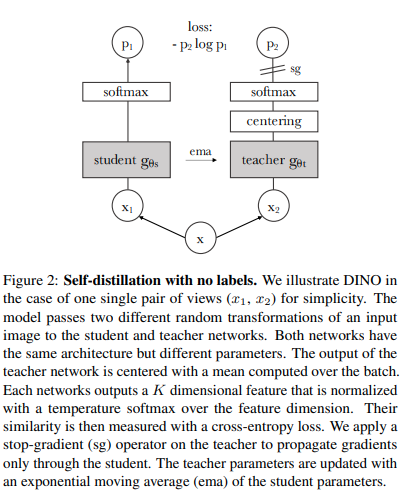

次のコードを使用すると、最新の SOTA 自己教師あり学習手法である Dino を使用してViTトレーニングできます。

ヤニック・キルチャーのビデオ

import torch

from vit_pytorch import ViT , Dino

model = ViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 8 ,

mlp_dim = 2048

)

learner = Dino (

model ,

image_size = 256 ,

hidden_layer = 'to_latent' , # hidden layer name or index, from which to extract the embedding

projection_hidden_size = 256 , # projector network hidden dimension

projection_layers = 4 , # number of layers in projection network

num_classes_K = 65336 , # output logits dimensions (referenced as K in paper)

student_temp = 0.9 , # student temperature

teacher_temp = 0.04 , # teacher temperature, needs to be annealed from 0.04 to 0.07 over 30 epochs

local_upper_crop_scale = 0.4 , # upper bound for local crop - 0.4 was recommended in the paper

global_lower_crop_scale = 0.5 , # lower bound for global crop - 0.5 was recommended in the paper

moving_average_decay = 0.9 , # moving average of encoder - paper showed anywhere from 0.9 to 0.999 was ok

center_moving_average_decay = 0.9 , # moving average of teacher centers - paper showed anywhere from 0.9 to 0.999 was ok

)

opt = torch . optim . Adam ( learner . parameters (), lr = 3e-4 )

def sample_unlabelled_images ():

return torch . randn ( 20 , 3 , 256 , 256 )

for _ in range ( 100 ):

images = sample_unlabelled_images ()

loss = learner ( images )

opt . zero_grad ()

loss . backward ()

opt . step ()

learner . update_moving_average () # update moving average of teacher encoder and teacher centers

# save your improved network

torch . save ( model . state_dict (), './pretrained-net.pt' )

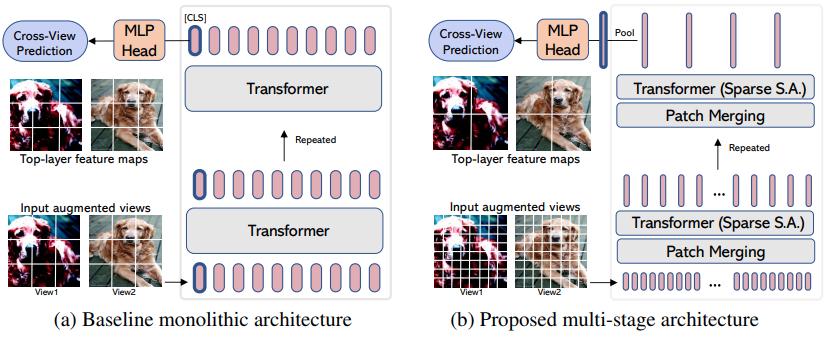

EsViT 、拡張ビュー間の追加の領域損失を考慮して、パッチのマージ/ダウンサンプリングを使用して効率的なViTをサポートするように再設計された (上記の) Dino のバリアントです。要約を引用すると、 outperforms its supervised counterpart on 17 out of 18 datasets 。

あたかも新しいViTバリアントであるかのように名前が付けられていますが、実際には、多段階のViTトレーニングするための戦略にすぎません (論文では Swin に焦点を当てています)。以下の例は、 CvTでそれを使用する方法を示しています。グローバル プーリングとロジットへの射影の直前に、非平均プール視覚表現を出力する効率的な ViT 内のレイヤーの名前にhidden_layer layer を設定する必要があります。

import torch

from vit_pytorch . cvt import CvT

from vit_pytorch . es_vit import EsViTTrainer

cvt = CvT (

num_classes = 1000 ,

s1_emb_dim = 64 ,

s1_emb_kernel = 7 ,

s1_emb_stride = 4 ,

s1_proj_kernel = 3 ,

s1_kv_proj_stride = 2 ,

s1_heads = 1 ,

s1_depth = 1 ,

s1_mlp_mult = 4 ,

s2_emb_dim = 192 ,

s2_emb_kernel = 3 ,

s2_emb_stride = 2 ,

s2_proj_kernel = 3 ,

s2_kv_proj_stride = 2 ,

s2_heads = 3 ,

s2_depth = 2 ,

s2_mlp_mult = 4 ,

s3_emb_dim = 384 ,

s3_emb_kernel = 3 ,

s3_emb_stride = 2 ,

s3_proj_kernel = 3 ,

s3_kv_proj_stride = 2 ,

s3_heads = 4 ,

s3_depth = 10 ,

s3_mlp_mult = 4 ,

dropout = 0.

)

learner = EsViTTrainer (

cvt ,

image_size = 256 ,

hidden_layer = 'layers' , # hidden layer name or index, from which to extract the embedding

projection_hidden_size = 256 , # projector network hidden dimension

projection_layers = 4 , # number of layers in projection network

num_classes_K = 65336 , # output logits dimensions (referenced as K in paper)

student_temp = 0.9 , # student temperature

teacher_temp = 0.04 , # teacher temperature, needs to be annealed from 0.04 to 0.07 over 30 epochs

local_upper_crop_scale = 0.4 , # upper bound for local crop - 0.4 was recommended in the paper

global_lower_crop_scale = 0.5 , # lower bound for global crop - 0.5 was recommended in the paper

moving_average_decay = 0.9 , # moving average of encoder - paper showed anywhere from 0.9 to 0.999 was ok

center_moving_average_decay = 0.9 , # moving average of teacher centers - paper showed anywhere from 0.9 to 0.999 was ok

)

opt = torch . optim . AdamW ( learner . parameters (), lr = 3e-4 )

def sample_unlabelled_images ():

return torch . randn ( 8 , 3 , 256 , 256 )

for _ in range ( 1000 ):

images = sample_unlabelled_images ()

loss = learner ( images )

opt . zero_grad ()

loss . backward ()

opt . step ()

learner . update_moving_average () # update moving average of teacher encoder and teacher centers

# save your improved network

torch . save ( cvt . state_dict (), './pretrained-net.pt' )研究のアテンションの重み (ソフトマックス後) を視覚化したい場合は、以下の手順に従ってください。

import torch

from vit_pytorch . vit import ViT

v = ViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

# import Recorder and wrap the ViT

from vit_pytorch . recorder import Recorder

v = Recorder ( v )

# forward pass now returns predictions and the attention maps

img = torch . randn ( 1 , 3 , 256 , 256 )

preds , attns = v ( img )

# there is one extra patch due to the CLS token

attns # (1, 6, 16, 65, 65) - (batch x layers x heads x patch x patch)十分なデータを収集したら、クラスとフックをクリーンアップします。

v = v . eject () # wrapper is discarded and original ViT instance is returned 同様に、 Extractorラッパーを使用して埋め込みにアクセスできます。

import torch

from vit_pytorch . vit import ViT

v = ViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

# import Recorder and wrap the ViT

from vit_pytorch . extractor import Extractor

v = Extractor ( v )

# forward pass now returns predictions and the attention maps

img = torch . randn ( 1 , 3 , 256 , 256 )

logits , embeddings = v ( img )

# there is one extra token due to the CLS token

embeddings # (1, 65, 1024) - (batch x patches x model dim)または、 CrossViTの場合は、「大」スケールと「小」スケールの 2 セットのエンベディングを出力するマルチスケール エンコーダーを備えています。

import torch

from vit_pytorch . cross_vit import CrossViT

v = CrossViT (

image_size = 256 ,

num_classes = 1000 ,

depth = 4 ,

sm_dim = 192 ,

sm_patch_size = 16 ,

sm_enc_depth = 2 ,

sm_enc_heads = 8 ,

sm_enc_mlp_dim = 2048 ,

lg_dim = 384 ,

lg_patch_size = 64 ,

lg_enc_depth = 3 ,

lg_enc_heads = 8 ,

lg_enc_mlp_dim = 2048 ,

cross_attn_depth = 2 ,

cross_attn_heads = 8 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

# wrap the CrossViT

from vit_pytorch . extractor import Extractor

v = Extractor ( v , layer_name = 'multi_scale_encoder' ) # take embedding coming from the output of multi-scale-encoder

# forward pass now returns predictions and the attention maps

img = torch . randn ( 1 , 3 , 256 , 256 )

logits , embeddings = v ( img )

# there is one extra token due to the CLS token

embeddings # ((1, 257, 192), (1, 17, 384)) - (batch x patches x dimension) <- large and small scales respectively コンピューター ビジョンの出身者の中には、注意力が依然として 2 次コストに悩まされていると考える人もいるかもしれません。幸いなことに、役立つ可能性のある新しいテクニックがたくさんあります。このリポジトリは、独自のスパース アテンション トランスフォーマーをプラグインする方法を提供します。

Nystromformer を使用した例

$ pip install nystrom-attention import torch

from vit_pytorch . efficient import ViT

from nystrom_attention import Nystromformer

efficient_transformer = Nystromformer (

dim = 512 ,

depth = 12 ,

heads = 8 ,

num_landmarks = 256

)

v = ViT (

dim = 512 ,

image_size = 2048 ,

patch_size = 32 ,

num_classes = 1000 ,

transformer = efficient_transformer

)

img = torch . randn ( 1 , 3 , 2048 , 2048 ) # your high resolution picture

v ( img ) # (1, 1000)私が強くお勧めする他のスパース アテンション フレームワークは、Routing Transformer または Sinkhorn Transformer です。

この論文では、声明を発表するために、最も平凡な注目ネットワークを意図的に使用しました。アテンション ネットの最新の改善点を使用したい場合は、このリポジトリのEncoderを使用してください。

元。

$ pip install x-transformers import torch

from vit_pytorch . efficient import ViT

from x_transformers import Encoder

v = ViT (

dim = 512 ,

image_size = 224 ,

patch_size = 16 ,

num_classes = 1000 ,

transformer = Encoder (

dim = 512 , # set to be the same as the wrapper

depth = 12 ,

heads = 8 ,

ff_glu = True , # ex. feed forward GLU variant https://arxiv.org/abs/2002.05202

residual_attn = True # ex. residual attention https://arxiv.org/abs/2012.11747

)

)

img = torch . randn ( 1 , 3 , 224 , 224 )

v ( img ) # (1, 1000) 非正方形の画像を渡すことはすでに可能です。必要なのは、高さと幅がimage_size以下で、両方ともpatch_sizeで割り切れることを確認することだけです。

元。

import torch

from vit_pytorch import ViT

v = ViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

img = torch . randn ( 1 , 3 , 256 , 128 ) # <-- not a square

preds = v ( img ) # (1, 1000) import torch

from vit_pytorch import ViT

v = ViT (

num_classes = 1000 ,

image_size = ( 256 , 128 ), # image size is a tuple of (height, width)

patch_size = ( 32 , 16 ), # patch size is a tuple of (height, width)

dim = 1024 ,

depth = 6 ,

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

img = torch . randn ( 1 , 3 , 256 , 128 )

preds = v ( img )コンピューター ビジョン出身で、トランスフォーマーは初めてですか?私の学習を大幅に加速してくれたリソースをいくつか紹介します。

イラスト付きトランスフォーマー - ジェイ・アランマー

ゼロからのトランスフォーマー - ピーター・ブルーム

注釈付きトランスフォーマー - ハーバード NLP

@article { hassani2021escaping ,

title = { Escaping the Big Data Paradigm with Compact Transformers } ,

author = { Ali Hassani and Steven Walton and Nikhil Shah and Abulikemu Abuduweili and Jiachen Li and Humphrey Shi } ,

year = 2021 ,

url = { https://arxiv.org/abs/2104.05704 } ,

eprint = { 2104.05704 } ,

archiveprefix = { arXiv } ,

primaryclass = { cs.CV }

} @misc { dosovitskiy2020image ,

title = { An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale } ,

author = { Alexey Dosovitskiy and Lucas Beyer and Alexander Kolesnikov and Dirk Weissenborn and Xiaohua Zhai and Thomas Unterthiner and Mostafa Dehghani and Matthias Minderer and Georg Heigold and Sylvain Gelly and Jakob Uszkoreit and Neil Houlsby } ,

year = { 2020 } ,

eprint = { 2010.11929 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { touvron2020training ,

title = { Training data-efficient image transformers & distillation through attention } ,

author = { Hugo Touvron and Matthieu Cord and Matthijs Douze and Francisco Massa and Alexandre Sablayrolles and Hervé Jégou } ,

year = { 2020 } ,

eprint = { 2012.12877 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { yuan2021tokenstotoken ,

title = { Tokens-to-Token ViT: Training Vision Transformers from Scratch on ImageNet } ,

author = { Li Yuan and Yunpeng Chen and Tao Wang and Weihao Yu and Yujun Shi and Francis EH Tay and Jiashi Feng and Shuicheng Yan } ,

year = { 2021 } ,

eprint = { 2101.11986 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { zhou2021deepvit ,

title = { DeepViT: Towards Deeper Vision Transformer } ,

author = { Daquan Zhou and Bingyi Kang and Xiaojie Jin and Linjie Yang and Xiaochen Lian and Qibin Hou and Jiashi Feng } ,

year = { 2021 } ,

eprint = { 2103.11886 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { touvron2021going ,

title = { Going deeper with Image Transformers } ,

author = { Hugo Touvron and Matthieu Cord and Alexandre Sablayrolles and Gabriel Synnaeve and Hervé Jégou } ,

year = { 2021 } ,

eprint = { 2103.17239 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { chen2021crossvit ,

title = { CrossViT: Cross-Attention Multi-Scale Vision Transformer for Image Classification } ,

author = { Chun-Fu Chen and Quanfu Fan and Rameswar Panda } ,

year = { 2021 } ,

eprint = { 2103.14899 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { wu2021cvt ,

title = { CvT: Introducing Convolutions to Vision Transformers } ,

author = { Haiping Wu and Bin Xiao and Noel Codella and Mengchen Liu and Xiyang Dai and Lu Yuan and Lei Zhang } ,

year = { 2021 } ,

eprint = { 2103.15808 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { heo2021rethinking ,

title = { Rethinking Spatial Dimensions of Vision Transformers } ,

author = { Byeongho Heo and Sangdoo Yun and Dongyoon Han and Sanghyuk Chun and Junsuk Choe and Seong Joon Oh } ,

year = { 2021 } ,

eprint = { 2103.16302 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { graham2021levit ,

title = { LeViT: a Vision Transformer in ConvNet's Clothing for Faster Inference } ,

author = { Ben Graham and Alaaeldin El-Nouby and Hugo Touvron and Pierre Stock and Armand Joulin and Hervé Jégou and Matthijs Douze } ,

year = { 2021 } ,

eprint = { 2104.01136 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { li2021localvit ,

title = { LocalViT: Bringing Locality to Vision Transformers } ,

author = { Yawei Li and Kai Zhang and Jiezhang Cao and Radu Timofte and Luc Van Gool } ,

year = { 2021 } ,

eprint = { 2104.05707 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { chu2021twins ,

title = { Twins: Revisiting Spatial Attention Design in Vision Transformers } ,

author = { Xiangxiang Chu and Zhi Tian and Yuqing Wang and Bo Zhang and Haibing Ren and Xiaolin Wei and Huaxia Xia and Chunhua Shen } ,

year = { 2021 } ,

eprint = { 2104.13840 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { su2021roformer ,

title = { RoFormer: Enhanced Transformer with Rotary Position Embedding } ,

author = { Jianlin Su and Yu Lu and Shengfeng Pan and Bo Wen and Yunfeng Liu } ,

year = { 2021 } ,

eprint = { 2104.09864 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CL }

} @misc { zhang2021aggregating ,

title = { Aggregating Nested Transformers } ,

author = { Zizhao Zhang and Han Zhang and Long Zhao and Ting Chen and Tomas Pfister } ,

year = { 2021 } ,

eprint = { 2105.12723 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { chen2021regionvit ,

title = { RegionViT: Regional-to-Local Attention for Vision Transformers } ,

author = { Chun-Fu Chen and Rameswar Panda and Quanfu Fan } ,

year = { 2021 } ,

eprint = { 2106.02689 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { wang2021crossformer ,

title = { CrossFormer: A Versatile Vision Transformer Hinging on Cross-scale Attention } ,

author = { Wenxiao Wang and Lu Yao and Long Chen and Binbin Lin and Deng Cai and Xiaofei He and Wei Liu } ,

year = { 2021 } ,

eprint = { 2108.00154 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { caron2021emerging ,

title = { Emerging Properties in Self-Supervised Vision Transformers } ,

author = { Mathilde Caron and Hugo Touvron and Ishan Misra and Hervé Jégou and Julien Mairal and Piotr Bojanowski and Armand Joulin } ,

year = { 2021 } ,

eprint = { 2104.14294 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { he2021masked ,

title = { Masked Autoencoders Are Scalable Vision Learners } ,

author = { Kaiming He and Xinlei Chen and Saining Xie and Yanghao Li and Piotr Dollár and Ross Girshick } ,

year = { 2021 } ,

eprint = { 2111.06377 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { xie2021simmim ,

title = { SimMIM: A Simple Framework for Masked Image Modeling } ,

author = { Zhenda Xie and Zheng Zhang and Yue Cao and Yutong Lin and Jianmin Bao and Zhuliang Yao and Qi Dai and Han Hu } ,

year = { 2021 } ,

eprint = { 2111.09886 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { fayyaz2021ats ,

title = { ATS: Adaptive Token Sampling For Efficient Vision Transformers } ,

author = { Mohsen Fayyaz and Soroush Abbasi Kouhpayegani and Farnoush Rezaei Jafari and Eric Sommerlade and Hamid Reza Vaezi Joze and Hamed Pirsiavash and Juergen Gall } ,

year = { 2021 } ,

eprint = { 2111.15667 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { mehta2021mobilevit ,

title = { MobileViT: Light-weight, General-purpose, and Mobile-friendly Vision Transformer } ,

author = { Sachin Mehta and Mohammad Rastegari } ,

year = { 2021 } ,

eprint = { 2110.02178 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { lee2021vision ,

title = { Vision Transformer for Small-Size Datasets } ,

author = { Seung Hoon Lee and Seunghyun Lee and Byung Cheol Song } ,

year = { 2021 } ,

eprint = { 2112.13492 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { renggli2022learning ,

title = { Learning to Merge Tokens in Vision Transformers } ,

author = { Cedric Renggli and André Susano Pinto and Neil Houlsby and Basil Mustafa and Joan Puigcerver and Carlos Riquelme } ,

year = { 2022 } ,

eprint = { 2202.12015 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { yang2022scalablevit ,

title = { ScalableViT: Rethinking the Context-oriented Generalization of Vision Transformer } ,

author = { Rui Yang and Hailong Ma and Jie Wu and Yansong Tang and Xuefeng Xiao and Min Zheng and Xiu Li } ,

year = { 2022 } ,

eprint = { 2203.10790 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @inproceedings { Touvron2022ThreeTE ,

title = { Three things everyone should know about Vision Transformers } ,

author = { Hugo Touvron and Matthieu Cord and Alaaeldin El-Nouby and Jakob Verbeek and Herv'e J'egou } ,

year = { 2022 }

} @inproceedings { Sandler2022FinetuningIT ,

title = { Fine-tuning Image Transformers using Learnable Memory } ,

author = { Mark Sandler and Andrey Zhmoginov and Max Vladymyrov and Andrew Jackson } ,

year = { 2022 }

} @inproceedings { Li2022SepViTSV ,

title = { SepViT: Separable Vision Transformer } ,

author = { Wei Li and Xing Wang and Xin Xia and Jie Wu and Xuefeng Xiao and Minghang Zheng and Shiping Wen } ,

year = { 2022 }

} @inproceedings { Tu2022MaxViTMV ,

title = { MaxViT: Multi-Axis Vision Transformer } ,

author = { Zhengzhong Tu and Hossein Talebi and Han Zhang and Feng Yang and Peyman Milanfar and Alan Conrad Bovik and Yinxiao Li } ,

year = { 2022 }

} @article { Li2021EfficientSV ,

title = { Efficient Self-supervised Vision Transformers for Representation Learning } ,

author = { Chunyuan Li and Jianwei Yang and Pengchuan Zhang and Mei Gao and Bin Xiao and Xiyang Dai and Lu Yuan and Jianfeng Gao } ,

journal = { ArXiv } ,

year = { 2021 } ,

volume = { abs/2106.09785 }

} @misc { Beyer2022BetterPlainViT

title = { Better plain ViT baselines for ImageNet-1k } ,

author = { Beyer, Lucas and Zhai, Xiaohua and Kolesnikov, Alexander } ,

publisher = { arXiv } ,

year = { 2022 }

}

@article { Arnab2021ViViTAV ,

title = { ViViT: A Video Vision Transformer } ,

author = { Anurag Arnab and Mostafa Dehghani and Georg Heigold and Chen Sun and Mario Lucic and Cordelia Schmid } ,

journal = { 2021 IEEE/CVF International Conference on Computer Vision (ICCV) } ,

year = { 2021 } ,

pages = { 6816-6826 }

} @article { Liu2022PatchDropoutEV ,

title = { PatchDropout: Economizing Vision Transformers Using Patch Dropout } ,

author = { Yue Liu and Christos Matsoukas and Fredrik Strand and Hossein Azizpour and Kevin Smith } ,

journal = { ArXiv } ,

year = { 2022 } ,

volume = { abs/2208.07220 }

} @misc { https://doi.org/10.48550/arxiv.2302.01327 ,

doi = { 10.48550/ARXIV.2302.01327 } ,

url = { https://arxiv.org/abs/2302.01327 } ,

author = { Kumar, Manoj and Dehghani, Mostafa and Houlsby, Neil } ,

title = { Dual PatchNorm } ,

publisher = { arXiv } ,

year = { 2023 } ,

copyright = { Creative Commons Attribution 4.0 International }

} @inproceedings { Dehghani2023PatchNP ,

title = { Patch n' Pack: NaViT, a Vision Transformer for any Aspect Ratio and Resolution } ,

author = { Mostafa Dehghani and Basil Mustafa and Josip Djolonga and Jonathan Heek and Matthias Minderer and Mathilde Caron and Andreas Steiner and Joan Puigcerver and Robert Geirhos and Ibrahim M. Alabdulmohsin and Avital Oliver and Piotr Padlewski and Alexey A. Gritsenko and Mario Luvci'c and Neil Houlsby } ,

year = { 2023 }

} @misc { vaswani2017attention ,

title = { Attention Is All You Need } ,

author = { Ashish Vaswani and Noam Shazeer and Niki Parmar and Jakob Uszkoreit and Llion Jones and Aidan N. Gomez and Lukasz Kaiser and Illia Polosukhin } ,

year = { 2017 } ,

eprint = { 1706.03762 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CL }

} @inproceedings { dao2022flashattention ,

title = { Flash{A}ttention: Fast and Memory-Efficient Exact Attention with {IO}-Awareness } ,

author = { Dao, Tri and Fu, Daniel Y. and Ermon, Stefano and Rudra, Atri and R{'e}, Christopher } ,

booktitle = { Advances in Neural Information Processing Systems } ,

year = { 2022 }

} @inproceedings { Darcet2023VisionTN ,

title = { Vision Transformers Need Registers } ,

author = { Timoth'ee Darcet and Maxime Oquab and Julien Mairal and Piotr Bojanowski } ,

year = { 2023 } ,

url = { https://api.semanticscholar.org/CorpusID:263134283 }

} @inproceedings { ElNouby2021XCiTCI ,

title = { XCiT: Cross-Covariance Image Transformers } ,

author = { Alaaeldin El-Nouby and Hugo Touvron and Mathilde Caron and Piotr Bojanowski and Matthijs Douze and Armand Joulin and Ivan Laptev and Natalia Neverova and Gabriel Synnaeve and Jakob Verbeek and Herv{'e} J{'e}gou } ,

booktitle = { Neural Information Processing Systems } ,

year = { 2021 } ,

url = { https://api.semanticscholar.org/CorpusID:235458262 }

} @inproceedings { Koner2024LookupViTCV ,

title = { LookupViT: Compressing visual information to a limited number of tokens } ,

author = { Rajat Koner and Gagan Jain and Prateek Jain and Volker Tresp and Sujoy Paul } ,

year = { 2024 } ,

url = { https://api.semanticscholar.org/CorpusID:271244592 }

} @article { Bao2022AllAW ,

title = { All are Worth Words: A ViT Backbone for Diffusion Models } ,

author = { Fan Bao and Shen Nie and Kaiwen Xue and Yue Cao and Chongxuan Li and Hang Su and Jun Zhu } ,

journal = { 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

year = { 2022 } ,

pages = { 22669-22679 } ,

url = { https://api.semanticscholar.org/CorpusID:253581703 }

} @misc { Rubin2024 ,

author = { Ohad Rubin } ,

url = { https://medium.com/ @ ohadrubin/exploring-weight-decay-in-layer-normalization-challenges-and-a-reparameterization-solution-ad4d12c24950 }

} @inproceedings { Loshchilov2024nGPTNT ,

title = { nGPT: Normalized Transformer with Representation Learning on the Hypersphere } ,

author = { Ilya Loshchilov and Cheng-Ping Hsieh and Simeng Sun and Boris Ginsburg } ,

year = { 2024 } ,

url = { https://api.semanticscholar.org/CorpusID:273026160 }

} @inproceedings { Liu2017DeepHL ,

title = { Deep Hyperspherical Learning } ,

author = { Weiyang Liu and Yanming Zhang and Xingguo Li and Zhen Liu and Bo Dai and Tuo Zhao and Le Song } ,

booktitle = { Neural Information Processing Systems } ,

year = { 2017 } ,

url = { https://api.semanticscholar.org/CorpusID:5104558 }

} @inproceedings { Zhou2024ValueRL ,

title = { Value Residual Learning For Alleviating Attention Concentration In Transformers } ,

author = { Zhanchao Zhou and Tianyi Wu and Zhiyun Jiang and Zhenzhong Lan } ,

year = { 2024 } ,

url = { https://api.semanticscholar.org/CorpusID:273532030 }

} @article { Zhu2024HyperConnections ,

title = { Hyper-Connections } ,

author = { Defa Zhu and Hongzhi Huang and Zihao Huang and Yutao Zeng and Yunyao Mao and Banggu Wu and Qiyang Min and Xun Zhou } ,

journal = { ArXiv } ,

year = { 2024 } ,

volume = { abs/2409.19606 } ,

url = { https://api.semanticscholar.org/CorpusID:272987528 }

}私は人間にとって犬がロボットにとってのような存在になる時代を想像しており、私は機械を応援しています。 — クロード・シャノン