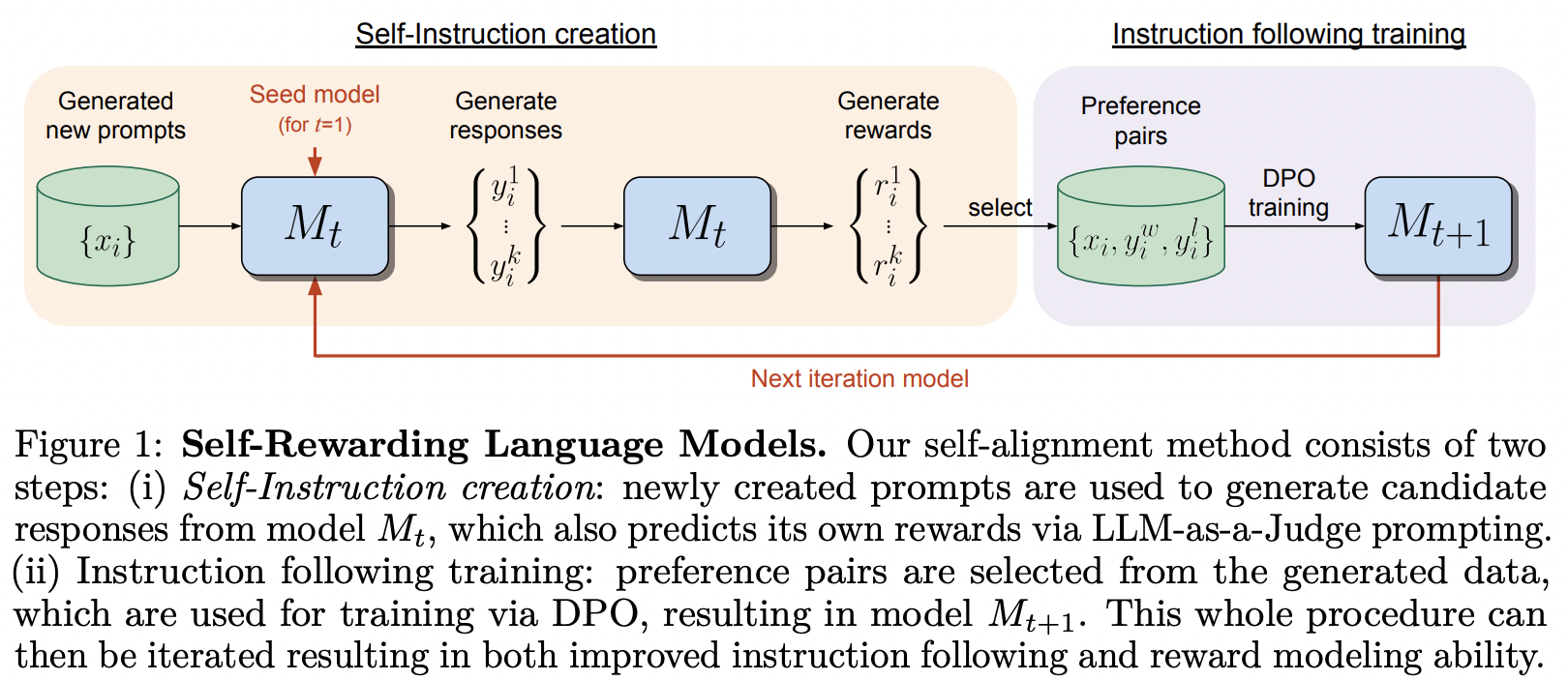

MetaAI による Self-Rewarding Language Model で提案されているトレーニング フレームワークの実装

彼らは DPO の論文のタイトルを真剣に受け止めました。

このライブラリには、Nous Research の Teknium が楽観的な見方を示している SPIN の実装も含まれています。

$ pip install self-rewarding-lm-pytorch import torch

from torch import Tensor

from self_rewarding_lm_pytorch import (

SelfRewardingTrainer ,

create_mock_dataset

)

from x_transformers import TransformerWrapper , Decoder

transformer = TransformerWrapper (

num_tokens = 256 ,

max_seq_len = 1024 ,

attn_layers = Decoder (

dim = 512 ,

depth = 1 ,

heads = 8

)

)

sft_dataset = create_mock_dataset ( 100 , lambda : ( torch . randint ( 0 , 256 , ( 256 ,)), torch . tensor ( 1 )))

prompt_dataset = create_mock_dataset ( 100 , lambda : 'mock prompt' )

def decode_tokens ( tokens : Tensor ) -> str :

decode_token = lambda token : str ( chr ( max ( 32 , token )))

return '' . join ( list ( map ( decode_token , tokens )))

def encode_str ( seq_str : str ) -> Tensor :

return Tensor ( list ( map ( ord , seq_str )))

trainer = SelfRewardingTrainer (

transformer ,

finetune_configs = dict (

train_sft_dataset = sft_dataset ,

self_reward_prompt_dataset = prompt_dataset ,

dpo_num_train_steps = 1000

),

tokenizer_decode = decode_tokens ,

tokenizer_encode = encode_str ,

accelerate_kwargs = dict (

cpu = True

)

)

trainer ( overwrite_checkpoints = True )

# checkpoints after each finetuning stage will be saved to ./checkpointsSPIN は次のようにトレーニングできます。Readme の最後の例に示されているように、微調整パイプラインに追加することもできます。

import torch

from self_rewarding_lm_pytorch import (

SPINTrainer ,

create_mock_dataset

)

from x_transformers import TransformerWrapper , Decoder

transformer = TransformerWrapper (

num_tokens = 256 ,

max_seq_len = 1024 ,

attn_layers = Decoder (

dim = 512 ,

depth = 6 ,

heads = 8

)

)

sft_dataset = create_mock_dataset ( 100 , lambda : ( torch . randint ( 0 , 256 , ( 256 ,)), torch . tensor ( 1 )))

spin_trainer = SPINTrainer (

transformer ,

max_seq_len = 16 ,

train_sft_dataset = sft_dataset ,

checkpoint_every = 100 ,

spin_kwargs = dict (

λ = 0.1 ,

),

)

spin_trainer ()独自の報酬プロンプト (LLM-as-Judge 以外) を実験したいとします。まずRewardConfigインポートし、次にそれをreward_prompt_configとしてトレーナーに渡す必要があります。

# first import

from self_rewarding_lm_pytorch import RewardConfig

# then say you want to try asking the transformer nicely

# reward_regex_template is the string that will be looked for in the LLM response, for parsing out the reward where {{ reward }} is defined as a number

trainer = SelfRewardingTrainer (

transformer ,

...,

self_reward_prompt_config = RewardConfig (

prompt_template = """

Pretty please rate the following user prompt and response

User: {{ prompt }}

Response: {{ response }}

Format your score as follows:

Rating: <rating as integer from 0 - 10>

""" ,

reward_regex_template = """

Rating: {{ reward }}

"""

)

)最後に、任意の順序で微調整を試したい場合は、 FinetuneConfigインスタンスをリストとしてfinetune_configsに渡すことで、その柔軟性も得られます。

元。 SPIN、外部報酬、自己報酬のインターリーブに関する研究を実施したいとします

このアイデアは、Teknium のプライベート Discord チャンネルから生まれました。

# import the configs

from self_rewarding_lm_pytorch import (

SFTConfig ,

SelfRewardDPOConfig ,

ExternalRewardDPOConfig ,

SelfPlayConfig ,

)

trainer = SelfRewardingTrainer (

model ,

finetune_configs = [

SFTConfig (...),

SelfPlayConfig (...),

ExternalRewardDPOConfig (...),

SelfRewardDPOConfig (...),

SelfPlayConfig (...),

SelfRewardDPOConfig (...)

],

...

)

trainer ()

# checkpoints after each finetuning stage will be saved to ./checkpoints バッチ内のさまざまな位置でサンプリングを進行できるようにサンプリングを一般化し、バッチ化されるすべてのサンプリングを修正します。一部の人々がそれを可能にする相対位置を持つトランスフォーマーを持っている場合に備えて、左に埋められたシーケンスも許可します。

イオスを処理する

デフォルトの llm-as-judge の代わりに独自の報酬プロンプトを使用する例を示します。

ペアをサンプリングするためのさまざまな戦略を可能にする

アーリーストッパー

sft、スピン、自己報酬 dpo、外部報酬モデルを使用した dpo の任意の順序

報酬の検証関数を許可します (報酬は整数、浮動小数点、ある範囲内である必要があるなど)

KV キャッシュのさまざまな影響を処理する最善の方法を考え出します。今のところは何もせずに実行します。

すべてのチェックポイント フォルダーを自動クリアする環境フラグ

@misc { yuan2024selfrewarding ,

title = { Self-Rewarding Language Models } ,

author = { Weizhe Yuan and Richard Yuanzhe Pang and Kyunghyun Cho and Sainbayar Sukhbaatar and Jing Xu and Jason Weston } ,

year = { 2024 } ,

eprint = { 2401.10020 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CL }

} @article { Chen2024SelfPlayFC ,

title = { Self-Play Fine-Tuning Converts Weak Language Models to Strong Language Models } ,

author = { Zixiang Chen and Yihe Deng and Huizhuo Yuan and Kaixuan Ji and Quanquan Gu } ,

journal = { ArXiv } ,

year = { 2024 } ,

volume = { abs/2401.01335 } ,

url = { https://api.semanticscholar.org/CorpusID:266725672 }

} @article { Rafailov2023DirectPO ,

title = { Direct Preference Optimization: Your Language Model is Secretly a Reward Model } ,

author = { Rafael Rafailov and Archit Sharma and Eric Mitchell and Stefano Ermon and Christopher D. Manning and Chelsea Finn } ,

journal = { ArXiv } ,

year = { 2023 } ,

volume = { abs/2305.18290 } ,

url = { https://api.semanticscholar.org/CorpusID:258959321 }

} @inproceedings { Guo2024DirectLM ,

title = { Direct Language Model Alignment from Online AI Feedback } ,

author = { Shangmin Guo and Biao Zhang and Tianlin Liu and Tianqi Liu and Misha Khalman and Felipe Llinares and Alexandre Rame and Thomas Mesnard and Yao Zhao and Bilal Piot and Johan Ferret and Mathieu Blondel } ,

year = { 2024 } ,

url = { https://api.semanticscholar.org/CorpusID:267522951 }

}