Lokiは、事実性を検証するプロセスを自動化するために設計されたオープンソースソリューションです。長いテキストを個々のクレームに分析し、検証の価値を評価し、証拠検索のクエリを生成し、証拠をrawっ、最終的にクレームを検証するための包括的なパイプラインを提供します。このツールは、ジャーナリスト、研究者、および情報の事実に興味のある人なら誰でも特に役立ちます。更新を維持するには、当社のニュースレターを当社のウェブサイトで購読するか、Discordに参加してください!

git clone https://github.com/Libr-AI/OpenFactVerification.git

cd OpenFactVerificationpoetry installバージョン3.9以下でPython環境を作成してアクティブ化します。

プロジェクトディレクトリに移動し、必要なパッケージをインストールします。

pip install -r requirements.txt必須のAPIキーを環境にエクスポートすることを選択できます

export SERPER_API_KEY=... # this is required in evidence retrieval if serper being used

export OPENAI_API_KEY=... # this is required in all tasksまたは、YAMLファイルを介してAPIキーを構成します。詳細については、ユーザーガイドを参照してください。

サンプルテストケース:

check_responseメソッドを含むfactcheck/__init__.pyにあるLoki Fact-checkerのメインインターフェイス。この方法は、機能セクションで説明されているように、各機能がクラスにカプセル化されている完全な事実検証パイプラインを統合します。

from factcheck import FactCheck

factcheck_instance = FactCheck ()

# Example text

text = "Your text here"

# Run the fact-check pipeline

results = factcheck_instance . check_response ( text )

print ( results )python webapp.py --api_config demo_data/api_config.yaml # String

python -m factcheck --modal string --input " MBZUAI is the first AI university in the world "

# Text

python -m factcheck --modal text --input demo_data/text.txt

# Speech

python -m factcheck --modal speech --input demo_data/speech.mp3

# Image

python -m factcheck --modal image --input demo_data/image.webp

# Video

python -m factcheck --modal video --input demo_data/video.m4v高度な使用については、ユーザーガイドをご覧ください。

事実確認のソリューションを進化させ、強化し続けるにつれて、私たちはあなたを私たちの旅の不可欠な部分にすることを招待することに興奮しています。サポーターエディションに登録することで、一連の高度な機能と利点を解除するだけではありません。また、信頼できる情報の未来を促進しています。

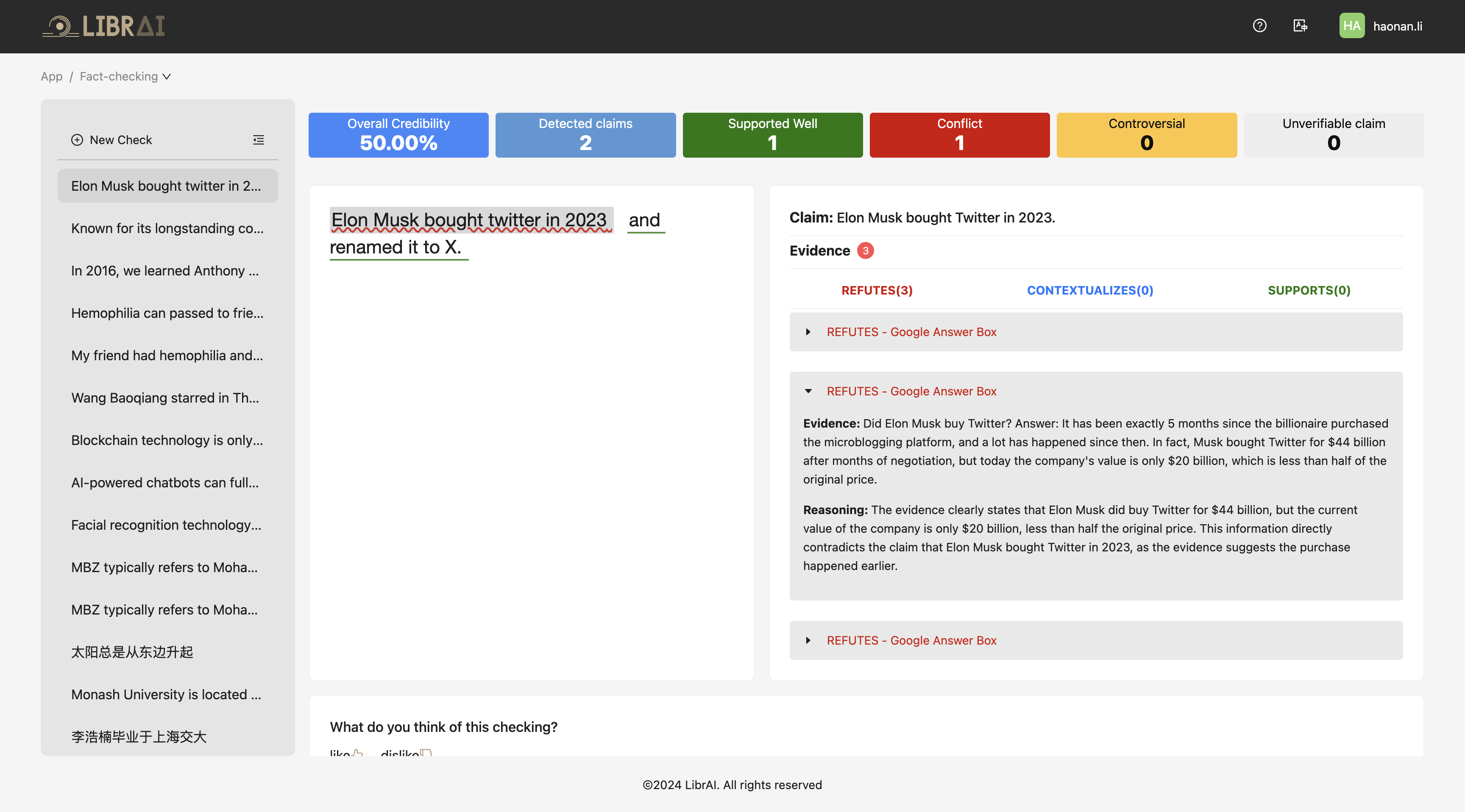

以下は、オンラインサービスのスクリーンショットです。今すぐ試してみるにはここをクリックしてください!

ようこそ、ロキプロジェクトに興味を持ってくれてありがとう!コミュニティからの貢献とフィードバックを歓迎します。開始するには、貢献ガイドラインを参照してください。

最新のアップデート、機能リリース、コミュニティの洞察をお見逃しなく!ニュースレターを購読し、成長するコミュニティの一員になることをお勧めします。

?今すぐ当社のウェブサイトで購読してください!

@misc{li2024lokiopensourcetoolfact,

title={Loki: An Open-Source Tool for Fact Verification},

author={Haonan Li and Xudong Han and Hao Wang and Yuxia Wang and Minghan Wang and Rui Xing and Yilin Geng and Zenan Zhai and Preslav Nakov and Timothy Baldwin},

year={2024},

eprint={2410.01794},

archivePrefix={arXiv},

primaryClass={cs.CL},

url={https://arxiv.org/abs/2410.01794},

}