これは、主にTianxiang Sunによって維持されている「言語モデル(LMAAS)」論文のキュレーションされたリストです。このトピックに関心のあるNLP研究者に、論文を追加または更新するようにプルリクエストを行うことを強くお勧めします(貢献を参照)。最新のアップデートについては、このリポジトリをご覧ください!

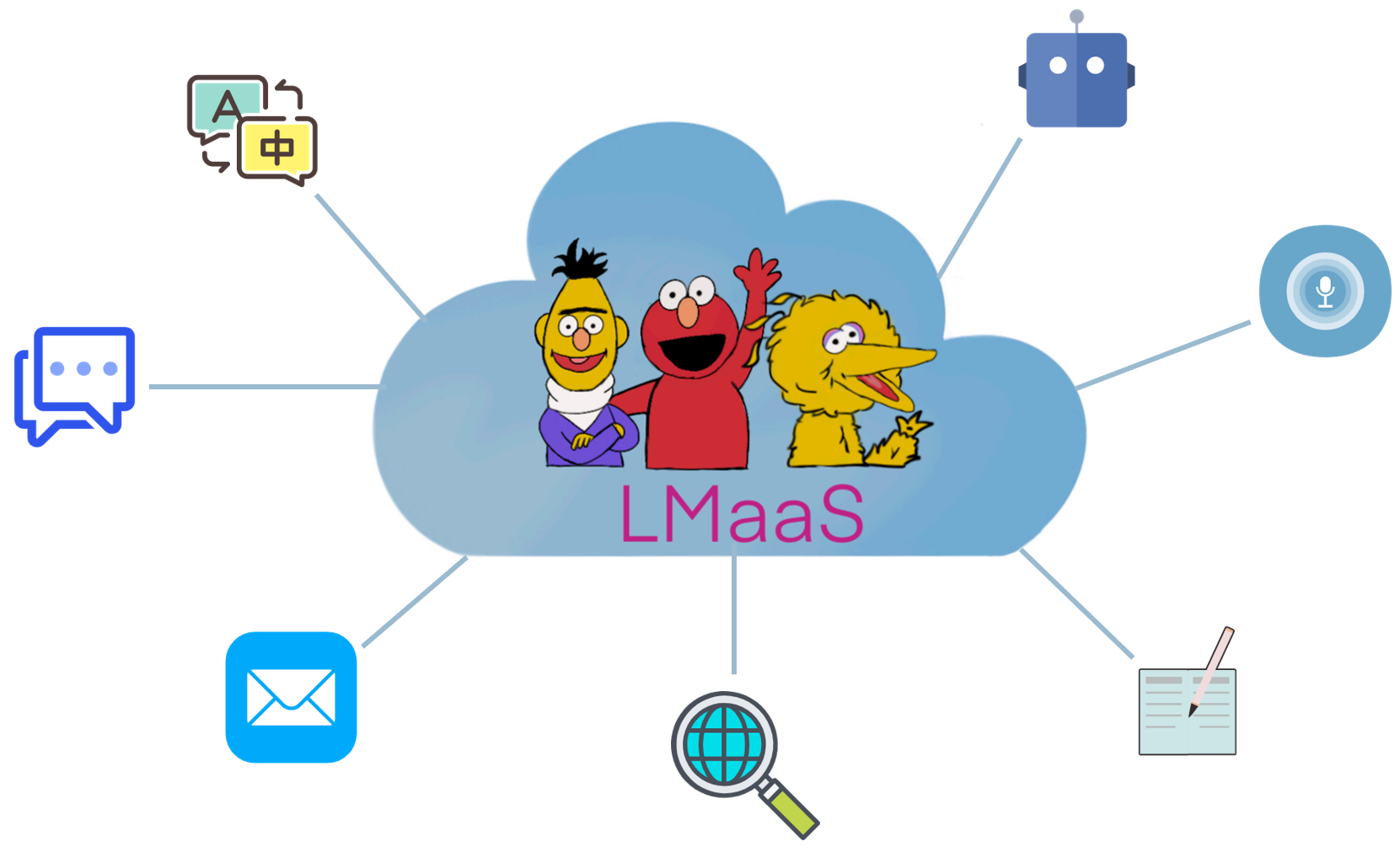

商業的な理由と高価なチューニングコストにより、GPT-3などの事前に訓練された大規模な言語モデル(LLM)は、通常、オープンソーシングモデルの重みではなくサービスとしてリリースされます。このシナリオを「言語モデルAs-a-Service(LMAAS) 」と呼びます(この用語はもともとICML'2022論文で使用されています)。このようなシナリオでは、ユーザーは推論APIを介して強力なLLMにアクセスできます。 LLMSのサービスは、多くのユースケースに電力を供給しています(GPT-3デモを参照)。微調整とは対照的に、LMAAは単一の汎用LLMが多くの違いのタスクを提供できるため、非常に展開効率が良くなります。それにもかかわらず、パラメーターや勾配にアクセスせずにタスクをターゲットにするためにLLMSを適応させる方法は課題です。 LLMがより多くの視聴者に利益をもたらすために、将来の研究を促進するためにこのシナリオに適合する論文を収集します。

どの論文がLMAAのシナリオに適合しますか?主に、モデルパラメーターや勾配にアクセスすることなく、LLMSを下流のタスクに適応させる論文を検討します。微調整されたLLMは、展開後もサービスになる可能性がありますが、限られたオーディエンスのための単一のタスクを解決するために制限されています。私たちの範囲では、さまざまなユーザーに汎用モデルを提供することを好みます。

既存の文献には、LMAAに適合するいくつかの研究があります。

テキストプロンプトとコンテキスト内学習の境界は少しぼやけています。このレポでは、テキストプロンプトカテゴリにはラベル付きサンプルを使用しない論文が含まれていますが、コンテキスト学習カテゴリは、プロンプトにラベル付きサンプルを含む論文で構成されています。

注:関連する(および部分的に重複する)トピックは迅速な学習です。これは、それぞれテンプレートと言葉による出力を変換することにより、一般的な目的LLMSを使用して下流のタスクを解決することを目的としています。ただし、プロンプトベースの学習のほとんどの作業では、モデルパラメーターと勾配へのアクセスが必要であるため、範囲に適合しません。 LMAAには適していないプロンプトベースの学習論文については、別の素晴らしいペーパーリストであるプロンプトに貢献することをお勧めします。

微調整タスク固有のLLMと比較して、LMAAには次の利点があります。

作品の略語。

作品の重要な機能。

作業の主な実験設定。

知識ベースとしての言語モデル? EMNLP 2019

ファビオ・ペトロニ、ティム・ロックテルシェル、パトリック・ルイス、アントン・バクティン、ユキアン・ウー、アレクサンダー・H・ミラー、セバスチャン・リーデル。 [PDF] [コード]

どの言語モデルが知っているかをどうやって知ることができますか? TACL 2020

Zhengbao Jiang、Frank F. Xu、Jun Araki、Graham Neubig 。 [PDF] [コード]

言語モデルは、少ないショット学習者です。ニューリップ2020

トム・B・ブラウン、ベンジャミン・マン、ニック・ライダー、メラニー・サブビア、ジャレッド・カプラン、プラフラ・ダリワル、アービンド・ニーラカンタン、プラナヴ・シャム、ギリッシュ・サストリー、アマンダ・アスケル、サンドヒニ・アガルワル、アリエル・ハーバート・ヴォス、グレッチェン・クルーガー、トム・ヘナイガン、アディヤン、ラメシュ、ダニエル・M・ジーグラー、ジェフリー・ウー、クレメンス・ウィンター、クリストファー・ヘッセ、マーク・チェン、エリック・シグラー、マテウス・リトウィン、スコット・グレイ、ベンジャミン・チェス、ジャック・クラーク、クリストファー・バーナー、サム・マッカンドリッシュ、アレック・ラドフォード、イリヤ・サッツキーバー、ダリオ・アモデイ。 [PDF]

データセットとプロンプトコレクションでメタチューニングすることにより、ゼロショット学習の言語モデルの適応。 EMNLP 2021の調査結果

Ruiqi Zhong、Kristy Lee、Zheng Zhang、Dan Klein 。 [PDF] [コード]

Finetuned Languageモデルはゼロショット学習者です。 ICLR 2022

ジェイソン・ウェイ、マルテン・ボスマ、ヴィンセント・Y・ザオ、ケルビン・グー、アダムズ・ウェイ・ユ、ブライアン・レスター、ナン・デュ、アンドリュー・M・ダイ、QUOC V. LE 。 [PDF] [コード]

マルチタスクは、トレーニングをプロンプトして、ゼロショットタスクの一般化を可能にします。 ICLR 2022

Victor Sanh、Albert Webson、Colin Raffel、Stephen H. Bach、Lintang Sutawika、Zaid Alyafeai、Antoine Chaffin、Arnaud Stiegler、Teven Le Scao、Arun Raja、Manan Dey、M Saifal Bari、Canwen XU、Urmish Thakker、Shanya Sharma Sharma、エリザ・シュチェチュラ、テウーン・キム、グンジャン・チャブラニ、ニハル・ナヤック、デバジョティ・ダッタ、ジョナサン・チャン、マイク・ティアン・ジアン・ジャン、ハン・ワン、マッテオ・マニカ、シェン・シェン、ゼン・シン・ヨン、ハーシット・パンディー、レイチェル・ボーデン、トーマス・ワン、トリシャラ・ネーラ・ネーラジ、ジョス・ローゼン、サンティリ、 Thibault Fevry、Jason Alan Fries、Ryan Teehan、Tali Bers、Stella Biderman、Leo Gao、Thomas Wolf、Alexander M. Rush 。 [PDF] [コード]

人間のフィードバックで指示に従うための言語モデルをトレーニングします。プリプリント2022.3

ロング・オウヤン、ジェフ・ウー、Xu江、ディオ・アルメイダ、キャロル・L・ウェインライト、パメラ・ミシュキン、チョン・チャン、サンドヒニ・アガルワル、カタリーナ・スラマ、アレックス・レイ、ジョン・シュルマン、ジェイコブ・ヒルトン、フレイザー・ケルトン、ルーク・ミラーピーター・ウェルダー、ポール・クリスチャン、ヤン・レイキ、ライアン・ロウ。 [PDF] [コード]

大規模な言語モデルはゼロショットの推論です。プリプリント2022.6

コジマ、シクシアン・シェーン・グ、マチェル・リード、ユタカ・マツー、ゆきつさ。 [PDF] [コード]

凍結した双方向言語モデルを介したゼロショットビデオ質問応答。プリプリント2022.6

アントワーヌ・ヤン、アントワーヌ・マイック、ヨーゼフ・シヴィック、イヴァン・ラップフ、コーデリア・シュミット。 [PDF] [コード]

言語モデルは、汎用インターフェイスです。プリプリント2022.6

Yaru Hao、Haoyu Song、Li Dong、Shaohan Huang、Zewen Chi、Wenhui Wang、Shuming Ma、Furu Wei 。 [PDF] [コード]

コードの大規模な言語モデルのリポジトリレベルのプロンプト生成。プリプリント2022.6

Disha Shrivastava、Hugo Larochelle、Daniel Tarlow [PDF] [Code]、2022.6

以前のプロンプトを無視する:言語モデルの攻撃技術。 Best Paper Award @ Neurips ML Safety Workshop 2022。

FábioPerez、Ian Ribeiro [PDF] [Project]、2022.11

言語モデルは、少ないショット学習者です。ニューリップ2020

トム・B・ブラウン、ベンジャミン・マン、ニック・ライダー、メラニー・サブビア、ジャレッド・カプラン、プラフラ・ダリワル、アービンド・ニーラカンタン、プラナヴ・シャム、ギリッシュ・サストリー、アマンダ・アスケル、サンドヒニ・アガルワル、アリエル・ハーバート・ヴォス、グレッチェン・クルーガー、トム・ヘナイガン、アディヤン、ラメシュ、ダニエル・M・ジーグラー、ジェフリー・ウー、クレメンス・ウィンター、クリストファー・ヘッセ、マーク・チェン、エリック・シグラー、マテウス・リトウィン、スコット・グレイ、ベンジャミン・チェス、ジャック・クラーク、クリストファー・バーナー、サム・マッカンドリッシュ、アレック・ラドフォード、イリヤ・サッツキーバー、ダリオ・アモデイ。 [PDF]

使用前にキャリブレーション:言語モデルのいくつかのショットパフォーマンスを改善します。 ICML 2021

トニーZ. Zhao、エリックウォレス、シフェン、ダンクライン、サミャーシン。 [PDF] [コード]

暗黙のベイジアン推論としてのコンテキスト学習の説明。 ICLR 2022

サン・マイケル・シー、アディティ・ラグナサン、パーシー・リアン、テンギュMA 。 [PDF] [コード]

促す一連の思考は、大規模な言語モデルで推論を引き出します。プリプリント2022.1

ジェイソン・ウェイ、Xuezhi Wang、Dale Schuurmans、Maarten Bosma、Brian Ichter、Fei Xia、Ed Chi、Quoc Le、Denny Zhou 。 [PDF]

自然言語のクラウドソーシングの指示によるクロスタスクの一般化。 ACL 2022

Swaroop Mishra、Daniel Khashabi、Chitta Baral、Hannaneh Hajishirzi 。 [PDF] [コード]

幻想的に注文されたプロンプトとそれらを見つける場所:少数のショットプロンプトの注文感度を克服します。 ACL 2022

Yao Lu、Max Bartolo、Alastair Moore、Sebastian Riede、Pontus Stenetorp 。 [PDF]

騒々しいチャンネル言語モデルは、少数のテキスト分類を求めています。 ACL 2022

Sewon Min、Mike Lewis、Hannaneh Hajishirzi、Luke Zettlemoyer 。 [PDF] [コード]

言語モデルのコンテキストチューニングを介したメタ学習。 ACL 2022

ヤンダ・チェン、ルイキ・チャン、シェン・ザ、ジョージ・カリピス、彼。 [PDF] [コード]

GPT-3のコンテキスト内の例が良いのは何ですか? Deelio@ACL 2022

jiachang liu、Dinghan Shen、Yizhe Zhang、Bill Dolan、Lawrence Carin、Weizhu Chen 。 [PDF]

コンテキスト内学習のプロンプトを取得することを学ぶ。 NAACL 2022

オハド・ルービン、ジョナサン・ヘルツィヒ、ジョナサン・ベラント。 [PDF] [コード]

Metaicl:文脈で学習することを学ぶ。 NAACL 2022

Sewon Min、Mike Lewis、Luke Zettlemoyer、Hannaneh Hajishirzi 。 [PDF] [コード]

自己教師のトレーニングを通じて、コンテキスト内の少ないショット学習を改善します。 NAACL 2022

Mingda Chen、Jingfei du、Ramakanth Pasunuru、Todor Mihaylov、Srini Iyer、Veselin Stoyanov、Zornitsa Kozareva 。 [PDF]

自己生成されたコンテキスト学習:デモンストレーションジェネレーターとしての自動回帰言語モデルを活用します。 LPLM@NAACL 2022

ヒューン・ジュン・キム、ヒョンスー・チョー、ジュンアイオブ・キム、テウク・キム、カン・ミン・ユ、サンゴ・リー。 [PDF]

デモンストレーションの役割を再考する:コンテキスト内学習が機能する理由は何ですか?プリプリント2022.2

Sewon Min、Xinxi Lyu、Ari Holtzman、Mikel Artetxe、Mike Lewis、Hannaneh Hajishirzi、Luke Zettlemoyer 。 [PDF] [コード]

少数のショットダイアログ状態追跡のコンテキスト内学習。プリプリント2022.3

Youshi Hu、Chia-Hsuan Lee、Tianbao Xie、Tao Yu、Noah A. Smith、Mari Ostendorf 。 [PDF] [コード]

自己整合性は、言語モデルの一連の思考推論を改善します。プリプリント2022.3

Xuezhi Wang、Jason Wei、Dale Schuurmans、Quoc Le、Ed Chi、Denny Zhou 。 [PDF]

スター:スターは、推論を伴う自己評価の推論ブートストラップの推論。プリプリント2022.3

エリック・ゼリクマン、ユハイ・ウー、ノア・D・グッドマン。 [PDF]

1,600以上の言語タスクに関するコンテキスト内の命令による一般化のベンチマーク。プリプリント2022.4

Yizhong Wang、Swaroop Mishra、Pegah Alipoormolabashi、Yeganeh Kordi、Amirreza Mirzaei、Anjana Arunkumar、Arjun Ashok、Arut Selvan Dhanasekaran、Atharva Naik、David Stap、Eshahi Pathak、Giannis Karamanolakis、Ishankisイシャニ・モンダル、ジェイコブ・アンダーソン、カービー・クズニア、クリマ・ドシ、マイトレヤ・パテル、クンタル・クマール・パル、メハラド・モラダシャヒ、ミヒル・パルマー、ミラリ・ピューロヒット、ニーラジ・ヴァリシュ、ニーラジ・ヴァリシュ、プラニ・ロヒタ・カザ、パルキット・ヴェルマ・ピュア・ピュールサンパット、サヴァン・ドシ、シッダルタ・ミシュラ、スジャン・レディ、スマンタ・パトロ、タナイ・ディクシット、Xudong・シェン、チッタ・バラル、Yejin Choi、Noah A. Smith、Hannaneh Hajishirzi、Daniel Khashabi 。 [PDF] [コード]

言語モデルはコンテキストの説明から学ぶことができますか? 。プリプリント2022.4

Andrew K. Lampinen、Ishita Dasgupta、Stephanie Cy Chan、Kory Matthewson、Michael Henry Tessler、Antonia Creswell、James L. McClelland、Jane X. Wang、Felix Hill 。 [PDF]

グラウンドトゥルースラベルは重要です:入力ラベルのデモンストレーションをより深く検討します。プリプリント2022.5

Junyeob Kim、Hyuhng Joon Kim、Hyunsoo Cho、Hwiyeol Jo、Sangwoo Lee、Sang-Goo Lee、Kang Min Yoo、Taeuk Kim 。 [PDF]

少数のショットコンテキスト内学習における説明の信頼性。プリプリント2022.5

xi ye、グレッグ・デュレット。 [PDF]

最小のプロンプトは、大規模な言語モデルで複雑な推論を可能にします。プリプリント2022.5

Denny Zhou、NathanaelSchärli、Le Hou、Jason Wei、Nathan Scales、Xuezhi Wang、Dale Schuurmans、Olivier Bousquet、Quoc Le、Ed Chi 。 [PDF]

Maieuticのプロンプト:再帰的な説明を使用した論理的に一貫した推論。プリプリント2022.5

Jaehun Jung、Lianhui Qin、Sean Welleck、Faeze Brahman、Chandra Bhagavatula、Ronan Le Bras、Yejin Choi 。 [PDF]

言語モデルをより良い推論者にすることの進歩について。プリプリント2022.6

Yifei Li、Zeqi Lin、Shizhuo Zhang、Qiang Fu、Bei Chen、Jian-Guang Lou、Weizhu Chen 。 [PDF] [コード]

大規模な言語モデルの緊急能力。プリプリント2022.6

ジェイソン・ウェイ、Yi Tay、Rishi Bommasani、Colin Raffel、Barret Zoph、Sebastian Borgeaud、Dani Yogatama、Maarten Bosma、Denny Zhou、Donald Metzler、エドH. [PDF]

言語モデルは、汎用インターフェイスです。プリプリント2022.6

Yaru Hao、Haoyu Song、Li Dong、Shaohan Huang、Zewen Chi、Wenhui Wang、Shuming Ma、Furu Wei 。 [PDF] [コード]

変圧器はコンテキスト内を何を学ぶことができますか?単純な関数クラスのケーススタディ。プリプリント2022.8

Shivam Garg、Dimitris Tsipras、Percy Liang、Gregory Valiant 。 [PDF] [コード]

コンテキストを蒸留することによる学習。プリプリント2022.9

チャーリー・スネル、ダン・クライン、ルイキ・チャン。 [PDF]

シンボリック言語のバインディング言語モデル。プリプリント2022.10

Zhoujun Cheng*、Tianbao Xie*、Peng Shi、Chengzu Li、Rahul Nadkarni、Youshi Hu、Caiming Xiong、Dragomir Radev、Mari Ostendorf、Luke Zettlemoyer、Noah A. Smith、Tao Yu 。 [PDF] [コード] [ウェブサイト]

大規模な言語モデルの微調整におけるコンテキスト内学習能力の保存。プリプリント2022.11

Yihan Wang、Si SI、Daliang Li、Michal Lukasik、Felix Yu、Cho-Jui Hsieh、Inderjit S Dhillon、Sanjiv Kumar 。 [PDF]

コンテキスト学習を介したアルゴリズムの推論を指導します。プリプリント2022.11

Hattie Zhou、Azade Nova、Hugo Larochelle、Aaron Courville、Behnam Neyshabur、Hanie Sedghi 。 [PDF]

コンテキスト学習はどのような学習アルゴリズムですか?線形モデルを使用した調査。プリプリント2022.11

EkinAkyürek、Dale Schuurmans、Jacob Andreas、Tengyu MA、Denny Zhou 。 [PDF]

サービスとしての言語モデルのためのブラックボックスチューニング。 ICML 2022

Tianxiang Sun、Yunfan Shao、Hong Qian、Xuanjing Huang、Xipeng Qiu。 [PDF] [コード]

事前に訓練された言語モデルのブラックボックスプロンプト学習。 TMLR 2023.2

Shizhe Diao、Xuechun Li、Yong Lin、Zhichao Huang、Tong Zhang 。 [PDF]

グリップ:グラデーションフリーの編集ベースの指導検索で、大規模な言語モデルを促すための検索。プリプリント2022.3

Archiki Prasad、Peter Hase、Xiang Zhou、Mohit Bansal 。 [PDF] [コード]

制御可能な応答生成に向けて少数のショットプロンプト。プリプリント2022.6

Hsuan Su、Pohan Chi、Shih-Cheng Huang、Chung Ho Lam、Saurav Sahay、Shang-Tse Chen、Hung-Yi Lee 。 [PDF]

BBTV2:大きな言語モデルを備えたグラデーションフリーの未来に向けて。 EMNLP 2022

Tianxiang Sun、Zhengfu He、Hong Qian、Yunhua Zhou、Xuanjing Huang、Xipeng Qiu 。 [PDF] [コード]

RLPROMPT:補強学習を使用して、個別のテキストプロンプトを最適化します。 EMNLP 2022

Mingkai Deng、Jianyu Wang、Cheng-Ping Hsieh、Yihan Wang、Han Guo、Tianmin Shu、Meng Song、Eric P. Xing、Zhiting Hu 。 [PDF] [コード]

クリップ調整:報酬の混合による派生のない迅速な学習に向けて。 EMNLP 2022の調査結果

Yekun Chai、Shuohuan Wang、Yu Sun、Hao Tian、Hua Wu、Haifeng Wang 。 [PDF]

Temea:補強学習によるテスト時間プロンプトの編集。プリプリント2022.11

Tianjun Zhang、Xuzhi Wang、Denny Zhou、Dale Schuurmans、Joseph E. Gonzalez。 [PDF] [コード]

プロンプトブースト:10回のフォワードパスによるブラックボックステキスト分類。プリプリント2022.12

Bairu Hou、Joe O'Connor、Jacob Andreas、Shiyu Chang、Yang Zhang 。 [PDF]

中国の少数の学習のためのモジュラープロンプトのマルチタスクプリトレーニング。 ACL 2023

Tianxiang Sun、Zhengfu He、Qin Zhu、Xipeng Qiu、Xuanjing Huang 。 [PDF]

勾配降下が派生のない最適化を満たすとき:ブラックボックスシナリオで行われたマッチ。 ACL 2023

Chengcheng Han、Liqing Cui、Renyu Zhu、Jianing Wang、Nuo Chen、Qiushi Sun、Xiang Li、Ming Gao 。 [PDF]

迅速なベースのブラックボックスチューニングをカラフルにします:3つの直交視点からモデルの一般化を強化します。 LREC-COLING 2024

Qiushi Sun、Chengcheng Han、Nuo Chen、Renyu Zhu、Jingyang Gong、Xiang Li、Ming Gao 。 [PDF]

チューニングするかどうか?多様なタスクに事前に守られた表現を適応させます。 REPL4NLP@ACL 2019

マシュー・E・ピーターズ、セバスチャン・ルーダー、ノア・A・スミス。 [PDF]

説明は、ブラックボックスモデルの校正に役立ちますか? ACL 2022

xi ye、グレッグ・デュレット。 [PDF] [コード]

共同トレーニングは、大規模な言語モデルの迅速な学習を改善します。 ICML 2022

ハンター・ラング、モニカ・アグラワル、ユン・キム、デビッド・ソンタグ。 [PDF]

Y-Tuning:ラベル表現学習を介した大規模な事前訓練モデルの効率的なチューニングパラダイム。プリプリント2022.2

Yitao Liu、Chenxin an、Xipeng Qiu 。 [PDF]

LST:パラメーターとメモリ効率的な転送学習用のラダーサイドチューニング。ニューリップ2022

Yi-Lin Sung、Jaemin Cho、Mohit Bansal 。 [PDF] [コード]

デコーダーチューニング:デコードとしての効率的な言語理解。プリプリント2022.12

Ganqu Cui、Wentao Li、Ning Ding、Longtao Huang、Zhiyuan Liu、Maosong Sun。 [PDF]

前処理された言語モデルでデータセットを生成します。 EMNLP 2021

ティモ・シック、ヒンリッヒ・シュッツェ。 [PDF] [コード]

GPT3MIX:テキスト増強のための大規模な言語モデルの活用。 EMNLP 2021の調査結果

Kang Min Yoo、Dongju Park、Jaewook Kang、Sangwoo Lee、Woomyeong Park 。 [PDF] [コード]

常識的な推論を促す知識を生成しました。 ACL 2022

Jiacheng Liu、Alisa Liu、Ximing Lu、Sean Welleck、Peter West、Ronan Le Bras、Yejin Choi、Hannaneh Hajishirzi 。 [PDF] [コード]

ゼロゲン:データセット生成による効率的なゼロショット学習。 EMNLP 2022

Jiacheng Ye、Jiahui Gao、Qintong Li、Hang Xu、Jiangtao Feng、Zhiyong Wu、Tao Yu、Lingpeng Kong 。 [PDF] [コード]

Zerogen+:効率的なゼロショット学習における自己ガイドの高品質データ生成。プリプリント2022.2

Jiahui Gao、Renjie Pi、Yong Lin、Hang Xu、Jiacheng Ye、Zhiyong Wu、Xiaodan Liang、Zhenguo Li、Lingpeng Kong 。 [PDF]

OceSC:感情的なサポートの会話のための大規模な言語モデルを使用した対話の増強。 ACL 2023の調査結果

Chujie Zheng、Sahand Sabour、Jiaxin Wen、Zheng Zhang、Minlie Huang 。 [PDF]

言語モデルでトレーニングデータを生成する:ゼロショット言語理解に向けて。ニューリップ2022

Yu Meng、Jiaxin Huang、Yu Zhang、Jiawei Han [PDF] [Code]

??まず、貢献するために時間を割いてくれてありがとう! ??

貢献する手順:

PaperNumberを変更し、プルリクエストを送信します。論文を追加または変更する必要があると考える理由を非常に簡単に説明することをお勧めします。あなたが何か間違ったものを置いても心配しないでください、私たちはあなたのためにそれらを修正します。ここであなたの素晴らしい仕事を貢献して宣伝してください!

プルリクエストを提出した以下の貢献者に加えて、私たちはまた、論文を推薦してくれたOhad RubinとKang Min Yooにも感謝したいと思います。