Meta Platforms は、Llama モデルの新しい合理化バージョンである Llama 3.21B および 3B をリリースしました。これにより、一般的なスマートフォンやタブレット上で大規模な言語モデルを安定して動作させることができます。この画期的な進歩とその意義について、ダウンコード編集者が詳しく解説します。

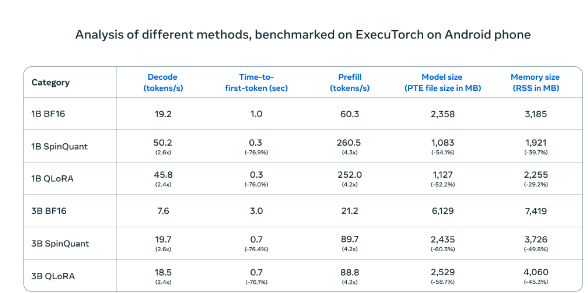

Meta Platforms は本日、Llama3.21B および 3B 製品を含む Llama モデルの新しい合理化バージョンをリリースしました。これにより、通常のスマートフォンやタブレット上で大規模な言語モデルを安定して動作させることが初めて可能になりました。定量的トレーニング技術と最適化アルゴリズムを革新的に統合することにより、新しいバージョンでは、元の連続処理品質を維持しながら、ファイル サイズが 56% 削減され、実行メモリ要件が 41% 削減され、処理速度が元のバージョンの 4 倍に向上しました。 8,000文字のテキスト。

Android スマートフォンでテストしたところ、Meta の圧縮 AI モデル (SpinQuant および QLoRA) は標準バージョンよりも大幅に高速かつ効率的でした。小型モデルはメモリ使用量が少なくなり、4 倍の速度で実行されます。

OnePlus12 携帯電話の実際のテストでは、この圧縮バージョンは標準バージョンと同等のパフォーマンスを示すと同時に、操作効率が大幅に向上し、モバイル デバイスのコンピューティング能力不足という長期的な問題を効果的に解決しました。 Meta はオープンな協力市場戦略を採用し、Qualcomm や MediaTek などの主流のモバイル プロセッサ メーカーとの綿密な協力を実行することを選択し、新バージョンは Llama 公式 Web サイトと Hugging Face プラットフォームを通じて同時にリリースされ、開発者に便利なアクセスを提供します。チャンネル。

この戦略は、業界の他の大手企業とはまったく対照的です。 Google と Apple が新しいテクノロジーを自社のオペレーティング システムに深く統合することを選択した場合、Meta のオープン ルートは開発者に大きなイノベーションの余地を提供します。このリリースは、集中サーバーから個人端末へのデータ処理モデルの移行を示しています。ローカル処理ソリューションは、ユーザーのプライバシーをより適切に保護するだけでなく、より高速な応答エクスペリエンスを提供します。

この技術的進歩は、パーソナルコンピュータの普及時と同様の大きな変化を引き起こす可能性がありますが、依然としてデバイスの性能要件や開発者プラットフォームの選択などの課題に直面しています。モバイル デバイスのパフォーマンスが向上し続けるにつれて、ローカル処理ソリューションの利点が徐々に明らかになるでしょう。 Meta は、オープンな協力を通じて業界全体のより効率的かつ安全な方向への発展を促進し、将来のモバイル デバイスのアプリケーション開発に新しい道を切り開くことを望んでいます。

Llama モデルの簡易版はモバイル AI アプリケーションに新たな可能性をもたらし、そのオープンな協力戦略も業界から学ぶ価値があります。将来的には、テクノロジーが成熟し、普及が進むにつれて、ローカライズされた AI 処理が主流のトレンドになるでしょう。