Downcodes の編集者は、本日、Hugging Face が SmolLM2 をリリースしたことを知りました。SmolLM2 は、パフォーマンスの点で優れており、大規模なモデルよりもはるかに少ないコンピューティング リソースを必要とする一連のコンパクトな言語モデルです。これは、リソースに制約のあるデバイスに AI アプリケーションを展開したい開発者にとって、間違いなく良いニュースです。 SmolLM2 は Apache 2.0 ライセンスの下でリリースされており、さまざまなアプリケーション シナリオに柔軟に適応できる、パラメーター サイズの異なる 3 つのモデルを提供します。

Hugging Face は本日、SmolLM2 をリリースしました。これは、大規模なモデルよりもはるかに少ない計算リソースを必要としながら、優れたパフォーマンスを実現するコンパクトな言語モデルの新しいセットです。新しいモデルは、Apache 2.0 ライセンスに基づいてリリースされ、135M、360M、1.7B パラメータの 3 つのサイズがあり、処理能力とメモリが限られているスマートフォンやその他のエッジ デバイスへの導入に適しています。

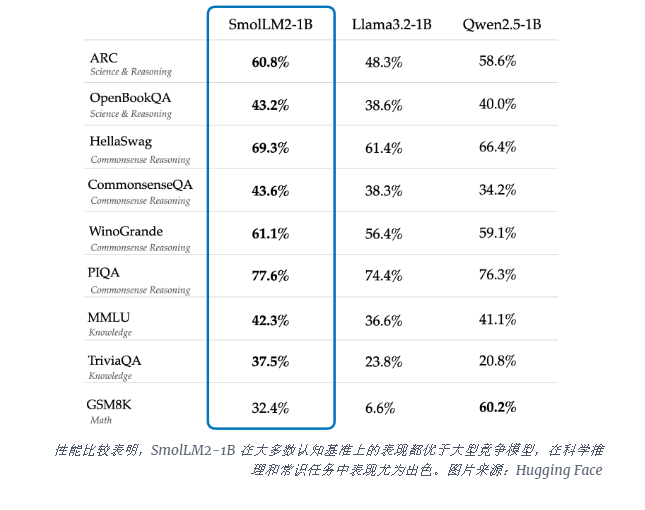

SmolLM2-1B モデルは、いくつかの主要なベンチマークで Meta の Llama1B モデルよりも優れており、特に科学的推論と常識的なタスクで優れたパフォーマンスを発揮します。このモデルは、FineWeb-Edu や特殊な数学およびコーディング データセットを含むデータセットの多様な組み合わせを使用し、ほとんどの認知ベンチマークで大規模な競合モデルよりも優れたパフォーマンスを発揮します。

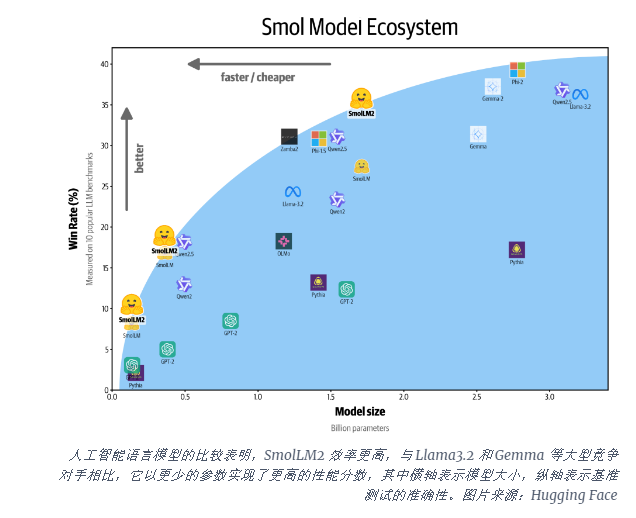

SmolLM2 のリリースは、AI 業界が大規模言語モデル (LLM) を実行するための計算需要に取り組んでいる重要な時期に行われます。 OpenAI や Anthropic などの企業がモデル スケールの限界を押し広げ続ける一方で、デバイス上でネイティブに実行できる効率的で軽量な AI の必要性に対する認識が高まっています。

SmolLM2 は、強力な AI 機能を個人のデバイスに直接導入するための異なるアプローチを提供し、大規模なデータセンターを備えたテクノロジー大手だけでなく、より多くのユーザーや企業が高度な AI ツールを利用できる未来を示しています。これらのモデルは、テキストの書き換え、要約、関数呼び出しなどのさまざまなアプリケーションをサポートしており、プライバシー、遅延、または接続の制約によってクラウドベースの AI ソリューションが実用的でないシナリオでの導入に適しています。

これらの小規模なモデルには依然として制限がありますが、より効率的な AI モデルを目指す広範な傾向の一部を表しています。 SmolLM2 のリリースは、人工知能の将来が、ますます大規模なモデルだけでなく、より少ないリソースで強力なパフォーマンスを提供できるより効率的なアーキテクチャに属する可能性があることを示しています。

SmolLM2 の出現は、軽量 AI アプリケーションの開発に新たな可能性を提供するとともに、AI テクノロジーがより普及し、より多くのユーザーに恩恵をもたらすことを示しています。 Downcodes の編集者は、人工知能技術の開発を促進するために、より効率的でリソース消費の少ない AI モデルが将来登場すると信じています。