Downcodes の編集者は、Tongyi Qianwen チームが最近、最新の Qwen2.5-Coder フル シリーズ モデルをオープンソース化したことを知りました。これは、オープンソースの大規模モデルの分野における新たなマイルストーンとなります。 Qwen2.5-Coder シリーズ モデルは、強力なコーディング機能、多様な機能、便利な実用性により多くの注目を集めており、コード生成、修復、推論において優れたパフォーマンスを発揮し、開発者にオープン コードのさらなる開発を促進する強力なツールを提供します。 LLM。この一連のモデルのオープンソースは、プログラミング分野における人工知能技術の応用と革新を大きく促進します。

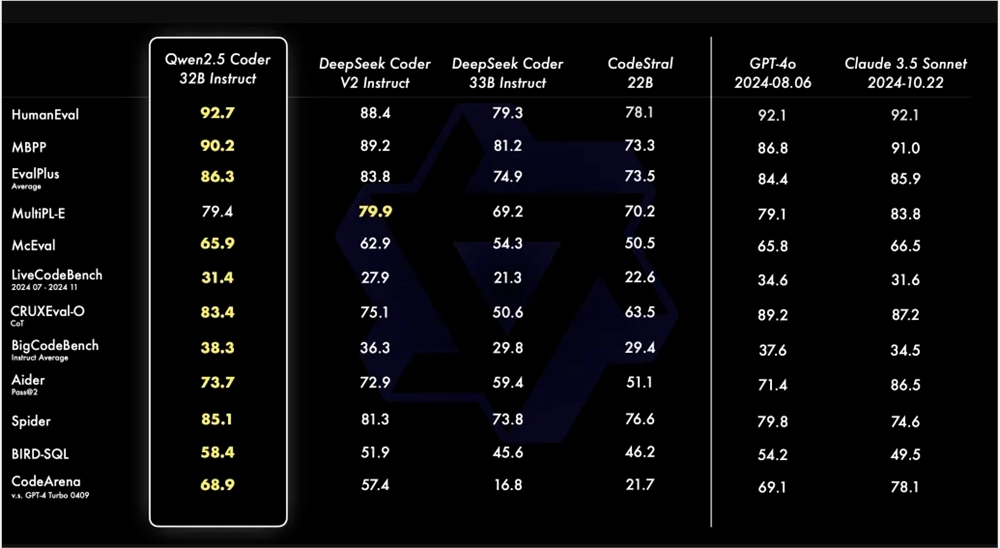

Tongyi Qianwen チームは最近、最新の Qwen2.5-Coder シリーズをオープンソース化すると発表しました。この動きは、オープン コード LLM の開発を促進することを目的としています。 Qwen2.5-Coder は、そのパワー、多様性、実用性で注目を集めています。 Qwen2.5-Coder-32B-Instruct モデルは、コード機能の点で GPT-4o と同等の SOTA レベルに達しており、コード生成、コード修復、コード推論などの包括的な機能を示しています。複数のコード生成ベンチマークで最高のパフォーマンスを達成し、Aider ベンチマークでは GPT-4o に匹敵する 73.7 のスコアを達成しました。

Qwen2.5-Coder は 40 以上のプログラミング言語をサポートしており、McEval で 65.9 ポイントを獲得しており、Haskell や Racket などの言語が特に優れたパフォーマンスを示しています。これは、トレーニング前の段階での独自のデータ クリーニングとマッチングによるものです。さらに、Qwen2.5-Coder-32B-Instruct は、複数のプログラミング言語のコード修復機能でも優れたパフォーマンスを発揮し、MdEval ベンチマークで 75.2 のスコアを獲得し、第 1 位にランクされました。

人間の好みに対する Qwen2.5-Coder-32B-Instruct のアラインメント パフォーマンスをテストするために、内部的に注釈が付けられたコード好み評価ベンチマーク Code Arena が構築されました。結果は、Qwen2.5-Coder-32B-Instruct が優先アラインメントにおいて利点があることを示しています。

Qwen2.5-Coderシリーズは今回、0.5B/3B/14B/32Bを含む4つのサイズのモデルをオープンソース化し、さまざまな開発者のニーズを満たすために6つの主流モデルサイズをカバーしています。公式は Base と Instruct の 2 つのモデルを提供します。前者は開発者がモデルを微調整するための基礎として機能し、後者は公式に調整されたチャット モデルとして機能します。モデルのサイズとパフォーマンスの間には正の相関関係があり、Qwen2.5-Coder はすべてのサイズで SOTA パフォーマンスを達成します。

Qwen2.5-Coder の 0.5B/1.5B/7B/14B/32B モデルは Apache2.0 ライセンスを採用していますが、3B モデルは Research Only ライセンスです。チームは、すべてのデータ セットでさまざまなサイズの Qwen2.5-Coder のパフォーマンスを評価することで、コード LLM のスケーリングの有効性を検証しました。

Qwen2.5-Coder のオープン ソースは、開発者に強力で多様かつ実用的なプログラミング モデルの選択肢を提供し、プログラミング言語モデルの開発と適用の促進に役立ちます。

Qwen2.5-Coder モデルのリンク:

https://modelscope.cn/collections/Qwen25-Coder-9d375446e8f5814a

つまり、Qwen2.5-Coder のオープンソースは開発者に強力なツールをもたらし、その優れたパフォーマンスと幅広い適用性により、コード生成とプログラミングの分野の発展を大きく促進することになります。 Qwen2.5-Coder が今後さらに多くのアプリケーション シナリオで役割を果たすことができることを楽しみにしています。