MIT の新しい研究で、大規模言語モデル (LLM) の内部構造と人間の脳との驚くべき類似点が明らかになり、人工知能の分野で激しい議論が巻き起こっています。 Downcodes の編集者が、この研究の画期的な発見と、AI の将来の発展におけるその重要性について詳しく説明します。研究者らは、LLM 活性化空間の詳細な分析を通じて、3 つのレベルの構造的特徴を発見しました。これらの特徴の発見は、LLM の動作メカニズムをより深く理解し、将来の AI テクノロジーの開発に新たな方向性を与えるでしょう。

AI は実際に「脳の成長」を始めた!? MIT の最新研究により、大規模言語モデル (LLM) の内部構造が人間の脳と驚くほど似ていることが判明しました。

この研究では、スパース オートエンコーダ テクノロジーを使用して、LLM の活性化空間の詳細な分析を実施し、驚くべき 3 つのレベルの構造的特徴を発見しました。

まず、顕微鏡レベルで、研究者らは「結晶」様構造の存在を発見した。これらの「クリスタル」の面は、「男性:女性::王様:女王」などのよく知られた言葉の例えに似た、平行四辺形または台形で構成されています。

さらに驚くべきことは、これらの「結晶」構造は、線形判別分析技術によっていくつかの無関係な干渉因子 (語長など) を除去した後により明確になることです。

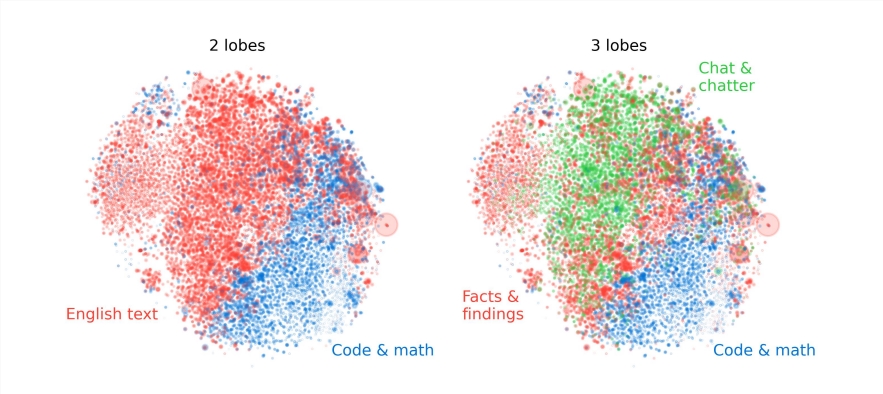

第二に、メソレベルでは、研究者らはLLMの活性化空間が人間の脳の機能部門と同様のモジュール構造を持っていることを発見しました。

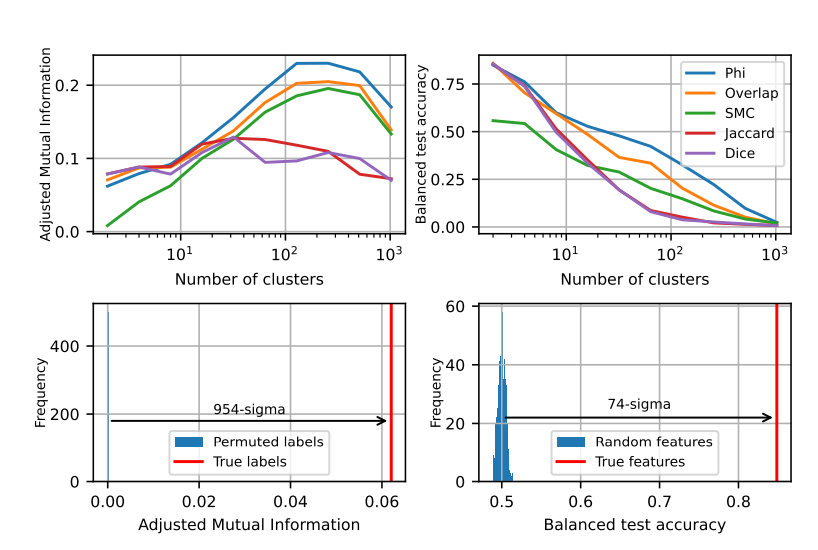

たとえば、数学とコーディングに関連する機能が集まって、人間の脳の機能葉に似た「葉」を形成します。研究者らは、複数の指標の定量分析を通じて、これらの「ローブ」の空間的局所性を確認し、ランダムな分布から予想されるものをはるかに超えて、共起する特徴もより空間的に集中していることを示しました。

研究者らは、マクロレベルでは、LLM 特徴点群の全体構造が等方性ではなく、べき乗則の固有値分布を示しており、この分布は中間層で最も明白であることを発見しました。

研究者らはまた、さまざまなレベルのクラスタリング エントロピーを定量的に分析し、中間層のクラスタリング エントロピーが低く、特徴表現がより集中していることを示し、一方、初期層と後期層のクラスタリング エントロピーが高く、特徴表現がより集中していることを示していることを発見しました。表現はより分散されました。

この研究は、大規模な言語モデルの内部メカニズムを理解する上で新しい視点を提供し、将来のより強力でインテリジェントな AI システムの開発の基礎も築きます。

この研究結果は、大規模言語モデルに対する理解が深まるだけでなく、人工知能の将来の発展に新たな方向性を示唆するものでもあります。 Downcodes の編集者は、テクノロジーの継続的な進歩により、人工知能はより多くの分野でその強力な可能性を発揮し、人間社会により良い未来をもたらすと信じています。