Downcodes の編集者は、Nvidia の最新の Blackwell プラットフォームが MLPerf Training 4.1 ベンチマーク テストで驚くべきパフォーマンスを示し、そのパフォーマンスが前世代の Hopper プラットフォームを大幅に上回っていることを知りました。テスト結果は、Blackwell が複数のベンチマーク テストで大幅なパフォーマンス向上を達成したことを示しており、これは業界で幅広い注目を集めており、AI アクセラレータ テクノロジの新たな進歩を告げています。具体的には、Blackwell は LLM の微調整と事前トレーニング タスクにおいて印象的な利点を実証し、AI 分野の発展に新たな可能性をもたらしました。

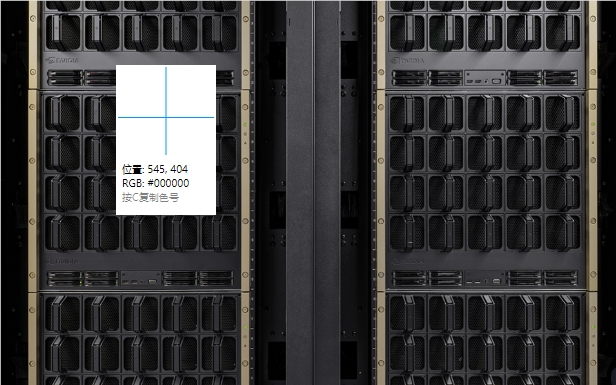

最近、NVIDIA は新しい Blackwell プラットフォームをリリースし、MLPerf Training4.1 ベンチマーク テストで予備的なパフォーマンスを実証しました。テスト結果によると、Blackwell のパフォーマンスは、前世代の Hopper プラットフォームに比べていくつかの面で 2 倍になっており、この結果は業界で広く注目を集めています。

MLPerf Training4.1 ベンチマークでは、Blackwell プラットフォームは、LLM (Large Language Model) ベンチマークの Llama270B 微調整タスクで GPU あたりの Hopper の 2.2 倍のパフォーマンスを達成し、GPT-3175B の事前トレーニングで 2.2 倍のパフォーマンスを達成しました。改善。さらに、Stable Diffusion v2トレーニングなどの他のベンチマークテストでも、新世代Blackwellは前世代製品を1.7倍上回りました。

特に、Hopper は引き続き改善を示していますが、MLPerf Training ベンチマークの前回のラウンドと比較して、言語モデルの事前トレーニングのパフォーマンスも 1.3 倍向上しています。これは、Nvidia のテクノロジーが向上し続けていることを示しています。最近の GPT-3175B ベンチマークでは、Nvidia は 11,616 個の Hopper GPU を提出し、新しいスケーリング記録を樹立しました。

Blackwellの技術的詳細に関してNvidiaは、新しいアーキテクチャでは最適化されたTensorコアとより高速な高帯域幅メモリが使用されていると述べた。これにより、GPT-3175B ベンチマークはわずか 64 GPU で実行できるようになりますが、Hopper プラットフォームを使用すると同じパフォーマンスを達成するには 256 GPU が必要になります。

Nvidiaはまた、記者会見でソフトウェアとネットワークのアップデートにおけるHopper世代の製品のパフォーマンスの向上を強調しており、Blackwellは今後の提出物によってさらに改善されることが期待されている。さらに、NVIDIA は来年、より多くのメモリとより強力なコンピューティング能力を提供する次世代 AI アクセラレータ Blackwell Ultra を発売する予定です。

Blackwell は、昨年 9 月に MLPerf Inference v4.1 ベンチマークでもデビューし、特に低い FP4 精度を使用した AI 推論において、GPU あたりの H100 の 4 倍という驚異的なパフォーマンスを達成しました。この新しいトレンドは、低遅延チャットボットや OpenAI の o1 モデルのようなインテリジェント コンピューティングに対する需要の高まりに対処することを目的としています。

Blackwell プラットフォームの優れたパフォーマンスは、AI アクセラレータ テクノロジの大きな進歩を示しており、LLM トレーニングと推論におけるパフォーマンスの向上により、AI テクノロジの開発と応用が大幅に促進されます。 Downcodes の編集者は、今後も Blackwell プラットフォームのその後の発展に注目し、より多くの関連レポートを提供していきます。