iFlytekは、iFlytekの大規模なマルチモーダルインタラクティブモデルをリリースし、人工知能の分野における新たなマイルストーンをマークしました。このモデルは、これまでの単一音声インタラクションの限界を打ち破り、音声、ビジュアル、デジタルによる人間のインタラクションのシームレスな統合を実現し、より鮮明でリアルで便利なインタラクティブ体験をユーザーにもたらします。 Downcodes の編集者は、この驚くべきマルチモーダル インタラクション モデルの機能と利点、そしてそれが人工知能との対話方法をどのように変えるのかを深く理解することができます。

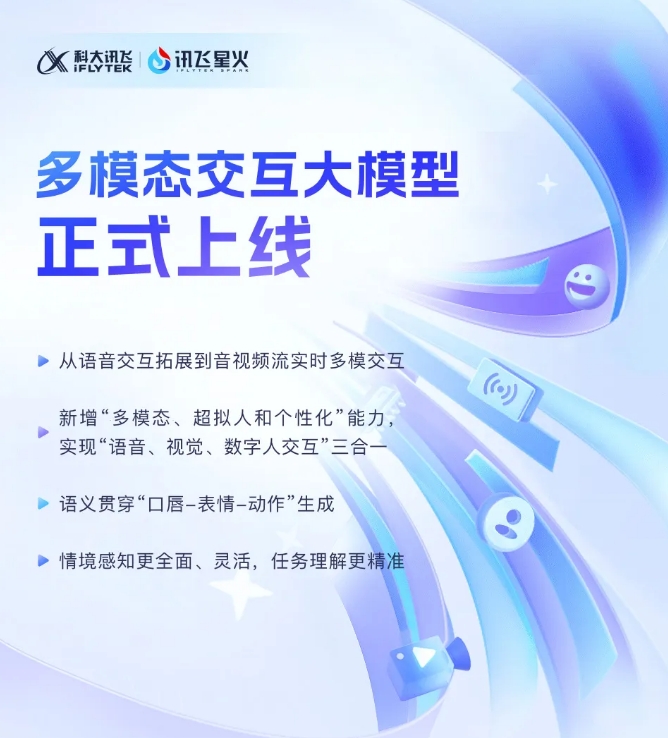

iFlytekは最近、新しく開発されたiFlytek Sparkマルチモーダル・インタラクティブ大型モデルが正式に運用開始されたと発表しました。この技術的ブレークスルーは、iFlytek を単一の音声インタラクション技術から、オーディオおよびビデオ ストリームのリアルタイム マルチモーダル インタラクションという新しい段階に拡張することを示しています。新モデルは音声、ビジュアル、デジタルヒューマンインタラクション機能を統合しており、ユーザーはワンクリックでこれら3つのシームレスな統合を実現できる。

iFlytek のマルチモーダル インタラクティブ モデルの発表により、超擬人化デジタル ヒューマン テクノロジーが初めて導入されました。このテクノロジーは、デジタル ヒューマンの胴体と四肢の動きを音声コンテンツと正確に一致させ、表情や動きを迅速に生成し、大幅に改善することができます。 AIの鮮やかさとリアルさ。新しいモデルは、テキスト、音声、表現を統合することで、クロスモーダルな意味の一貫性を実現し、感情表現をより現実的かつ一貫したものにすることができます。

さらに、iFlytek Spark は超擬人化超高速インタラクション テクノロジーをサポートし、統合ニューラル ネットワークを使用して音声間のエンドツーエンドのモデリングを直接実現し、応答をより速く、よりスムーズにします。この技術は、感情の変化を敏感に感知し、指示に従って音のリズム、大きさ、個性を自由に調整することができ、よりパーソナライズされたインタラクティブ体験を提供します。

マルチモーダルな視覚的インタラクションの観点から、iFlytek Spark は「世界を理解」し、「すべてを認識」することができ、特定の背景シーン、物流状況、その他の情報を包括的に認識し、タスクの理解をより正確にします。音声、ジェスチャー、行動、感情などのさまざまな情報を統合することで、モデルが適切な応答を行い、より豊かで正確なインタラクティブ体験をユーザーに提供します。

マルチモーダル対話型大規模モデル SDK: https://www.xfyun.cn/solutions/Multimodel

iFlytek Spark マルチモーダル インタラクティブ大型モデルの登場は、人工知能テクノロジーがよりインテリジェントで人道的な方向に発展していることを示しています。その強力な機能と便利な操作は、ユーザーに新たなインタラクティブ体験をもたらし、あらゆる人々に無限の可能性をもたらすでしょう。 iFlytek Spark が今後さらに驚きをもたらすことを楽しみにしています。