ChatGPT や Wenxinyiyan などの AI 製品の背後にあるテクノロジーに興味がありますか?これらはすべて大規模言語モデル (LLM) に依存しています。 Downcodes のエディターは、LLM の動作原理をシンプルかつわかりやすい方法で理解できるようにします。2 年生の数学レベルしか持っていない人でも、簡単に理解できます。ニューラル ネットワークの基本概念から始めて、LLM を明確に理解できるように、モデル トレーニング、高度なテクニック、GPT や Transformer アーキテクチャなどのコア テクノロジーについて徐々に説明します。

ChatGPT や Wen Xinyiyan などの高度な AI について聞いたことがありますか? その背後にあるコア技術は「ラージ言語モデル」(LLM) です。複雑で理解するのが難しいと感じていませんか? 心配しないでください。たとえ 2 年生の数学レベルしか持っていないとしても、この記事を読めば LLM の動作原理を簡単に理解できるでしょう。

ニューラル ネットワーク: 数字の魔法

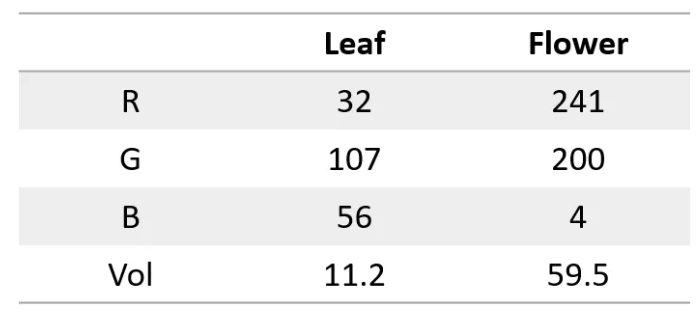

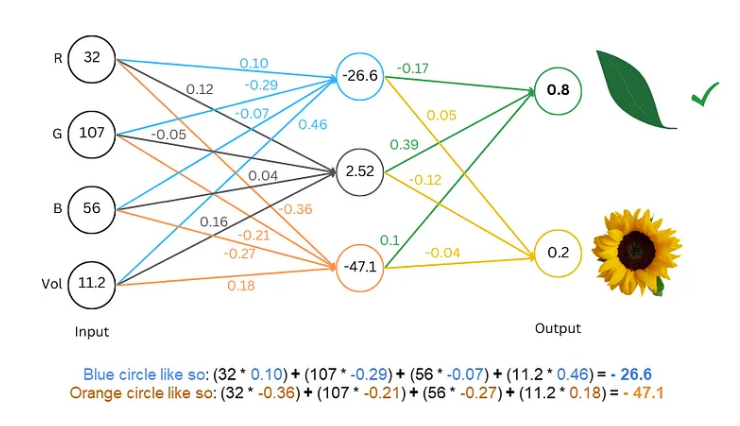

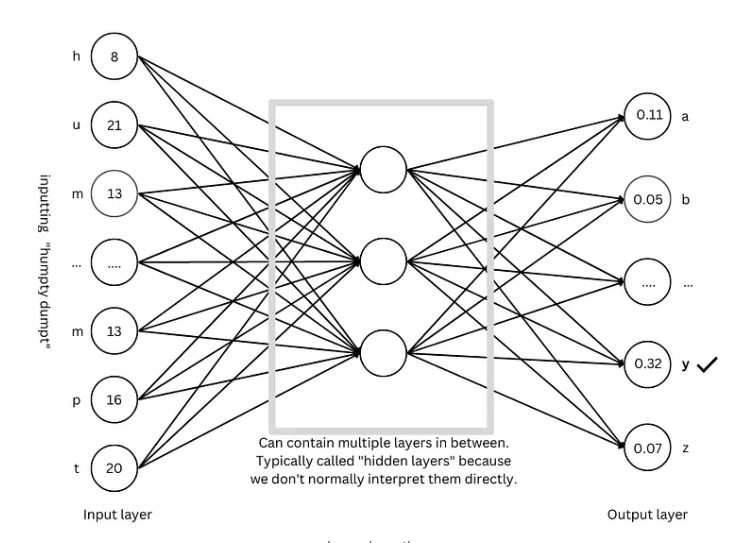

まず、ニューラル ネットワークはスーパーコンピューターのようなもので、数値しか処理できないことを知っておく必要があります。入力と出力は両方とも数値である必要があります。では、どうすればテキストを理解できるようになるのでしょうか?

秘密は単語を数字に変換することです。たとえば、a=1、b=2 などのように、各文字を数字で表すことができます。このようにして、ニューラル ネットワークはテキストを「読み取る」ことができます。

モデルのトレーニング: ネットワークに言語を「学習」させます

デジタル テキストの場合、次のステップはモデルをトレーニングし、ニューラル ネットワークに言語のルールを「学習」させることです。

トレーニング プロセスは、推測ゲームをプレイするようなものです。 「ハンプティ・ダンプティ」などのテキストをネットワークに見せて、次の文字が何であるかを推測してもらいます。推測が正しければ報酬を与え、推測が間違っていればペナルティを与えます。常に推測と調整を続けることで、ネットワークは次の文字をますます正確に予測できるようになり、最終的には「ハンプティ ダンプティは壁に座っていました」などの完全な文を生成します。

高度なテクニック: モデルをより「スマート」にする

モデルをより「スマート」にするために、研究者は次のような多くの高度な技術を発明しました。

単語の埋め込み: 単純な数値を使用して文字を表すのではなく、一連の数値 (ベクトル) を使用して各単語を表すことで、単語の意味をより完全に説明できます。

サブワード セグメンター: 単語をより小さな単位 (サブワード) に分割します。たとえば、「cat」を「cat」と「s」に分割することで、語彙を減らし効率を向上させることができます。

自己注意メカニズム: モデルが次の単語を予測するとき、私たちが読書するときに文脈に基づいて単語の意味を理解するのと同じように、文脈内のすべての単語に基づいて予測の重みが調整されます。

残留接続: ネットワーク層が多すぎることによって引き起こされるトレーニングの困難を避けるために、研究者はネットワークの学習を容易にする残留接続を発明しました。

マルチヘッド アテンション メカニズム: 複数のアテンション メカニズムを並行して実行することで、モデルはさまざまな観点からコンテキストを理解し、予測の精度を向上させることができます。

位置エンコーディング: モデルが単語の順序を理解できるようにするために、研究者は、私たちが読むときに単語の順序に注意を払うのと同じように、単語の埋め込みに位置情報を追加します。

GPT アーキテクチャ: 大規模言語モデルの「青写真」

GPT アーキテクチャは、現在最も人気のある大規模言語モデル アーキテクチャの 1 つであり、モデルの設計とトレーニングをガイドする「青写真」のようなものです。 GPT アーキテクチャは、上記の高度な技術を巧みに組み合わせて、モデルが言語を効率的に学習および生成できるようにします。

Transformer アーキテクチャ: 言語モデルの「革命」

Transformer アーキテクチャは、近年の言語モデルの分野における大きな進歩であり、予測の精度を向上させるだけでなく、トレーニングの難易度を軽減し、大規模な言語モデルの開発の基礎を築きます。 GPT アーキテクチャも、Transformer アーキテクチャに基づいて進化しました。

参考: https://towardsdatascience.com/ Understanding-llms-from-scratch-using-middle-school-math-e602d27ec876

Downcodes の編集者による説明が、大規模言語モデルの動作原理を理解するのに役立つことを願っています。 もちろん、LLM テクノロジーはまだ発展途上にあります。この記事は氷山の一角にすぎません。さらに詳細な内容については、学習と探索を続ける必要があります。