Downcodes の編集者は、Allen Institute for Artificial Intelligence (Ai2) が最近、新しいオープンソースのマルチモーダル AI モデル ファミリである Molmo をリリースしたことを知りました。そのパフォーマンスは驚くべきもので、複数のサードパーティ ベンチマーク テストで OpenAI の GPT-4o や Anthropic のパフォーマンスをも上回っています。 .Claude3.5SonnetとGoogleのGemini1.5。 Molmo は、ユーザーがアップロードした画像を分析するだけでなく、独自のトレーニング技術のおかげで、トレーニング中に使用するデータの量が競合他社と比べて 1,000 分の 1 になります。この画期的な進歩は、Ai2 のオープンリサーチへの取り組みを実証し、高性能モデル、オープンウェイト、データをより広範なコミュニティや企業が利用できるようにしています。

モルモは、分析のためにユーザーがアップロードした画像を受け入れるだけでなく、独自のトレーニング技術のおかげで、トレーニングに「競合他社よりも 1,000 倍少ないデータ」を使用します。

このリリースは、オープンな研究に対する Ai2 の取り組みを示しており、より広範なコミュニティや企業が使用できるオープンな重みとデータを備えた高性能モデルを提供しています。 Molmo ファミリには、Molmo-72B、Molmo-7B-D、Molmo-7B-O、MolmoE-1B の 4 つの主要モデルがあり、Molmo-72B は 72 億のパラメータを含むフラッグシップ モデルであり、そのパフォーマンスは特に優れています。

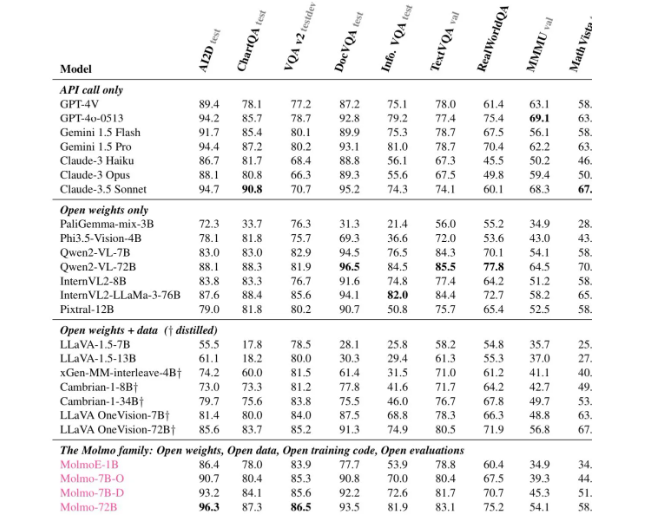

さまざまな評価によると、Molmo-72B は 11 の重要なベンチマークで最高のスコアを獲得し、ユーザーの好みの点では -4o に次ぐ 2 位にランクされました。 Ai2 は、費用対効果を向上させるために「小規模モデルの組み合わせ」アプローチを使用した OLMoE モデルも発売しました。

Molmo のアーキテクチャは、効率と優れたパフォーマンスを実現するために慎重に設計されています。すべてのモデルは、OpenAI の ViT-L/14336px CLIP モデルをビジュアル エンコーダーとして使用し、マルチスケール イメージをビジュアル コマンドに処理します。言語モデル部分はデコーダー Transformer であり、さまざまな容量とオープン性があります。

トレーニングに関しては、Mol は 2 段階のトレーニングを受けます。1 つ目はマルチモデルの事前トレーニングで、2 つ目は教師あり微調整です。多くの最新モデルとは異なり、Molmo は人間のフィードバックによる強化学習に依存せず、慎重に調整されたトレーニング プロセスを通じてモデル パラメーターを更新します。

Molmo は、複数のベンチマーク、特に文書の読み取りや視覚的推論などの複雑なタスクで良好なパフォーマンスを示し、その強力な機能を実証しました。 Ai2 はこれらのモデルとデータセットを Hugging Face でリリースしており、研究者により多くのリソースを提供するために、今後数か月以内にさらに多くのモデルと拡張技術レポートをリリースする予定です。

Molmo の機能について知りたい場合は、Molmo の公式 Web サイト (https://molmo.allenai.org/) から公開デモンストレーションを利用できるようになりました。

ハイライト:

Ai2Molmo のオープンソース モーダル AI モデルは、業界トップの製品を超えています。

? Mol-72B は、複数のベンチマークで GPT4o に次ぐ良好なパフォーマンスを示します。

オープン性が高く、研究者はモデルやデータセットを自由に使用できます。

全体として、Molmo の登場はマルチモーダル AI 分野における大きな進歩を示しており、そのオープンソースの性質は世界中の研究者に貴重なリソースも提供します。 Downcodes の編集者は、Molmo が今後さらに広く使用および開発され、AI テクノロジーの継続的な進歩が促進されることを期待しています。