GPT-4V は、「写真を見て話す」として知られる人工物ですが、グラフィカル インターフェイスの理解が欠けているとして批判されています。 これは、頻繁に間違ったボタンをクリックする「画面盲人」のようなもので、腹立たしいです。しかし、Microsoft がリリースした OmniParser モデルは、この問題を完全に解決すると期待されています。 OmniParser は「スクリーン トランスレーター」のようなもので、スクリーンショットを GPT-4V の理解しやすい構造化言語に変換し、GPT-4V の「視覚」をより鋭くします。 Downcodes の編集者は、この魔法のモデルを深く理解し、GPT-4V が「目の見えなさ」という欠点を克服するのにどのように役立つのか、そしてその背後にある驚くべきテクノロジーを紹介します。

GPT-4V という「絵を見て話す」という機能をまだ覚えていますか? それは絵の内容を理解し、絵に基づいてタスクを実行することができます。しかし、これには致命的な問題があります。弱点:視力があまり良くない!

GPT-4V にボタンをクリックするように指示すると、「スクリーン ブラインド」のようにあちこちでクリックされることを想像してください。

今日は、GPT-4V の見栄えを良くするアーティファクト、 OmniParser を紹介します。これは、グラフィカル ユーザー インターフェイス (GUI) の自動対話の問題を解決することを目的として、Microsoft によってリリースされた新しいモデルです。

オムニパーサーは何をするのですか?

簡単に言うと、OmniParser は、スクリーンショットを GPT-4V が理解できる「構造化言語」に解析できる「スクリーン トランスレーター」です。 OmniParser は、微調整された対話型アイコン検出モデル、微調整されたアイコン記述モデル、および OCR モジュールの出力を組み合わせます。

この組み合わせにより、UI の構造化された DOM のような表現と、対話可能な要素の境界ボックスをカバーするスクリーンショットが生成されます。研究者らはまず、一般的な Web ページとアイコン説明データセットを使用して、インタラクティブなアイコン検出データセットを作成しました。これらのデータセットは、画面上の対話可能な領域を解析するための検出モデルと、検出された要素の機能セマンティクスを抽出するための記述モデルという特殊なモデルを微調整するために使用されます。

具体的には、OmniParser は次のことを行います。

画面上のすべてのインタラクティブなアイコンとボタンを識別し、ボックスでマークし、各ボックスに一意の ID を割り当てます。

「設定」や「最小化」など、各アイコンの機能をテキストで説明します。画面上のテキストを認識して抽出します。

このようにして、GPT-4V は、クリックしたいボタンの ID を伝えるだけで、画面上に何が表示され、それぞれが何を行うのかを明確に知ることができます。

OmniParser はどれほど素晴らしいのでしょうか?

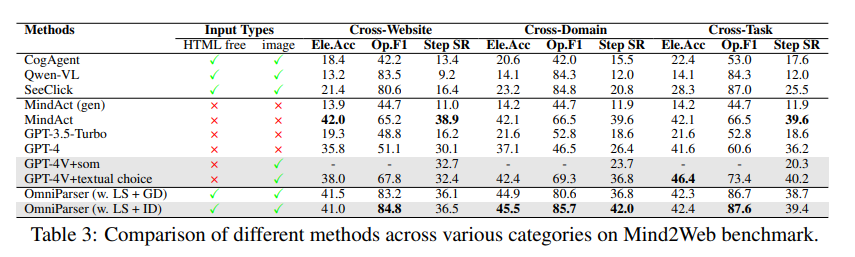

研究者はさまざまなテストを使用して OmniParser をテストし、それが GPT-4V を本当に「改善」できることを発見しました。

ScreenSpot テストでは、OmniParser は GPT-4V の精度を大幅に向上させ、グラフィカル インターフェイス用に特別にトレーニングされた一部のモデルをも上回りました。たとえば、ScreenSpot データセットでは、OmniParser は精度を 73% 向上させ、基盤となる HTML 解析に依存するモデルを上回りました。特に、UI 要素のローカル セマンティクスを組み込むことで、予測精度が大幅に向上しました。OmniParser の出力を使用した場合、GPT-4V のアイコンは 70.5% から 93.8% に正しくラベル付けされました。

Mind2Web テストでは、OmniParser は Web ブラウジング タスクにおける GPT-4V のパフォーマンスを向上させ、その精度は HTML 情報支援を使用する GPT-4V をも上回りました。

AITW テストでは、OmniParser は携帯電話のナビゲーション タスクにおける GPT-4V のパフォーマンスを大幅に向上させました。

OmniParser の欠点は何ですか?

OmniParser は非常に強力ですが、次のような小さな欠陥もあります。

アイコンやテキストが繰り返されると混乱しやすく、それらを区別するにはより詳細な説明が必要です。

場合によっては、フレームが十分に正確に描画されず、GPT-4V が間違った位置でクリックしてしまうことがあります。

アイコンの解釈は時々誤る場合があり、より正確に説明するにはコンテキストが必要です。

しかし、研究者たちは OmniParser の改良に熱心に取り組んでおり、OmniParser がますます強力になり、最終的には GPT-4V の最良のパートナーになると信じています。

モデルのエクスペリエンス: https://huggingface.co/microsoft/OmniParser

論文の入り口: https://arxiv.org/pdf/2408.00203

公式紹介: https://www.microsoft.com/en-us/research/articles/omniparser-for-pure-vision-based-gui-agent/

ハイライト:

✨OmniParser は、GPT-4V が画面の内容をよりよく理解し、タスクをより正確に実行するのに役立ちます。

OmniParser はさまざまなテストで良好なパフォーマンスを示し、その有効性が証明されました。

?️OmniParser にはまだ改善の余地がありますが、将来には期待が持てます。

全体として、OmniParser は GPT-4V とグラフィカル ユーザー インターフェイスの対話に革命的な改善をもたらします。まだまだ不足点はありますが、そのポテンシャルは大きく、今後の発展が期待されます。 Downcodes の編集者は、テクノロジーの継続的な進歩により、OmniParser が人工知能の分野で輝く星になると信じています。