近年、Transformer モデルとそのアテンション メカニズムは大規模言語モデル (LLM) の分野で大きな進歩を遂げましたが、無関係な情報からの干渉を受けやすいという問題は常に存在していました。 Downcodes の編集者が最新の論文を解釈します。この論文では、差動トランス (DIFF トランス) と呼ばれる新しいモデルが提案されています。このモデルは、トランス モデルにおける注意ノイズの問題を解決し、モデルの効率と精度を向上させることを目的としています。このモデルは、革新的な差分注意メカニズムを通じて無関係な情報を効果的に除外し、モデルが重要な情報にさらに集中できるようにし、それによって言語モデリング、長いテキスト処理、重要な情報の検索、モデルの錯覚の削減などの複数の側面で大幅な改善を達成します。 。

大規模言語モデル (LLM) は最近急速に発展しており、そこでは Transformer モデルが重要な役割を果たしています。 Transformer の中核はアテンション メカニズムです。これは情報フィルターのように機能し、モデルが文の最も重要な部分に焦点を当てることができます。しかし、たとえ強力なトランスフォーマーであっても、図書館で本を探しているのに、無関係な本の山に圧倒されるのと同じように、無関係な情報によって妨害され、当然効率は低くなります。

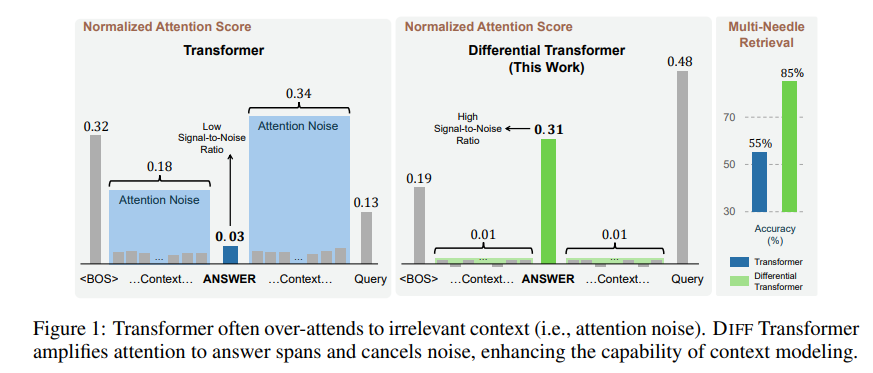

この注意メカニズムによって生成される無関係な情報を、論文では注意ノイズと呼びます。ファイル内の重要な情報を見つけたいのに、重要なポイントが見えない近視眼的な人のように、Transformer モデルの注意が無関係なさまざまな場所に分散されていると想像してください。

この問題を解決するために、本論文では差動トランス(DIFFトランス)を提案します。名前は非常に高度ですが、実際の原理はノイズキャンセリングヘッドフォンと同じように、2つの信号の差によってノイズを除去します。

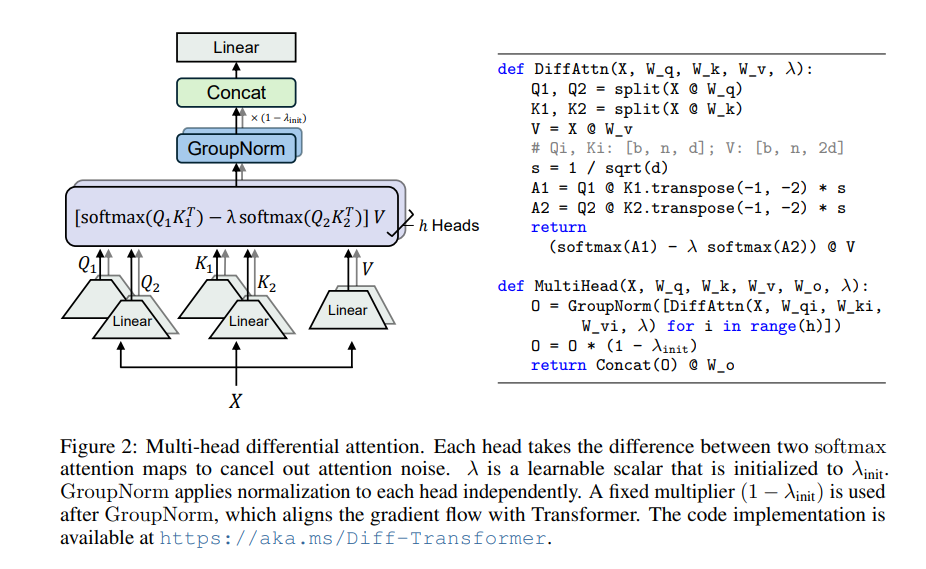

Differential Transformer の核心は、差動アテンション メカニズムです。クエリ ベクトルとキー ベクトルを 2 つのグループに分割し、それぞれ 2 つのアテンション マップを計算し、これら 2 つのマップを減算して最終的なアテンション スコアを取得します。このプロセスは、2 台のカメラで同じオブジェクトを撮影し、その後 2 枚の写真を重ね合わせるようなもので、違いが強調表示されます。

このようにして、Differential Transformer は注意ノイズを効果的に排除し、モデルが重要な情報にさらに集中できるようにします。ノイズキャンセリングヘッドホンを装着したときと同じように、周囲の騒音が消え、聞きたい音がよりクリアに聞こえます。

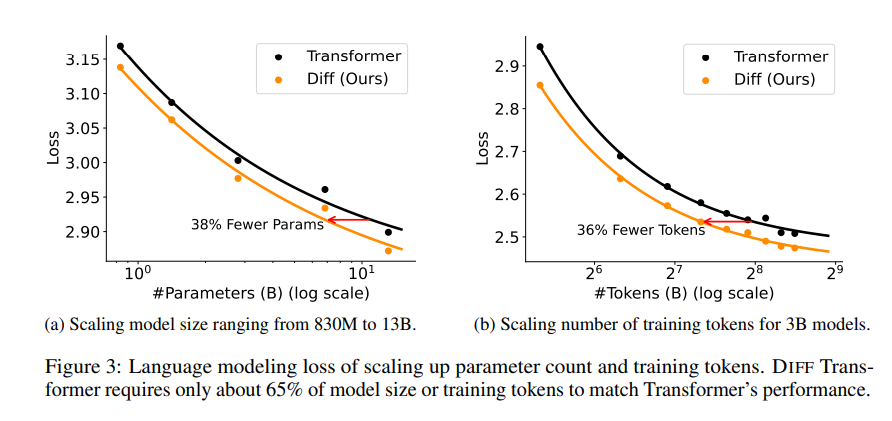

論文では、差動トランスの優位性を証明するために一連の実験が行われました。まず、言語モデリングで優れたパフォーマンスを発揮し、同様の結果を達成するために必要なモデル サイズまたはトレーニング データは Transformer の 65% だけです。

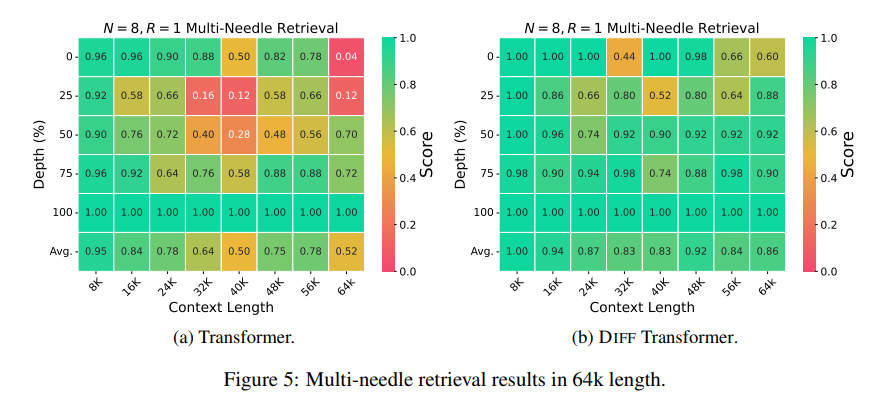

次に、Differential Transformer は長いテキストのモデリングにも優れており、より長いコンテキスト情報を効果的に利用できます。

さらに重要なことは、Differential Transformer は、重要な情報の取得、モデルの錯覚の軽減、およびコンテキストの学習において大きな利点を示していることです。

重要な情報の検索に関しては、Differential Transformer は、大量の情報の中から必要なものを正確に見つけることができる正確な検索エンジンのようなもので、非常に複雑な情報が含まれるシナリオでも高い精度を維持できます。

モデルの幻覚を減らすという点では、Differential Transformer はモデルの「ナンセンス」を効果的に回避し、より正確で信頼性の高いテキストの要約と質問と回答の結果を生成できます。

コンテキスト学習の観点から見ると、Differential Transformer は学習のマスターに近く、サンプルの順序に影響されにくい Transformer とは異なり、少数のサンプルから新しい知識を迅速に学習でき、学習効果がより安定しています。 。

さらに、Differential Transformer は、モデルのアクティベーション値の外れ値を効果的に削減することもできます。これは、モデルの量子化がより容易で、より低ビットの量子化を実現できることを意味し、それによってモデルの効率が向上します。

全体として、Differential Transformer は、差動アテンション メカニズムを通じて Transformer モデルのアテンション ノイズ問題を効果的に解決し、複数の側面で大幅な改善を実現します。これは大規模な言語モデルの開発に新しいアイデアを提供し、将来的にはより多くの分野で重要な役割を果たすでしょう。

論文アドレス: https://arxiv.org/pdf/2410.05258

全体として、Differential Transformer は、Transformer モデルのアテンション ノイズ問題を解決する効果的な方法を提供します。その優れたパフォーマンスは、将来の大規模な言語モデルの開発において重要な位置を占めることを示しています。 Downcodes の編集者は、技術的な詳細と応用の見通しを深く理解するために論文全文を読むことを読者に推奨しています。 差動トランスが人工知能の分野にさらなるブレークスルーをもたらすことを楽しみにしています。