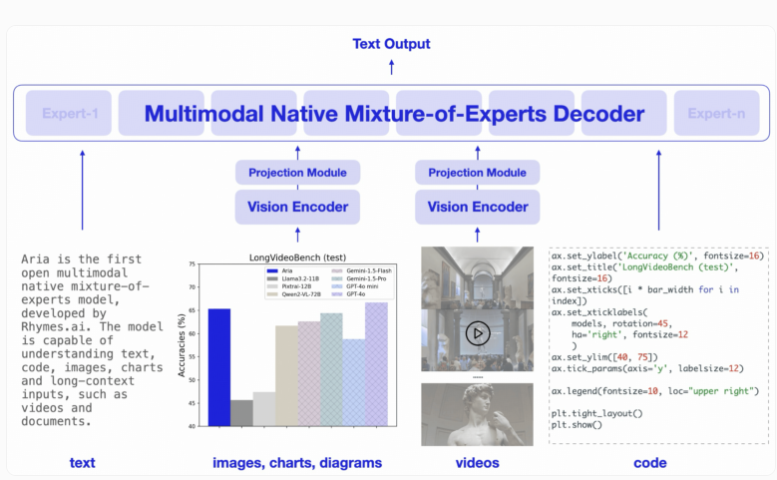

東京を拠点とするスタートアップ Rhymes AI は、同社初の人工知能モデル、オープンソースのマルチモーダル ハイブリッド エキスパート (MoE) モデルである Aria をリリースしました。 Downcodes の編集者は、Aria がテキスト、コード、画像、ビデオなどのさまざまな入力の処理に優れたパフォーマンスを発揮し、その機能がいくつかの有名なビジネス モデルをも上回ることを知りました。 Aria は、独自の MoE アーキテクチャを使用して、複数の専門家による計算効率を向上させ、最大 249 億のパラメータと 64,000 のトークンのマルチモーダル コンテキスト ウィンドウを備えており、より長い入力データを処理できます。 Rhymes AI はまた、AMD と協力してモデルのパフォーマンスを最適化し、AMD ハードウェアに基づいた BeaGo 検索アプリケーションを開始しました。

Aria は、テキスト、コード、画像、ビデオなどのさまざまな入力形式にわたって優れた理解と処理機能を提供するように設計されています。従来の Transformer モデルとは異なり、MoE モデルはフィードフォワード層を複数の専門家に置き換えます。各入力トークンを処理する際、ルーティング モジュールはアクティブ化するエキスパートのサブセットを選択するため、計算効率が向上し、トークンあたりのアクティブ化パラメータの数が削減されます。

Aria のデコーダーはテキスト トークンごとに 35 億のパラメーターをアクティブにすることができ、モデル全体には 249 億のパラメーターがあります。ビジュアル入力を処理するために、Aria は、さまざまな長さ、サイズ、アスペクト比のビジュアル入力をビジュアル トークンに変換できる 4 億 3,800 万のパラメーターを備えた軽量ビジュアル エンコーダーも設計しました。さらに、Aria のマルチモーダル コンテキスト ウィンドウは 64,000 トークンに達し、より長い入力データを処理できることになります。

トレーニングに関しては、Rhymes AI は 4 つの段階に分かれています。最初にテキスト データを使用して事前トレーニングを行い、次にマルチモーダル データを導入し、次に長いシーケンスのトレーニングを行い、最後に微調整を行います。

このプロセスでは、Aria は事前トレーニングに合計 6 兆 4,000 億のテキスト トークンと 4,000 億のマルチモーダル トークンを使用しました。データは Common Crawl や LAION などの有名なデータセットから取得され、いくつかの合成強化が実行されました。

関連するベンチマーク テストによると、Aria は複数のマルチモーダル、言語、プログラミング タスクにおいて Pixtral-12B や Llama-3.2-11B などのモデルを上回り、アクティベーション パラメーターが少ないため推論コストが低くなります。

さらに、Aria は、字幕付きのビデオや複数ページのドキュメントを処理するときに優れたパフォーマンスを発揮し、長いビデオやドキュメントを理解する能力は、GPT-4o mini や Gemini1.5Flash などの他のオープンソース モデルを上回ります。

使いやすさを考慮して、Rhymes AI は Apache2.0 ライセンスに基づいて GitHub で Aria のソース コードをリリースし、学術的および商用利用をサポートしています。同時に、単一の GPU 上で複数のデータ ソースと形式に合わせて Aria を微調整できるトレーニング フレームワークも提供します。 Rhymes AI がモデルのパフォーマンスを最適化するために AMD と協力し、AMD ハードウェア上で実行してより包括的なテキストおよび画像 AI 検索結果をユーザーに提供できる BeaGo と呼ばれる検索アプリケーションを実証したことは注目に値します。

ハイライト:

Aria は、世界初のオープンソースのマルチモーダル ハイブリッド エキスパート AI モデルです。

Aria は、テキスト、画像、ビデオなどのさまざまな入力を処理する際に、多くの同等モデルよりも優れたパフォーマンスを発揮します。

? Rhymes AI は AMD と協力してモデルのパフォーマンスを最適化し、複数の機能をサポートする BeaGo 検索アプリケーションを起動します。

全体として、Aria モデルのオープンソースと高性能は、人工知能の分野に新たなブレークスルーをもたらし、開発者や研究者に強力なツールを提供しました。そのマルチモーダル機能と高い計算効率により、将来のアプリケーションに大きな可能性をもたらします。 Downcodes の編集者は、Aria のより多くの分野での応用と開発を楽しみにしています。