最近、Downcodes の編集者は、医療業界で広く使用されている OpenAI の Whisper テクノロジーをベースにした AI 文字起こしツールに「幻覚」があり、虚偽のコンテンツを生成する可能性があることが判明したという憂慮すべきニュースに注目しました。これにより、医療分野におけるAI技術の安全性と信頼性に対する懸念が生じています。この記事では、このインシデントを詳細に分析し、その潜在的なリスクと OpenAI の対応を探ります。

最近、OpenAI の Whisper テクノロジーを活用した AI 文字起こしツールが医療業界で人気を集めています。多くの医師や医療機関がこのツールを使用して、患者との面談を記録し、要約しています。

ABCニュースの報道によると、研究者らはこのツールが場合によっては「幻覚」を引き起こし、場合によってはコンテンツを完全に捏造する可能性があることを発見したという。

Nabla という会社が開発したこの文字起こしツールは、700 万件を超える医療会話の文字起こしに成功し、現在 30,000 人以上の臨床医と 40 の医療システムで使用されています。それでも、ナブラ氏はウィスパーが幻覚を起こす可能性を認識しており、この問題に対処するために取り組んでいると述べた。

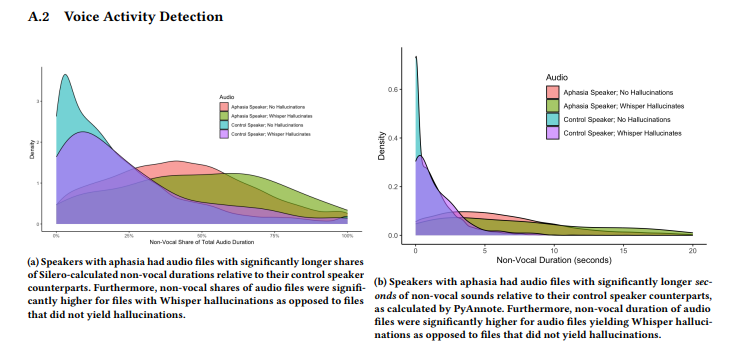

コーネル大学やワシントン大学などの研究者チームが行った研究では、ウィスパーの転写の約1%で幻覚が見られたことが判明した。このような場合、このツールは録音中の無音部分に意味のないフレーズをランダムに生成し、場合によっては激しい感情を表現します。研究者らはTalkBankのAphasiaBankから音声サンプルを収集し、言語障害を持つ人々が話すときに沈黙が特に一般的であることに注目した。

コーネル大学の研究者アリソン・コーネッケ氏は、ウィスパーによって生成された幻覚コンテンツを示すいくつかの例をソーシャルメディアで共有しました。研究者らは、このツールによって生成されたコンテンツには、作られた医療用語や、YouTube 動画の言葉のように聞こえる「ご視聴ありがとうございます!」のようなフレーズも含まれていることを発見しました。

この研究は6月にブラジルで開催されたコンピューティング機械協会のFAccT会議で発表されたが、査読を受けたかどうかは不明である。この問題に関して、OpenAIの広報担当者タヤ・クリスチャンソン氏は「The Verge」のインタビューで、この問題を非常に深刻に受け止めており、特に幻覚の減少など、改善に向けて努力を続けると述べた。同時に彼女は、API プラットフォームで Whisper を使用する場合、特定のリスクの高い意思決定環境でのツールの使用を禁止する明確な使用ポリシーがあることにも言及しました。

ハイライト:

Whisper 文字起こしツールは医療業界で広く使用されており、700 万件の医療会話を記録しています。

⚠️ 研究によると、Whisper は転写の約 1% で「幻覚」を起こし、意味のないコンテンツを生成することがあります。

OpenAIは、特に幻覚の軽減においてツールのパフォーマンスの向上に取り組んでいると述べた。

全体として、AI テクノロジーは医療分野での応用が期待されていますが、多くの課題にも直面しています。 Whisper の「幻覚」現象の出現は、医療分野での安全かつ効果的な適用を確保し、患者の権利と安全を保護するために、AI テクノロジーを慎重に扱い、その安全性と信頼性の監督を強化する必要があることを思い出させます。 『Downcodes』編集部は今後もこの事件のその後の展開に注目していきたい。