大規模言語モデル (LLM) の「ブラック ボックス」の性質は、常に人工知能の分野を悩ませている重要な問題です。モデルの出力結果が解釈できないため、その信頼性と信頼性を保証することが困難になります。この問題を解決するために、OpenAI は Prover-Verifier Games (PVG) と呼ばれる新しいテクノロジーを立ち上げました。これは、LLM 出力の解釈可能性と検証可能性を向上させることを目的としています。 Downcodes の編集者がこのテクノロジーについて詳しく説明します。

OpenAI は最近、人工知能モデル出力の「ブラック ボックス」問題を解決することを目的とした Prover-Verifier Games (PVG) と呼ばれる新しいテクノロジーをリリースしました。

非常にインテリジェントなアシスタントがいると想像してください。しかし、その思考プロセスはブラックボックスのようなもので、どうやって結論に達するのかまったくわかりません。これは少し不安に思えますか? はい、これは多くの大規模言語モデル (LLM) が現在直面している問題です。強力ではありますが、生成されるコンテンツの正確性を検証するのは困難です。

論文の URL: https://cdn.openai.com/prover-verifier-games-improve-legibility-of-llm-outputs/legibility.pdf

この問題を解決するために、OpenAI は PVG テクノロジーを立ち上げました。簡単に言えば、小さなモデル (GPT-3 など) に大きなモデル (GPT-4 など) の出力を監視させることです。これは、ゲームをプレイするようなものです。証明者はコンテンツを生成する責任を負い、検証者はコンテンツが正しいかどうかを判断する責任を負います。面白そうですか?

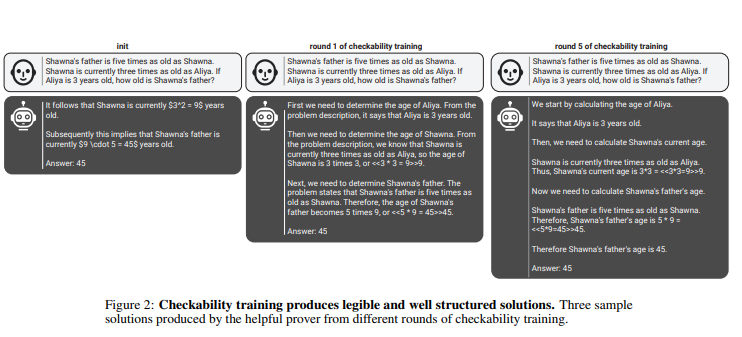

このルールでは、証明者と検証者は、複数ラウンドの反復トレーニングを通じて継続的に能力を向上させます。検証者は教師あり学習を使用してコンテンツの正しさを予測し、証明者は強化学習を使用して生成するコンテンツを最適化します。さらに興味深いことに、証明者には 2 つのタイプがあります。便利な証明者と狡猾な証明者です。有用な証明者は正しくて説得力のあるコンテンツを生成しようと努める一方、狡猾な証明者は不正確だが同様に説得力のあるコンテンツを生成しようとし、それによって検証者の判断に異議を唱えます。

PenAI は、効果的な検証モデルをトレーニングするには、その認識機能を向上させるために大量の実際の正確なラベル データが必要であることを強調しています。そうしないと、たとえ PVG テクノロジーが使用されていたとしても、検証されたコンテンツが違法に出力される危険性が依然としてある可能性があります。

ハイライト:

? PVG テクノロジーは、大規模なモデルの出力を小規模なモデルで検証することにより、AI の「ブラック ボックス」問題を解決します。

? トレーニング フレームワークはゲーム理論に基づいており、証明者と検証者の相互作用をシミュレートし、モデル出力の精度と制御性を向上させます。

? 十分な判断力と堅牢性を確保するために検証モデルをトレーニングするには、大量の実データが必要です。

全体として、OpenAI の PVG テクノロジーは、人工知能モデルの「ブラック ボックス」問題を解決するための新しいアイデアを提供しますが、その有効性は依然として高品質のトレーニング データに依存しています。 このテクノロジーの将来の開発は、より信頼性が高く、説明可能で信頼できる方向に人工知能モデルの開発を促進するため、期待に値します。 Downcodes の編集者は、同様の革新的なテクノロジーがさらに登場することを楽しみにしています。