Image-to-Video (I2V) 生成テクノロジーは、より現実的で制御されたビデオを作成することを目標に急速に進化しています。 Downcodes の編集者は本日、Motion-I2V と呼ばれる新しいフレームワークを紹介します。これは、明示的なモーション モデリングを通じて I2V 生成の分野で大きな進歩を遂げました。 Xiaoyu Shi 氏や Zhaoyang Huang 氏などの研究者によって開発されたこのフレームワークは、画像からビデオへの変換プロセスを 2 つの段階に分解し、モーション フィールド予測とモーション エンハンスメントのタイミング レイヤーを巧みに組み合わせて、より安定した高品質を実現するという点で革新的です。制御可能なビデオ生成。

人工知能技術の急速な発展に伴い、画像からビデオ (I2V) 生成技術が注目の研究テーマになっています。最近、Xiaoyu Shi 氏や Zhaoyang Huang 氏などの研究者で構成されるチームは、明示的なモーション モデリングを通じて、より一貫性があり制御可能な画像からビデオへの生成を実現する、Motion-I2V と呼ばれる新しいフレームワークを導入しました。この技術的進歩により、ビデオ生成の品質と一貫性が向上するだけでなく、ユーザーに前例のない制御エクスペリエンスが提供されます。

画像からビデオへの生成の分野では、生成されたビデオの一貫性と制御性をどのように維持するかが常に技術的な問題でした。従来の I2V メソッドは画像からビデオへの複雑なマッピングを直接学習しますが、Motion-I2V フレームワークは革新的にこのプロセスを 2 つの段階に分解し、両方の段階で明示的なモーション モデリングを導入します。

第 1 段階では、Motion-I2V は、参照画像ピクセルの軌跡の導出に焦点を当てた拡散ベースの動きフィールド予測子を提案します。この段階の鍵は、参照画像とテキスト キューを使用して、参照フレームと将来のすべてのフレームの間のモーション フィールド マップを予測することです。第 2 ステージは、参照画像のコンテンツを合成フレームに伝播する役割を果たします。新しいモーション拡張時間層を導入することにより、1 次元の時間的注意が強化され、時間的受容野が拡張され、複雑な時空間パターンを直接学習する複雑さが軽減されます。

既存の方法と比較すると、Motion-I2V には明らかな利点があります。 「高速で移動する戦車」、「高速で走行する青い BMW」、「3 つの透明な氷」、または「這うカタツムリ」などのシナリオであっても、Motion-I2V は、高品質の出力であっても、より一貫したビデオを生成します。幅広い動きや視野角の変化の下でも維持されます。

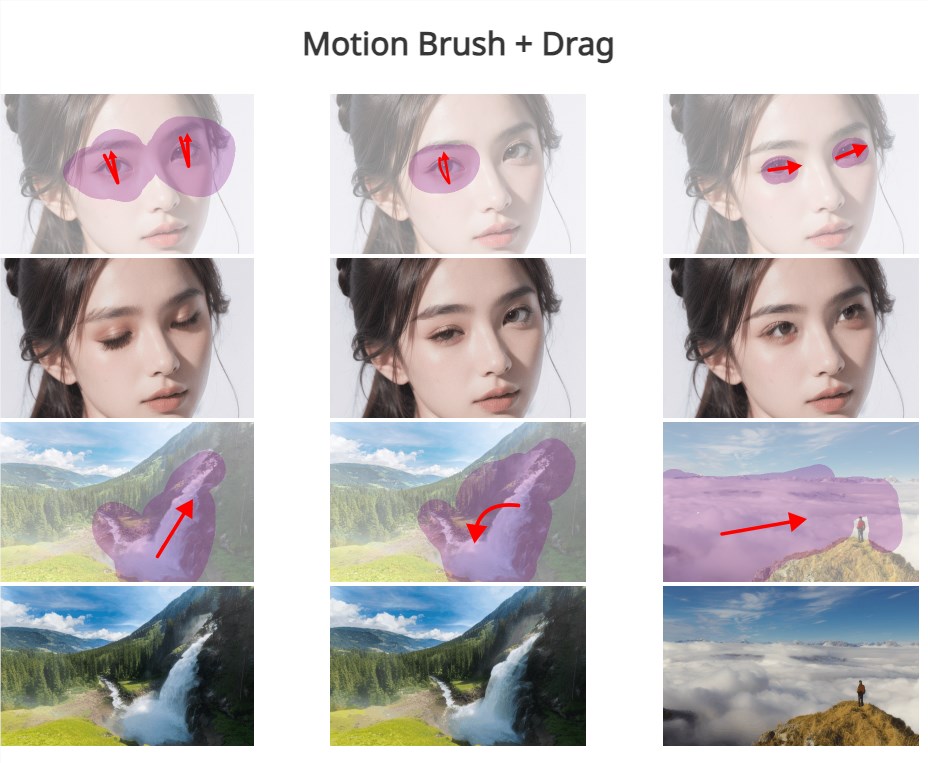

さらに、Motion-I2V は、ユーザーがまばらな軌道と領域の注釈を通じてモーション軌道とモーション領域を正確に制御することもサポートし、テキストの指示だけに依存するよりも多くの制御機能を提供します。これにより、ユーザーのインタラクティブなエクスペリエンスが向上するだけでなく、ビデオ生成のカスタマイズとパーソナライズの可能性も提供されます。

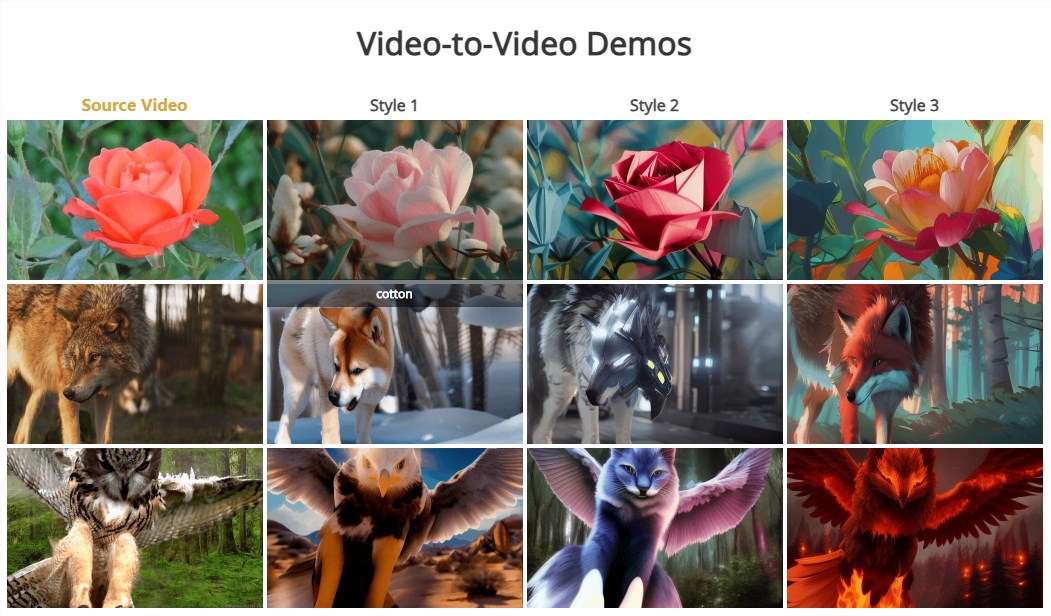

Motion-I2V の第 2 段階では、ゼロサンプルのビデオからビデオへの変換も当然サポートされていることに注意してください。これは、サンプルをトレーニングすることなく、さまざまなスタイルやコンテンツのビデオ変換を実現できることを意味します。

Motion-I2V フレームワークの発表は、画像からビデオへの生成テクノロジーの新たな段階を示します。品質と一貫性の大幅な向上を達成するだけでなく、ユーザーの制御とパーソナライゼーションにおいても大きな可能性を示します。テクノロジーが成熟し、改善し続けるにつれて、Motion-I2V が映画やテレビの制作、仮想現実、ゲーム開発などの分野で重要な役割を果たし、より豊かで鮮明な視覚体験を人々にもたらすと私たちは確信しています。

ドキュメントアドレス: https://xiaoyushi97.github.io/Motion-I2V/

github アドレス: https://github.com/GUN/Motion-I2V

Motion-I2V フレームワークの出現は、I2V テクノロジーに新たな可能性をもたらし、ビデオ生成の品質、一貫性、およびユーザー制御の向上に期待する価値があります。 今後、技術のさらなる発展に伴い、Motion-I2Vはより多くの分野に応用され、より刺激的な映像体験をもたらしてくれると思います。 このフレームワークに基づくさらなる革新的なアプリケーションに期待してください。