今日、AI テクノロジーの急速な発展に伴い、リソースに制約のあるデバイス上で実行できる小型言語モデル (SLM) が大きな注目を集めています。 Nvidia チームは最近、Llama 3 モデルの圧縮に基づいた優れた小型言語モデルである Llama-3.1-Minitron4B をリリースしました。モデルの枝刈りおよび蒸留テクノロジーを利用して、より大規模なモデルに匹敵するパフォーマンスを実現するとともに、効率的なトレーニングと展開の利点を備え、AI アプリケーションに新たな可能性をもたらします。 Downcodes のエディターは、この技術的進歩についての深い理解を導きます。

テクノロジー企業がデバイス上の人工知能を追いかけている時代に、リソースに制約のあるデバイス上で実行できる小型言語モデル (SLM) がますます登場しています。最近、Nvidia の研究チームは、最先端のモデル プルーニングおよび蒸留テクノロジーを使用して、Llama3 モデルの圧縮バージョンである Llama-3.1-Minitron4B を起動しました。この新しいモデルは、より大きなモデルとパフォーマンスが同等であるだけでなく、同じサイズのより小さなモデルと競合するだけでなく、トレーニングとデプロイメントの効率も向上しています。

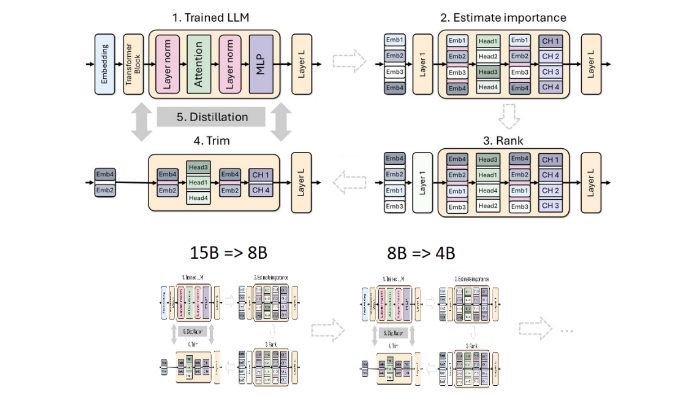

枝刈りと蒸留は、より小さく、より効率的な言語モデルを作成するための 2 つの重要なテクニックです。枝刈りとは、レイヤー全体を削除する「深さ枝刈り」や、ニューロンやアテンション ヘッドなどの特定の要素を除去する「幅枝刈り」など、モデルの重要でない部分を削除することを指します。一方、モデルの蒸留では、知識と機能を大規模なモデル (つまり、「教師モデル」) からより小さく単純な「生徒モデル」に転送します。

蒸留には主に 2 つの方法があります。1 つは、生徒モデルが教師モデルの入力と応答を学習できるようにする「SGD トレーニング」です。2 番目は、学習結果に加えて、「古典的な知識の蒸留」です。学生モデルには、学習教師モデルの内部アクティブ化も必要です。

以前の研究で、Nvidia の研究者は、プルーニングと蒸留によって Nemotron15B モデルを 8 億のパラメータ モデルに削減し、最終的にはさらに 4 億のパラメータに削減することに成功しました。このプロセスにより、有名な MMLU ベンチマークでパフォーマンスが 16% 向上するだけでなく、最初からトレーニングする場合に比べて、必要なトレーニング データが 40 倍少なくなります。

今回、Nvidia チームは同じ方法を使用して、Llama3.18B モデルに基づいて 4 億のパラメーター モデルを作成しました。まず、トレーニング データと抽出されたデータセットの間の分布の違いに対処するために、940 億のトークンを含むデータセットで枝刈りされていない 8B モデルを微調整しました。次に、深さ枝刈りと幅枝刈りの 2 つの方法が使用され、最終的に 2 つの異なるバージョンの Llama-3.1-Minitron4B が得られました。

研究者らは、NeMo-Aligner を通じてプルーニングされたモデルを微調整し、命令追従、ロールプレイング、検索拡張生成 (RAG)、および関数呼び出しにおけるその機能を評価しました。

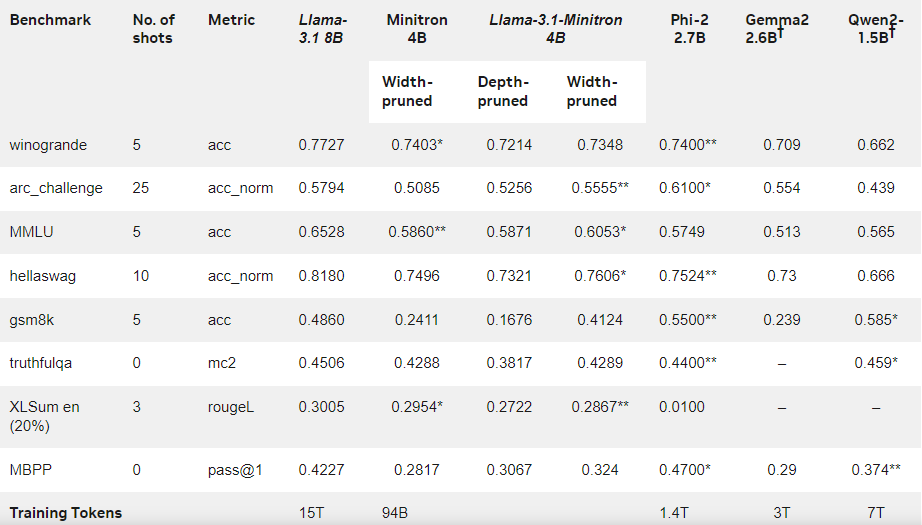

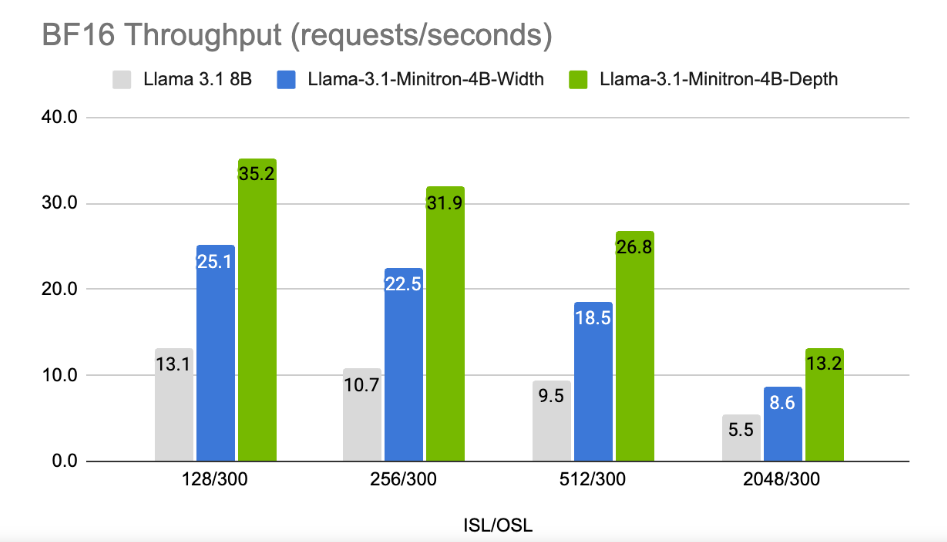

結果は、トレーニング データの量が少ないにもかかわらず、Llama-3.1-Minitron4B のパフォーマンスが他の小型モデルに近く、良好にパフォーマンスしていることを示しています。モデルの幅を切り詰めたバージョンが Hugging Face でリリースされ、商用利用が可能になり、より多くのユーザーや開発者がその効率性と優れたパフォーマンスの恩恵を受けることができます。

公式ブログ: https://developer.nvidia.com/blog/how-to-prune-and-distill-llama-3-1-8b-to-an-nvidia-llama-3-1-minitron-4b-model /

ハイライト:

Llama-3.1-Minitron4B は、効率的なトレーニングと展開機能を備えた、プルーニングと蒸留テクノロジーに基づいて Nvidia によって発売された小規模な言語モデルです。

このモデルのトレーニング プロセスで使用されるマーカーの量は、最初からトレーニングする場合に比べて 40 分の 1 に削減されますが、パフォーマンスは大幅に向上します。

? ユーザーが商用利用や開発を容易にするために、幅剪定バージョンが Hugging Face でリリースされました。

全体として、Llama-3.1-Minitron4B の登場は、小規模言語モデルの開発における新たなマイルストーンとなり、その効率的なパフォーマンスと便利な導入方法は、より多くの開発者とユーザーに朗報をもたらし、AI テクノロジーの普及と応用を加速するでしょう。 Downcodes の編集者は、将来的に同様のイノベーションがさらに増えることを楽しみにしています。