Downcodes の編集者は、学術論文の「別の用途」を理解するのに役立ちます。近年、AI モデルのトレーニング データのソースが広く注目を集めており、多くの学術出版社が AI システムの機能を向上させるために研究論文をテクノロジー企業に「パッケージ化して販売」しています。これには巨額の取引が伴い、知的財産権、著作者の権利、AI開発の倫理について学術コミュニティで激しい議論が巻き起こった。この記事では、この現象のメカニズムや影響、今後の動向について掘り下げていきます。

自分の研究論文が AI のトレーニングに使用されたかもしれないと考えたことはありますか。はい、多くの学術出版社が、AI モデルを開発しているテクノロジー企業にその結果を「パッケージ化して販売」しています。この動きが、特に著者がそれについて何も知らないときに、科学研究コミュニティに大きな波紋を引き起こしたことは間違いありません。専門家らは、あなたの言語モデルがまだ大規模言語モデル (LLM) で使用されていない場合、近い将来に使用されるようになる可能性が高いと述べています。

最近、英国の学術出版社である Taylor & Francis は Microsoft と 1,000 万ドルの契約に達し、テクノロジー大手が AI システムの機能を向上させるために研究データを使用できるようになりました。 6月にはアメリカの出版社ワイリーもある企業と契約に達し、自社のコンテンツが生成AIモデルのトレーニングに使用される見返りに2,300万米ドルの収益を受け取った。

論文がオンラインで入手できる場合、オープンアクセスであろうとペイウォールの内側であろうと、それは何らかの大規模な言語モデルにフィードされている可能性があります。ワシントン大学の AI 研究者であるルーシー・ルー・ワン氏は、「モデルのトレーニングに一度使用された論文は、モデルのトレーニング後に削除することはできません」と述べています。

大規模な言語モデルのトレーニングには大量のデータが必要ですが、多くの場合、そのデータはインターネットから収集されます。これらのモデルは、何十億もの言語の断片を分析することで、流暢なテキストを学習して生成できます。学術論文は、情報密度が高く、長さも長いため、LLM 開発者にとって非常に貴重な「宝」となっています。このようなデータは、AI が科学においてより適切な推論を行うのに役立ちます。

最近では、高品質のデータセットを購入する傾向が高まっており、多くの有名メディアやプラットフォームがAI開発者と協力してコンテンツを販売し始めています。合意がなければ多くの作品が黙って削除される可能性があることを考えると、この種の協力は今後さらに一般的になるだろう。

しかし、大規模人工知能ネットワークなどの一部の AI 開発者は、データセットをオープンのままにすることを選択していますが、生成 AI を開発している多くの企業は、トレーニング データについては何も知られていないと専門家は考えています。」 arXiv などのプラットフォームや PubMed などのデータベースは、間違いなく AI 企業がクロールする人気のターゲットです。

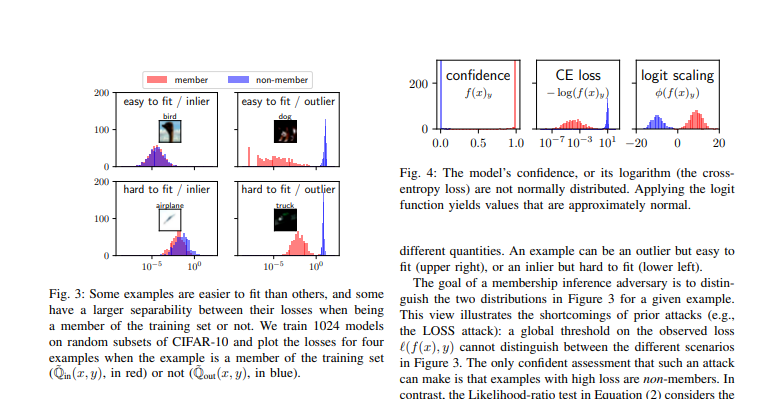

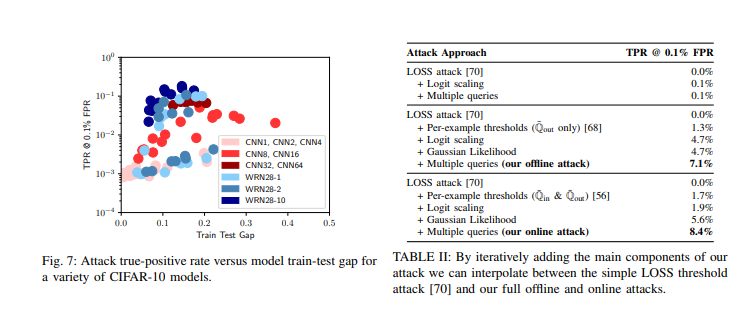

特定の論文が特定の LLM のトレーニング セットに含まれるかどうかを証明することは簡単ではありません。研究者は、論文の珍しい文を使用して、モデルの出力が元のテキストと一致するかどうかをテストできますが、開発者がトレーニング データを直接出力しないようにモデルを調整できるため、論文が使用されなかったことを完全に証明するわけではありません。

LLM が特定のテキストを使用したことが証明されたとしても、次に何が起こるのでしょうか? 出版社は、著作権で保護されたテキストの無断使用は著作権侵害に当たると主張していますが、LLM はテキストをコピーしているのではなく、新しいテキストを生成しているという反論もあります。情報の内容を分析することによって。

現在、米国で著作権訴訟が進行中であり、画期的な訴訟となる可能性がある。 New York Timesは、MicrosoftとChatGPT開発者のOpenAIを、ニュースコンテンツを許可なくモデルのトレーニングに使用したとして告訴している。

多くの学者は、特にこれらのモデルが研究の精度を向上させることができる場合、LLM のトレーニング データに自分の研究が含まれることを歓迎します。しかし、この分野の研究者全員がこれを真剣に受け止めているわけではなく、多くの人が自分の仕事が脅かされていると感じています。

一般に、個々の科学著者は現在、出版社の販売決定についてほとんど発言権を持っておらず、クレジットがどのように割り当てられるか、またそれが出版された論文に使用されるかどうかについて明確なメカニズムはありません。一部の研究者は「AIモデルの助けを期待しているが、公平なメカニズムも望んでいる。そのような解決策はまだ見つかっていない」と不満を表明した。

参考文献:

https://www.nature.com/articles/d41586-024-02599-9

https://arxiv.org/pdf/2112.03570

AI と学術出版の将来の方向性はまだ不透明であり、著作権問題、データプライバシー、著者の権利と利益の保護メカニズムはすべてさらに改善される必要があります。 これは出版社とテクノロジー企業の間の単なるゲームではなく、学術研究の持続可能な発展とAI技術の倫理に関わる大きな問題でもあり、社会全体の注目と努力が必要となります。