Downcodes のエディターが、Transformer モデルの秘密を徹底的に理解します。最近、「ペインターとしてのトランスフォーマー層」というタイトルの論文で、トランスフォーマー モデルの中間層の動作メカニズムを「ペインター」の観点から鮮やかに説明しました。この論文は、巧妙な比喩と実験を通じて、Transformer 階層がどのように動作するかを明らかにし、大規模な言語モデルの内部動作を理解するための新しいアイデアを提供します。論文の中で著者は、トランスフォーマーの各層を、協力して壮大な言語の絵を作成する画家に例え、一連の実験を通じてこの見方を検証しました。

人工知能の世界には、特別なペインターのグループ、つまり Transformer モデルの階層構造が存在します。彼らは魔法の絵筆のようなもので、言語というキャンバスにカラフルな世界を描きます。最近、「Transformer Layers as Painters」という論文が、Transformer 中間層の動作メカニズムを理解するための新しい視点を提供します。

Transformer モデルは現在最も人気のある大規模言語モデルであり、数十億のパラメータを持っています。その各層は画家のようなもので、協力して壮大な言語の絵を完成させます。しかし、これらの画家たちはどのように協力して作業を行ったのでしょうか? 彼らが使用したブラシと絵の具はどのように異なっていたのでしょうか? この論文はこれらの質問に答えようとしています。

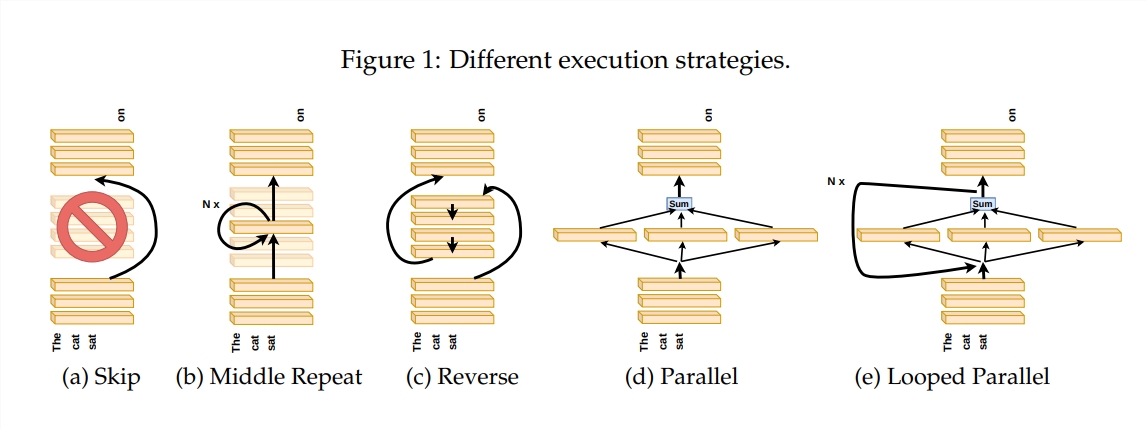

Transformer レイヤーがどのように機能するかを調査するために、著者は、特定のレイヤーをスキップする、レイヤーの順序を変更する、レイヤーを並行して実行するなどの一連の実験を設計しました。これらの実験は、画家が適応できるかどうかを確認するために、さまざまな絵画ルールを設定するようなものです。

「画家のパイプライン」のメタファーでは、入力はキャンバスとして見なされ、中間層を通過するプロセスは組み立てラインでのキャンバスの通過に似ています。各「ペインター」、つまりトランスフォーマーの各レイヤーは、独自の専門知識に従ってペイントを変更します。この類似性は、Transformer 層の並列性とスケーラビリティを理解するのに役立ちます。

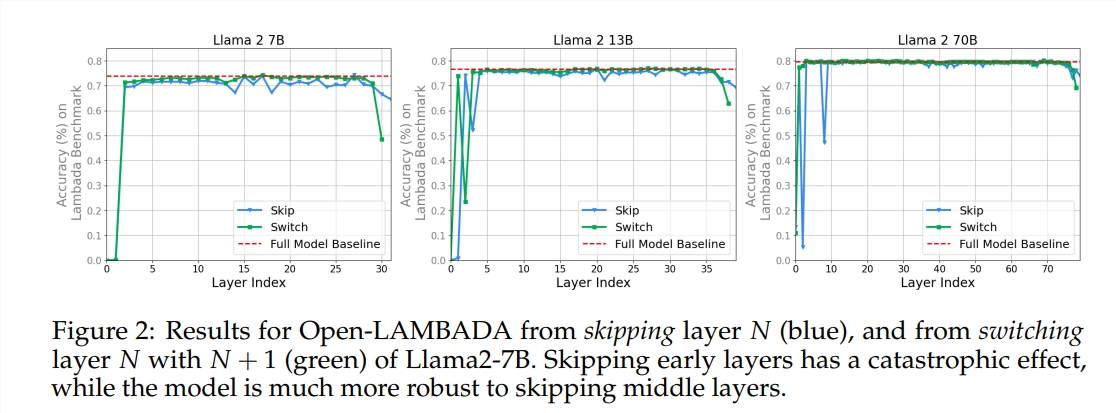

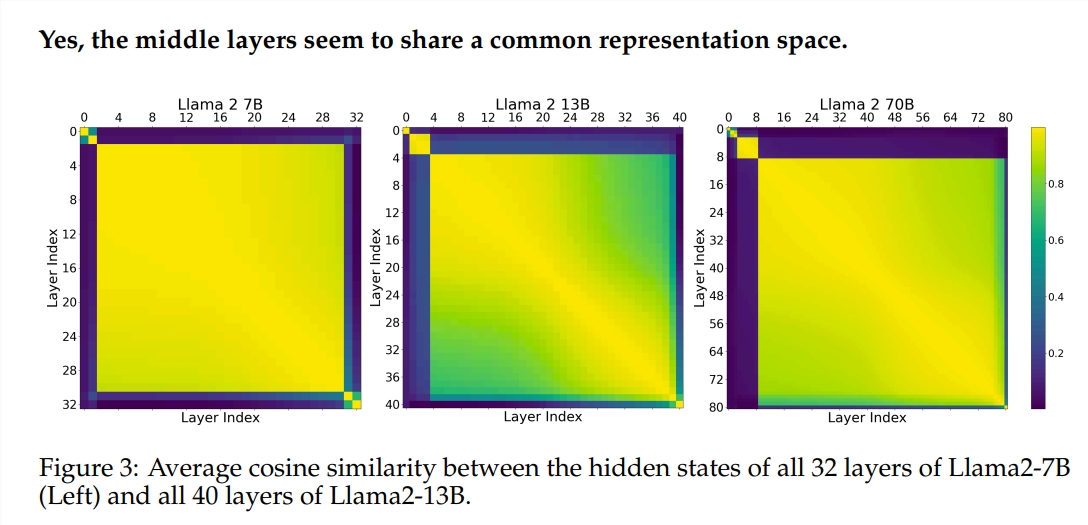

実験では、Llama2-7B と BERT という 2 つの事前トレーニングされた大規模言語モデル (LLM) を使用しました。この研究では、中間層の画家たちは、最初と最後の層の画家とは異なる、空間を表す共通の絵の具箱を共有しているようであることが判明した。特定の中間レイヤーをスキップしたペインターは絵画全体にほとんど影響を与えず、すべてのペインターが必要なわけではないことを示しています。

中間層の画家たちは同じ絵の具箱を使いながらも、それぞれのスキルを駆使してキャンバス上に異なる模様を描きます。ある画家の技法をそのまま使い回してしまうと、その絵は本来の魅力を失ってしまいます。

描画する順序は、厳密なロジックを必要とする数学的タスクや推論タスクでは特に重要です。意味の理解に依存するタスクの場合、順序の影響は比較的小さいです。

研究結果によると、Transformer の中間層はある程度の一貫性はあるものの、冗長ではありません。数学的タスクや推論タスクの場合、意味論的なタスクよりもレイヤーの順序が重要です。

この研究では、すべての層が必要なわけではなく、モデルのパフォーマンスに壊滅的な影響を与えることなく中間層をスキップできることもわかりました。さらに、中間層は同じ表現空間を共有しますが、異なる機能を実行します。レイヤーの実行順序を変更するとパフォーマンスが低下しました。これは、順序がモデルのパフォーマンスに重要な影響を与えることを示しています。

Transformer モデルの探索の途中で、多くの研究者が枝刈りやパラメータの削減などを含めてモデルを最適化しようとしています。これらの作品は、Transformer モデルを理解するための貴重な経験とインスピレーションを提供します。

論文アドレス: https://arxiv.org/pdf/2407.09298v1

全体として、このペーパーは、Transformer モデルの内部メカニズムを理解するための新しい視点を提供し、将来のモデル最適化のための新しいアイデアを提供します。 Downcodes の編集者は、興味のある読者がトランスフォーマー モデルの謎を深く理解するために記事全文を読むことをお勧めします。