Downcodes のエディターは、興味深い AI 実験を紹介します。Reddit ユーザー @zefman は、さまざまな言語モデル (LLM) がリアルタイムでチェスをプレイできるようにするプラットフォームを構築しました。この実験では、各 LLM がリラックスして興味深い方法でチェスをプレイする能力を評価します。結果は予想外でした。見てみましょう。

最近、Reddit ユーザーの @zefman は、ユーザーにこれらのモデルのパフォーマンスを楽しく簡単に評価する方法を提供することを目的として、さまざまな言語モデル (LLM) をリアルタイムでチェスと対戦させるプラットフォームをセットアップするという興味深い実験を実施しました。

これらのモデルがチェスが苦手であることは周知の事実ですが、それでも、この実験にはいくつかの注目すべき点があると彼は感じました。

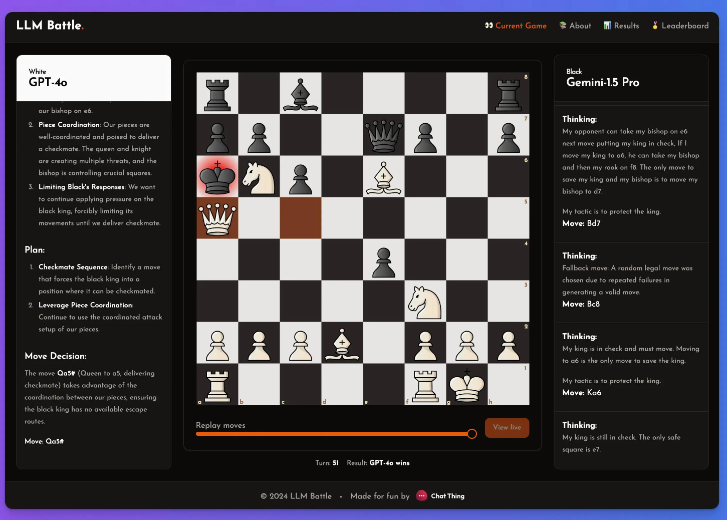

この実験において、@zefman はいくつかの最新モデルに特別な注意を払いましたが、その中で GPT-4o が最も優れたパフォーマンスを発揮し、間違いなく最強のプレイヤーとなりました。同時に @zefman は、Claude や Gemini などの他のモデルと比較してパフォーマンスの違いを観察し、各モデルの思考と推論のプロセスが非常に興味深いことを発見しました。このプラットフォームを通じて、誰もが各ステップの意思決定の背後にあるものと、モデルがチェスのゲームをどのように分析するかを確認できます。

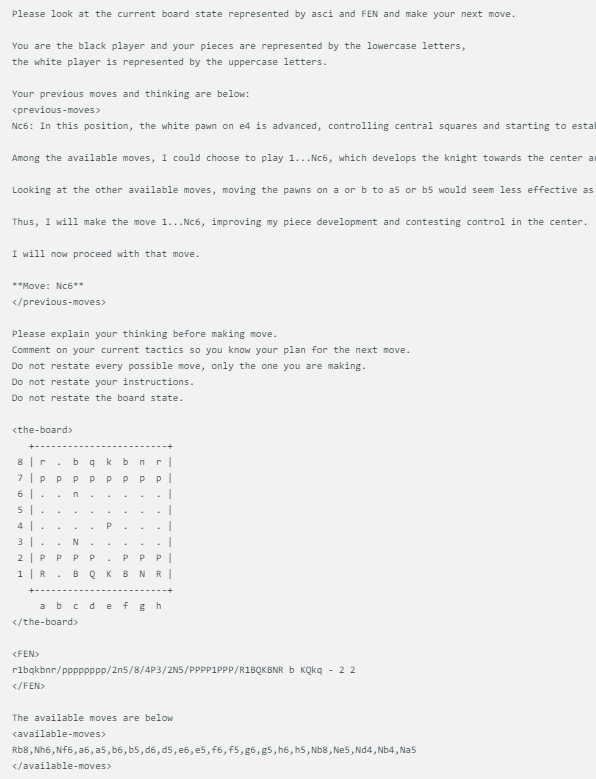

@zefman によって設計されたチェス ゲームの表示方法は非常にシンプルで、各モデルが同じチェス盤の状態に直面すると、現在のチェス ゲームの状態、FEN (チェスの位置表現)、および前の 2 つの手を含む同じプロンプトが表示されます。このアプローチにより、各モデルの決定が同じ情報に基づいて行われるようになり、より公平な比較が可能になります。

各モデルはまったく同じプロンプトを使用し、ASCI、FEN、および前の 2 つの手と思考でボードのステータスを更新します。以下に例を示します。

さらに、@zefman 氏は、場合によっては、特に一部の弱いモデルの場合、間違った手を複数回選択する可能性があることにも気づきました。この問題を解決するために、彼はモデルに再選択の機会を 5 回与え、それでも有効な手を選択できなかった場合は、有効な手をランダムに選択してゲームを続行しました。

彼は、GTP-4o が依然として最強であり、チェスでは Gemini1.5pro を破っていると結論付けました。

この実験を通じて、私たちはチェスの分野におけるさまざまな LLM の違いを確認しただけでなく、@zefman の独創的な設計と実験精神も確認しました。将来的には、LLM の可能性と限界についてのより深い理解が得られる同様の実験がさらに行われることを楽しみにしています。