上海人工知能研究所は、2024年7月4日にWAICサイエンスフロンティアメインフォーラムでScholar Puyuシリーズモデルの最新バージョンであるInternLM2.5をリリースした。このバージョンでは、複雑なシナリオにおける推論機能が大幅に向上し、1M の超長コンテキストをサポートし、インターネット検索と情報統合を独立して実行できるようになりました。これは大きな進歩です。 InternLM2.5の機能やオープンソース情報をDowncodes編集部が詳しく解説します。

上海人工知能研究所は、2024 年 7 月 4 日に開催された WAIC サイエンス フロンティア メイン フォーラムで、Scholar Puyu シリーズ モデルの新バージョンである InternLM2.5 を発表しました。このバージョンの複雑なシナリオにおける推論機能は包括的に強化されており、1M の超長コンテキストをサポートし、独立してインターネット検索を実行し、数百の Web ページからの情報を統合できます。

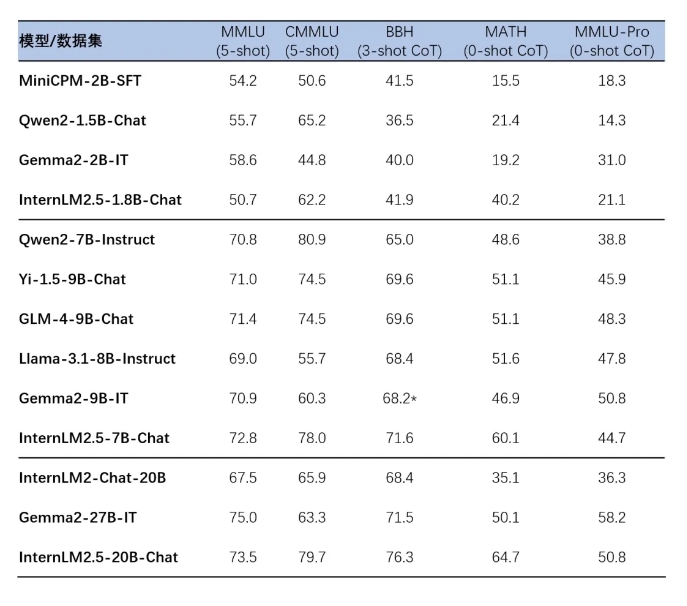

InternLM2.5 は、さまざまなアプリケーション シナリオと開発者のニーズに適応するために、モデルの 3 つのパラメーター バージョン、つまり 1.8B、7B、および 20B をリリースしました。 1.8B バージョンは超軽量モデルですが、20B バージョンはより強力な総合パフォーマンスを提供し、より複雑な実用的なシナリオをサポートします。これらのモデルはすべてオープンソースであり、Scholar・Puyu シリーズの大型モデルのホームページ、ModelScope のホームページ、および Hugging Face のホームページで見つけることができます。

InternLM2.5 は複数のデータ合成テクノロジを反復処理し、特に数学的評価セット MATH の精度が大幅に向上しました。さらに、このモデルは、事前トレーニング段階での効率的なトレーニングを通じてコンテキスト長の処理能力を向上させます。

InternLM2.5 シリーズ モデルは、上海人工知能研究所が独自に開発した XTuner 微調整フレームワークや LMDeploy 推論フレームワークなど、下流の推論および微調整フレームワークとのシームレスな統合も実現します。 vLLM、Ollama、llama.cpp などのコミュニティ。 Moda コミュニティによって開始された SWIFT ツールは、InternLM2.5 シリーズ モデルの推論、微調整、展開もサポートしています。

これらのモデルのアプリケーション エクスペリエンスには、複数ステップの複雑な推論、複数ターンの会話の意図の正確な理解、柔軟な形式制御操作、および複雑な指示に従う能力が含まれます。開発者がすぐに始められるように、詳細なインストールおよび使用ガイドが提供されています。

Scholar・Puyuシリーズ大型モデルホームページ:

https://internlm.intern-ai.org.cn

モデルスコープのホームページ:

https://www.modelscope.cn/organization/Shanghai_AI_Laboratory?tab=model

ハグフェイスのホームページ:

https://huggingface.co/internlm

InternLM2.5 オープンソース リンク:

https://github.com/InternLM/InternLM

InternLM2.5 のオープンソース リリースは、人工知能分野の研究とアプリケーションに新たな可能性をもたらし、その強力なパフォーマンスと使いやすさが多くの開発者を魅了し、革新をもたらすと考えられています。 Downcodes の編集者は、InternLM2.5 をベースにしたさらに優れたアプリケーションを期待しています。