Downcodes の編集者は、OpenAI が実験モデル gpt-4o-64k-output-alpha をリリースしたことを知りました。その最大の特徴は、一度に 64K の長さのトークンを出力できることです。これは、よりリッチで詳細なコンテンツを生成できることを意味します。しかし、それは API 価格の上昇も意味します。このモデルはアルファ参加者に提供され、執筆、プログラミング、複雑なデータ分析などのシナリオで使用して、より包括的かつ詳細なサポートをユーザーに提供できます。ただし、コストが高いため、ユーザーは慎重に検討する必要があります。結局のところ、出力トークン 100 万あたりの価格は 18 ドルにもなります。

OpenAI は新しい実験モデル gpt-4o-64k-output-alpha をオープンしました。この新しいモデルの最大のハイライトは、一度に 64K の長さのトークンを出力できることです。これは、1 回のリクエストでより豊富で詳細なコンテンツを生成できることを意味しますが、API の価格は高くなります。

アルファ参加者は、「gpt-4o-64k-output-alpha」モデル名を使用して GPT-4o ロング出力エフェクトにアクセスできます。このモデルは、ユーザーが執筆、プログラミング、または複雑なデータ分析を実行しているかどうかにかかわらず、長いテキストに対するユーザーのニーズを満たすだけでなく、GPT-4o はより包括的かつ詳細なサポートを提供できます。

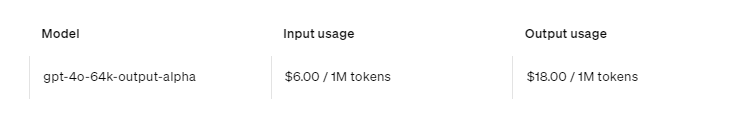

価格面でも出力の長いモデルを使用することは、その分出費も増加することを意味します。 OpenAI は、長いテキストの生成はより高価であるため、100 万出力トークンあたりの価格は 18 ドルであることを明らかにしています。比較すると、入力されたトークン 100 万個あたりの価格は 6 ドルです。この価格設定戦略は、より高いコンピューティング コストに見合うように設計されていると同時に、ユーザーがこの強力なツールを活用することを奨励します。

全体として、GPT-4o-64k-output-alpha モデルの登場は、超長いテキストを処理して生成する必要があるユーザーに新しいオプションを提供しますが、コストが高いため、ユーザーは自分のニーズに応じて慎重に検討する必要もあります。 Downcodes の編集者は、実際の状況に応じて適切なモデルを選択し、リソースを合理的に使用することをお勧めします。