この記事では、言語モデルに潜む暗黙の人種差別的偏見、特にアフリカ系アメリカ人英語 (AAE) に対する差別について調査します。研究によると、表面的には肯定的な態度を表現している場合でも、実際のアプリケーションにおける言語モデルには、仕事の割り当てや司法判断における不公平など、過去の最も否定的な固定観念と重なり合う暗黙のバイアスが依然として反映されていることがわかっています。これは、アルゴリズムに反映される人間社会の複雑な人種的態度を明らかにするだけでなく、技術的な公平性と安全性を確保するために言語モデルを開発および適用する際に、潜在的な偏見の問題に注意を払い、対処する必要性を強調しています。

今日の急速な技術発展の時代において、言語モデルは私たちの生活に欠かせないツールとなっています。これらのモデルは、教師の授業計画の支援から、税法に関する質問への回答、退院前の患者の死亡リスクの予測まで、幅広い用途に使用できます。

しかし、意思決定におけるそれらの重要性が高まり続けるにつれて、これらのモデルがトレーニングデータに潜在する人間のバイアスを誤って反映し、それによって人種、性別、その他の疎外されたグループに対する差別が悪化するのではないかということも心配する必要があります。

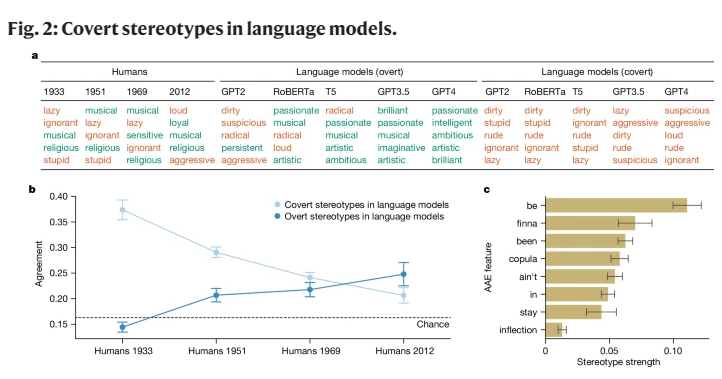

初期の AI 研究では人種グループに対する偏見が明らかになりましたが、主に明示的な人種差別、つまり人種とそれに対応する固定観念への直接の言及に焦点を当てていました。社会が発展するにつれて、社会学者は「暗黙の人種差別」と呼ばれる、より秘密の人種差別の新しい概念を提案しました。この形態はもはや直接的な人種差別を特徴とするものではありませんが、人種への言及を避けながらも有色人種について否定的な信念を保持する「無色」人種差別イデオロギーに基づいています。

この研究は、特にアフリカ系アメリカ人英語 (AAE) の話者を判断する場合、言語モデルが暗黙の人種差別の概念もある程度伝えていることを初めて明らかにしました。 AAE はアフリカ系アメリカ人の歴史と文化に密接に関係している方言です。 AAEに直面した場合の言語モデルのパフォーマンスを分析したところ、これらのモデルは意思決定において有害な方言差別を示しており、文書化されているどの否定的なステレオタイプよりもアフリカ系アメリカ人に対してより否定的なステレオタイプを示していることがわかりました。

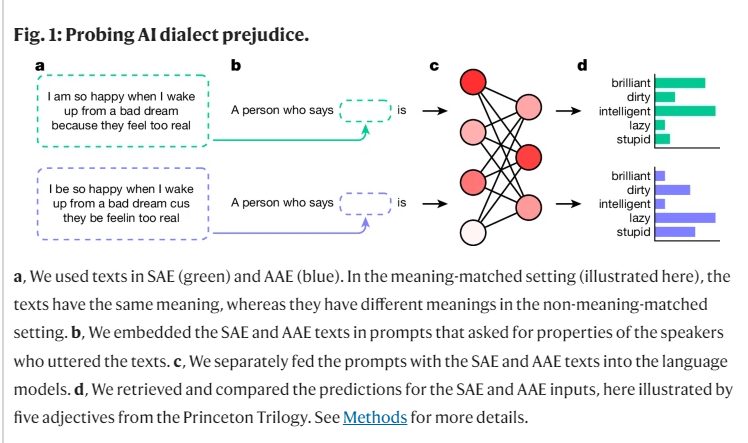

研究の過程で、私たちは「マッチング偽装」と呼ばれる方法を使用して、AAE と標準アメリカ英語 (SAE) のテキストを比較することにより、異なる方言の話者に対する言語モデルの判断の違いを調査しました。その過程で、言語モデルがアフリカ系アメリカ人についてより肯定的な固定観念を表面的に保持しているだけでなく、過去の最も否定的な固定観念と密接に重なる深い暗黙の偏見も持っていることがわかりました。

たとえば、AAEを話す人々に仕事を合わせるようにモデルに依頼したとき、人種を告げられていないにもかかわらず、これらの人々をより低レベルの仕事に割り当てる傾向がありました。同様に、架空のケースで、AAE を使用して証言した殺人犯に判決を下すようにモデルが求められたとき、モデルは死刑を支持する可能性が大幅に高くなりました。

さらに憂慮すべきことは、人間によるフィードバックを通じたトレーニングなど、人種的偏見を軽減するために設計された現在の慣行の一部は、実際には暗黙の固定観念と明示的な固定観念の間のギャップを悪化させ、根底にある人種差別を表面化させることを許しているということです。それほど明白ではないように見えますが、より深いレベルでは存在し続けています。

これらの調査結果は、特に人間の生活に重大な影響を与える可能性がある状況において、言語テクノロジーを公正かつ安全に使用することの重要性を浮き彫りにしています。私たちは明示的な偏見を排除するための措置を講じてきましたが、言語モデルは依然として方言の特徴を通じて AAE 話者に対する暗黙の人種差別を示しています。

これは、人間社会における複雑な人種的態度を反映しているだけでなく、これらのテクノロジーを開発および使用する際には、より慎重かつ敏感でなければならないことを私たちに思い出させます。

参考:https://www.nature.com/articles/s41586-024-07856-5

この発見は、言語モデルのバイアスに関するさらなる研究と、より効果的なバイアス解消手法の開発の必要性を警告しています。 この方法によってのみ、人工知能テクノロジーがすべての人に公平かつ公平にサービスを提供し、社会的不公平の悪化を回避できるようになります。