最近、Anthropic の AI チャットボット Claude のユーザー エクスペリエンスが激しい議論を引き起こしました。クロードのパフォーマンスが低下し、具体的には記憶喪失とコーディング能力の低下として現れたという多数のユーザーフィードバックが Reddit に投稿されました。この事件は、大規模な言語モデルのパフォーマンス評価とユーザー エクスペリエンスに関する広範な議論を引き起こし、モデルの安定性を維持する上で AI 企業が直面する課題を改めて浮き彫りにしました。

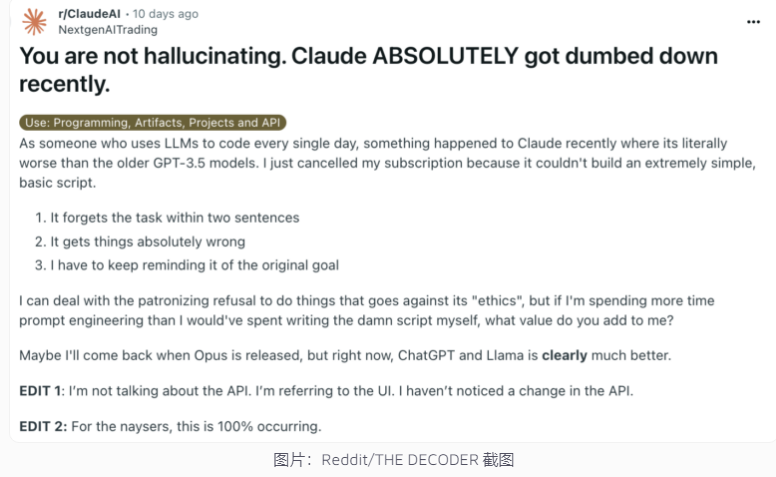

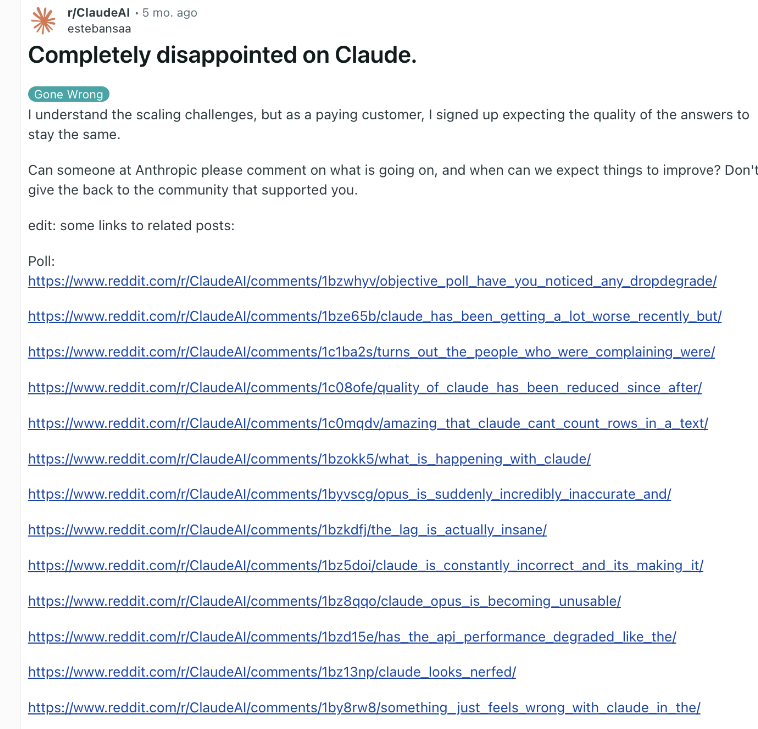

最近、Anthropic の AI チャットボット Claude が再びパフォーマンス論争に巻き込まれています。最近、クロードがより愚かになったと主張するレディットの投稿が広く注目を集め、多くのユーザーが記憶喪失やコーディング能力の低下など、クロードの能力の低下を経験したと報告した。

これに対し、Anthropic の幹部である Alex Albert 氏は、同社の調査では一般的な問題は見つからなかったと答え、Claude3.5Sonnet モデルや推論パイプラインには変更が加えられていないことを確認したと述べました。透明性を高めるために、Anthropic はクロード モデルのシステム プロンプトを公式 Web サイトで公開しました。

ユーザーがAIの劣化を報告し、同社がそれを否定したのはこれが初めてではない。 2023 年末、OpenAI の ChatGPT も同様の疑問に直面しました。業界関係者によると、この現象の理由としては、時間の経過とともに高まるユーザーの期待、AI 出力の自然な変化、一時的なコンピューティング リソースの制限などが考えられます。

ただし、これらの要因により、基礎となるモデルに大幅な変更が加えられなかった場合でも、ユーザーが知覚するパフォーマンスの低下が生じる可能性があります。 OpenAI はかつて、AI の動作自体は予測不可能であり、大規模な生成 AI のパフォーマンスを維持および評価するのは大きな課題であると指摘しました。

Anthropic は、今後もユーザーからのフィードバックに注意を払い、Claude のパフォーマンスの安定性を向上させるために懸命に取り組むと述べました。この事件は、AI 企業がモデルの一貫性を維持する際に直面する課題と、AI のパフォーマンス評価とコミュニケーションにおける透明性を高めることの重要性を浮き彫りにしました。

クロードのパフォーマンスに関する論争は、大規模な言語モデルの開発と展開の複雑さ、およびユーザーの期待と実際のアプリケーションとのギャップを反映しています。将来的に、AI 企業は、AI テクノロジーがユーザーに確実にサービスを提供し続けることができるように、モデルの安定性をさらに向上させ、ユーザーとのより効果的なコミュニケーションを維持する必要があります。