Anthropicは最近、AIの使用コストを削減し、パフォーマンスを改善するために、Claudeシリーズの大規模な言語モデルの新しい機能を発表しました。この動きは、Openai、Google、Microsoftなどの巨人と競合する際の人類の独自の戦略と見なされ、効率の向上とコストの視点を削減することから選択します。この関数は現在、Claude3.5 SonnetおよびClaude3 HaikuモデルのAPIで公開されており、最大90%のコストを削減し、いくつかのアプリケーションシナリオの応答速度を上げることを約束しています。ただし、実際の効果には依然として市場検査が必要です。

8月14日、Anthropicは、Claude Series Large Languageモデルと呼ばれる新しい機能を開始したことを発表し、AIの使用コストを大幅に削減し、パフォーマンスを改善できると主張しました。しかし、この機能は、会社が言ったのと同じくらい魔法のようであり、市場でテストする必要があるかどうか。

キャッシュ関数は、claude3.5sonnetおよびclaude3haikuモデルのAPIで公開されます。この関数により、ユーザーは、追加のコストや遅延の増加なしに、複雑な命令やデータを含む特定のコンテキスト情報を保存および再利用できます。同社のスポークスマンは、これはクロード能力を強化するために開発した多くの切断特性の1つであると述べました。

現在、Openai、Google、Microsoftなどの技術の巨人は、大規模な言語モデルの分野で激しい競争を開始しており、各企業は製品のパフォーマンスと市場の競争力を改善しようとしています。この競争では、人類は、使用効率を改善し、コストを削減し、独自の市場戦略を示すという観点から削減することを選択しました。

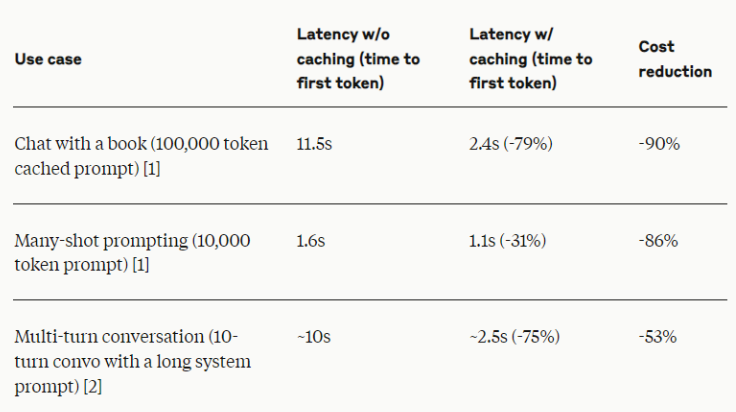

人類によると、この新機能はコストの最大90%をもたらし、いくつかのアプリケーションシナリオで応答速度を2倍にする可能性があります。これらの数字は間違いなく印象的ですが、業界の専門家は、特定のアプリケーションシナリオと実装により、実際の効果が異なる可能性があることを思い出させます。

人類は、キャッシュ関数は、長期的な対話、大規模なドキュメント処理、コード支援、複雑なツールなど、複数のクエリやセッションでコンテキストで一貫性を持つ必要があるシーンに特に適していると述べました。この方法は、さまざまな商用AIアプリケーションに効率改善をもたらすと予想されます。

業界関係者は、人類の新機能は明るいように見えますが、他のAI企業はモデルの効率を改善し、使用コストを削減する方法を積極的に調査していると指摘しました。たとえば、OpenAIはさまざまな機能と価格モデルのオプションを提供しますが、Googleは通常のハードウェアで効率的に動作できるモデルの開発に取り組んでいます。

この新機能の実際の効果については、市場は依然として慎重です。特に急速に発展しているAI分野では、新しいテクノロジーと同様に、現実の世界でのキャッシュ関数のパフォーマンスはまだ観察されていません。人類は、顧客と緊密に連携して、関連するデータとフィードバックを収集すると述べました。これは、新しいAIテクノロジーの影響を評価する業界でのベストプラクティスに沿っています。

人類のイニシアチブは、特に中小企業に高度なAI機能を提供する際に、AI業界に大きな影響を与える可能性があります。この機能が促進と同じくらい効果的である場合、企業が複雑なAIソリューションを採用するためのしきい値を減らし、それにより、より広範なビジネス分野でのAIテクノロジーの適用を促進する可能性があります。

パブリックテストの開発により、企業と開発者は、キャッシュ機能の実際のパフォーマンスと、それぞれのAI戦略にどのように適応するかを個人的に評価する機会があります。今後数か月で、この管理AIプロンプトのパフォーマンスと実際のアプリケーションのコンテキストが表示されることが期待されています。

人類の迅速なキャッシュ機能は、効率とコストの最適化の点で、AI業界による興味深い試みを表しています。ただし、業界の変化を真に導くことができるかどうかは、市場のさらなる検査も必要です。いずれにせよ、この革新は、激しい競争におけるAI企業の新しい方向性の継続的な調査を反映しており、AIテクノロジーが新しい効率的な革命の新しいラウンドを導く可能性があることを示しています。

全体として、人類のプロンプトキャッシュ関数の成功の鍵は、実際のアプリケーション効果です。 その後の市場パフォーマンスは、このテクノロジーをテストするための究極の基準となり、AI業界全体に新しい啓示をもたらします。