大規模言語モデル (LLM) の急速な発展により、驚くべき自然言語処理機能がもたらされましたが、その膨大なコンピューティング要件とストレージ要件により、その普及が制限されています。 1,760 億のパラメーターを含むモデルを実行するには、数百ギガバイトのストレージ容量と複数のハイエンド GPU が必要であり、コストが高くつき、拡張が困難になります。この問題を解決するために、研究者らは量子化などのモデル圧縮技術に焦点を当て、モデルのサイズと実行要件を削減してきましたが、精度損失のリスクにも直面しています。

人工知能 (AI) はますます賢くなっており、特に大規模言語モデル (LLM) は自然言語の処理において優れています。しかし、これらのスマート AI の頭脳の背後には、それらをサポートするために膨大なコンピューティング能力とストレージ容量が必要であることをご存知ですか?

1,760 億個のパラメータを持つ多言語モデル Bloom は、モデルの重みを保存するためだけに少なくとも 350 GB のスペースを必要とし、実行するにはいくつかの高度な GPU も必要です。これはコストがかかるだけでなく、普及が困難です。

この問題を解決するために、研究者たちは「定量化」と呼ばれる手法を提案しました。定量化は、AI の脳を「ダウンサイジング」するようなもので、モデルの重みとアクティベーションを下位のデータ形式にマッピングすることで、モデルのサイズを縮小するだけでなく、モデルの実行速度も高速化します。ただし、このプロセスにはリスクも伴い、一部の精度が失われる可能性があります。

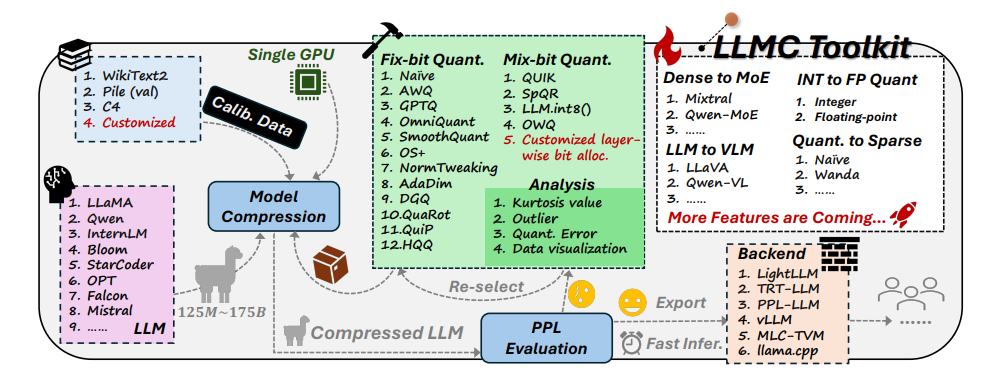

この課題に直面して、北航大学と SenseTime Technology の研究者は共同で LLMC ツールキットを開発しました。 LLMC は、AI の個人的な減量コーチのようなもので、研究者や開発者が最適な減量計画を見つけるのに役立ち、知能レベルに影響を与えることなく AI モデルを軽量化できます。

LLMC ツールキットには 3 つの主要な機能があります。

多様化: LLMC は 16 の異なる定量的手法を提供します。これは、AI 用に 16 の異なる減量レシピを準備するようなものです。 AI が全体的な体重を減らしたい場合でも、部分的に体重を減らしたい場合でも、LLMC はニーズを満たすことができます。

低コスト: LLMC はリソースを非常に節約し、非常に大規模なモデルを処理する場合でもハードウェア サポートをほとんど必要としません。たとえば、40GB A100 GPU のみを使用して、1,750 億個のパラメーターを備えた OPT-175B モデルを調整および評価できます。これは、オリンピックチャンピオンをトレーニングするために家庭用トレッドミルを使用するのと同じくらい効率的です。

高い互換性: LLMC はさまざまな量子化設定とモデル形式をサポートし、さまざまなバックエンドやハードウェア プラットフォームとも互換性があります。使用する器具に関係なく、適切なトレーニング計画を立てるのに役立つ万能トレーナーのようなものです。

LLMC の実践的な応用: AI をよりスマートにし、よりエネルギー効率を高める

LLMC ツールキットの登場により、大規模な言語モデルの定量化のための包括的で公正なベンチマーク テストが提供されます。ユーザーが最適なパフォーマンス最適化ソリューションを見つけるのに役立つように、トレーニング データ、アルゴリズム、データ形式という 3 つの重要な要素が考慮されます。

実際のアプリケーションでは、LLMC は研究者や開発者が適切なアルゴリズムと低ビット形式をより効率的に統合し、大規模な言語モデルの圧縮の普及を促進するのに役立ちます。これは、将来的には、より軽量でありながら同等に強力な AI アプリケーションが登場する可能性があることを意味します。

この論文の著者は、いくつかの興味深い発見と提案も共有しました。

トレーニング データを選択するときは、人間が体重を減らすときに自分の状況に基づいて適切なレシピを選択する必要があるのと同じように、語彙分布の点でテスト データにより近いデータ セットを選択する必要があります。

定量化アルゴリズムの観点からは、さまざまな運動方法の減量に対する効果を比較するのと同じように、変換、切り取り、再構成という 3 つの主要な手法の影響を調査しました。

整数量子化と浮動小数点量子化のどちらかを選択する場合、複雑な状況を処理するには浮動小数点量子化の方が有利である一方、特殊な場合には整数量子化の方が優れている可能性があることがわかりました。減量の段階ごとに異なる運動強度が必要になるようなものです。

LLMC ツールキットの出現は、AI 分野に新しいトレンドをもたらしました。研究者や開発者に強力なアシスタントを提供するだけでなく、AI の将来の発展の方向性も示します。 LLMC を通じて、より軽量で高性能な AI アプリケーションが登場し、AI が私たちの日常生活に真に浸透できるようになることが期待されます。

プロジェクトアドレス: https://github.com/ModelTC/llmc

論文アドレス: https://arxiv.org/pdf/2405.06001

全体として、LLMC ツールキットは、大規模な言語モデルのリソース消費の問題を解決するための効果的なソリューションを提供します。これは、モデル操作のコストとしきい値を削減するだけでなく、モデルにインジェクションを注入することで、モデルの効率と使いやすさも向上します。 AIの普及と新たな活力の発展。将来的には、LLMC をベースにした、より軽量な AI アプリケーションが登場し、私たちの生活にさらなる利便性をもたらすことが期待できます。