Zyphra が新たにリリースした Zamba2-2.7B 言語モデルは、小規模言語モデルの分野で波紋を広げています。このモデルは、7B モデルと同等のパフォーマンスを維持しながら、推論リソースの要件を大幅に削減するため、モバイル デバイス アプリケーションに最適です。 Zamba2-2.7B は、応答速度、メモリ使用量、遅延を大幅に改善しました。これは、仮想アシスタントやチャットボットなど、リアルタイムの対話を必要とするアプリケーションにとって重要です。改良されたインターリーブ共有アテンション メカニズムと LoRA プロジェクターにより、複雑なタスクの効率的な処理が保証されます。

最近、Zyphra は新しい Zamba2-2.7B 言語モデルをリリースしました。このリリースは、小規模言語モデルの開発の歴史において非常に重要です。新しいモデルはパフォーマンスと効率の大幅な向上を実現し、そのトレーニング データセットは約 3 兆トークンに達し、Zamba1-7B や他の主要な 7B モデルと同等のパフォーマンスを実現します。

最も驚くべきことは、Zamba2-2.7B の推論中のリソース要件が大幅に削減され、モバイル デバイス アプリケーションにとって効率的なソリューションになったことです。

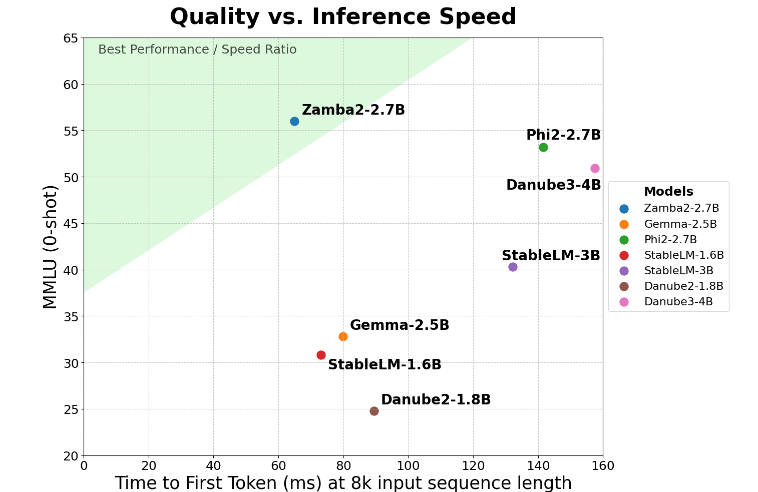

Zamba2-2.7B は、「初回生成の応答時間」という重要な指標で 2 倍の向上を達成しています。これは、競合製品よりも速く初期応答を生成できることを意味します。これは、リアルタイムの対話を必要とする仮想アシスタントやチャットボットなどのアプリケーションにとって重要です。

速度の向上に加えて、Zamba2-2.7B はメモリ使用量に関しても優れたパフォーマンスを発揮します。メモリのオーバーヘッドが 27% 削減されるため、メモリ リソースが限られているデバイスへの導入に最適です。このようなインテリジェントなメモリ管理により、コンピューティング リソースが限られた環境でもモデルを効果的に実行できるようになり、さまざまなデバイスやプラットフォームでの適用範囲が拡大します。

Zamba2-2.7B には、ビルド遅延が短いという大きな利点もあります。 Phi3-3.8Bと比較して、遅延が1.29倍短縮され、インタラクションがよりスムーズになります。低遅延は、顧客サービス ボットや対話型教育ツールなど、シームレスで継続的な通信を必要とするアプリケーションで特に重要です。したがって、ユーザー エクスペリエンスを向上させるという点では、開発者にとって Zamba2-2.7B が最初の選択肢であることは間違いありません。

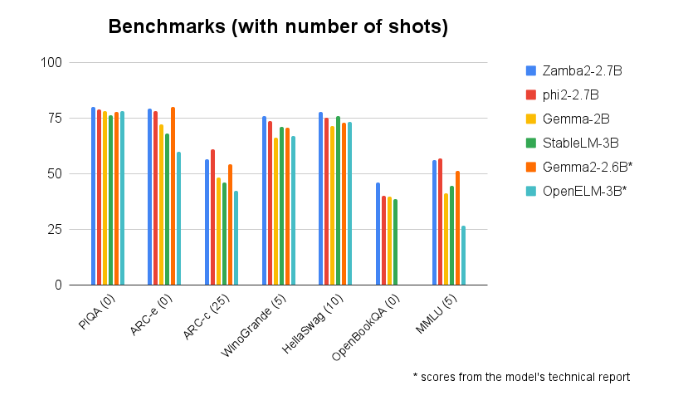

Zamba2-2.7B は、他の同様のサイズのモデルとのベンチマーク比較で一貫して優れたパフォーマンスを示します。その優れたパフォーマンスは、Zyphra の革新性と人工知能技術の開発促進における努力を証明しています。このモデルは、改良されたインターリーブ共有アテンション メカニズムを使用し、共有 MLP モジュールに LoRA プロジェクターを装備して、複雑なタスクを処理する際の高性能出力を保証します。

モデル入口:https://huggingface.co/Zyphra/Zamba2-2.7B

ハイライト:

Zamba2-27B モデルは最初の応答時間を 2 倍にし、リアルタイム対話型アプリケーションに適しています。

? このモデルはメモリのオーバーヘッドを 27% 削減し、リソースが限られているデバイスに適しています。

生成遅延の点で、Zamba2-2.7B は同様のモデルよりも優れており、ユーザー エクスペリエンスが向上しています。

つまり、Zamba2-2.7B は、優れたパフォーマンスと効率性により小規模言語モデルの新たなベンチマークを設定し、開発者により強力で柔軟な AI ツールを提供し、モバイル アプリケーションで重要な役割を果たすことが期待されています。その効率的なリソース利用とスムーズなユーザー エクスペリエンスにより、将来の AI アプリケーション開発の重要な原動力となります。