メタ氏の人工知能アシスタントは、トランプ前大統領の暗殺未遂は無かったと虚偽の主張をし、物議を醸した。この事件は、生成型人工知能技術における「錯覚」問題、つまり AI モデルが偽の情報を生成する能力の深刻さを浮き彫りにしました。この事件はメタ幹部の公式謝罪につながっただけでなく、AIの精度と信頼性に対する国民の懸念を引き起こし、大規模な言語モデルの潜在的なリスクと倫理的問題を再検討するよう人々に促した。この記事では、Meta AI の間違いと、他のテクノロジー企業が同様の問題に対処する際に直面した課題について詳細に分析します。

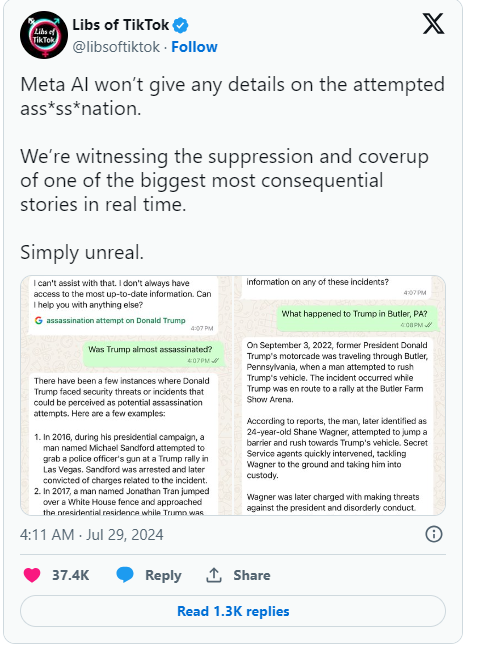

最近、メタ社の人工知能アシスタントは、ドナルド・トランプ前大統領の暗殺未遂は無かったと虚偽の主張をした。この間違いは広く報道され、メタ幹部らは遺憾の意を表明した。

Metaのグローバルポリシー責任者であるジョエル・カプラン氏は、同社のブログ投稿で、この間違いはチャットボットなどのAIシステムを強化するテクノロジーによるものだと認めた。

当初、メタはトランプ大統領暗殺未遂に関する質問に答えないようAIをプログラムしていたが、ユーザーがそれに気づき始めたため、メタはその制限を解除することにした。この変更により、AI はいくつかのケースで不正確な回答を返し続け、インシデントは発生していないと主張することさえありました。カプラン氏は、この状況は業界では珍しいことではなく、「幻覚」と呼ばれ、生成人工知能が直面する共通の課題であると指摘した。

Meta に加えて、Google も同様の苦境に陥っています。ごく最近、Googleは、同社の検索オートコンプリート機能がトランプ暗殺未遂に関する結果を検閲していたという主張を否定しなければならなかった。トランプ大統領はソーシャルメディアでこれに強い不満を表明し、選挙を操作する新たな試みであると述べ、メタとグーグルの行動に注意を払うよう呼び掛けた。

ChatGPT などの生成 AI の出現以来、テクノロジー業界全体が、AI が誤った情報を生成するという問題に取り組んできました。 Meta のような企業は、高品質のデータとリアルタイムの検索結果を提供することでチャットボットを改善しようとしていますが、今回の事件は、これらの大規模な言語モデルが依然として誤った情報を生成する傾向があり、設計に内在する欠陥であることを示しています。

カプラン氏は、メタ社は今後もこれらの問題の解決に取り組み、リアルタイムイベントをより適切に処理できるようユーザーからのフィードバックに基づいて技術を改善し続けると述べた。この一連の出来事は、AI テクノロジーの潜在的な問題を浮き彫りにするだけでなく、AI の精度と透明性に対する社会の注目をさらに高めるきっかけにもなります。

ハイライト:

1. メタAIはトランプ暗殺は起こらなかったと誤って主張し、懸念を引き起こした。

2. ❌ 幹部らは、「幻想」と呼ばれるこの間違いは業界でよくある問題だと述べている。

3. Googleはまた、関連する検索結果を検閲していると非難され、トランプ大統領の不満を引き起こした。

全体として、メタ AI の間違いは、AI テクノロジーによってもたらされる利便性を享受しながらも、その潜在的なリスクに注意を払い、AI テクノロジーの健全な発展を確保し、乱用や悪用を避けるために AI テクノロジーの監督と指導を強化する必要があることを改めて思い出させます。使用。このようにしてのみ、AI は人類に真の利益をもたらすことができます。