メタサイエンティストの Thomas Scialom 氏はポッドキャスト Latent Space で Llama 3.1 の開発プロセスを詳しく説明し、Llama 4 の開発の方向性をプレビューしました。 Llama 3.1 は単純なパラメータのスタッキングではなく、パラメータ サイズ、トレーニング時間、ハードウェア制限の間のトレードオフであり、その 405B パラメータ サイズは GPT-4o への対応です。モデルサイズが巨大なため、通常のコンピュータでの実行は困難ですが、オープンソースであるため、より多くの人が参加し、技術開発を促進できます。

Llama3.1 の誕生は、パラメーターのスケール、トレーニング時間、ハードウェアの制限の間で完璧なバランスが保たれています。 405B の巨大な本体はランダムな選択ではなく、メタによって GPT-4o に対して発行された挑戦です。ハードウェアの制限により、Llama3.1 をすべての家庭のコンピューターで実行することはできませんが、オープンソース コミュニティの力によってすべてが可能になります。

Llama 3.1 の開発中に、Scialom と彼のチームはスケーリングの法則を再検討しました。彼らは、モデルのサイズが確かに重要であるが、それよりも重要なのはトレーニング データの総量であることを発見しました。 Llama3.1 は、より多くの計算能力を費やすことになっても、トレーニング トークンの数を増やすことを選択しました。

Llama 3.1 のアーキテクチャには地球を揺るがすような変更はありませんが、Meta はデータの規模と品質の点で多大な努力を払ってきました。 15T トークンの海は、Llama3.1 に知識の深さと広さにおいて質的な飛躍をもたらしました。

データの選択に関して、シャロム氏は、公共のインターネット上にはテキストのゴミが多すぎて、本当の金は合成データであると強く信じています。 Llama3.1 のトレーニング後のプロセスでは、手書きの回答はまったく使用されず、Llama2 によって生成された合成データに完全に依存していました。

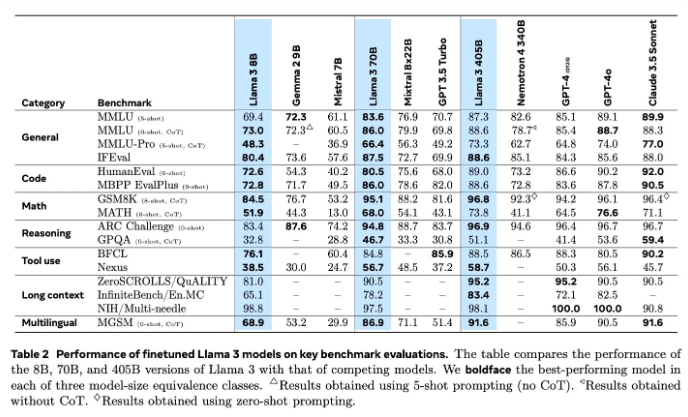

AI分野においてモデルの評価は常に難しい問題でした。 Llama3.1では、報酬モデルや多様なベンチマークテストなど、評価と改善のためにさまざまな手法を試してきました。しかし、本当の課題は、強力なモデルを打ち負かすことができる適切なプロンプトを見つけることにあります。

Meta は 6 月に Llama4 のトレーニングを開始しており、今回はエージェント技術に焦点を当てました。 Toolformer などのエージェント ツールの開発は、AI 分野における Meta の新たな探求の先駆けとなります。

Llama3.1 のオープンソースは、Meta による大胆な試みであるだけでなく、AI の将来についての深い考えでもあります。 Llama4 の発売により、Meta が今後も AI 分野をリードし続けると信じる理由ができました。 Llama4 とエージェント技術が AI の未来をどのように再定義するのかを楽しみにしましょう。

Llama 3.1 の研究開発プロセスを深く理解することで、Meta が大規模な言語モデルの分野で継続的な革新と努力を行っていること、またオープンソース コミュニティに重点を置いていることがわかります。 Llama 4の研究開発の方向性は、今後のAI技術の発展動向を示すものでもあり、注目に値する。 AI技術が今後どのように発展していくのか、楽しみにしましょう。